目录

大语言模型(LLM)是近年来发展迅猛并且激动人心的热点话题,引入了许多新场景,满足了各行各业的需求。随着开源模型能力的不断增强,越来越多的企业开始尝试在生产环境中部署开源模型,将AI模型接入到现有的基础设施,优化系统延迟和吞吐量,完善监控和安全等方面。然而要在生产环境中部署这一套模型推理服务过程复杂且耗时。为了简化流程,帮助企业客户加速部署生成式 AI 模型,本文结合 NVIDIA NIM (一套专为安全、可靠地部署高性能 AI 模型推理而设计的微服务,是一套易于使用的预构建容器化工具)和阿里云容器服务 ACK 等产品,提供了一套开箱即用,可以快速构建一个高性能、可观测、灵活弹性的 LLM 模型推理服务的操作指南。

阿里云容器服务 (ACK) 云原生 AI 套件

阿里云容器服务 Kubernetes 版 ACK(Container Service for Kubernetes)是全球首批通过Kubernetes一致性认证的服务平台,提供高性能的容器应用管理服务,支持企业级 Kubernetes 容器化应用的生命周期管理,让您轻松高效地在云端运行 Kubernetes 容器化应用。

云原生 AI 套件是阿里云容器服务 ACK 提供的云原生 AI 技术和产品方案。使用云原生 AI 套件,您可以充分利用云原生架构和技术,在 Kubernetes 容器平台上快速定制化构建 AI 生产系统,并为 AI/ML 应用和系统提供全栈优化。云原生 AI 套件支持使用 Kubeflow 社区开源的命令行工具 Arena,对深度学习核心生产环节(包括数据管理、模型训练、模型评估、推理服务部署等)任务进行简单抽象和高效管理,同时降低 Kubernetes 复杂概念带来的使用复杂度。Arena可以实现分布式训练任务的快速提交,并进行任务的生命周期管理。此外,云原生 AI 套件还提供针对分布式场景优化的调度策略,例如 Binpack 算法分配策略,提升 GPU 利用率,还支持自定义的任务优先级管理和租户弹性资源配额控制,在确保用户资源分配的基础上,通过资源共享的方式来提升集群的整体资源利用率。

方案介绍

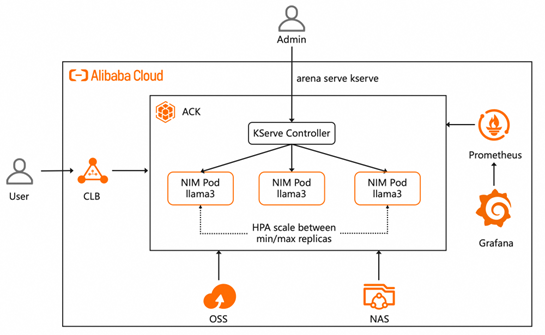

本文将介绍如何在阿里云 ACK 集群上,使用云原生 AI 套件集成开源推理服务框架 KServe,快速部署 NVIDIA NIM。同时,结合阿里云的 Prometheus 和 Grafana 服务,快速搭建监控大盘,实时观测推理服务状态。利用 NVIDIA NIM 提供丰富的监控指标,如num_requests_waiting,配置推理服务弹性扩缩容策略。当有突发流量导致推理服务处理请求排队时,能自动扩容新的实例来应对高峰流量。整体解决方案架构如下所示。

NVIDIA NIM on ACK

本文将介绍在 ACK 集群上部署 NVIDIA NIM 的步骤,总体步骤如下:

- 创建 ACK 集群并安装云原生 AI 套件,

ack-kserve等组件。 - 使用 Arena 提交 KServe 推理服务,使用 NIVDIA NIM 容器,部署 Llama3-8B 模型。

- 为推理服务配置监控,实时观测推理服务状态。

- 基于排队中请求数指标配置弹性扩缩容策略,自动灵活地调整模型服务实例的规模。

部署流程

首先需要创建包含 GPU 的 Kubernetes 集群,并部署云原生 AI 套件。为了在集群中使用 KServe 管理推理服务,还需要安装 ack-kserve️。集群环境准备好后,就可以参考下列步骤开始部署服务了。

重要

- 您应自觉遵守第三方模型的用户协议、使用规范和相关法律法规,并就使用第三方模型的合法性、合规性自行承担相关责任。

- 参考NVIDIA NIM 文档,生成 NVIDIA NGC API key,访问需要部署的模型镜像,比如本文中使用的 Llama3-8b-instruct。请阅读并承诺遵守 Llama 模型的自定义可商用开源协议。

- 创建imagePullSecret,用于从 NGC 私有仓库拉取 NIM 镜像。

export NGC_API_KEY=<your-ngc-api-key>

kubectl create secret docker-registry ngc-secret \

--docker-server=nvcr.io\

--docker-username='$oauthtoken'\

--docker-password=${NGC_API_KEY}- 创建nvidia-nim-secret,用于在容器内访问 NGC 私有仓库,参考 nim-deploy 部署文档。

kubectl apply -f-<<EOF

apiVersion: v1

kind: Secret

metadata:

name: nvidia-nim-secrets

stringData:

NGC_API_KEY: <your-ngc-api-key>

EOF

- 为目标集群配置存储卷 PV 和存储声明 PVC,后续模型文件将会下载到创建的共享存储中。具体操作,请参见使用 NAS 静态存储卷。

- 以下为示例 PV 的配置信息:

| 配置项 | 说明 |

| 存储卷类型 | NAS |

| 名称 | nim-model |

| 访问模式 | ReadWriteMany |

| 挂载点域名 | 您可以通过选择挂载点或者自定义的方式定义集群在 NAS 文件系统中挂载点的挂载地址。关于如何查看挂载点地址,请参见查看挂载点地址。 |

| 挂载路径 | 指定模型所在的路径,如 /nim-model |

- 以下为示例 PVC 的配置信息:

| 配置项 | 说明 |

| 存储声明类型 | NAS |

| 名称 | nim-model |

| 分配模式 | 选择已有存储卷。 |

| 已有存储卷 | 单击选择已有存储卷链接,选择已创建的存储卷 PV。 |

- 执行下列命令,部署一个 KServe 推理服务,使用 NVIDIA NIM 提供的镜像,指定使用一个 NVIDIA GPU,将 PVC 挂载到容器内的 /mnt/models 目录用于保存模型文件,配置 autoscalerClass=external 指定使用自定义 HPA 策略,同时还开启 Prometheus 采集推理服务监控指标,用于后续在 Grafana 中搭建监控大盘。等待容器启动后,即可使用 Llama3-8b-instruct 模型提供推理服务。

arena serve kserve \

--name=llama3-8b-instruct \

--image=nvcr.io/nim/meta/llama3-8b-instruct:1.0.0 \

--image-pull-secret=ngc-secret \

--gpus=1 \

--cpu=8 \

--memory=32Gi \

--share-memory=32Gi \

--port=8000 \

--security-context runAsUser=0 \

--annotation=serving.kserve.io/autoscalerClass=external \

--env NIM_CACHE_PATH=/mnt/models \

--env-from-secret NGC_API_KEY=nvidia-nim-secrets \

--enable-prometheus=true \

--metrics-port=8000 \

--data=nim-model:/mnt/models预期输出:

INFO[0004] The Job llama3-8b-instruct has been submitted successfully

INFO[0004] You can run `arena serve get llama3-8b-instruct --type kserve -n default` to check the job status

输出结果表明推理服务已部署成功。

- 推理部署完成后,可通过执行以下命令,查看 KServe 推理服务的部署情况。

arena serve get llama3-8b-instruct

预期输出:

Name: llama3-8b-instruct

Namespace: default

Type: KServe

Version: 1

Desired: 1

Available: 1

Age: 24m

Address: http://llama3-8b-instruct-default.example.com

Port: :80

GPU: 1

Instances:

NAME STATUS AGE READY RESTARTS GPU NODE

---- ------ --- ----- -------- --- ----

llama3-8b-instruct-predictor-545445b4bc-97qc5 Running 24m 1/1 0 1 ap-southeast-1.172.16.xx.xxx

输出结果表明,KServe 推理服务部署成功,模型访问地址为http://llama3-8b-instruct-default.example.com。

- 接下来就可以访问推理服务了,可通过使用获取到的 Nginx Ingress 网关地址访问推理服务。

# Obtain the IP address of the Nginx ingress.

NGINX_INGRESS_IP=$(kubectl -n kube-system get svc nginx-ingress-lb -ojsonpath='{.status.loadBalancer.ingress[0].ip}')

# Obtain the Hostname of the Inference Service.

SERVICE_HOSTNAME=$(kubectl get inferenceservice llama3-8b-instruct -o jsonpath='{.status.url}' | cut -d "/" -f 3)

# Send a request to access the inference service.

curl -H "Host: $SERVICE_HOSTNAME" -H "Content-Type: application/json" http://$NGINX_INGRESS_IP:80/v1/chat/completions -d '{"model": "meta/llama3-8b-instruct", "messages": [{"role": "user", "content": "Once upon a time"}], "max_tokens": 64, "temperature": 0.7, "top_p": 0.9, "seed": 10}'预期输出:

{"id":"cmpl-70af7fa8c5ba4fe7b903835e326325ce","object":"chat.completion","created":1721557865,"model":"meta/llama3-8b-instruct","choices":[{"index":0,"message":{"role":"assistant","content":"It sounds like you're about to tell a story! I'd love to hear it. Please go ahead and continue with \"Once upon a time...\""},"logprobs":null,"finish_reason":"stop","stop_reason":128009}],"usage":{"prompt_tokens":14,"total_tokens":45,"completion_tokens":31}}输出结果表明,已经能够通过 Nginx Ingress 网关地址访问推理服务,并成功返回推理结果。

监控

NVIDIA NIM 提供了丰富的 Prometheus 监控指标,比如首 token 时延、当前正在运行的请求数、请求 token 数、生成 token 数等指标。结合阿里云 Prometheus 和 Grafana 服务,可以快速在 Grafana 中搭建监控大盘,实时观测推理服务状态。

- 已开启阿里云 Prometheus 监控组件。具体操作,请参见开启阿里云 Prometheus 监控。

- 创建grafana 工作区,登录 Grafana 的 Dashboards 页面。

- 导入NVIDIA NIM 提供的 dashboard 样例。

- 成功导入后,dashboard 示例如下

弹性伸缩

在部署与管理 KServe 模型服务过程中,需应对模型推理服务面临的高度动态负载波动。KServe 通过集成 Kubernetes 原生的 HPA(Horizontal Pod Autoscaler)技术及扩缩容控制器,实现了根据 CPU 利用率、内存占用情况、GPU 利用率以及自定义性能指标,自动灵活地调整模型服务 Pod 的规模,以确保服务效能与稳定性。

基于排队请求数配置自定义指标的弹性扩缩容策略

自定义指标的扩缩容依赖 ACK 提供的 ack-alibaba-cloud-metrics-adapter 组件与 Kubernetes HPA 机制实现。详细信息,请参见基于阿里云 Prometheus 指标的容器水平伸缩。

以下示例演示如何基于 NVIDIA NIM 提供的 num_requests_waiting 指标配置扩缩容策略。

- 已部署阿里云 Prometheus 和 ack-alibaba-cloud-metrics-adapter,请参见基于阿里云 Prometheus 指标的容器水平伸缩。

- 在Helm 列表的操作列,单击 ack-alibaba-cloud-metrics-adapter 对应的更新。在 custom字段下添加如下 rules。

- seriesQuery: num_requests_waiting{namespace!="",pod!=""}

resources:

overrides:

namespace: {resource: "namespace"}

pod: {resource: "pod"}

metricsQuery: sum(<<.Series>>{<<.LabelMatchers>>}) by (<<.GroupBy>>)- 通过Custom Metrics 进行容器伸缩,示例配置了当等待中的请求数超过 10 则进行扩容。

- 使用以下内容,创建 hpa.yaml 文件。

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: llama3-8b-instruct-hpa

namespace: default

spec:

# The minReplicas and maxReplicas for the HPA.

minReplicas: 1

maxReplicas: 3

# An array of monitoring metrics that supports the coexistence of multiple types of metrics.

metrics:

- pods:

metric:

name: num_requests_waiting

target:

averageValue: 10

type: AverageValue

type: Pods

# The scaling target description for the HPA, which dynamically adjusts the number of Pods for the target object.

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: llama3-8b-instruct-predictor- 执行以下命令,创建HPA应用。

kubectl apply -f hpa.yaml- 执行以下命令,创建 HPA 应用。

kubectl get hpa llama3-8b-instruct-hpa预期输出:

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE

llama3-8b-instruct-hpa Deployment/llama3-8b-instruct-predictor 0/10 1 3 1 34s

- 执行以下命令,对服务进行压测。

说明 Hey 压测工具的详细介绍,请参见 Hey。

hey -z 5m -c 400 -m POST -host $SERVICE_HOSTNAME -H "Content-Type: application/json" -d '{"model": "meta/llama3-8b-instruct", "messages": [{"role": "user", "content": "Once upon a time"}], "max_tokens": 64}' http://$NGINX_INGRESS_IP:80/v1/chat/completions

- 在压测期间,重新打开一个终端,执行以下命令查看服务的扩缩容情况。

kubectl describe hpa llama3-8b-instruct-hpa

预期输出包含如下内容:

Events:

Type Reason Age From Message

—- —— —- —- ——-

Normal SuccessfulRescale 52s horizontal-pod-autoscaler New size: 3; reason: pods metric num_requests_waiting above target

预期输出表明在压测期间 Pod 数会扩容到 2,而当压测结束后,经过一段时间(约为 5 分钟),Pod 缩容到 1。即可以实现自定义指标的扩缩容。

120

120

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?