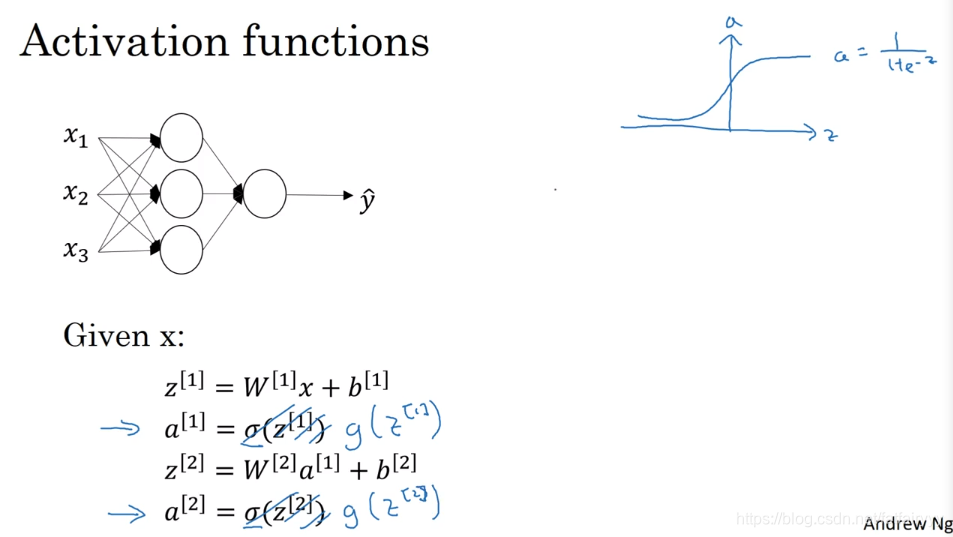

神经网络的激活函数

双曲正切函数tanh(x)

- 之前我们使用的神经网络,一直选择sigmoid函数作为激活函数,但实际上,激活函数可以是任何函数。

使用双曲正切函数,它的表现比sigmoid函数更好。

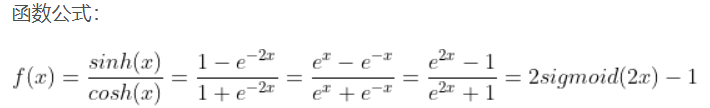

tanh(x)函数公式:

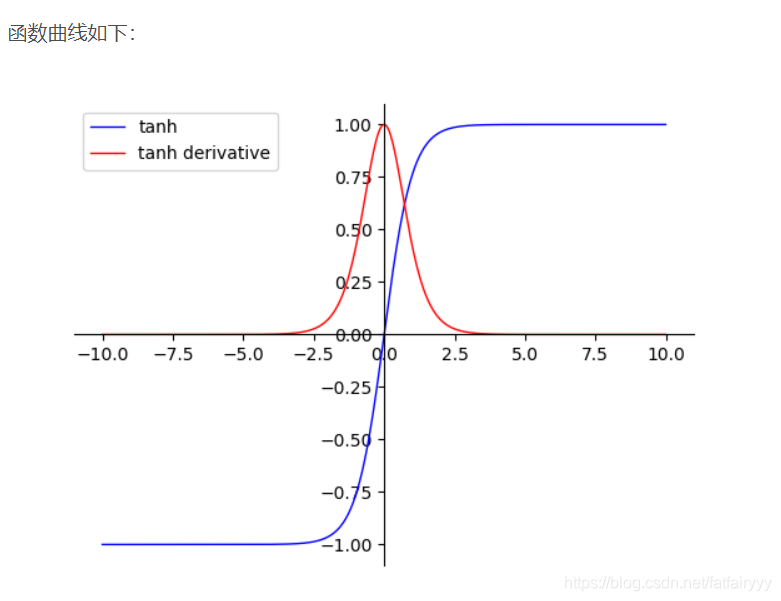

函数曲线:介于(-1,1),类似于sigmoid函数的平移版本。

使用tanh(x)的好处:

①函数图像过原点。(sigmoid函数的图像不过原点)

②收敛速度快于sigmoid函数。 - 由于双曲正切函数介于(-1,1)之间,使用它作为激活函数好于sigmoid函数。因为使用它,激活函数的平均值更接近于0,让下一层的学习更方便。

- 将双曲正切函数用于任何情况作为激活函数都是好的,除了将它用于输出层,因为如果y的真实值是二元分类的0或1,那么让y_hat介于0到1之间更为合理,此时使用sigmoid函数更合理。

- sigmoid函数和tanh函数都有一个缺点,当Z很大或很小的时候,会使α十分接近1或-1,此时两个函数的斜率接近于0(以Logistic回归为例,改变参数W和b,Z的变化缓慢,导致y_hat - y的变化缓慢,降低梯度下降算法的速度),会降低梯度下降算法的速度。

深度学习中的激活函数解析

深度学习中的激活函数解析

本文介绍了神经网络中的激活函数,包括双曲正切函数tanh(x)和ReLU函数。tanh(x)优于sigmoid函数,因其函数图像过原点且收敛速度更快。ReLU函数在多数情况下成为默认选择,但在Z<0时导数为0。非线性激活函数在神经网络中至关重要,线性激活仅适用于特定场景如线性回归。激活函数的导数在反向传播中起到关键作用。

本文介绍了神经网络中的激活函数,包括双曲正切函数tanh(x)和ReLU函数。tanh(x)优于sigmoid函数,因其函数图像过原点且收敛速度更快。ReLU函数在多数情况下成为默认选择,但在Z<0时导数为0。非线性激活函数在神经网络中至关重要,线性激活仅适用于特定场景如线性回归。激活函数的导数在反向传播中起到关键作用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1408

1408

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?