线性模型

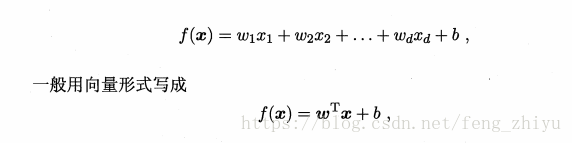

基本形式

线性回归

给定一个数据集:

线性回归试图学得一个线性模型以尽可能准确地预测实值输出标记。

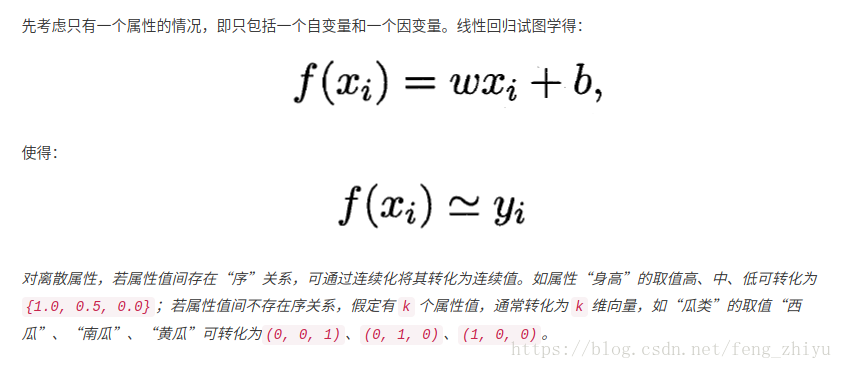

一元线性回归

一元线性回归的基本形式

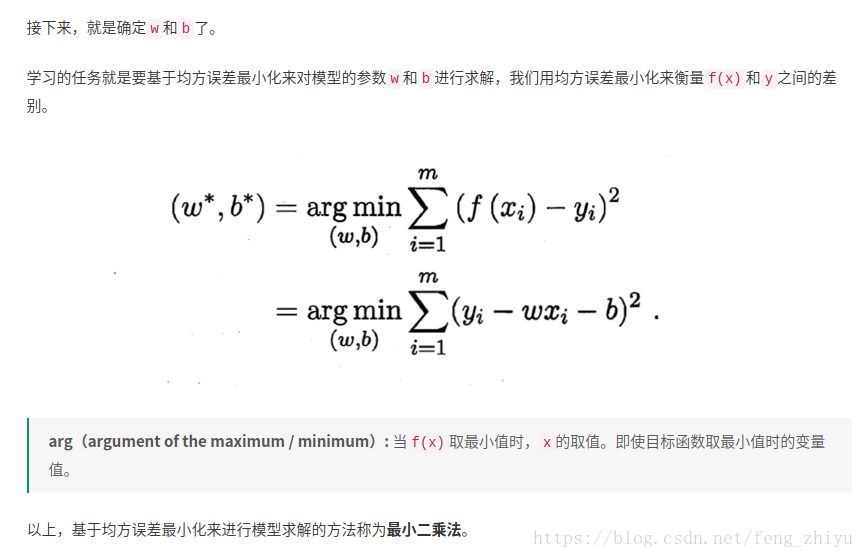

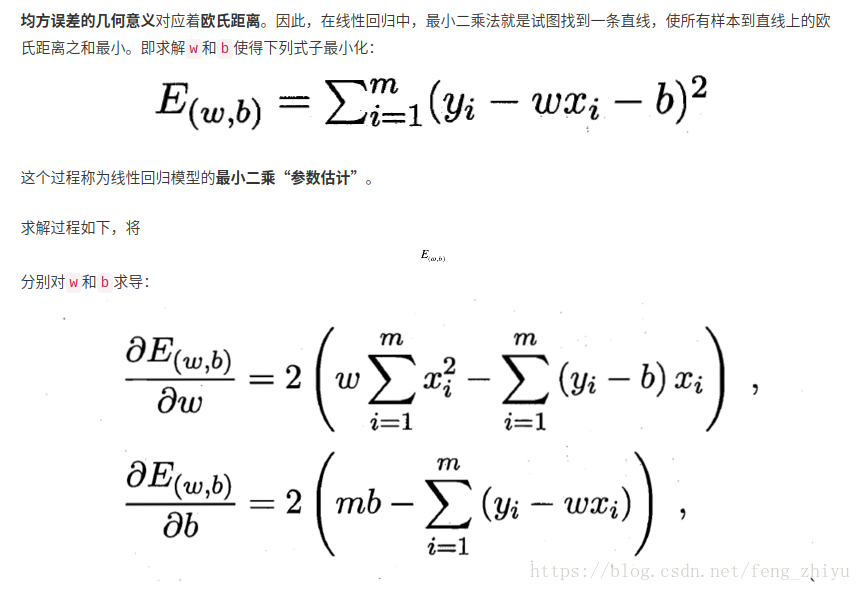

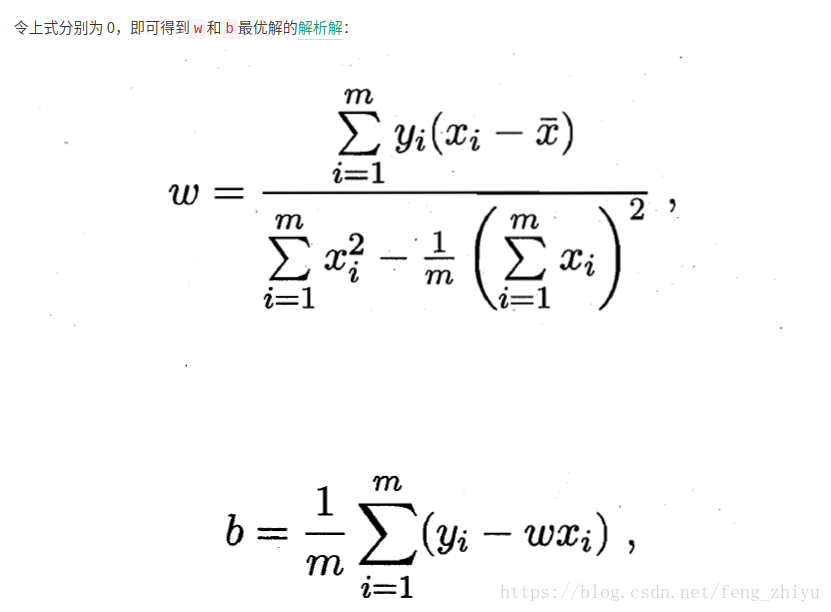

求解线性回归参数

最小二乘法求解回归方程推导过程:最小二乘法求回归方程的推导

多元线性回归

参见:https://segmentfault.com/a/1190000016091382#articleHeader0

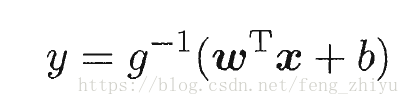

广义线性模型

更一般地,考虑单调可微函数g(·),令

这样得到的模型称为广义线性模型。其中,函数g(·)称为联系函数。

显然,对数线性回归是广义线性模型在g(·)=ln(·)时的特例。

对数几率回归

基本形式

可化为 ,显然,如果将y视为样本Z作为正例的可能性,那1−y是其反例的可能性,两者的比值就是

,称之为“几率”,

则是“对数几率”。

将线性回归模型代入,得, 从这个式子看出这是用线性回归模型的预测结果来逼近真实标记的对数几率,故称“对数几率回归”(logistic regression)。虽然名字是回归,但是实际上它是一种分类学习算法。

优点:

- 直接对分类可能性进行建模,无需事先假设数据分布,因此能够避免假设分布不准确所带来的问题;

- 不仅预测”类别“,而是可得到近似概率预测;

- 对数函数时任意阶可导的凸函数,有很好的数学性质,现有的许多数值优化算法都直接用于求取最优解

简单的说回归问题和分类问题:

回归问题:预测一个连续的输出。

分类问题:离散输出,比如二分类问题输出0或1。

逻辑回归常用于垃圾邮件分类,天气预测等。

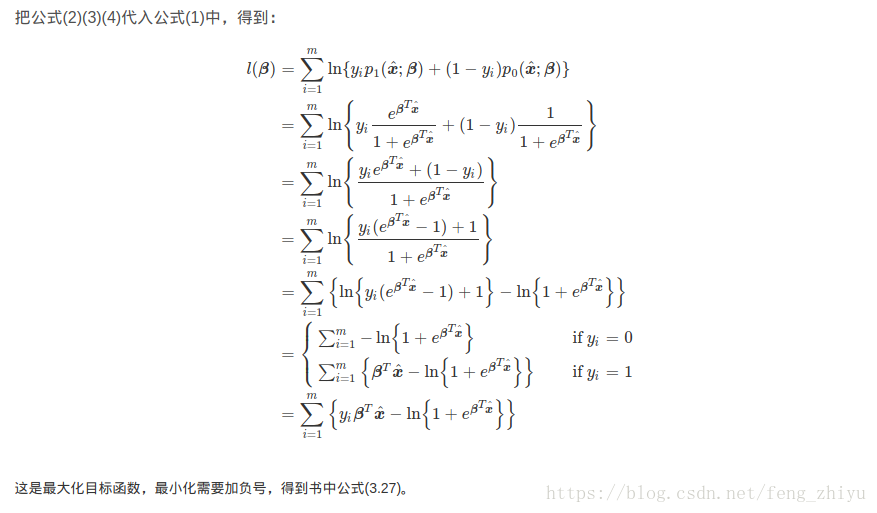

这里引用西瓜书《机器学习》阅读笔记6——Chapter3_公式(3.27)的推导过程 。

3.27式时关于的高阶可导连续凸函数,根据凸优化理论,经典的数值优化算法如梯度下降法、牛顿法等都可求得其最优解。

线性判别分析

线性判别分析(Linear Discriminant Analysis,简称LDA)是一种经典的线性学习方法。

LDA思想:给定训练样例集,设法将样例投影到一条直线上,使得同类样例的投影尽可能接近、异类样例的投影点尽可能远离;在对新样本进行分类时,将其投影到同样的这条直线上,再根据投影点的位置来确定新样本的类别。

实践

from sklearn.linear_model import LogisticRegression

classifier = LogisticRegression()

classifier.fit(x_train,y_train)实际案例

参考链接:

西瓜书《机器学习》阅读笔记6——Chapter3_公式(3.27)的推导过程

1476

1476

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?