作者 | 周俊贤

整理 | NewBeeNLP

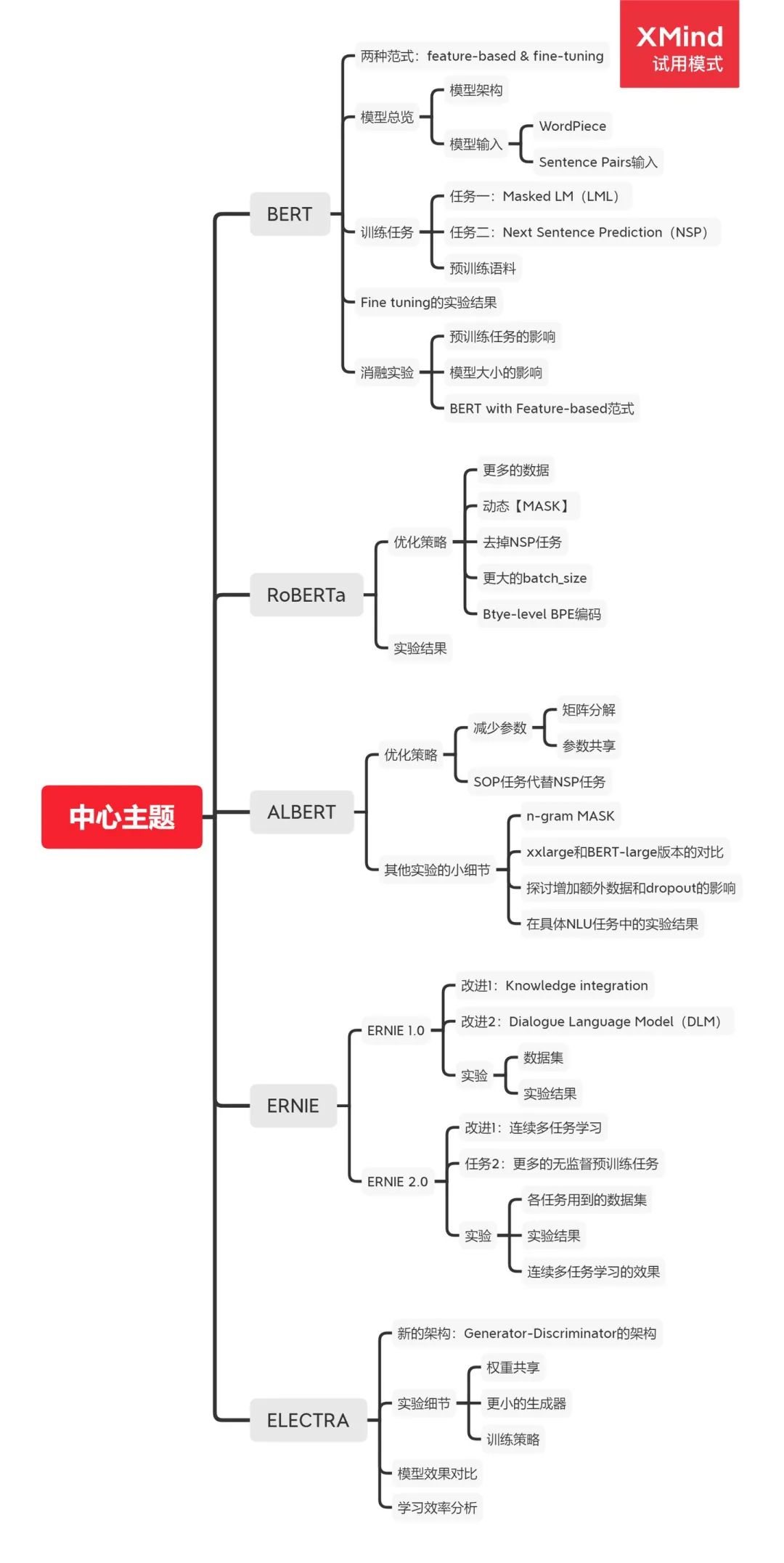

本文讲解下BERT推出后,预训练模型的演变,包括BERT、RoBERTa、ALBERT、ERNIE系列、ELECTRA。下面脑图是本系列第一篇内容,欢迎关注更多后续!

一、BERT

论文全称及链接:《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》[1]

首先,BERT的全称叫Bidirectional Encoder Representations from Transformers,从论文题目和BERT英文全称,可以看到BERT做的是一个上下文的信息编码。整篇论文的主要比较对象是ELMo和GPT,ELMo和GPT的最大问题在于「不是真正的双向编码」,

GPT利用的是Transformer结构的Decoder,所以肯定不是双向的,

ELMo虽然把LSTM的正向向量和反向向量拼接在一起,但并不是真正的双向(想想,拼接但是并没有发生交互),这样的网络结构对下游任务非常不利的,举个例子,做问答任务的时候,从两个方向编码上下文是非常重要的。

BERT用到的是transformer的encoder部分,编码每个token的时候考虑了所有input token的交互,「所以BERT是真正的双向编码模型」!

feature-based and fine-tuning两种范式

feature-based范式,代表作如EMLo,想想在17年之前,Transformer没出的时候,大家最常解决NLP任务的方法就是「用别人训练好的词向量作为embedding」,然后后面接各种全新初始化的RNN/LSTM/CNN等网络结构,也就是预训练只提供了feature-based的embedding。

fine-tunning范式,代表作如GPT,用于下游任务时,不仅仅保留了输入的embedding,Transformer里面的参数(如attention层、全连接层)也同样可以保留,在fine-tuning的时候只需在原来的Transfomer上加一些简单的层,就可以应用于具体的下游任务。

BERT当然也是属于fine-tuning范式。

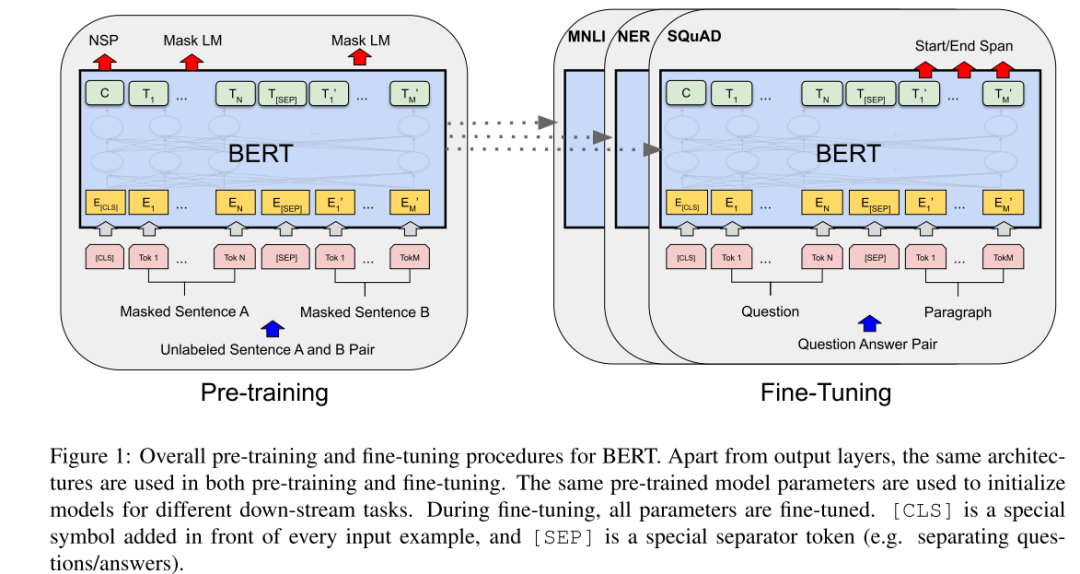

BERT模型总览

模型架构

BERT提供了一种解决各种下游任务的统一结构。当我们要对具体的任务做微调时,我们只需要在原来的结构上面增加一些网络层就OK了,「这样预训练的网络结构和具体下游任务的网络结构差别很小,有助于把BERT预训练时学习到的特征尽可能保留下来」。

模型输入

「WordPiece」

在模型输入的时候,并非是具体的单词,而是WordPiece,具体的,我们看谷歌发布的原生BERT的vocab词表,有一些英文单词是带有##前缀的,例如##bed等等,如embedding这个单词,通过WordPiece会拆分成em、##bed、##d、##ing,带有##前缀的单词表示它是单词的一部分,而不是完成的单词(所以在词表里面bed、##bed,它们的含义是完全不一样的),具体的可以搜索一下BPE,引入WordPiece作为输入可以有效缓解OOV问题。

至于中文,个人认为还是单字作为输入,因为中文很难像英文一样,再进行拆分下去(当然这几年也有人研究把字按拼音或偏旁拆,这里就不进行深入讨论了)。

「Segment Pairs输入」

BERT引入了句子对作为输入,为什么要引入句子对作为输入,是为了让BERT能应对更多的下游任务(例如句子相似度任务,问答任务等都是多句输入)。注意!这里的""句子"是「广义的,表示的并非是单句,而是一段文章的连续片段,可以包含一个句子或多句句子」,所以输入的时候,其实是可能不止两个句子的。

感觉原文就不应该用Sentence pairs来表达,而应该用Segment Pairs。在后面的RoBERTa实验里验证,假如用单句拼接作为句子对相对于用连续片段拼接作为句子对,其实是损害性能的。

训练任务

「任务一:Masked LM(MLM)」

把输入的句子对进行WordPiece处理后,随机选15%的token【MASK】掉,然后i对【MASK】掉的token进行预测,但这会引起一个问题:「预训练和下游任务,输入不一致,因为下游任务的时候,输入基本上是不带【MASK】的,这种不一致会损害BERT的性能」,这也是后面研究的改善方向之一),当然BERT自身也做出了一点缓解,就是并非15%的token都用【MASK】代替,而是15%的80%用【MASK】代替,10%用随机的词代替,10%用原来的词保持不变。

「任务二:Next Sentence Prediction(NSP)」

判断句子对是否是真正连续的句子对。

预训练语料

BooksCorpus(800M单词)和英语维基百科(2500M单词)

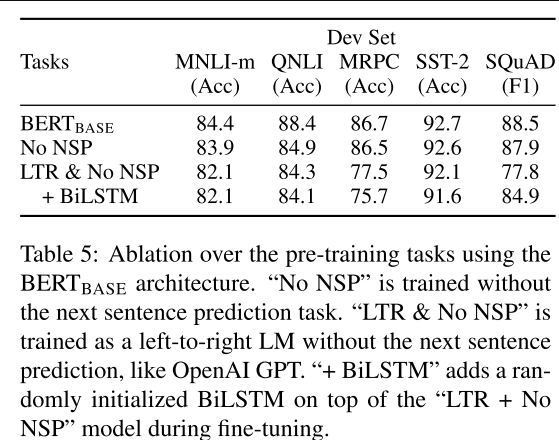

消融实验

「预训练任务的影响」

对比去掉NLP任务和把原来的MLM任务改成LTR(Left-to-Right)任务,实验结果如下表,表明原来的MLM和NSP任务缺一不可。

「模型大小的影响」

模型规模越大,性能越好。

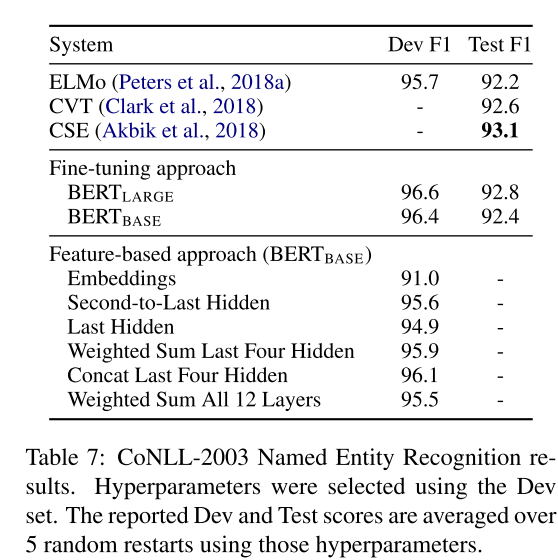

BERT with Feature-based

这个实验很有意思,「就是把BERT作为feature-based范式,而不是fine-funing范式」。具体的做法是把BERT的某些层的向量拿出来,作为token的embedding(这些embedding在后面的fine-tuning任务中不更新),还不明白的,类比下,用word2vec作为token的特征,然后后面接具体的任务层,只不过这里的word2vec向量用BERT的某些层的输出作为代替,假如直接用BERT embeddings作为Feature,自然每个token的feature都是固定的(这就有点像用预训练好的的word2vec向量作为特征),如果取后面的层(每个token的feature不一样,有点像ELMo),实验证明,BERT无论是作为feature-based还是fine-tuning方法都是非常有效的。

二、RoBERTa

论文全称及链接:《RoBERTa: A Robustly Optimized BERT Pretraining Approach》[2]

RoBERTa的全称叫做Robustly optimized BERT approach。RoBERTa之于BERT的改动很简单,主要是用了更多的数据,训练上,采用动态【MASK】、去掉下一句预测的NSP任务、更大的batch_size、文本编码。

更多的数据

在BERT采用的数据BOOKCORPUS + English WIKIPEDIA(共16G)基础上

增加 CC-NEWS(76GB)

增加 OPENWEBTEXT(38GB)

增加 STORIES(31GB)

也就是RoBERTa一共用了160GB语料进行预训练。

动态【MASK】

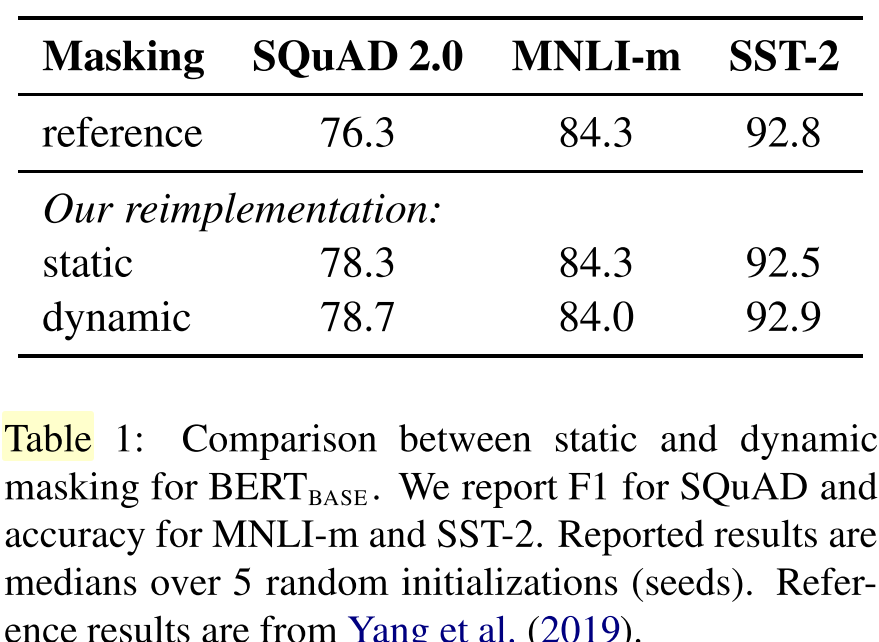

预训练的每一个step,是重新挑选15%token进行【MASK】的,而BERT是固定的,就是对于同一个输入样本,在不同的epoch,输入是一样的,实验结果见下图,有很微弱的提升吧。

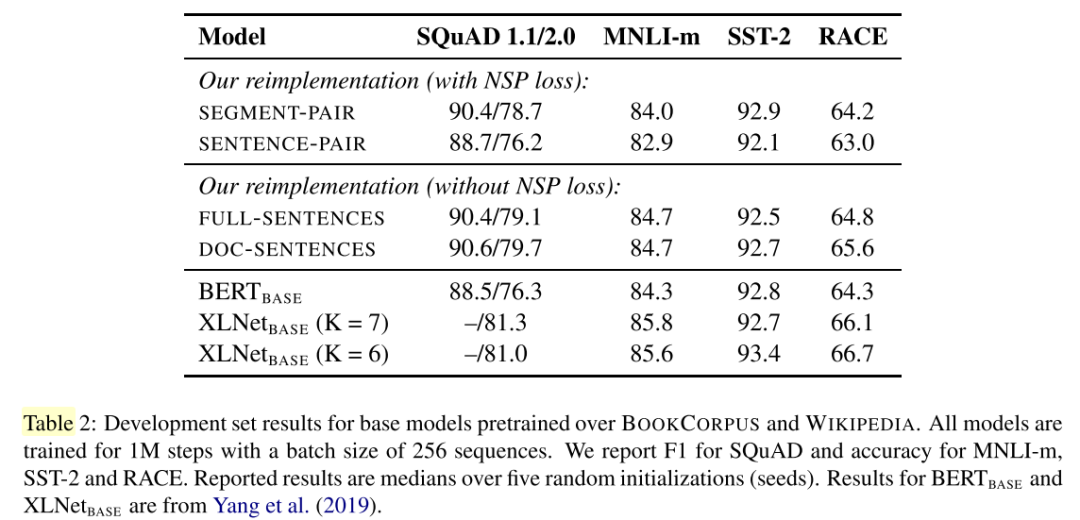

去掉NSP任务

首先看一下结果图,SEGMENT-PAIR就是BERT采用的方式,虽「然是句子对输入,但其实一个句子不只有一句,而是文章里面的连续片段,可以包含多句」。而SENTENCE-PARI就是两个单句拼接在一起。可以看到使用单句拼接会损害性能,还是原生的BERT一样把连续的片段拼接成句子对的表现比较好。

FULL-SENTENCES和DOC-SENTENCES都是去掉NSP任务的,可以看到去掉NSP任务表现都比原来的要好,FULL-SENTENCES是可以跨文档来采样句子。DOC-SENTENCES是保证采样的句子都在同一个文档里面,可以看到DOC-SENTENCES表现稍微好一点。所以最后的RoBERTa是采用去掉NSP而且一个样本是从同一个文档里面进行采样。

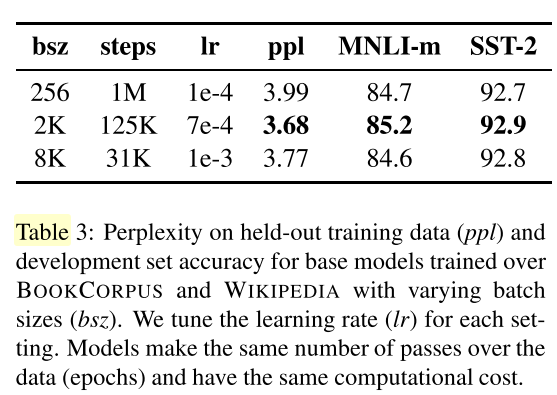

更大的batch_size

BERT的batch_size是256,一共训练了1M步,实验证明,采用更大的batch_size以及训练更多步,可以提高性能,所以最后的RoBERTa采用的batch_size是8K。

文本编码

BERT采用的是基于character level的Byte-Pair Encoding(BPE)编码,词表大小是30K,RoBERTa采用的是混合character level 和 word level的BPE编码,词表大小变成50K,作者相信这个编码方式更通用。

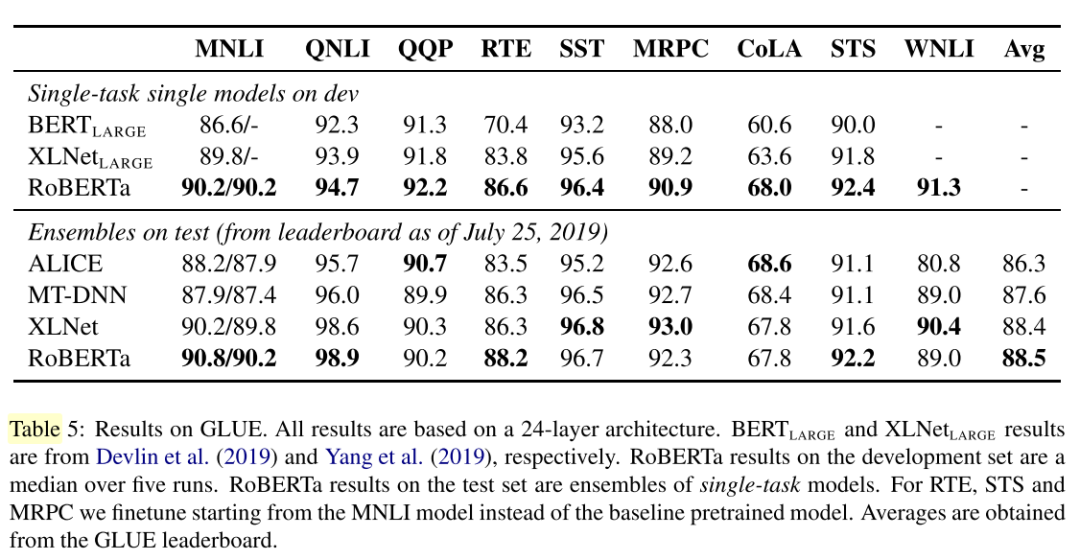

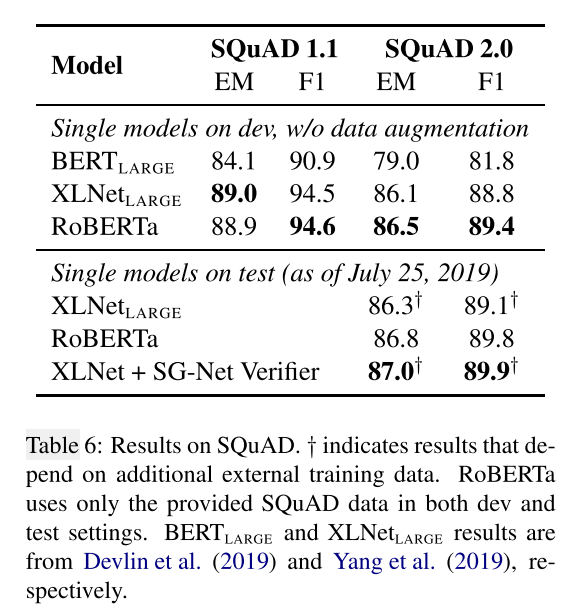

实验结果

可以看到采用更多的数据、更大的batch_size、训练更多轮,都对模型效果有所提升。

三、ALBERT

论文全称及链接:《ALBERT: A Lite BERT for Self-supervised Learning of Language Representations》[3]

ALBERT的全程是A Lite BERT,顾名思义,它是一个精简版的BERT模型,作者提出ALBERT的动机是,通常情况下,「增加模型规模能提高模型的性能」,但我们不能无限制地增加下去,因为「资源有限」。因此,论文提出一种减少参数的方法(注意哦,减少参数跟增加模型规模是不矛盾的,减少参数的同时我们也可以增加模型规模!具体的往下看)。除了减少参数,作者还提出SOP的训练任务。

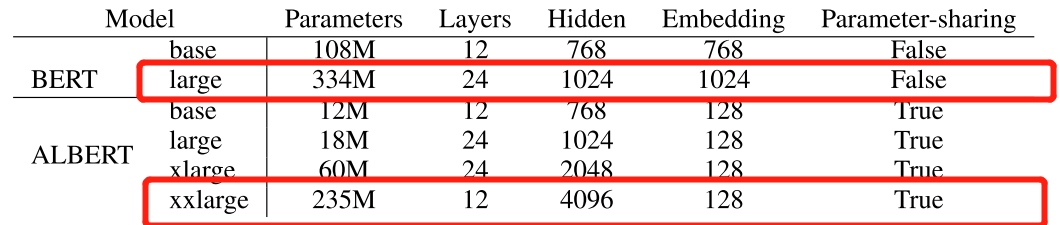

值得注意的是,大家都说ALbert的性能比BERT要好,实质上,ALBERT-large版本的性能是比BERT-large版本的性能差的!大家所说的性能好的ALBERT版本是xlarge和xxlarge版本,而这两者模型,虽然都比BERT-large参数量少,但由于模型规模变大了,所以训练时间是变慢的,推断速度也变慢了!所以ALBERT也不是如名字说的,属于轻量级模型。

优化策略

减少参数

其实解决资源不足问题也有一些其它的方法,如模型并行和更智能的内存、显存管理机制。但这些解决方法「都不是从通信端去解决问题」。而减少参数量是有效从通信端解决资源不足的方法。

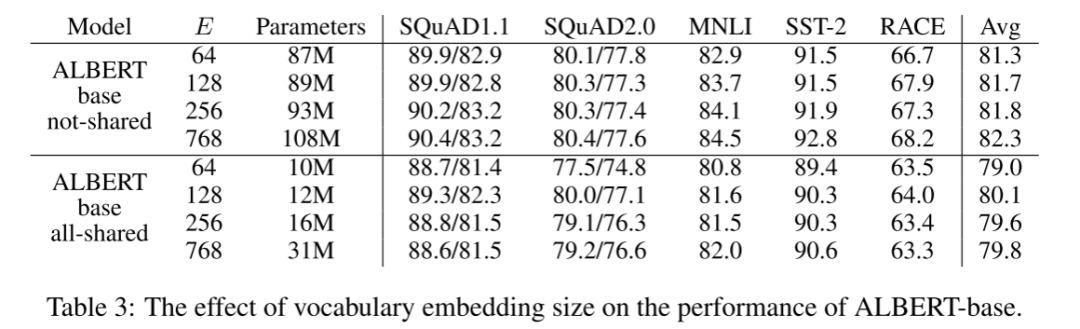

「矩阵分解」

这是从输入的embedding维度去减少参数,BERT采用的是WordPiece,大概有3K个token,然后原生BERT采用的embedding size是跟hidden size一样的,都为768,所以参数量约为3000 * 768 = 2304000。假如我们通过一个矩阵分解去代替本来的embedding矩阵,如上图所示,E取为128,则参数量变为3000 * 128+128 * 768=482304,参数量变为原来的20%!

思考一个问题:这样的分解会影响模型的性能吗?作者给出的角度是,WordPiece embedding是跟上下文独立的,hidden-layer embedding(即Transformer结构每一个encoder的输出)是跟上下文有关的,而BERT的强大主要是attention机制,即根据上下文给出token的表示,所以WordPiece embedding size不需要太大,因为WordPiece embedding不是BERT这么强的主要原因。

「参数共享」

思想就是,BERT的Transformer共用了12层的encoder,让这12层的attention层和全连接层层共享参数,作者还发现这样做对稳定网络参数有一定的作用。其实看下表的实验结果,全共享(attention层和全连接层都共享)是比单纯共享attention层的效果要差的,但是全共享d减少的参数实在太多了,所以作者采用的为全共享。

SOP代替NSP

还记得NSP任务吗?判断句子对是否是连续的句子对,后面的研究者发现,NSP给BERT带来不好的影响,主要原因是跟MLM任务相比,任务难度太小了。具体的,把NSP分别topic prediction(主题预测)和coherence prediction(一致性预测),很明显NSP是比较偏向主题预测的(预测句子对是否是同一文档的连续片段),而topic prediction相对clherence prediction是比较简单的。SOP将负样本换成了同一篇文章中的两个逆序的句子,从而消除topic prediction,让模型学习更难得coherence prediction。

n-gram MASK

预测n-gram片段,包含更完整的语义信息。每个片段的长度取值n(论文里取最大为3)。根据公式取1-gram、2-gram、3-gram的概率分别为6/11,3/11,2/11。越长概率越小。

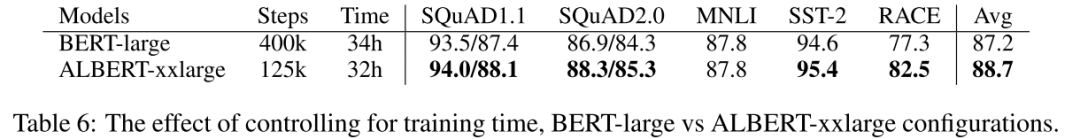

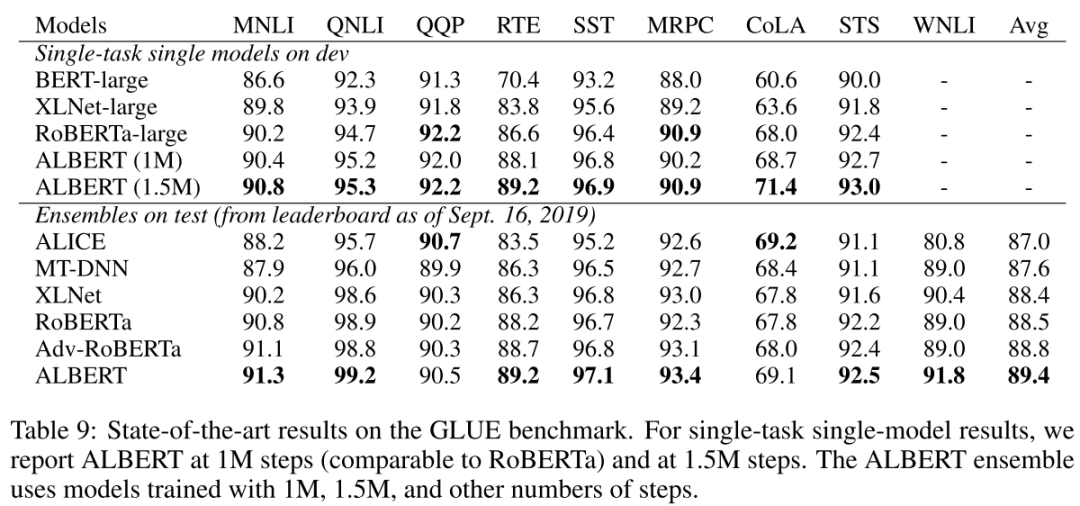

xxlarge版本和BERT-large版本的对比

由于模型的参数变少了,所以,我们可以训练规模更大的网络,具体的ALBERT-xxlarge版本也是12层,但是hidden_size为4096!控制BERT-large和ALBERT-xxlarge的训练时间一样,可以看到ALBERT-xxlarge版本的训练速度时间只有BERT-large的1/3左右,慢了不少,这是模型规则变大的副作用。但由于模型规则变大了,所以模型性能也得到了一定的提升,大家常说刷榜的ALBERT,其实是xxlarge版本,普通的large版本性能是比BERT的large版本要差的。

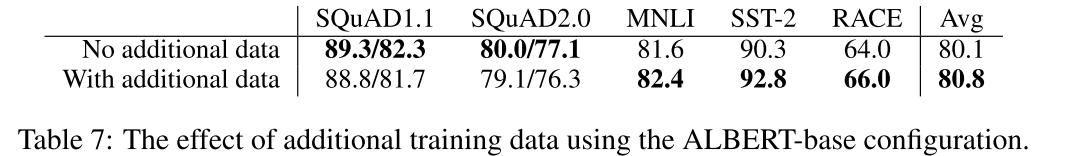

探讨增加额外的数据和dropout的影响

实验表明,增加额外的数据是能提升模型效果的(除了在SQuAD数据集上,因为SQuAD数据集是采样于Wikipedia的,Wikipedia是BERT原生用于训练的数据集,现在增加其它数据集,那在Wikepedia数据集上的任务自然变差)。

除此之外,还首次提出,「dropout会带来负向的效果」,可能是是模型太大、数据太多,模型很难收敛,还没达到需要抗拟合的时候,作者说这个还有待研究。

在具体NLU任务中的实验结果

效果就是各种屠榜吧。

四、ERNIE

ERNIE 1.0

论文全称及链接:《ERNIE: Enhanced Representation through Knowledge Integration》[4]

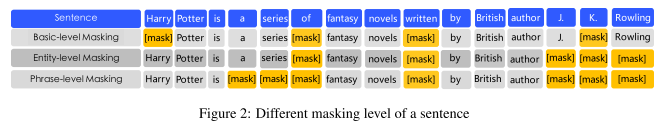

ERNIE1.0采用与BERT一样的架构,与BERT有所区别的是,在于训练任务的不同,可看下面这幅图。

原生BERT是采用随机【MASK】,ERIENE1.0论文里提到这会让模型学不到语义信息,降低学习难度,具体的看图,Harry Potter的Harry被【MASK】掉,这时候让模型去预测,这种情况下,模型很可能是根据Potter从而预测Harry(毕竟Harry Potter在语料中共同出现频率的比较高),在这种情况下,模型也许并不是根据Harry Potter和J.K.Rowling的关系来预测出Harry的。

改进1:Knowledge Integration

具体的,把MASK分成三部分

Basic-level Masking:与BERT一样

Entity-level Masking:把实体作为一个整体MASK,例如J.K.Rowling这个词作为一个实体,被一起【MASK】

Phrase-Level Masking:把短语作为一个整体MASK,如a series of作为一个短语整体,被一起【MASK】

不过论文好像没有详细讲这几种Masking分别的比例?

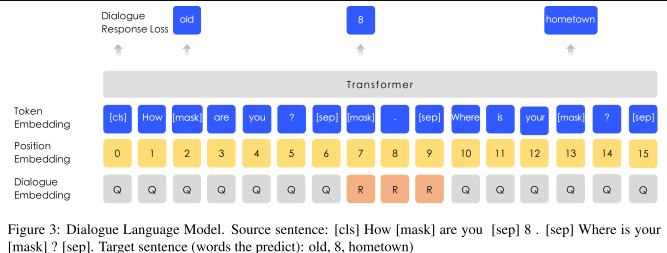

改进2:Dialogue Language Model(DLM)

增加了对话数据的任务,如下图所示,数据不是单轮问答的形式(即问题+答案),而是多轮问答的数据,即可以是QQR、QRQ等等。同上面一样,也是把里面的单token、实体、短语【MASK】掉,然后预测它们,另外在生成数据的时,有一定几率用另外的句子替代里面的问题和答案,所以模型还要预测是否是真实的问答对。论文提到DLM任务能让ERNIE学习到对话中的隐含关系,增加模型的语义表达能力。

注意看Segment Embedding被Dialogue Embedding代替了,但其它结构跟MLM模型是一样的,所以可以和MLM任务联合训练。

数据集

用了四个数据集,分别是中文维基百科、百度百科、百度新闻、百度贴吧,其中百度贴的每个帖子可以认为是对话数据,所以百度贴吧的数据用于DLM任务。

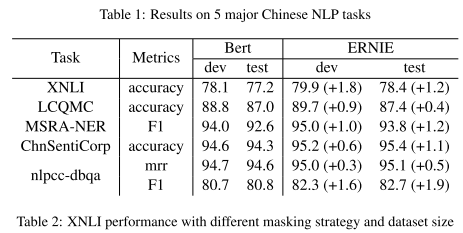

实验结果

在五个数据集上,表现都比Bert好。

ERNIE 2.0

论文全称及链接:《ERNIE 2.0: A Continual Pre-Training Framework for Language Understanding》[5]

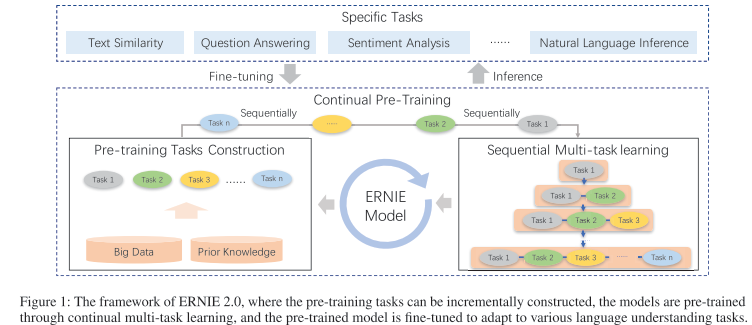

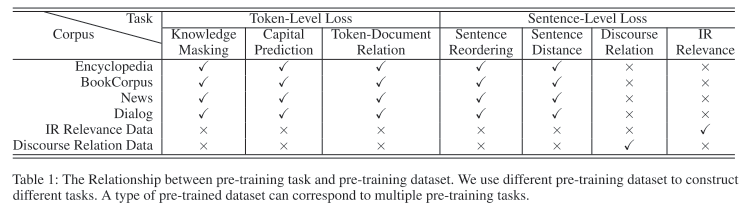

ERNIE2.0的结构与 ERNIE1.0 、BERT 的结构一样,ERNIE2.0 主要是从修改预训练的学习任务来提升效果。从BERT推出,到现在被广泛使用也有近三年的时间,这几年也有不少其它预训练模型的出现,它们大部分干的一件事就是「提出难度更大、更多样化的预训练任务,从而增加模型的学习难度,让模型有更好的词语、语法、语义的表征能力」!ERNIE2.0正是如此,构建了三种类型的无监督任务。为了完成多任务的训练,又提出了连续多任务学习,整体框架见下图。

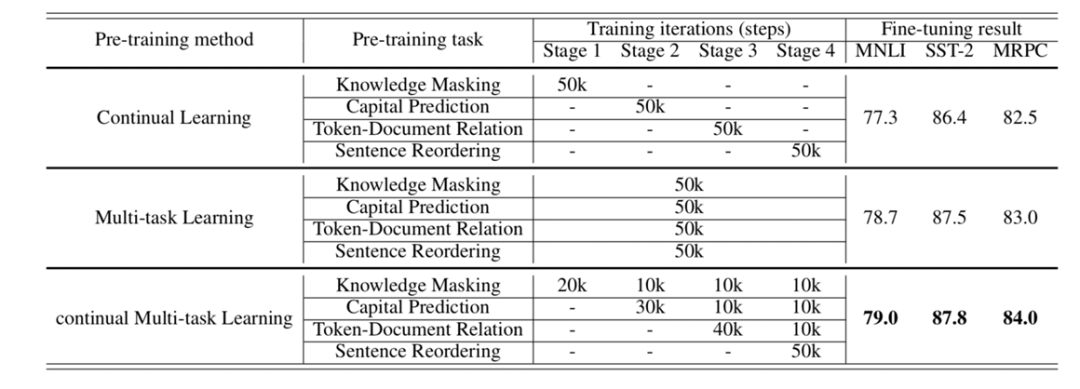

改进1:连续多任务学习

假如让模型同时学3个任务(就是目前比较火的联合训练),你会怎么训练?这里提供三种策略:

策略一,Multi-task Learning,就是让模型同时学这3个任务,具体的让这3个任务的损失函数权重双加,然后一起反向传播;

策略二,先训练任务1,再训练任务2,再训练任务3,这种策略的缺点是容易遗忘前面任务的训练结果,如最后训练出的模型容易对任务3过拟合;

策略三:连续多任务学习,即第一轮的时候,先训练任务1,但不完全让他收敛训练完,第二轮,一起训练任务1和任务2,同样不让模型收敛完,第三轮,一起训练三个任务,直到模型收敛完。

论文里采用的就是策略三的思想。

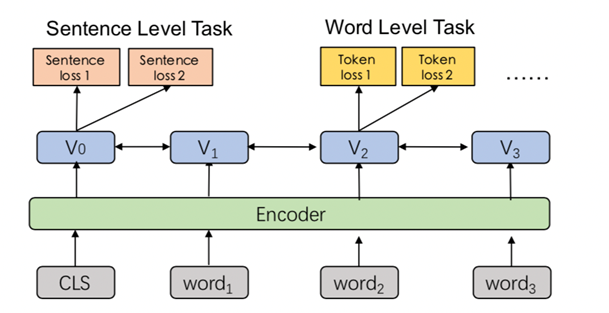

具体的,如下图所示,每个任务有独立的损失函数,句子级别的任务可以和词级别的任务一起训练,相信做过联合训练的同学并不陌生!

改进2:更多的无监督预训练任务

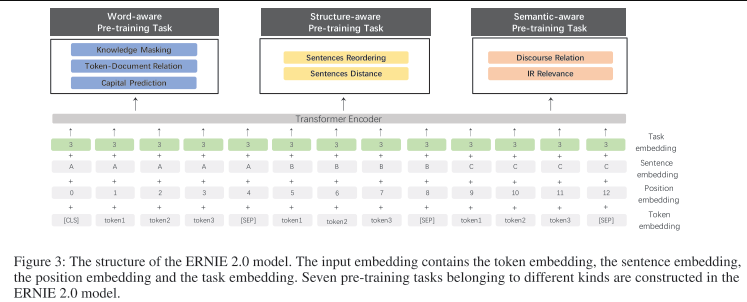

模型的结构如下图所示,由于是多任务学习,模型输入的时候额外多了一个Task embedding。

具体的三种类型的无监督训练任务是哪三种呢?每种里面又包括什么任务呢?

任务一:词法级别预训练任务

Knowledge Masking Task:这任务同ERNIE 1.0一样,把一些字、短语、实体【MASK】掉,预测【MASK】词语。

Capitalization Prediction Task:预测单词是大写还是小写,大写出现在实体识别等,小写可用于其他任务。

Token-Document Relation Prediction Task:在段落A中出现的token,是否在文档的段落B中出现。

任务二:语言结构级别预训练任务

Sentence Reordering Task:把文档中的句子打乱,识别正确顺序。

Sentence Distance Task:分类句子间的距离(0:相连的句子,1:同一文档中不相连的句子,2:两篇文档间的句子)。

任务三:语句级别预训练任务

Discourse Relation Task:计算两句间的语义和修辞关系。

IR Relevance Task:短文本信息检索关系,搜索数据(0:搜索并点击,1:搜素并展现,2:无关)。

请注意,这些任务全是「无监督的预训练任务」!

各任务用到的数据集

数据集包括百科、书籍、新闻、对话、检索数据、修辞关系数据。可以看到相对于ERNIE1.0,所用的数据更多样化了。注意的是,并非每类型数据都用到所有任务,如百科数据,就不用于训练语句级别的任务。

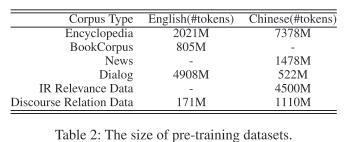

数据集的大小如下图所示。

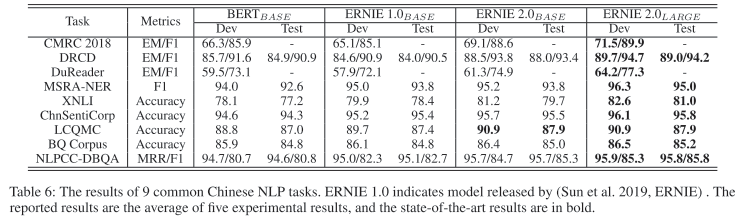

实验结果

训练完后,在9个中文数据集上分别进行fine-tunning,结果比BERT和ERNIE1.0要好。

连续多任务学习的效果

下表展示的就是连续多任务学习,看continual Multi-task Learing那一行所示,对于具体的某个任务,不是把它放在一个stage里面就让模型学习收敛完,而是一个连续学习的过程,避免模型遗忘。可以看到,连续多任务学习相比Continual Learing和Multi-task Learning的效果都要好。

五、ELECTRA

论文全称及链接:《ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators》[6]

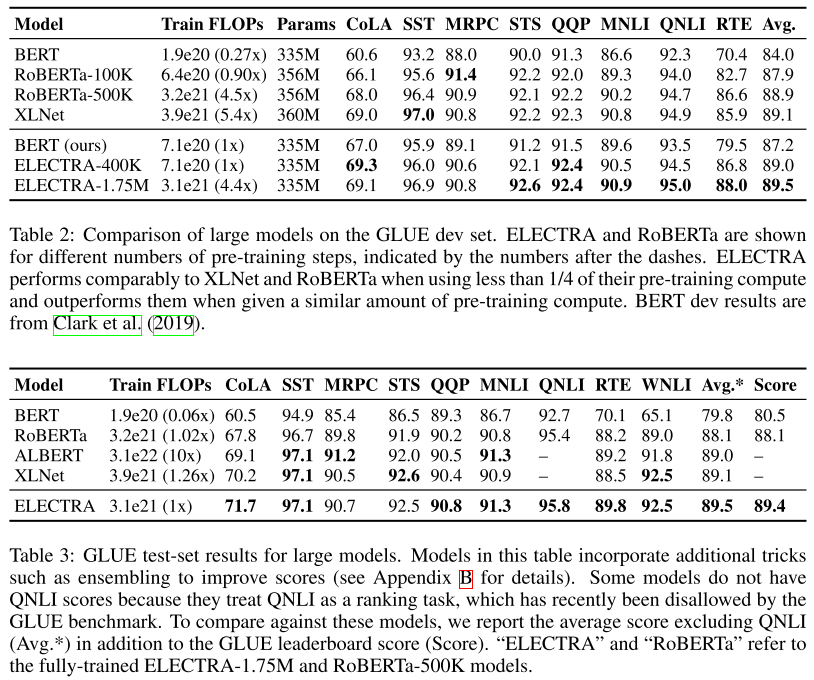

ELECTRA是这几年一个比较创新的模型,从模型架构和预训练任务都和BERT有一定程度的不同。ELECTRA的全称是Efficiently Learning an Encoder that Classifies Token Replacements Auucrately,在论文的开始指出了BERT训练的一个缺点,就是「学习效率太慢」,因为模型从一个样本中只能学习到15%的token信息,所以作者提出了一种新的架构让模型能学习到所有输入token的信息,而不仅仅是被【MASK】掉的tioken,这样模型学习效率会更好。作者指出,ELECTRA用相同的数据,达到和BERT、RoBERTa、XLNET相同效果所需要的训练轮数更少,假如使用相同的训练轮数,将超越上面所说的模型。

「但看哈工大发布的中文ELECTRA模型来看,发现并没有比BERT等要好,甚至在一些中文任务上表现反而要差了,对于这个模型,相信大家目前还是有很多争议的。」

新的架构:Generator-Discriminator的架构

ELECTRA的结构很简单,由一个Generator生成器和一个DIscriminator判别器组成,如下图所示。首先对一句话里面的token进行随机的【MASK】,然后训练一个生成器,对【MASK】掉的token进行预测,通常生成器不需要很大(原因在后面的实验部分有论证),生成器对【MASK】掉的token预测完后,得到一句新的话,然后输入判别器,判别器判断每个token,是否是原样本的,还是被替换过的。

注意的是,假如生成器预测出的token为原来的token,那这个token在判别器的输出标签里还是算原样本,而不是被替换过的(如下图的the,生成器预测为the,则the在判别器中的真实标签就为original,而不是replaced)。自此,整个模型架构的思想就介绍完了,是否很简单?

权重共享

假如生成器和判别器采用同样架构的话,则两个模型可以权重共享,假如不是同样架构的话,也可以共享embedding层。所以作者分别对以下三种情况做了实验:

生成器和判别器的参数独立,完全不共享;

生成器和判别器的embedding参数共享,而且生成器input层和output层的embedding参数共享(想想为什么可以这样?因为生成器最后是一个全词表的分类,所以可以跟输入时embedding矩阵的维度一致,而判别器最后是一个二分类,所以不能共享输入时的embedding矩阵),其他参数不共享;

生成器和判别器的参数共享。

第一种方案GLUE score为83.6,第二种方案GLUE score为84.3,第三种方案GLUE score为84.4,从结果上,首先肯定的是共享参数能带来效果的提升,作者给出的理由是,假如不共享参数,判别器只会对【MASK】的token的embedding进行更新,而生成器则会对全词表进行权重更新(这里有疑惑的可以想想,生成器最后可是做了一个全词表的分类哦),「所以共享参数肯定是必要的」,至于为什么作者最后采用方案二是不是方案三呢,是因为假如采用方案三的话,限定了生成器和判别器的模型结构要一样,极大影响了训练的效率。

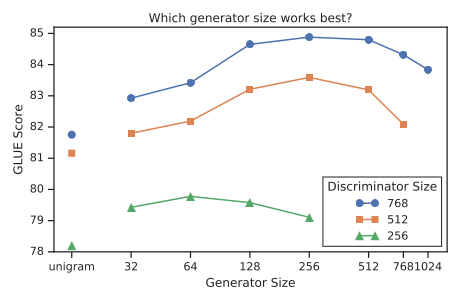

更小的生成器

如下图所示,作者发现最佳的生成器大小为判别器规模的1/4~1/2,作者给出的理由是假如生成器太强大的话,会让判别器难以学习。

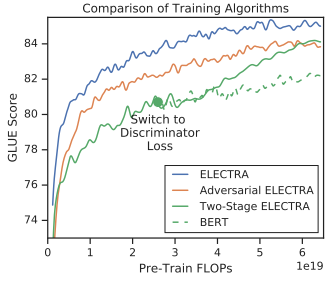

训练策略

作者提出了三种训练策略,结果如下图所示:

生成器和判别器联合训练;

二步训练,先训练生成器,再训练判别器;

引入对抗训练。

这里先不讨论对抗训练,先探讨策略一和策略二,作者发现,假如不采用权重共享的话,二步训练法训练完的判别器可能什么都学不到,作者提出的理由是判别器的学习晚生成器太多。除此之外,假如是参数共享,且采用二步法,在生成器刚学完,切换到判别器开始学的时候,GLUE score有一个显著的提升,理由可能是由于参数共享,所以判别器并不是从一个小白开始训练起。然并卵,实验发现联合训练在GLUE上的指标是最好的,所以最后也是采用联合训练方法。

模型效果对比

实验效果自然是又快又好咯。具体的就是,达到相同的效果,ELECTRA所需要的训练时间更少。同样训练相同的时间,ELECTRA将超越RoBERTa和XLNET等的效果。

学习效率分析

这是我认为该论文最精彩的一章,上面的实验证明了ELECTRA确实训练更加的高效,但究竟这是什么带来的?是的,虽然我们说BERT每次只需要预测15%的token,但无论如何,模型输入的同样是所有的input tokens啊。为此,作者进行了以下的实验(目的是严谨地证明判别器对每个token的二分类任务能极大的提高训练效率)

ELECTRA 15%:判别器不对每一个token计算二分类损失,而是只对在生成器输入时,被【MASK】掉的15%的token求损失;

Replace MLM:训练BERT MLM,其中input里的【MASK】使用ELECTRA生成器生成的token进行替换,目的是探讨只有预训练才出现【MASK】对模型的影响(因为大家吐槽BERT最多的就是,预训练里引入【MASK】,但在几乎所有的下游任务中输入都不会有【MASK】,这种预训练和fine tuning的不一致会影响模型效果);

All-Tokens MLM:同Replace MLM一样,用生成器生成的token来替换【MASK】,但BERT输出的时候,对每一个token进行预测,这个模型架构有点像是BERT和ELECTRA的结合。

实验结果如上表所示,首先比较 ELECTRA 和 ELECTRA 15%可以得出对每一个token进行二分类预测是能带来更好的效果的。然后,我们对比Replace MLM 和 BERT,可以得出,BERT预训练时引入【MASK】是给模型带来一定影响的。最后,我们发现ALL-tokens MLM最接近ELECTRA的效果。「总的来说,ELECTRA效果之那么好,大部分归功于对所有的token进行学习,其次是由于缓解了预训练和fine tuning时输入不一致的问题」。

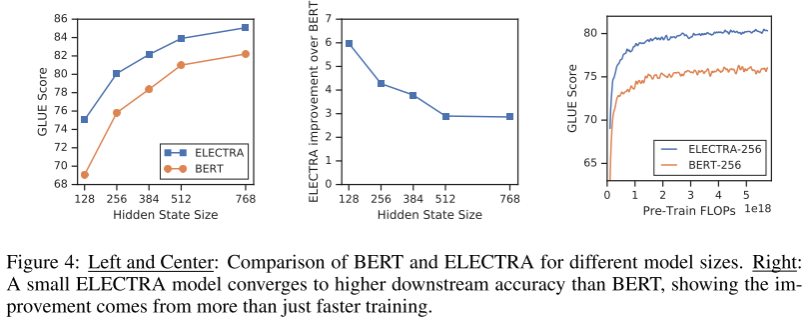

除此之外,如下图所示,作者还做实验发现,模型的规模越小,ELECTRA比BERT的效果就更好。作者认为是模型规模越小,ELECTRA就学习得越充分,越快收敛,因为本质上,ELECTRA判别器的二分类任务就比BERT的预测词任务要简单。

本文参考资料

[1]

《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》: https://arxiv.org/pdf/1810.04805.pdf

[2]《RoBERTa: A Robustly Optimized BERT Pretraining Approach》: https://arxiv.org/pdf/1907.11692.pdf

[3]《ALBERT: A Lite BERT for Self-supervised Learning of Language Representations》: https://arxiv.org/pdf/1909.11942.pdf

[4]《ERNIE: Enhanced Representation through Knowledge Integration》: https://arxiv.org/pdf/1904.09223.pdf

[5]《ERNIE 2.0: A Continual Pre-Training Framework for Language Understanding》: https://ojs.aaai.org//index.php/AAAI/article/view/6428

[6]《ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators》: https://arxiv.org/pdf/2003.10555.pdf

- END -

往期精彩回顾

适合初学者入门人工智能的路线及资料下载机器学习及深度学习笔记等资料打印机器学习在线手册深度学习笔记专辑《统计学习方法》的代码复现专辑

AI基础下载机器学习的数学基础专辑温州大学《机器学习课程》视频

本站qq群851320808,加入微信群请扫码:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?