点击下方“AI算法与图像处理”,一起进步!

重磅干货,第一时间送达

大家好,今天跟大家分享 ICCV 2021 的论文成果,主要包含五篇内容的简介:

基于Transformer 的分割方法;

用于场景文本识别的数据增强;

在线持续学习在食品视觉分类中的应用;

用于视频插帧的非对称双边运动估计;

遮挡感知视频对象修复

更多ICCV 2021 最新工作(目前已更新 250+论文):

https://github.com/DWCTOD/ICCV2021-Papers-with-Code-Demo

SOTR: Segmenting Objects with Transformers

基于Transformer 的分割方法

论文:https://arxiv.org/abs/2108.06747

代码:https://github.com/easton-cau/SOTR

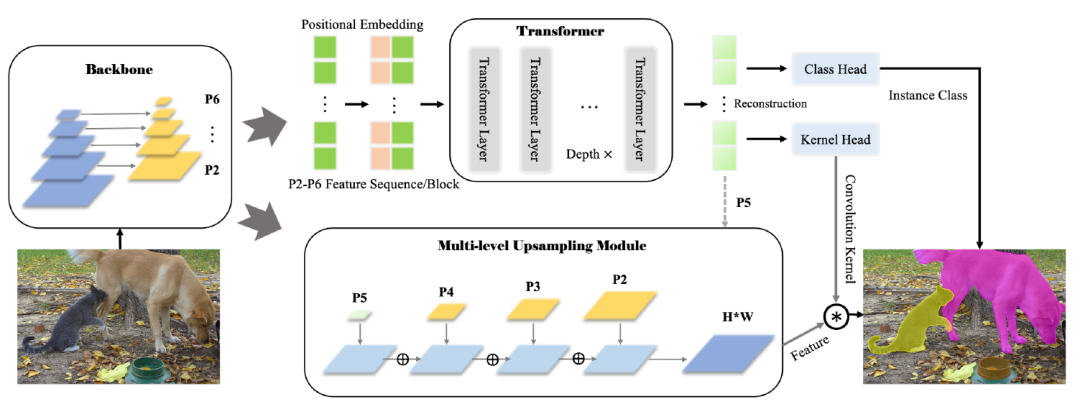

摘要:最新的基于Transformer的模型在视觉任务上表现出令人印象深刻的性能,甚至比卷积神经网络(CNN)更好。在这项工作中,我们提出了一种新颖、灵活、有效的基于Transformer 的高质量实例分割模型。所提出的Segmenting Objects with Transformers(SOTR)的方法简化了分割pipeline,建立在一个附加有两个并行子任务的CNN主干上:

(1)通过Transformer 预测每个实例的类别;

(2)使用多级上采样模块动态生成分割掩码。

SOTR可以分别通过特征金字塔网络(FPN)和twin transformer有效地提取底层特征表示,并捕获长期上下文依赖。同时,与原Transformer 相比,该双Transformer 在时间和资源上都是高效的,因为只需要注意一行和一列来编码像素。此外,SOTR易于与各种CNN主干和Transformer模型变体结合,从而大大提高分割精度和训练收敛性。大量实验表明,我们的SOTR在MS COCO数据集上表现良好,超过了最先进的实例分割方法。我们希望我们简单但强大的框架可以作为实例级识别的首选基线。

Data Augmentation for Scene Text Recognition

用于场景文本识别的数据增强

论文:https://arxiv.org/abs/2108.06946

代码:https://github.com/roatienza/straug

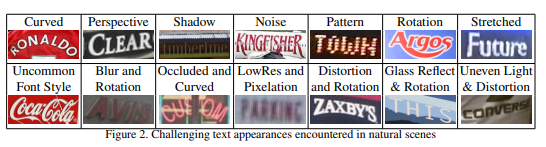

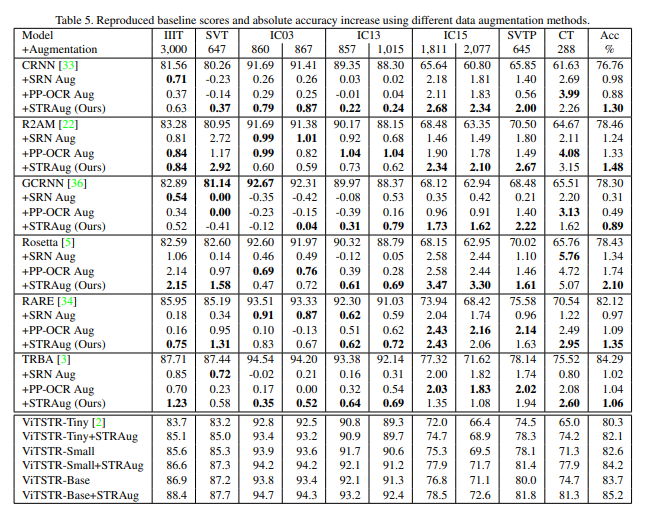

摘要:由于自然场景中可能出现大量文本,因此场景文本识别(STR)是计算机视觉中一项具有挑战性的任务。大多数STR模型依赖于合成数据集进行训练,因为没有足够大且公开可用的标记真实数据集。由于STR模型是使用真实数据进行评估的,因此训练和测试数据分布之间的不匹配导致模型性能不佳,特别是在受噪声、伪影、几何、结构等影响的具有挑战性的文本上,我们介绍了STRAug,它由36个为STR设计的图像增强函数组成。每个函数都模拟了某些文本图像属性,这些属性可以在自然场景中找到,由摄像机传感器引起,或由信号处理操作引起,但在训练数据集中表现不佳。当使用RandAugment应用于强基线模型时,STRAug显著提高了常规和不规则测试数据集STR模型的整体绝对准确度,Rosetta为2.10%,R2AM为1.48%,CRNN为1.30%,RARE为1.35%,TRBA为1.06%,GCRNN为0.89%。STRAug函数提供的API的多样性和简单性使STRAug的现有数据扩充方法易于复制和验证。

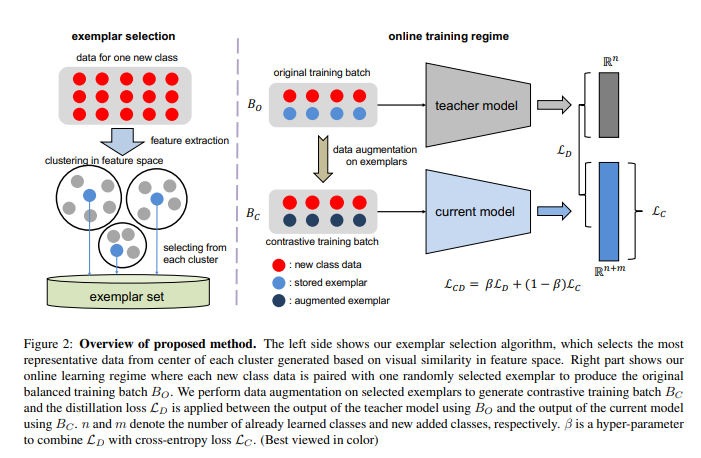

Online Continual Learning For Visual Food Classification

在线持续学习在食品视觉分类中的应用

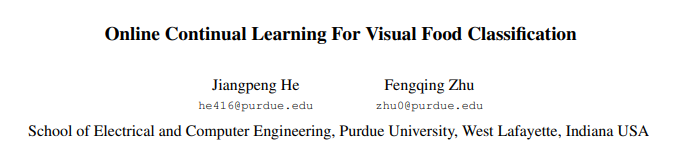

论文:https://arxiv.org/abs/2108.06781

摘要:食品图像分类对于现实世界的应用是一个挑战,因为现有的方法需要静态数据集进行训练,并且不能从连续可用的新食品图像中学习。在线持续学习旨在从数据流中学习新课程,只使用一次新数据,而不忘记以前学习的知识。然而,现有的研究都没有针对食品图像分析的,食品图像分析由于其高度的类内变异性以及未来食品类分布的不平衡性和不可预测性而更难以增量学习。在本文中,我们通过引入(1)一种新的基于聚类的样本选择算法来解决这些问题,该算法存储属于每个学习食物的最具代表性的数据,用于知识回放;(2)一个有效的在线学习机制,使用平衡的训练批以及增广样本上的知识提炼,以保持模型在所有学习类上的性能。我们的方法是在一个具有挑战性的大型食品图像数据库food-1K上通过改变新添加的食品类别的数量进行评估的。我们的研究结果表明,与现有最先进的在线持续学习方法相比,该方法有了显著的改进,显示出在现实世界中实现食品图像分类终身学习的巨大潜力。

Asymmetric Bilateral Motion Estimation for Video Frame Interpolation

用于视频插帧的非对称双边运动估计

论文:https://arxiv.org/abs/2108.06815

代码:https://github.com/JunHeum/ABME

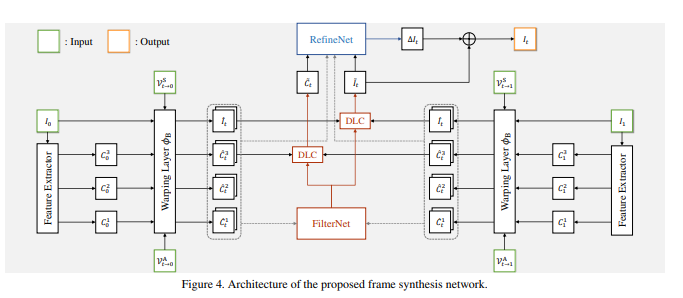

摘要:我们提出了一种新的基于非对称双边运动估计(ABME)的视频插帧算法,该算法在两个输入帧之间合成一个中间帧。

第一,我们预测对称的双边运动场来插值锚框架。

第二,我们估计从锚帧到输入帧的不对称双边运动场。

第三,我们使用非对称场向后扭曲输入帧并重建中间帧。

最后,为了细化中间帧,我们开发了一个新的合成网络,该网络使用局部和全局信息生成一组动态滤波器和一个剩余帧。

实验结果表明,该算法在各种数据集上都取得了良好的性能。

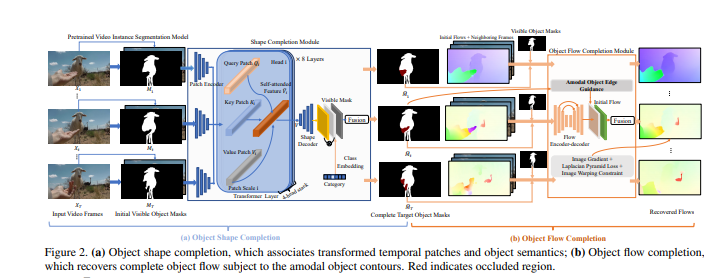

Occlusion-Aware Video Object Inpainting

遮挡感知视频对象修复

https://arxiv.org/abs/2108.06765

摘要:传统的视频修复既不是面向对象的,也不是遮挡感知的,这使得在修复大的遮挡对象区域时容易产生明显的伪影。该文提出了一种基于遮挡的视频对象修复方法,该方法在给定遮挡对象可见遮罩分割的情况下,恢复视频中遮挡对象的完整形状和外观。为了促进这项新的研究,我们构建了第一个大规模视频对象修复基准YouTube VOI,以提供具有遮挡和可见对象遮罩的真实遮挡场景。我们的技术贡献VOIN联合执行视频对象形状完成和遮挡纹理生成。特别是,形状完成模块建模远程对象一致性,而流完成模块恢复具有尖锐运动边界的精确流,以便跨帧将时间一致的纹理传播到同一运动对象。为了获得更真实的结果,我们使用T-PatchGAN和一种新的基于时空注意的多类鉴别器对VOIN进行了优化。最后,我们在YouTube VOI上比较VOIN和强基线。实验结果清楚地证明了我们的方法的有效性,包括修复复杂和动态对象。VOIN随着不准确的输入可见遮罩而优雅地降解。

努力分享优质的计算机视觉相关内容,欢迎关注:

个人微信(如果没有备注不拉群!)

请注明:地区+学校/企业+研究方向+昵称

下载1:何恺明顶会分享

在「AI算法与图像处理」公众号后台回复:何恺明,即可下载。总共有6份PDF,涉及 ResNet、Mask RCNN等经典工作的总结分析

下载2:终身受益的编程指南:Google编程风格指南

在「AI算法与图像处理」公众号后台回复:c++,即可下载。历经十年考验,最权威的编程规范!

下载3 CVPR2021

在「AI算法与图像处理」公众号后台回复:CVPR,即可下载1467篇CVPR 2020论文 和 CVPR 2021 最新论文

5384

5384

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?