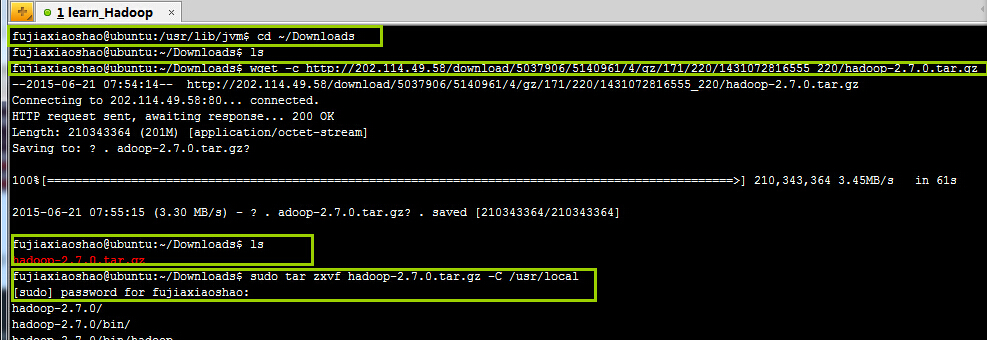

首先进入Downloads文件夹,执行wget -c URL 命令将Hadoop2.7下载到Downloads文件夹

然后如上图,等下载完毕后查看Downloads文件夹中已经有hadoop-2.7.0.tar.gz

此时执行sudo tar zxvf hadoop-2.7.0.tar.gz -C /usr/local 将压缩包解压包了local文件夹下。

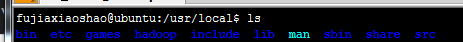

接着进入/usr/local,并查看hadoop文件夹存在

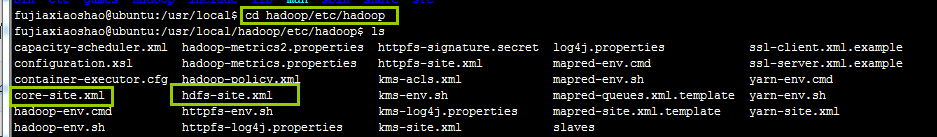

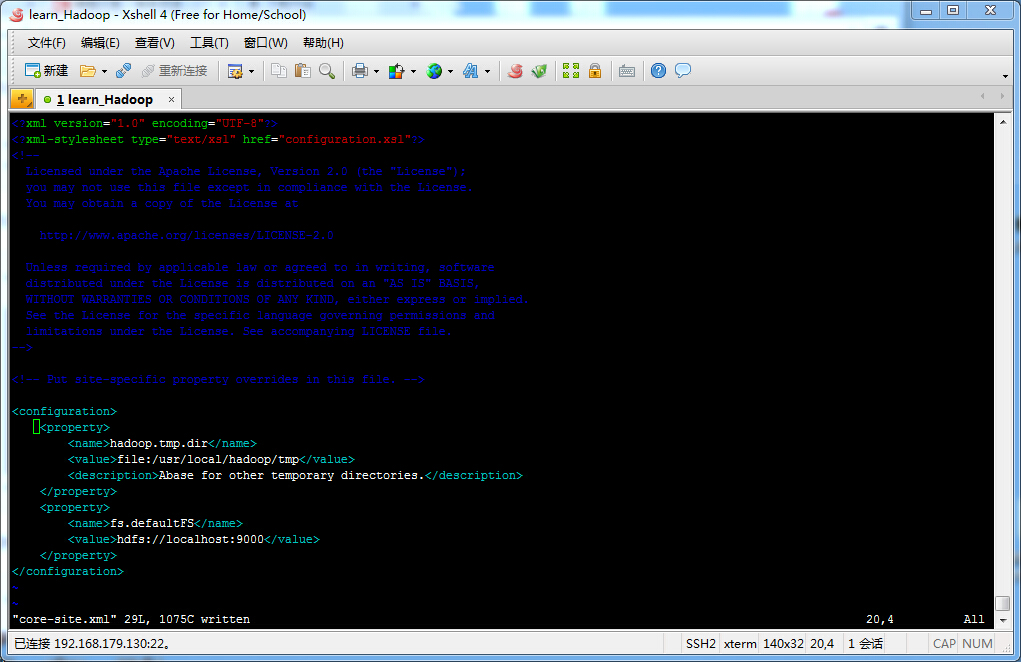

进入如下目录,修改被圈起来的两个文件:

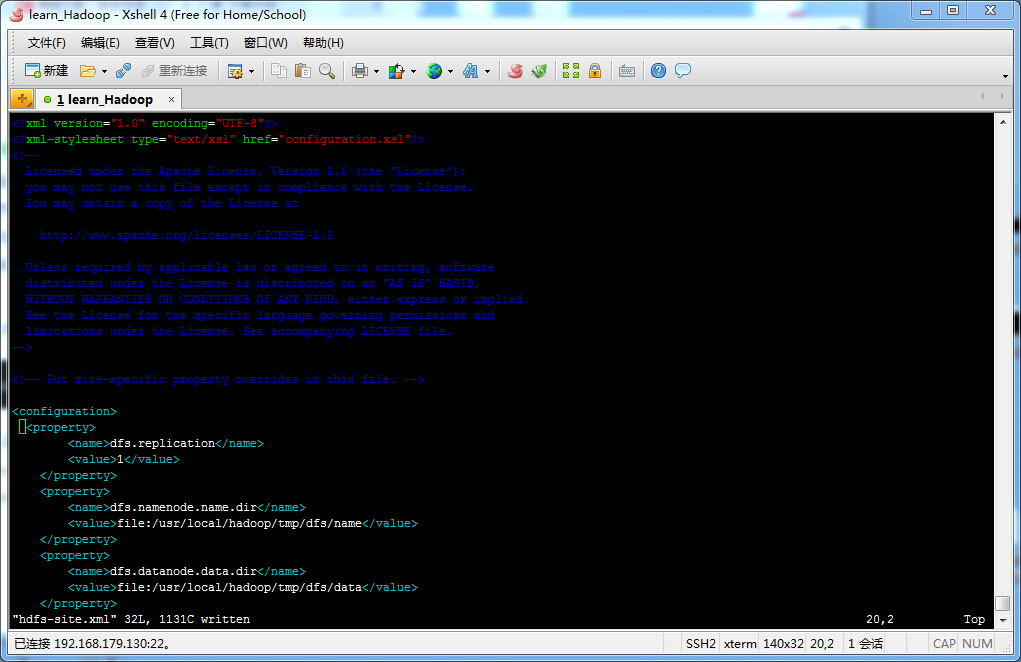

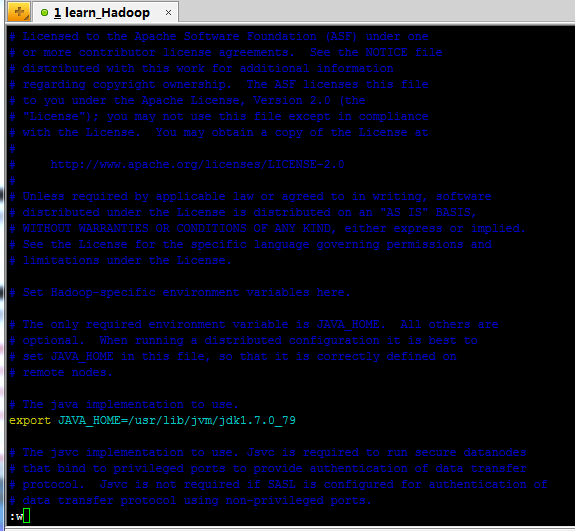

将原始内容改为如下:

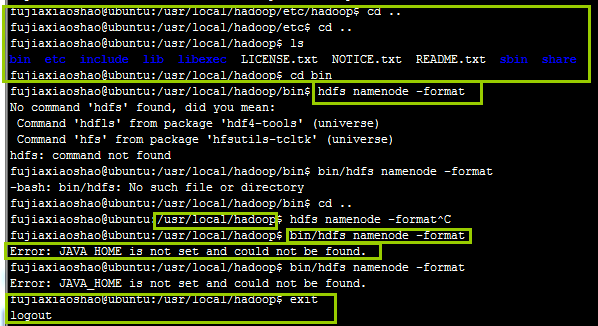

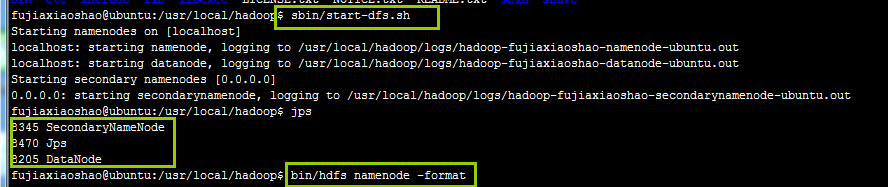

此时退出到hadoop文件夹下,再次进去到bin目录,执行hdfs namenode -format,结果找不到命令如下图:

然后退回hadoop目录,执行bin/hdfs namenode -format,结果显示找不到java路径,于是怀疑是jdk配置还未生效,输入exit退出。

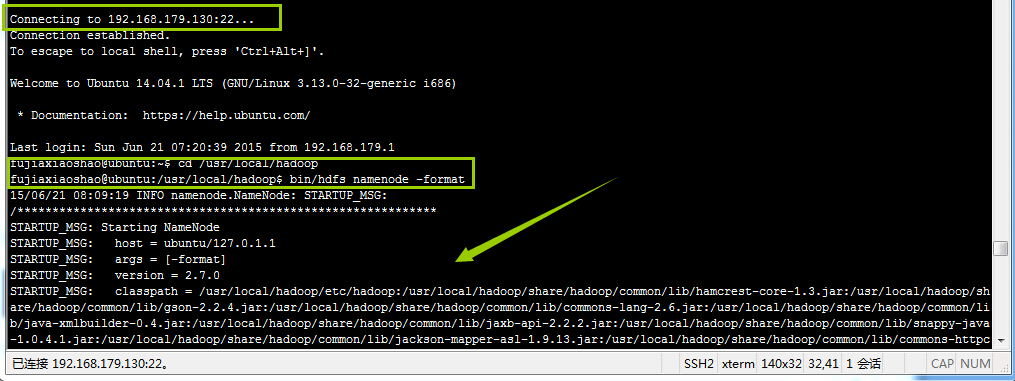

如下图重新登录。

进入hadoop目录后执行之前的命名,根据箭头处显示,格式化namenode成功。

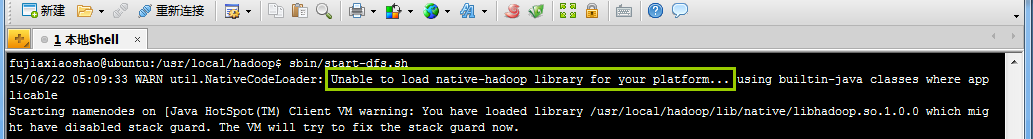

接下来执行 sbin/start-dfs.sh,开启节点,结果报错,如下

经分析原因是,虚拟机是32位,jdk32位,结果hadoop64位,于是找别人要到了重新编译的32位,并重新配置到上一步。网址:http://pan.baidu.com/s/1c0rW6Vu

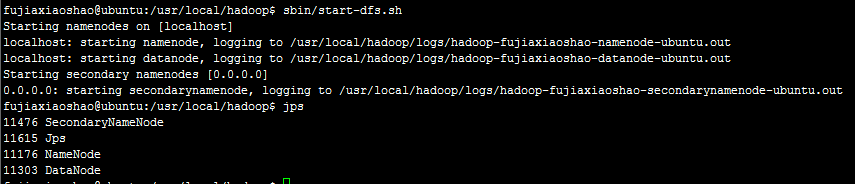

于是继续执行sbin/start-dfs.sh

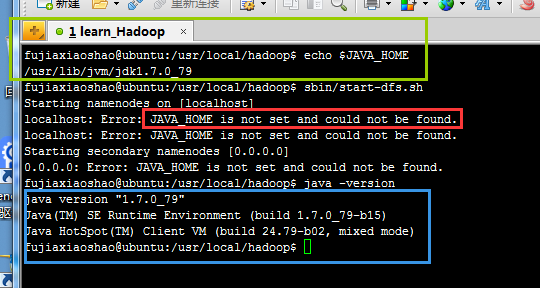

结果JAVA_HOME没问题的情况下显示找不到JAVA_HONE,于是发现需要在etc/hdoop/hadoop-env.sh 中设置JAVA_HOME如下

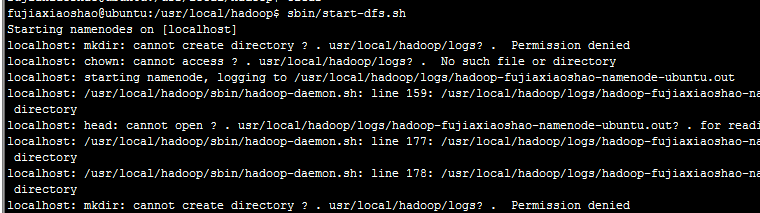

保存后,退回hadoop目录,执行sbin/start-dfs.sh

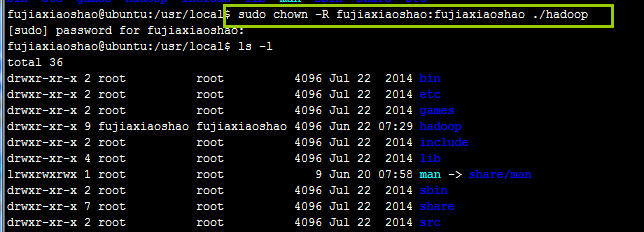

发现是权限问题(刚开始准备使用sudo管理员权限执行,但是不知道root用户的密码,所以采用:),于是将hadoop文件夹的权限分配给fujiaxiaoshao,如下:

成功分配权限后,

发现不能直接开启进程,需要重新格式化namenode,否则,namenode无法正常开启

于是重新格式化namenode,开启进程后发现datanode没有成功开启,查看datanode的日志,报错,百度,如下网址解决:

http://www.cnblogs.com/kinglau/p/3796274.html/usr/local/hadoop/tmp/dfs/name

重新开启后成功!

备注:需要学会看日志,日志提示报错内容。

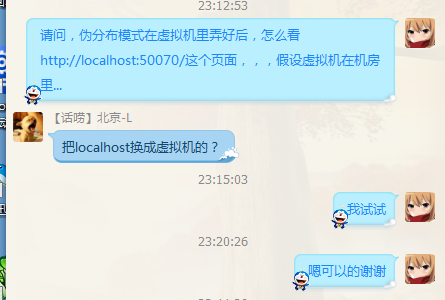

远程查看:

另外需要对目录权限有所注意,把目录权限分配给特定用户。

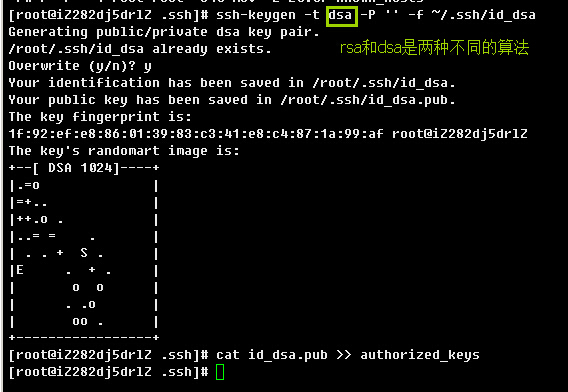

SSH免密码登陆

136

136

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?