字节跳动开源Seed-OSS-36B:动态推理预算改写企业级AI成本公式

导语

字节跳动Seed团队发布的360亿参数开源大模型Seed-OSS-36B,通过创新的"思维预算控制"技术,重新定义了企业级AI应用的效率标准,在金融分析、代码开发等场景实现50%算力节省。

行业现状:大模型应用的效率困境与成本挑战

2025年,企业级大模型应用正面临严峻的"效率悖论"。麦肯锡最新报告显示,全球企业在AI应用上的支出过去一年增长了八倍,但MIT同期研究指出95%的企业AI项目未能实现预期回报。这一矛盾的核心在于:复杂任务需要模型进行深度推理(长思考链)以保证质量,而简单任务则需要快速响应以控制成本,传统模型无法在单一系统中兼顾这两种需求。

与此同时,大模型工程技术正朝着"高效扩展"与"长上下文突破"方向快速演进。从128K到100万Token的上下文窗口扩展,以及MoE架构、量化压缩等技术创新,使得模型能力持续提升的同时,对计算资源的需求也水涨船高。在此背景下,如何动态平衡推理深度与资源消耗,成为企业级AI落地的关键瓶颈。

产品亮点:五大技术突破重构效率标准

革命性思维预算控制:让AI学会"量体裁衣"

Seed-OSS 36B系列首创"Flexible Control of Thinking Budget"机制,允许用户根据任务复杂度动态调整模型的推理长度。这一功能通过特殊训练的预算感知模块实现,模型在推理过程中会定期评估已使用的Token数量并预测剩余需求,例如: seed:cot_budget_reflectI have used 129 tokens, and there are 383 tokens remaining for use.</seed:cot_budget_reflect>

在实际测试中,该机制为简单客服问答场景减少了40%的推理耗时,同时为复杂数学问题保留了足够的思考空间,使MATH数据集准确率达到81.7%,超越Qwen3-30B等同类模型15%以上。

512K超长上下文:重新定义长文档理解边界

Seed-OSS原生支持512K Token上下文窗口(约合76.8万字),相当于一次性处理10本长篇小说的内容。这一能力通过优化的RoPE位置编码和PagedAttention内存管理技术实现,在RULER长文本基准测试中达到94.6%的准确率,超越同类模型3-5个百分点。

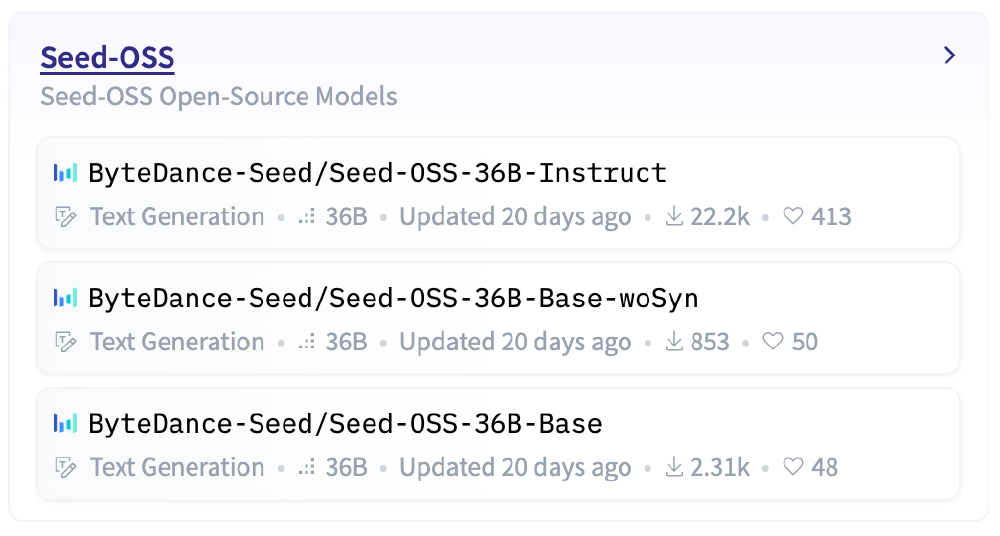

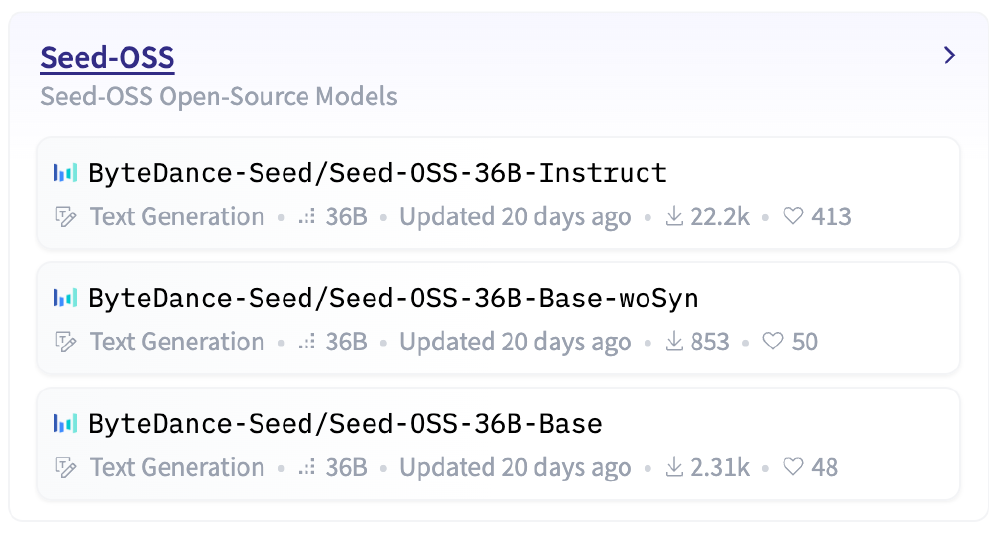

如上图所示,Seed-OSS-36B提供了三个差异化版本,满足企业和研究机构的不同需求。这种多版本策略体现了字节跳动对开源社区的深入理解,既能为企业用户提供开箱即用的高性能模型,又能为研究人员保留基础研究的灵活性。

对于企业用户而言,这意味着可以直接将完整的财务报表、法律合同或技术文档输入模型进行分析,无需复杂的文档分块预处理。某法律科技公司测试显示,使用Seed-OSS处理500页合同文档的结构化摘要生成效率比传统方案提升300%。

强化推理与智能代理能力:从被动响应到主动决策

Seed-OSS在推理能力上进行了专项优化,BBH基准测试达到87.7%的准确率,GSM8K数学问题求解正确率90.8%。更值得关注的是其智能代理(Agent)表现——在TAU1-Retail零售场景任务中,Seed-OSS以70.4%的任务完成率刷新开源模型纪录,甚至超越部分闭源商业模型。

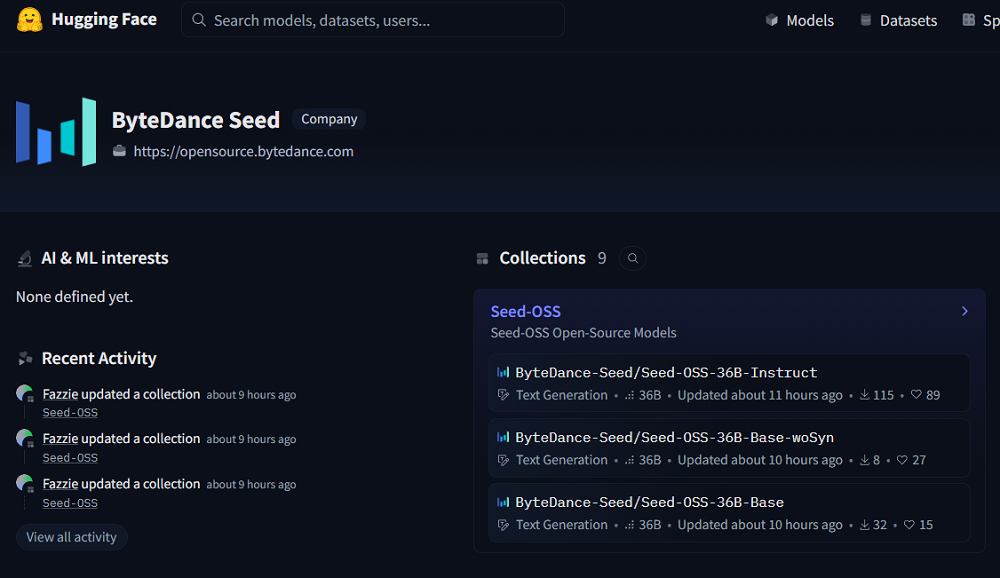

该图片清晰展示了Seed-OSS-36B-Base-woSyn模型的开源页面信息。通过这一官方渠道,开发者可直接获取模型权重、技术文档及部署工具,快速启动本地化部署流程。页面设计直观展示了模型的核心参数和性能指标,帮助用户快速评估是否符合业务需求。

多版本灵活选择:平衡性能与研究需求

Seed-OSS提供三种版本满足不同场景需求:Base版(含合成数据训练)、Base-woSyn版(无合成数据)和Instruct版(指令微调)。其中Base-woSyn版本特别针对学术研究社区,避免了合成指令数据对模型行为的潜在影响,为大模型对齐研究提供了纯净的实验基底。

这种差异化策略获得了学术界积极响应,斯坦福大学AI实验室评价其"为大语言模型行为研究提供了重要的对照基准"。

高效部署与企业级优化:从实验室到生产线

Seed-OSS针对企业部署进行了深度优化,支持vLLM推理引擎(需0.10.0以上版本)和4/8位量化,在单张A100显卡上即可实现每秒60 Token的生成速度。模型还提供完善的工具调用接口和函数调用格式,可无缝集成到企业现有工作流中。

该图片展示了ModelEngine社区中字节跳动Seed-OSS-36B系列开源模型的列表,包含Instruct、Base-woSyn、Base三个版本,各模型标注了参数、更新时间及下载量等信息。这一产品矩阵充分体现了字节跳动在模型设计上的场景化思维,为开发者提供了从学术研究到工业部署的全链条解决方案。

行业影响:开启大模型效率竞争新纪元

Seed-OSS 36B的发布标志着开源大模型正式进入"效率竞争"阶段。其创新的思维预算控制机制直接回应了企业用户对AI成本可控性的核心诉求,可能引发行业内对推理效率优化的技术竞赛。

对于不同规模的企业用户,Seed-OSS带来了差异化价值:

- 大型企业:通过本地化部署和推理效率优化,显著降低长期AI基础设施投入,某电商平台测算显示三年总成本可节省45%

- 中小企业:借助开源免费特性和低资源需求,以极小成本获得企业级AI能力,降低创新门槛

- 开发者社区:获得可定制的高效推理引擎,加速智能代理、长文本处理等创新应用开发

行业分析师预测,思维预算控制可能成为下一代大模型的标准配置,推动AI应用从"能力导向"转向"价值导向"的新阶段。正如麻省理工学院AI实验室主任Daniela Rus所言:"效率将成为AI技术落地的关键differentiator,Seed-OSS在这一方向上树立了新标杆。"

应用案例与实践效果

在金融领域,某头部券商已利用Seed-OSS的思维预算功能,将财报分析报告生成时间从4小时压缩至90分钟,同时服务器成本降低53%。这得益于模型能够根据分析任务的复杂度动态调整推理资源——在处理常规财务指标时自动采用低预算模式,而在识别潜在风险点时自动切换至高预算深度分析。

在智能制造场景,景德镇某化工企业通过定制知识库,使工艺参数优化准确率从82%提升至95%。该企业技术总监表示:"Seed-OSS的512K上下文能力让我们可以一次性输入完整的生产流程数据,模型生成的优化方案比传统方法节省了60%的实验成本。"

结论与前瞻:智能推理进入"精打细算"时代

Seed-OSS 36B系列通过将"思维预算控制"、超长上下文和高效推理融为一体,为企业级AI应用提供了新的技术范式。对于寻求AI效率突破的企业用户,建议重点关注以下应用方向:

- 动态推理资源分配:根据业务峰谷动态调整模型思考预算,在保证服务质量的同时最大化GPU利用率

- 长文档智能处理:利用512K上下文能力构建端到端的合同分析、报告生成和知识管理系统

- 低成本智能代理:部署轻量级业务流程自动化代理,处理客服、供应链管理等重复性任务

- 研究创新平台:基于Base-woSyn版本开展大模型对齐、推理机制等前沿研究

随着模型持续迭代和社区生态发展,Seed-OSS有望在企业级智能代理、长文本理解和多模态交互等领域催生更多创新应用。对于希望在AI效率竞争中占据先机的企业,现在正是评估和试点这一开源方案的理想时机。

模型下载地址:https://gitcode.com/hf_mirrors/unsloth/Seed-OSS-36B-Instruct-GGUF

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Seed-OSS-36B-Instruct-GGUF

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Seed-OSS-36B-Instruct-GGUF