如何利用matlab做BP神经网络分析(包括利用matlab神经网络工具箱)

转载:https://blog.csdn.net/xgxyxs/article/details/53265318

最近一段时间在研究如何利用预测其销量个数,在网上搜索了一下,发现了很多模型来预测,比如利用回归模型、时间序列模型,GM(1,1)模型,可是自己在结合实际的工作内容,发现这几种模型预测的精度不是很高,于是再在网上进行搜索,发现神经网络模型可以来预测,并且有很多是结合时间序列或者SVM(支持向量机)等组合模型来进行预测,本文结合实际数据,选取了常用的BP神经网络算法,其算法原理,因网上一大堆,所以在此不必一一展示,并参考了bp神经网络进行交通预测的Matlab源代码这篇博文,运用matlab 2016a,给出了下面的代码,并最终进行了预测

-

clc

-

-

clear all

-

-

close all

-

-

%bp 神经网络的预测代码

-

-

%载入输出和输入数据

-

-

load C:\Users\amzon\Desktop\p.txt;

-

-

load C:\Users\amzon\Desktop\t.txt;

-

-

%保存数据到matlab的工作路径里面

-

-

save p.mat;

-

-

save t.mat;%注意t必须为行向量

-

-

%赋值给输出p和输入t

-

-

p=p;

-

-

t=t;

-

-

%数据的归一化处理,利用mapminmax函数,使数值归一化到[-

1.1]之间

-

-

%该函数使用方法如下:[

y,ps] =mapminmax(

x,ymin,ymax),

x需归化的数据输入,

-

-

%ymin,ymax为需归化到的范围,不填默认为归化到[-

1,

1]

-

-

%返回归化后的值

y,以及参数ps,ps在结果反归一化中,需要调用

-

-

[p1,ps]=mapminmax(p);

-

-

[t1,ts]=mapminmax(t);

-

-

%确定训练数据,测试数据,一般是随机的从样本中选取

70%的数据作为训练数据

-

-

%15%的数据作为测试数据,一般是使用函数dividerand,其一般的使用方法如下:

-

-

%[trainInd,valInd,testInd] = dividerand(Q,trainRatio,valRatio,testRatio)

-

-

[trainsample.p,valsample.p,testsample.p] =dividerand(p,

0.

7,

0.

15,

0.

15);

-

-

[trainsample.t,valsample.t,testsample.t] =dividerand(t,

0.

7,

0.

15,

0.

15);

-

-

%建立反向传播算法的BP神经网络,使用newff函数,其一般的使用方法如下

-

-

%net = newff(minmax(p),[隐层的神经元的个数,输出层的神经元的个数],{隐层神经元的传输函数,输出层的传输函数},

'反向传播的训练函数'),其中p为输入数据,t为输出数据

-

-

%tf为神经网络的传输函数,默认为

'tansig'函数为隐层的传输函数,

-

-

%purelin函数为输出层的传输函数

-

-

%一般在这里还有其他的传输的函数一般的如下,如果预测出来的效果不是很好,可以调节

-

-

%TF1 =

'tansig';TF2 =

'logsig';

-

-

%TF1 =

'logsig';TF2 =

'purelin';

-

-

%TF1 =

'logsig';TF2 =

'logsig';

-

-

%TF1 =

'purelin';TF2 =

'purelin';

-

-

TF1=

'tansig';TF2=

'purelin';

-

-

net=newff(minmax(p),[

10,

1],{TF1 TF2},

'traingdm');%网络创建

-

-

%网络参数的设置

-

-

net.trainParam.epochs=

10000;%训练次数设置

-

-

net.trainParam.goal=

1e-

7;%训练目标设置

-

-

net.trainParam.lr=

0.

01;%学习率设置,应设置为较少值,太大虽然会在开始加快收敛速度,但临近最佳点时,会产生动荡,而致使无法收敛

-

-

net.trainParam.mc=

0.

9;%动量因子的设置,默认为

0.

9

-

-

net.trainParam.show=

25;%显示的间隔次数

-

-

% 指定训练参数

-

-

% net.trainFcn =

'traingd'; % 梯度下降算法

-

-

% net.trainFcn =

'traingdm'; % 动量梯度下降算法

-

-

% net.trainFcn =

'traingda'; % 变学习率梯度下降算法

-

-

% net.trainFcn =

'traingdx'; % 变学习率动量梯度下降算法

-

-

% (大型网络的首选算法)

-

-

% net.trainFcn =

'trainrp'; % RPROP(弹性BP)算法,内存需求最小

-

-

% 共轭梯度算法

-

-

% net.trainFcn =

'traincgf'; %Fletcher-Reeves修正算法

-

-

% net.trainFcn =

'traincgp'; %Polak-Ribiere修正算法,内存需求比Fletcher-Reeves修正算法略大

-

-

% net.trainFcn =

'traincgb'; % Powell-Beal复位算法,内存需求比Polak-Ribiere修正算法略大

-

-

% (大型网络的首选算法)

-

-

%net.trainFcn =

'trainscg'; % ScaledConjugate Gradient算法,内存需求与Fletcher-Reeves修正算法相同,计算量比上面三种算法都小很多

-

-

% net.trainFcn =

'trainbfg'; %Quasi-Newton Algorithms - BFGS Algorithm,计算量和内存需求均比共轭梯度算法大,但收敛比较快

-

-

% net.trainFcn =

'trainoss'; % OneStep Secant Algorithm,计算量和内存需求均比BFGS算法小,比共轭梯度算法略大

-

-

% (中型网络的首选算法)

-

-

%net.trainFcn =

'trainlm'; %Levenberg-Marquardt算法,内存需求最大,收敛速度最快

-

-

% net.trainFcn =

'trainbr'; % 贝叶斯正则化算法

-

-

% 有代表性的五种算法为:

'traingdx',

'trainrp',

'trainscg',

'trainoss',

'trainlm'

-

-

%在这里一般是选取

'trainlm'函数来训练,其算对对应的是Levenberg-Marquardt算法

-

-

net.trainFcn=

'trainlm';

-

-

[net,

tr]=train(net,trainsample.p,trainsample.t);

-

-

%计算仿真,其一般用sim函数

-

-

[normtrainoutput,trainPerf]=sim(net,trainsample.p,[],[],trainsample.t);%训练的数据,根据BP得到的结果

-

-

[normvalidateoutput,validatePerf]=sim(net,valsample.p,[],[],valsample.t);%验证的数据,经BP得到的结果

-

-

[normtestoutput,testPerf]=sim(net,testsample.p,[],[],testsample.t);%测试数据,经BP得到的结果

-

-

%将所得的结果进行反归一化,得到其拟合的数据

-

-

trainoutput=mapminmax(

'reverse',normtrainoutput,ts);

-

-

validateoutput=mapminmax(

'reverse',normvalidateoutput,ts);

-

-

testoutput=mapminmax(

'reverse',normtestoutput,ts);

-

-

%正常输入的数据的反归一化的处理,得到其正式值

-

-

trainvalue=mapminmax(

'reverse',trainsample.t,ts);%正常的验证数据

-

-

validatevalue=mapminmax(

'reverse',valsample.t,ts);%正常的验证的数据

-

-

testvalue=mapminmax(

'reverse',testsample.t,ts);%正常的测试数据

-

-

%做预测,输入要预测的数据pnew

-

-

pnew=[

313,

256,

239]

';

-

-

pnewn=mapminmax(pnew);

-

-

anewn=sim(net,pnewn);

-

-

anew=mapminmax('

reverse

',anewn,ts);

-

-

%绝对误差的计算

-

-

errors=trainvalue-trainoutput;

-

-

%plotregression拟合图

-

-

figure,plotregression(trainvalue,trainoutput)

-

-

%误差图

-

-

figure,plot(1:length(errors),errors,'-b

')

-

-

title('误差变化图

')

-

-

%误差值的正态性的检验

-

-

figure,hist(errors);%频数直方图

-

-

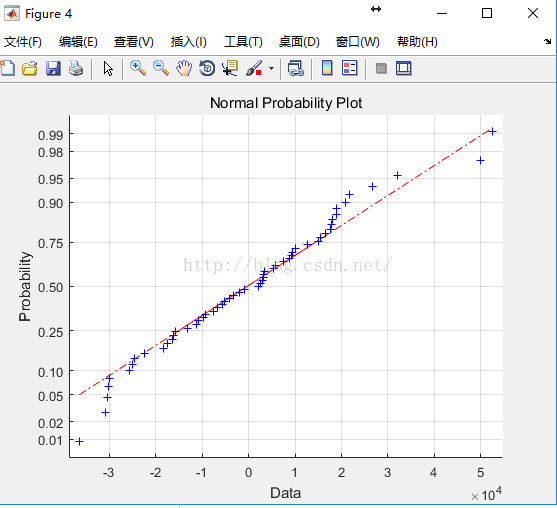

figure,normplot(errors);%Q-Q图

-

-

[muhat,sigmahat,muci,sigmaci]=normfit(errors);%参数估计 均值,方差,均值的0.95置信区间,方差的0.95置信区间

-

-

[h1,sig,ci]= ttest(errors,muhat);%假设检验

-

-

figure, ploterrcorr(errors);%绘制误差的自相关图

-

-

figure, parcorr(errors);%绘制偏相关图

运行之后的,结果如下:

BP神经网络的结果分析图

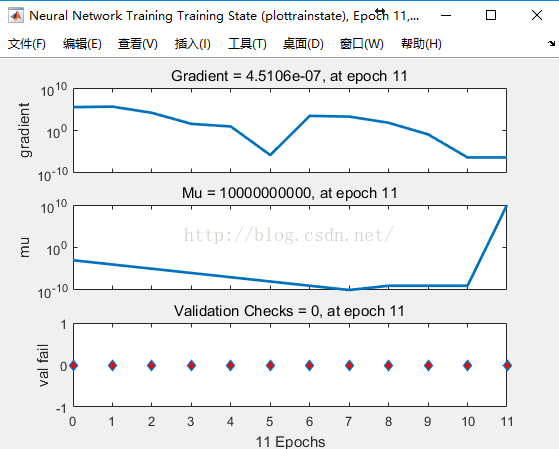

训练数据的梯度和均方误差之间的关系图

验证数据的梯度与学习次数

残差的正态的检验图(Q-Q图)

在网上,发现可以通过神经网络工具箱这个GUI界面来创建神经网络,其一般的操作步骤如下:

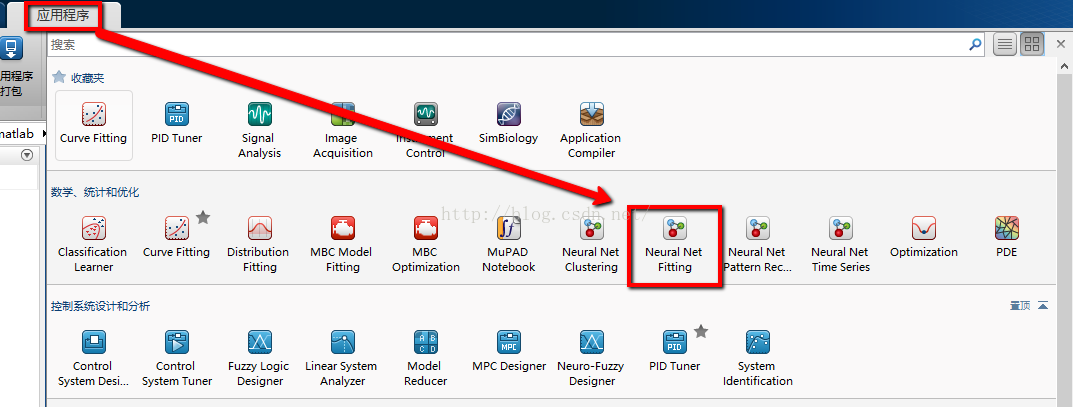

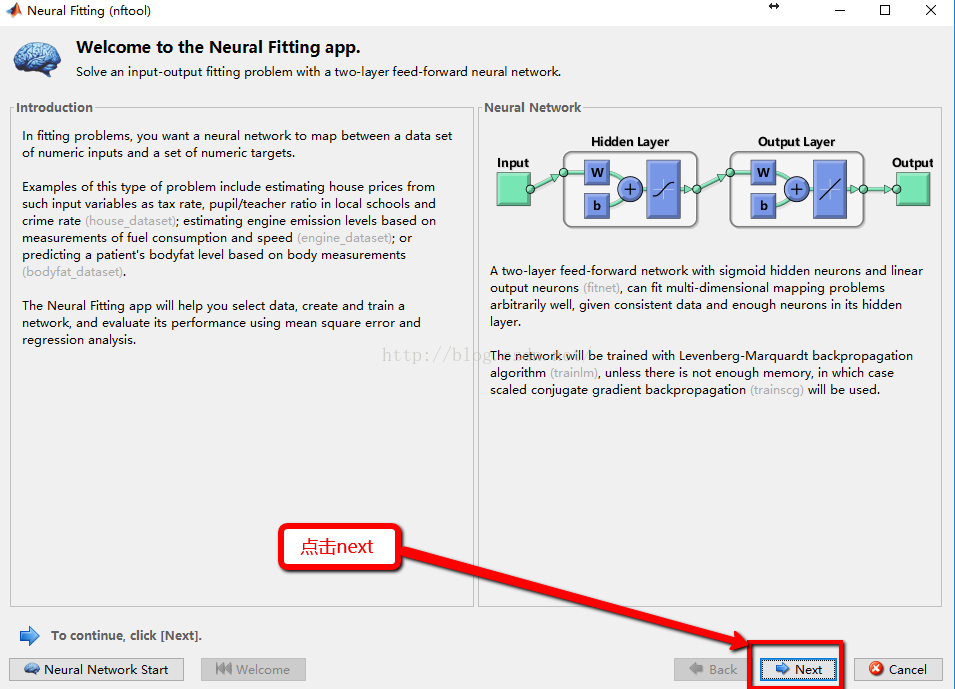

1:在输入命令里面输入nntool命令,或者在应用程序这个选项下找到Netrual Net Fitting 这个应用程序,点击打开,就能看见如下界面

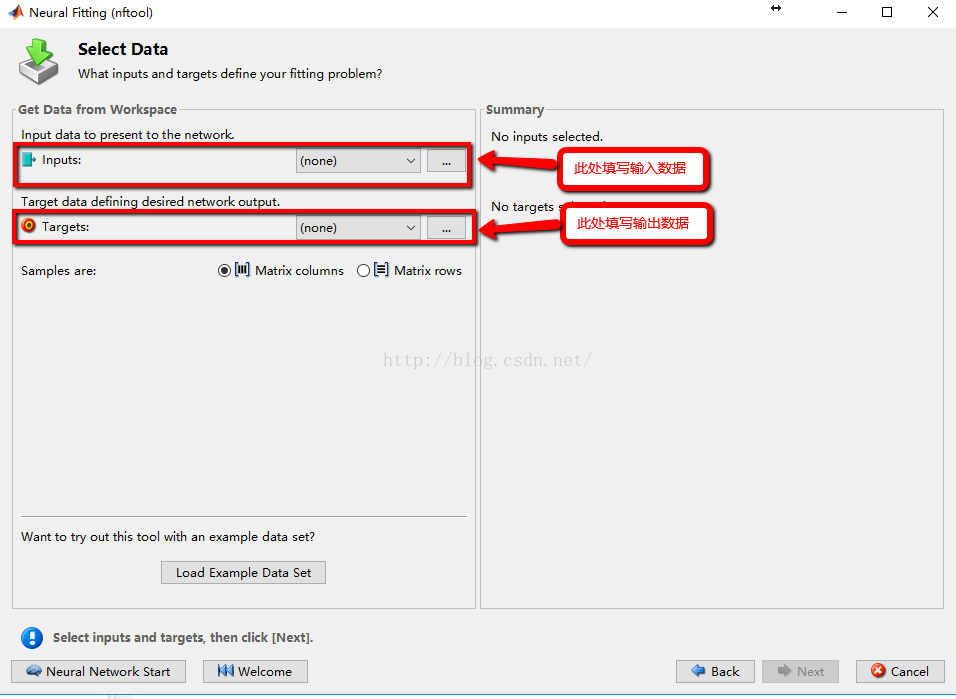

2:输入数据和输出数据的导入(在本文中选取了matlab自带的案例数据)

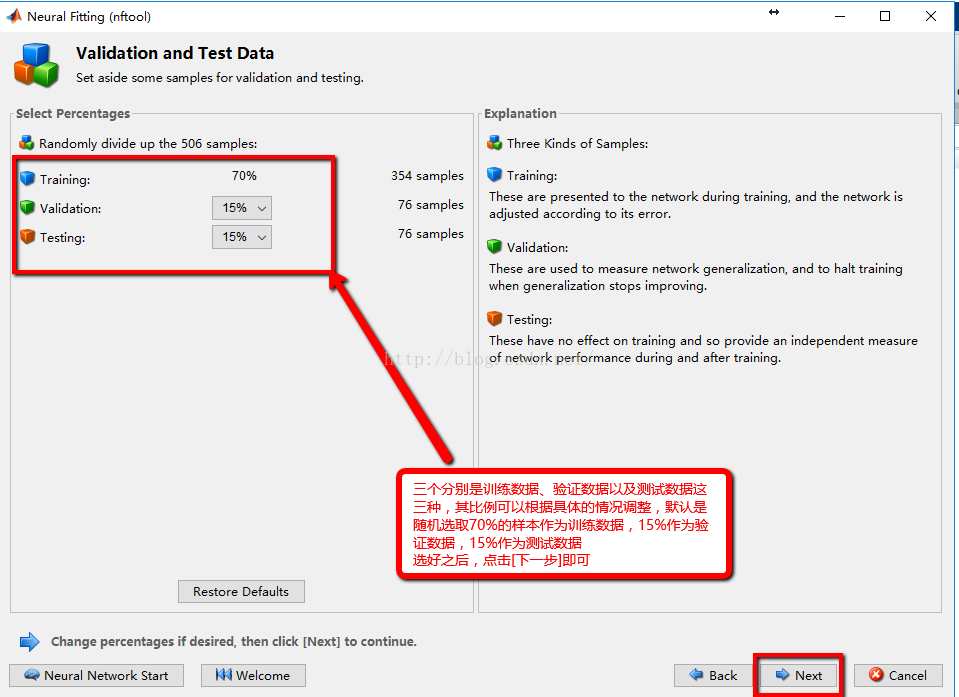

3:随机选择三种类型的数据所占的样本量的比例,一般选取默认即可

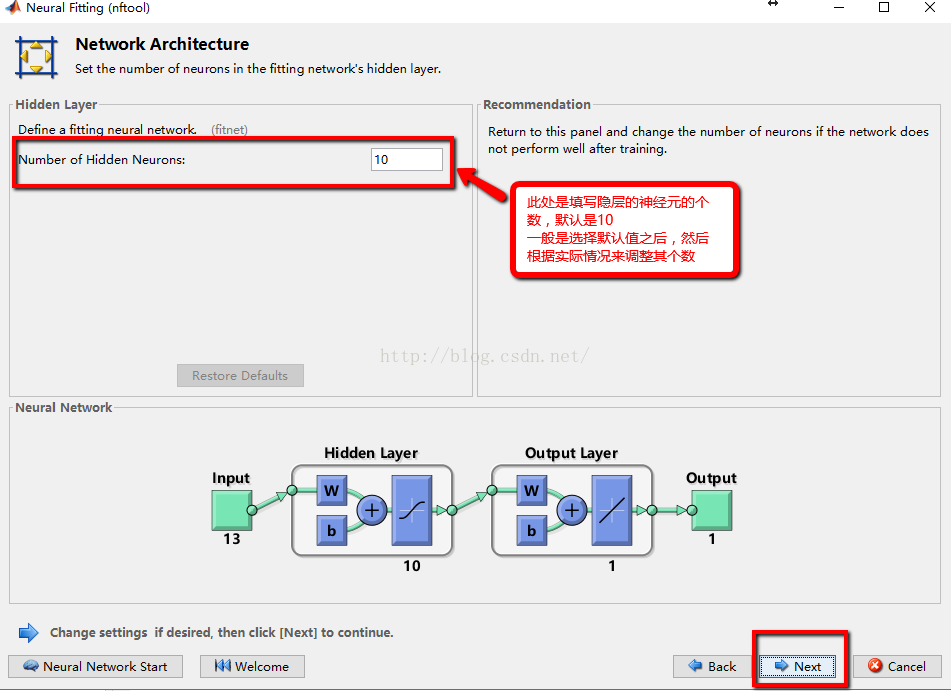

4:隐层神经元的确定

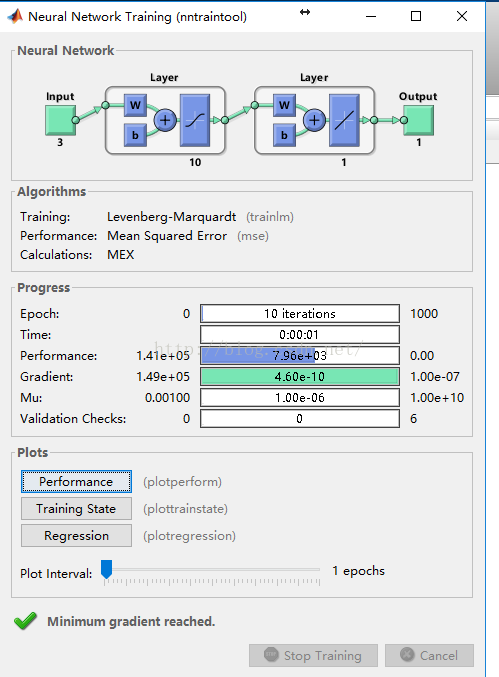

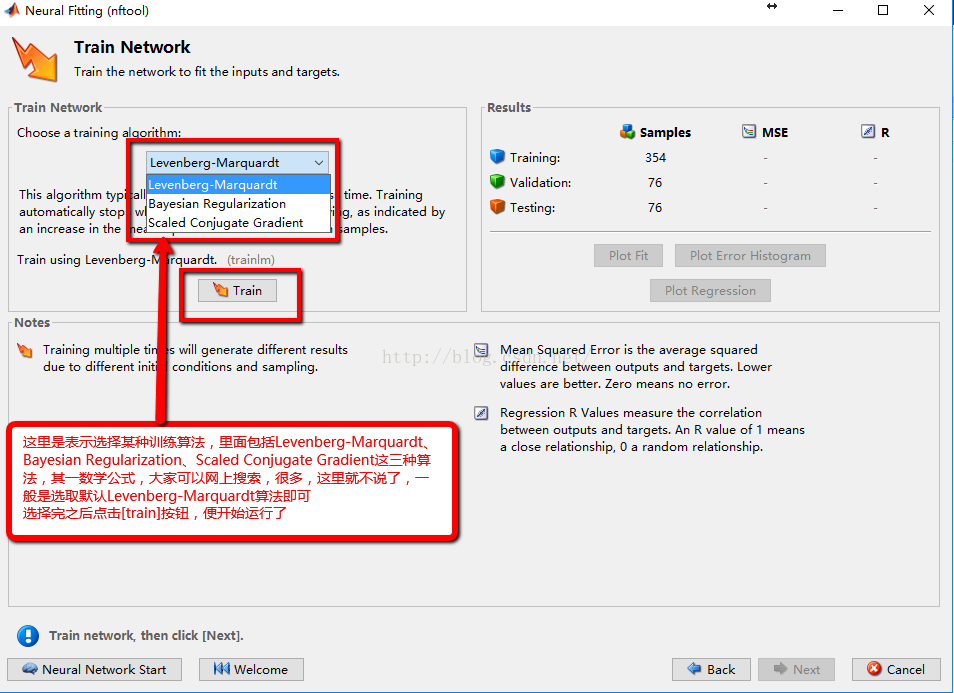

5:训练算法的选取,一般是选择默认即可,选择完成后点击<train>按钮即可运行程序

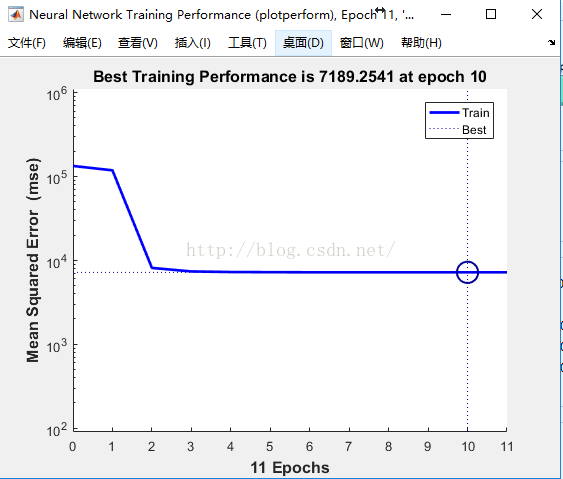

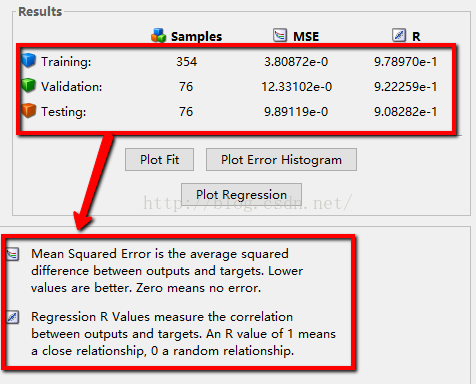

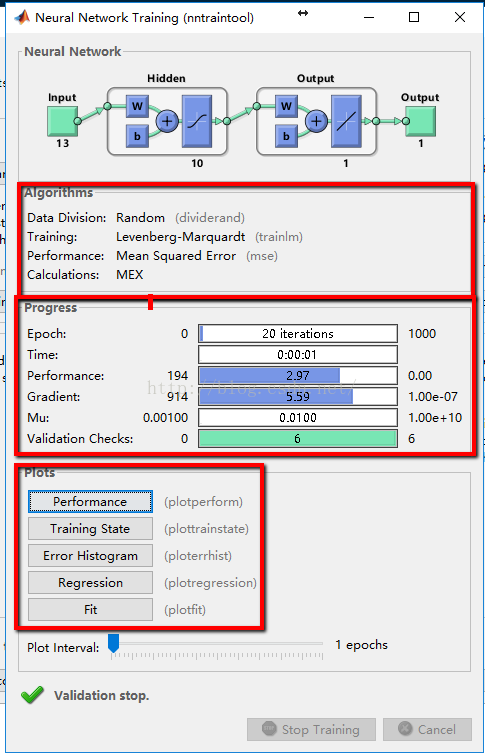

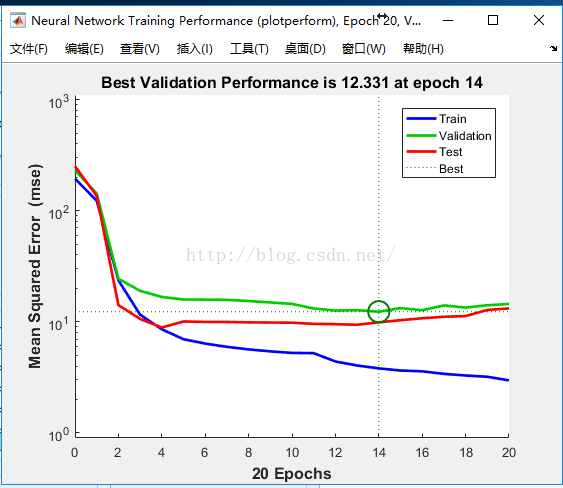

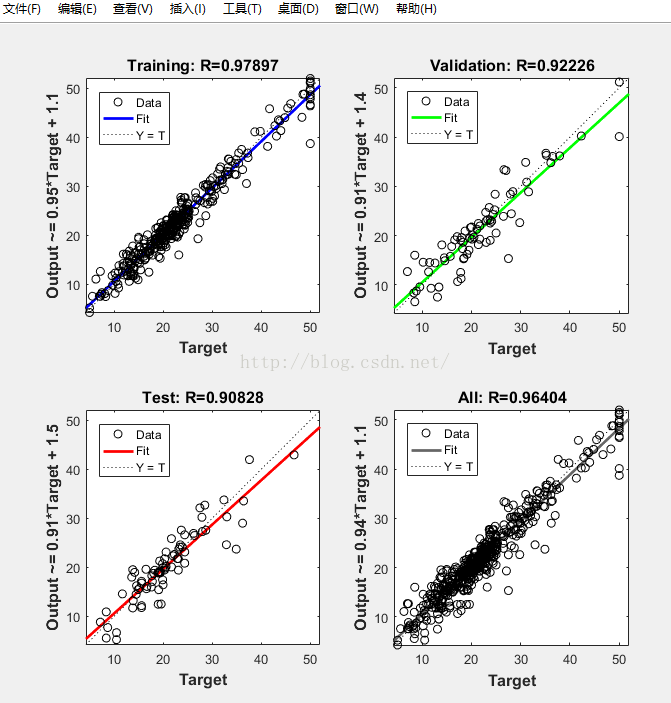

6:根据得到的结果,一般是MSE的值越小,R值越接近1,其训练的效果比较,并第二张图给出了神经网络的各参数的设置以及其最终的结果,其拟合图R越接近1,模型拟合的更好

最终的结果图

7:如果所得到的模型不能满足你的需求,则需重复上述的步骤直至能够得到你想要的精确度

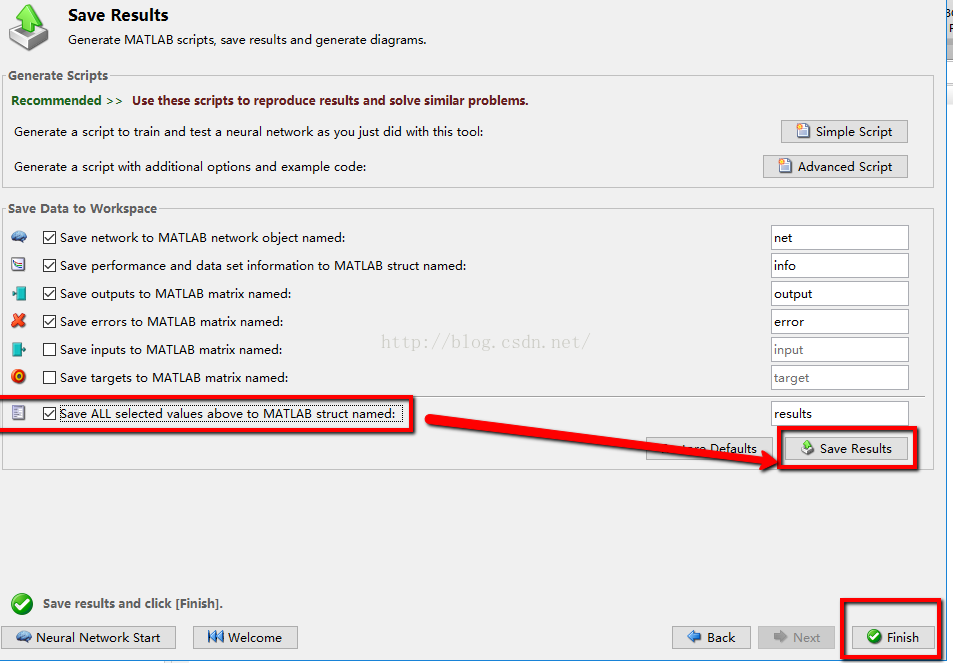

8:将最终的得到的各种数据以及其拟合值进行保存,然后查看,就可以得到所要的拟合值

MATLAB 与神经网络相关的函数总结如下:

Save

1147

1147

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?