之前自己也断断续续看过一些机器学习算法,但是由于没有真正用来解决问题,每一次看都如蜻蜓点水。所以索性将其总结下来,总结过程中借鉴了许多其他博主的文章,在此深表感谢。

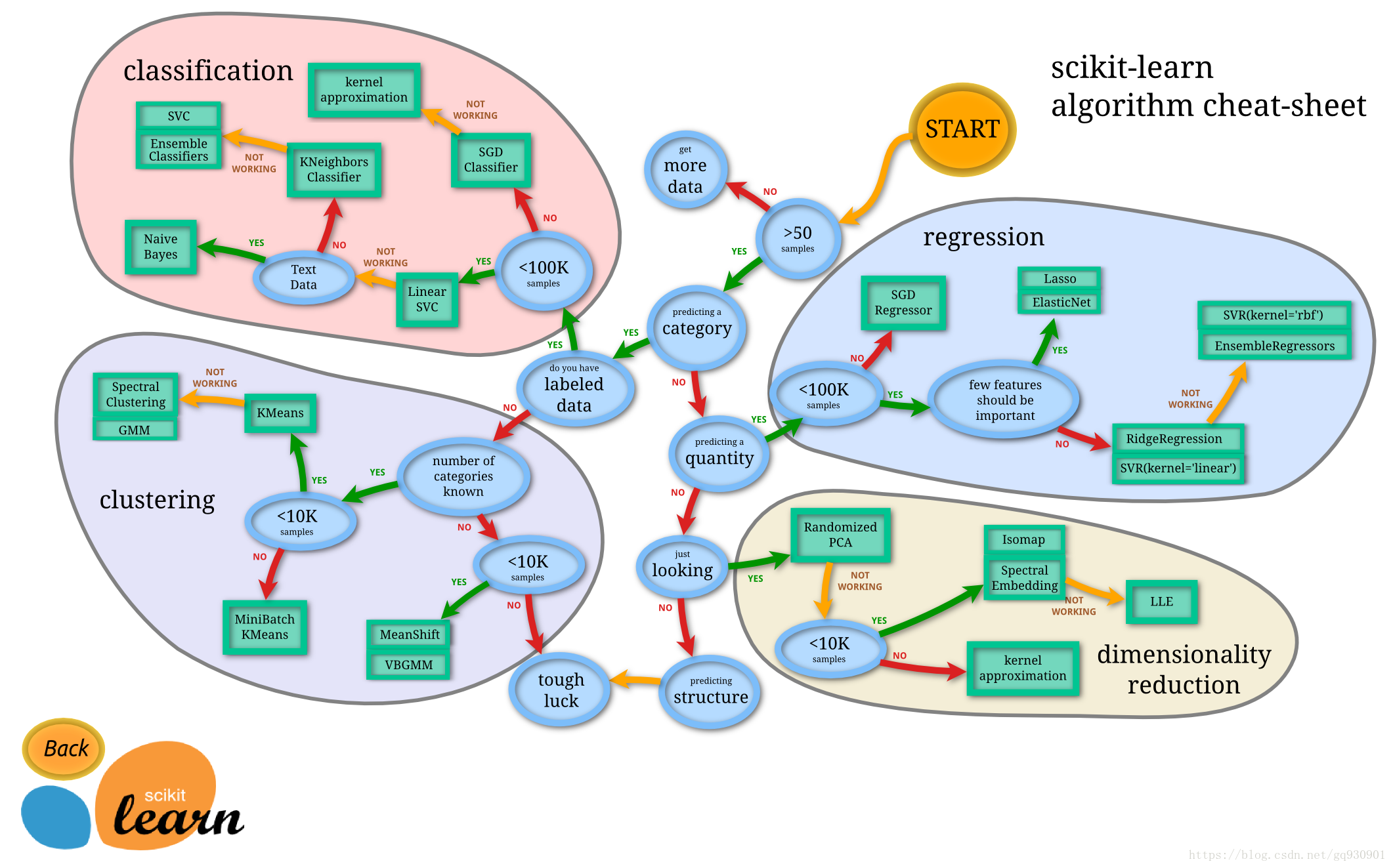

有这样一张图,总结了常见的算法的特点以及彼此关系:

这图中的好多算法我还都一知半解甚至不了解,接下来就会一个个填坑,首当其冲的就是参照其他博主的机器学习十大算法,具体如下:

- 决策树

- 随机森林算法

- 逻辑回归

- SVM

- 朴素贝叶斯

- K最近邻算法

- K均值算法

- Adaboost 算法

- 神经网络

- 马尔可夫

废话少说,说干就干!!!

个人总结:

在分类问题中,决策树就是利用一系列特征来将样本逐渐划分成不同子集,来达到分类的目的。

在构建决策树的过程中,存在特征选取的问题,一个基本的原则是所选取的特征能够使得样本划分类别的不确定性尽可能小,用来刻画样本信息的量为熵,由样本统计概率得到的熵为经验熵,信息增益定义为按照某一特征对样本集进行分类后样本集经验熵之差,是ID3算法选择特征的依据。信息增益比定义为信息增益与按某一特征划分前样本集经验熵的比,是C4.5算法选择特征的依据。此外CART算法使用 Gini 指数最小化准则来选择特征并进行划分

决策树往往泛化能力很弱,所以必须对其进行剪枝,既在其损失函数后加上正则项(损失函数的定义没看明白):

决策树的剪枝过程(泛化过程)就是从叶子节点开始递归,记其父节点将所有子节点回缩后的子树为Tb(分类值取类别比例最大的特征值),未回缩的子树为Ta,如果Cα(Ta)≥Cα(Tb)说明回缩后使得损失函数减小了,那么应该使这棵子树回缩,递归直到无法回缩为止,这样使用“贪心”的思想进行剪枝可以降低损失函数值,也使决策树得到泛化。

CART(分类回归树)既可以用于分类也可以用于回归,回归问题中,CART使用平方误差最小化准则来选择特征并进行划分。每一个叶子节点给出的预测值,是划分到该叶子节点的所有样本目标值的均值,这样只是在给定划分的情况下最小化了平方误差。

要确定最优化分,还需要遍历所有属性,以及其所有的取值来分别尝试划分并计算在此种划分情况下的最小平方误差,选取最小的作为此次划分的依据。由于回归树生成使用平方误差最小化准则,所以又叫做最小二乘回归树。

1335

1335

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?