文章目录

1、概述

我们知道Apache Hive 是构建在Apache Hadoop之上的数据仓库。有助于对大型的数据集进行读、写和管理。这也是官网介绍的第一句话,虽然简短但是却能提炼出很多东西,大家可以去细细品味下。该篇博客不做过多讲述。本文我们介绍Hive的原数据表,他默认是存储在derby中的,但是derby是单session的,所以我们一般会修改会mysql。作者使用的也是mysql进行的管理。

2、启用mysql管理

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true</value>

<description>JDBC connect string for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>hive</value>

<description>username to use against metastore database</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>hive</value>

<description>password to use against metastore database</description>

</property>

3、通过mysql查看basic01数据库

就是你的Hive元数据库

show tables;

+---------------------------+

| Tables_in_basic01 |

+---------------------------+

| bucketing_cols |

| cds |

| columns_v2 |

| database_params |

| dbs |

| func_ru |

| funcs |

| global_privs |

| idxs |

| index_params |

| part_col_privs |

| part_col_stats |

| part_privs |

| partition_key_vals |

| partition_keys |

| partition_params |

| partitions |

| roles |

| sd_params |

| sds |

| sequence_table |

| serde_params |

| serdes |

| skewed_col_names |

| skewed_col_value_loc_map |

| skewed_string_list |

| skewed_string_list_values |

| skewed_values |

| sort_cols |

| tab_col_stats |

| table_params |

| tbl_col_privs |

| tbl_privs |

| tbls |

| version |

+---------------------------+

4、version(存储Hive版本的元数据表)

如果该表出现问题,根本进入不了Hive-Cli。比如该表不存在,当启动Hive-Cli时候,就会报错”Table ‘hive.version’ doesn’t exist”。

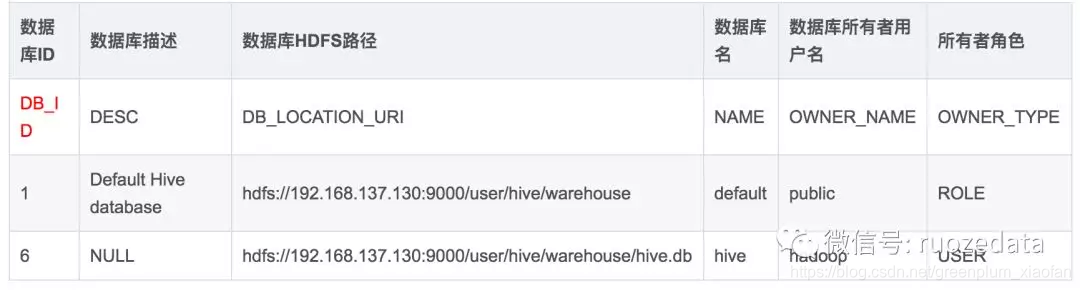

5、Hive数据库相关的元数据表(DBS、DATABASE_PARAMS)

select * from dbs

该表存储Hive中所有数据库的基本信息,字段如下:

select * from database_params;

该表存储数据库的相关参数,在CREATE DATABASE时候用 WITH DBPROPERTIES (property_name=property_value, …)指定的参数。

6、Hive表和视图相关的元数据表

主要有TBLS、TABLE_PARAMS、TBL_PRIVS,这三张表通过TBL_ID关联。

select * from tbls;

该表中存储Hive表、视图、索引表的基本信息。

select * from table_params;

该表存储表/视图的属性信息。

TBL_PRIVS

该表存储表/视图的授权信息

7、Hive文件存储信息相关的元数据表

主要涉及SDS、SD_PARAMS、SERDES、SERDE_PARAMS

由于HDFS支持的文件格式很多,而建Hive表时候也可以指定各种文件格式,Hive在将HQL解析成MapReduce时候,需要知道去哪里,使用哪种格式去读写HDFS文件,而这些信息就保存在这几张表中。

select * from sds;

文件存储的基本信息:

+-------+----------------------------------+------------------------------------------+---------------+---------------------------+------------------------------------------------+-------------+------------------------------------------------------------+----------+

| SD_ID | 字段信息ID(对应column_v2 的CD_ID) | 文件输入格式 | 是否压缩 | 是否以子目录存储 | HDFS路径 | 分桶数量 | 文件输出格式 | 序列化类ID |

+-------+----------------------------------+------------------------------------------+---------------+---------------------------+------------------------------------------------+-------------+------------------------------------------------------------+----------+

| SD_ID | CD_ID | INPUT_FORMAT | IS_COMPRESSED | IS_STOREDASSUBDIRECTORIES | LOCATION | NUM_BUCKETS | OUTPUT_FORMAT | SERDE_ID |

+-------+-------+------------------------------------------+---------------+---------------------------+------------------------------------------------+-------------+------------------------------------------------------------+----------+

| 1 | 1 | org.apache.hadoop.mapred.TextInputFormat | | | hdfs://localhost:9000/user/hive/warehouse/test | -1 | org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat | 1 |

+-------+-------+------------------------------------------+---------------+---------------------------+------------------------------------------------+-------------+------------------------------------------------------------+----------+

SD_PARAMS

该表存储Hive存储的属性信息,在创建表时候使用

STORED BY ‘storage.handler.class.name’ [WITH SERDEPROPERTIES (…)指定。

select * from serdes;

该表存储序列化使用的类信息:

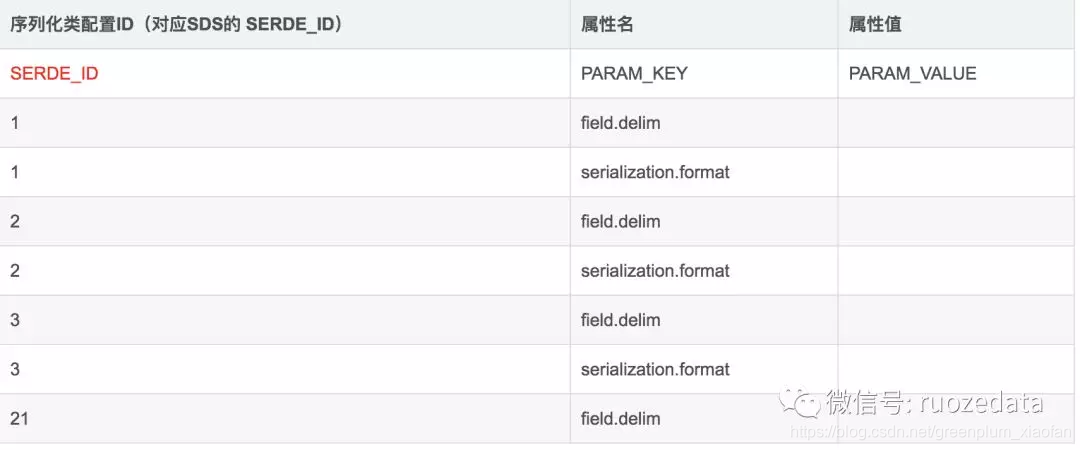

select * from serde_params;

该表存储序列化的一些属性、格式信息,比如:行、列分隔符

8、Hive表字段相关的元数据表

select * from columns_v2;

表的字段信息:

9、Hive表分区相关的元数据表

主要涉及PARTITIONS、PARTITION_KEYS、PARTITION_KEY_VALS、PARTITION_PARAMS

select * from partitions ;

分区的基本信息:

select * from partition_keys;

分区的字段信息:

select * from partition_key_vals;

该表存储分区字段值:

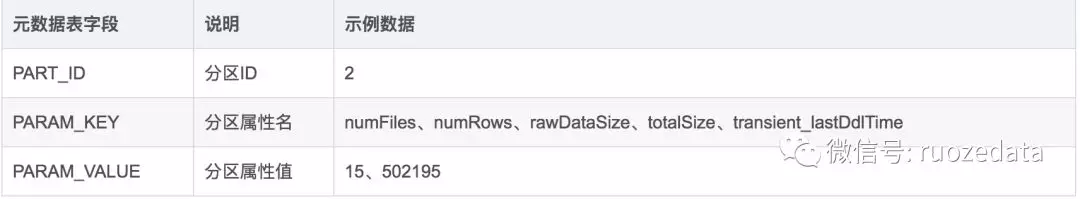

select * from partition_params;

该表存储分区的属性信息.

10、其他不常用的元数据表

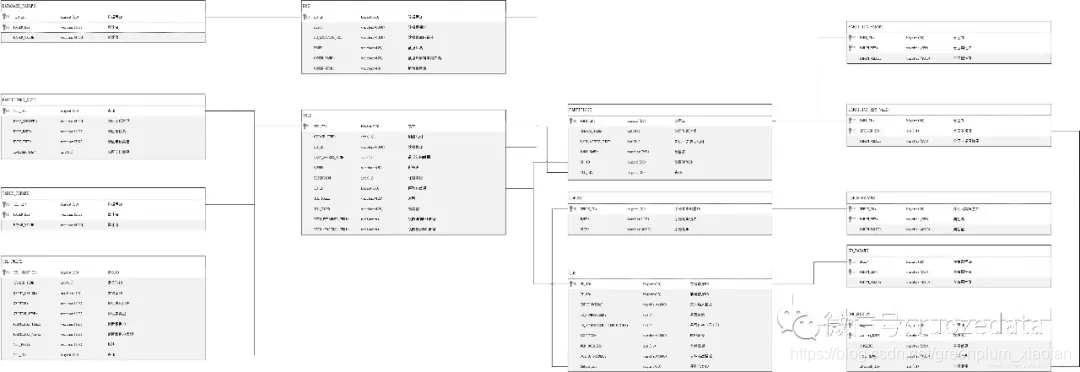

11、最后我们总结下他们之间的关系图

478

478

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?