Chinese-CLIP入门学习资料汇总

Chinese-CLIP是CLIP模型的中文版本,基于约2亿的中文图文对数据进行训练,旨在帮助用户在中文领域快速实现图文特征提取、跨模态检索、零样本图像分类等任务。本文汇总了Chinese-CLIP项目的相关学习资源,帮助读者快速了解和使用该模型。

1. 项目简介

Chinese-CLIP项目地址:GitHub - OFA-Sys/Chinese-CLIP

Chinese-CLIP是基于open_clip project开发的,并针对中文数据做了优化。项目提供了API、训练代码和测试代码,涵盖了从模型训练到推理的全流程。

2. 模型下载

Chinese-CLIP目前开源了5个不同规模的模型,包括:

- CN-CLIP RN50

- CN-CLIP ViT-B/16

- CN-CLIP ViT-L/14

- CN-CLIP ViT-L/14@336px

- CN-CLIP ViT-H/14

各模型的详细信息和下载链接可在项目README中查看。

3. 快速使用

Chinese-CLIP提供了简单的API接口,可以快速实现图文特征提取和相似度计算。安装方法:

pip install cn_clip

使用示例:

import torch

from PIL import Image

import cn_clip.clip as clip

device = "cuda" if torch.cuda.is_available() else "cpu"

model, preprocess = clip.load_from_name("ViT-B-16", device=device, download_root='./')

model.eval()

image = preprocess(Image.open("examples/pokemon.jpeg")).unsqueeze(0).to(device)

text = clip.tokenize(["杰尼龟", "妙蛙种子", "小火龙", "皮卡丘"]).to(device)

with torch.no_grad():

image_features = model.encode_image(image)

text_features = model.encode_text(text)

logits_per_image, logits_per_text = model.get_similarity(image, text)

probs = logits_per_image.softmax(dim=-1).cpu().numpy()

print("Label probs:", probs)

4. 详细教程

项目提供了详细的教程,包括:

这些教程提供了代码示例和详细说明,可以帮助用户深入理解和使用Chinese-CLIP模型。

5. 在线Demo

基于Hugging Face Spaces,项目提供了Chinese-CLIP零样本图像分类的在线Demo,支持4种模型规模,欢迎尝试使用。

6. 技术报告

如需了解Chinese-CLIP的技术细节,可以参考项目的技术报告。

7. 相关资源

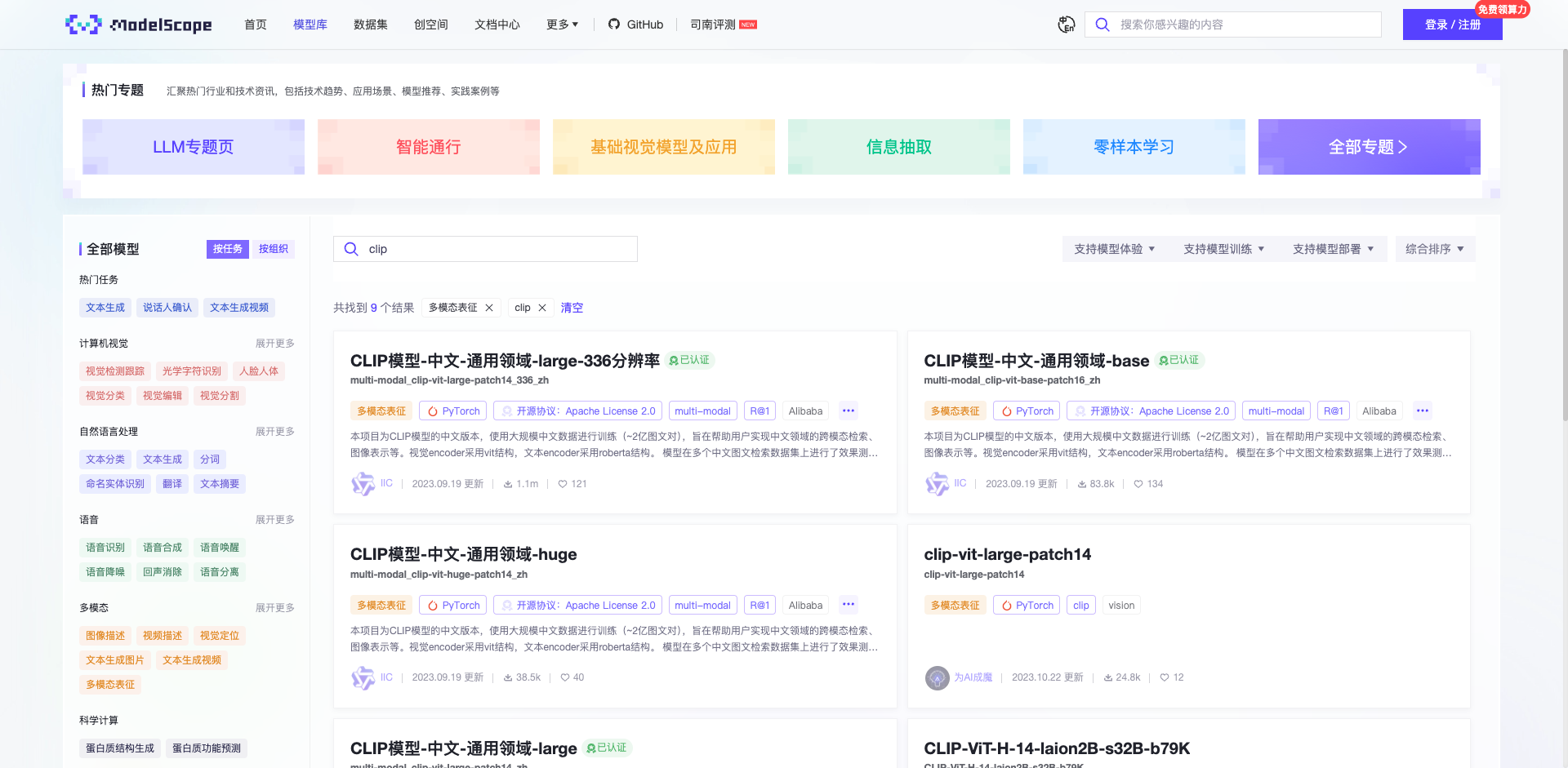

- ModelScope:可以在ModelScope平台上体验Chinese-CLIP模型。

- 跨模态检索Demo:基于Chinese-CLIP实现的跨模态检索demo。

通过以上资源,相信读者可以快速上手使用Chinese-CLIP模型,并将其应用到自己的项目中。Chinese-CLIP作为一个强大的中文多模态预训练模型,在图文理解和跨模态任务中有着广泛的应用前景,欢迎更多开发者参与到项目中来,共同推动中文多模态AI技术的发展。

文章链接:www.dongaigc.com/a/chinese-clip-beginners-guide

https://www.dongaigc.com/a/chinese-clip-beginners-guide

2394

2394

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?