业务场景描述:

在我们的项目中有些配置信息持久化在数据库中,这些配置信息又是在系统启动后自动加载并缓存在local或者redis中,但如果后台运营系统进行了相应更新配置操作,我们需要实现“热部署”或“热插拔”等功能的话,我们有哪些方案可以实现呢?单机项目就非常简单了,但分布式集群的项目怎么办呢?

分布式集群的项目之间同步数据,我们来讲一下有哪些方案解决。

方案一:项目程序中对DB进行操作后,留一个后门接口进行刷新操作,针对不同机器的IP进行轮询或点对点刷新同步操作。其简单,就是再次进行一次db查询操作,该接口的安全性也需要留神,比较low。

方案二:项目程序中对DB进行操作时,通过切面或者自带调用一个异步方法将数据发送给MQ或者缓存Redis等中间件,再由另一个程序去监听并读入到本地缓存或者公共缓存。其简单但不稳定,如果忘了通知或者通知MQ失败了或者事务回滚了,要谨慎和想完全其处理逻辑。

方案三:使用阿里的canal等成熟的基于数据库日志增量订阅&消费的中间件进行独立有效的数据同步。其简单,可独立立项,更解耦更成熟,但缺点是属于Java方向,暂时支持的数据库为mysql,后文也将重点介绍这个方案。

方案四:使用成熟的分布式系统的协调中间件Zookeeper等的环境变量进行简单配置信息管理。

以上所说的四种方案,可以相互结合使用,也可以单独使用,没有最终的方案,只有适合不是适合而已,因人而异。

方案一和二的主要是在代码层面和主流的消息或缓存中间件之间的搭配,方案四主要是增加相关环境变量属性,我们就不多说了,接下来我们还是重点介绍一下方案三。

首先介绍Canal是什么?

Canal是阿里巴巴团队基于数据库日志增量订阅&消费的框架。纯java开发的,基于数据库增量日志解析,提供增量数据订阅&消费,目前主要支持了mysql。

Github:https://github.com/alibaba/canal

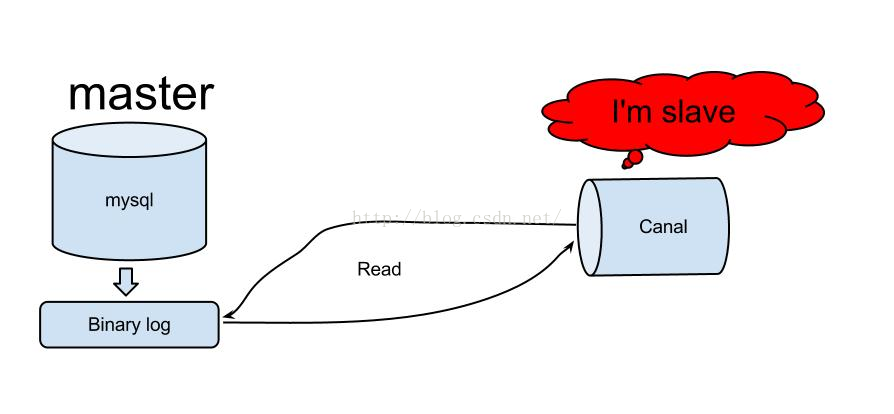

Canal的工作原理是?

原理相对比较简单,你也可以举一反三封装其他DB中间件:

1. canal模拟mysql slave的交互协议,伪装自己为mysql slave,向mysql master发送dump协议

2. mysql master收到dump请求,开始推送binary log给slave(也就是canal)

3. canal解析binary log对象(原始为byte流)

Canal如何安装及使用?

A. Canal的原理是基于mysql binlog技术,所以这里一定需要开启mysql的binlog写入功能,建议配置binlog模式为row.

修改Mysql配置:vim ./etc/mysql/my.cnf

[mysqld]

log-bin=mysql-bin #添加这一行就ok

binlog-format=ROW #选择row模式

server_id=1 #配置mysql replaction需要定义,不能和canal的slaveId重复

B. Canal的原理是模拟自己为mysql slave,所以这里一定需要做为mysql slave的相关权限.

CREATE USER canal IDENTIFIED BY 'canal';

GRANT SELECT, REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'canal'@'%';

-- GRANT ALL PRIVILEGES ON *.* TO 'canal'@'%' ;

FLUSH PRIVILEGES;

C. 下载最新Release版本:https://github.com/alibaba/canal/releases/download/canal-1.0.22/canal.deployer-1.0.22.tar.gz

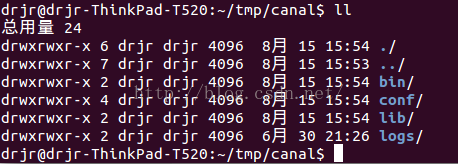

D. 解压相关文件并进行config配置:

解压指令:

mkdir ~/tmp/canal

tar zxvf canal.deployer-1.0.22.tar.gz -C ~/tmp/canal

目录结构:

修改配置:vi ~/tmp/canal/conf/example/instance.properties

配置自己数据库配置

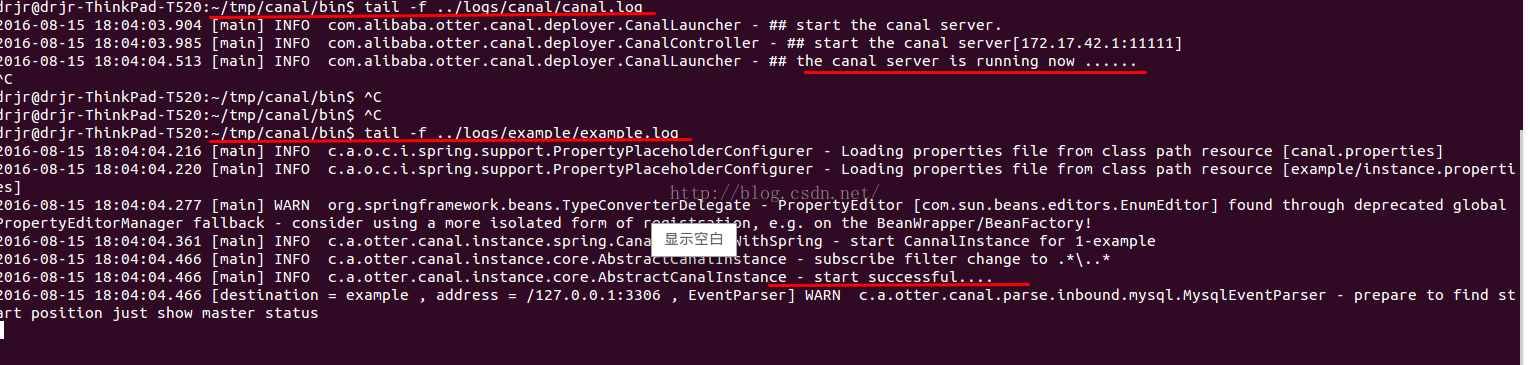

E. 启动Cannal和查看相关日志:

启动:sh ~/tmp/canal/bin/startup.sh

查看日志:tail -f ~/tmp/canal/logs/canal/canal.log

tail -f ~/tmp/canal/logs/example/example.log

停止:sh ~/tmp/canal/bin/stop.sh

F. Java-Maven项目集成及Demo:

1.添加pom依赖:

<dependency>

<groupId>com.alibaba.otter</groupId>

<artifactId>canal.client</artifactId>

<version>1.0.12</version>

</dependency>

2.代码:参考https://github.com/alibaba/canal/wiki/ClientExample

package com.ft.test.unit;

import java.net.InetSocketAddress;

import java.util.List;

import com.alibaba.otter.canal.client.CanalConnector;

import com.alibaba.otter.canal.common.utils.AddressUtils;

import com.alibaba.otter.canal.protocol.Message;

import com.alibaba.otter.canal.protocol.CanalEntry.Column;

import com.alibaba.otter.canal.protocol.CanalEntry.Entry;

import com.alibaba.otter.canal.protocol.CanalEntry.EntryType;

import com.alibaba.otter.canal.protocol.CanalEntry.EventType;

import com.alibaba.otter.canal.protocol.CanalEntry.RowChange;

import com.alibaba.otter.canal.protocol.CanalEntry.RowData;

import com.alibaba.otter.canal.client.*;

/**

* Created by drjr on 16-8-15.

*/

public class TestCanal {

public static void main(String args[]) {

//调用通过canal获取DB数据同步

neveDieGetMysqlDB();

}

private static void neveDieGetMysqlDB() {

// 根据ip,直接创建链接,无HA的功能

String destination = "example";

// 创建链接

CanalConnector connector =

CanalConnectors.newSingleConnector(new InetSocketAddress(AddressUtils.getHostIp(), 11111), destination, "", "");

int batchSize = 1000;

int emptyCount = 0;

try {

connector.connect();

connector.subscribe(".*\\..*");

connector.rollback();

Long batchId = null;

while (true) { //demo方便处理,可以根据时间情况调整

try {

Message message = connector.getWithoutAck(batchSize); // 获取指定数量的数据

batchId = message.getId();

int size = message.getEntries().size();

if (batchId == -1 || size == 0) {

emptyCount++;

System.out.println("empty count : " + emptyCount);

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

} else {

emptyCount = 0;

printEntry(message.getEntries());

}

connector.ack(batchId); // 提交确认

} catch (Exception e) {

if (null != batchId) {

connector.rollback(batchId); // 处理失败, 回滚数据

}

}

}

} finally {

connector.disconnect();

}

}

private static void printEntry(List<Entry> entrys) {

for (Entry entry : entrys) {

if (entry.getEntryType() == EntryType.TRANSACTIONBEGIN || entry.getEntryType() == EntryType.TRANSACTIONEND) {

continue;

}

RowChange rowChage = null;

try {

rowChage = RowChange.parseFrom(entry.getStoreValue());

} catch (Exception e) {

throw new RuntimeException("ERROR ## parser of eromanga-event has an error , data:" + entry.toString(),

e);

}

EventType eventType = rowChage.getEventType();

System.out.println(String.format("================> binlog[%s:%s] , name[%s,%s] , eventType : %s",

entry.getHeader().getLogfileName(), entry.getHeader().getLogfileOffset(),

entry.getHeader().getSchemaName(), entry.getHeader().getTableName(),

eventType));

for (RowData rowData : rowChage.getRowDatasList()) {

if (eventType == EventType.DELETE) {

printColumn(rowData.getBeforeColumnsList());

} else if (eventType == EventType.INSERT) {

printColumn(rowData.getAfterColumnsList());

} else {

System.out.println("-------> before");

printColumn(rowData.getBeforeColumnsList());

System.out.println("-------> after");

printColumn(rowData.getAfterColumnsList());

}

}

}

}

private static void printColumn(List<Column> columns) {

for (Column column : columns) {

System.out.println(column.getName() + " : " + column.getValue() + " update=" + column.getUpdated());

}

}

}

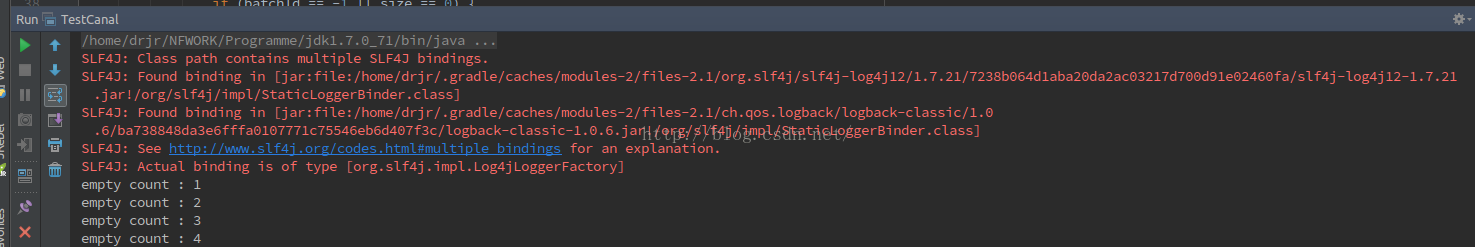

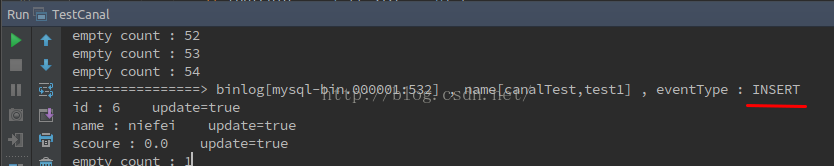

运行后,会输出empty,并一直在读取:

3.Test表:

CREATE TABLE `test1` (

`id` int(11) NOT NULL,

`name` varchar(45) NOT NULL,

`scoure` decimal(10,2) NOT NULL,

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=UTF8;

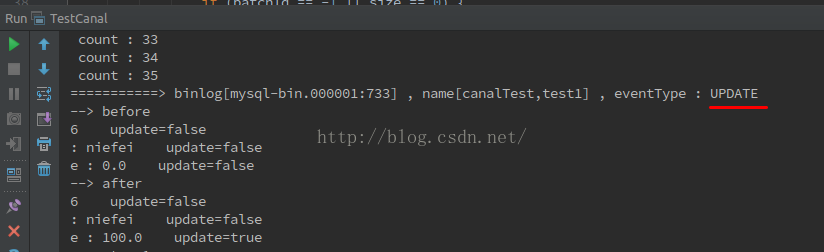

4.进行简单Insert,Update语句操作后:

INSERT INTO `canalTest`.`test1` (`id`, `name`, `scoure`) VALUES ('6', 'niefei', '0.0');

UPDATE `canalTest`.`test1` SET `scoure`='100' WHERE `id`='6';

我们可以看到我们的监听程序监听了相关数据信息:

这样看我已经可以获取想要的全部信息了,接下来就是对你想要的“表”,“字段”等进行相关获取及封装进行操作了,后面也可以解析数据后放到公共的redis中等,监听也可以放在一个独立或者放在本身项目中就随你了。

我们现在是Canal单机的配置,其也支持集群方式部署,目前看单机已满足我们的业务需求。

Canal还能做什么?

1. 数据库镜像

2. 数据库实时备份

3. 多级索引 (卖家和买家各自分库索引)

4. search build

5. 业务cache刷新

6. 价格变化等重要业务消息

我们这边主要介绍的是通过监听获取DB的数据进行业务cache刷新,你有兴趣的话可以参考以下相关文档使用其更多功能。

更多文档可参考文献:

Canal的介绍:https://github.com/alibaba/canal/wiki

MySQL的Binlay Log介绍:http://dev.mysql.com/doc/refman/5.5/en/binary-log.html

Redis介绍:http://redis.io/documentation

RabbitMQ介绍:http://www.rabbitmq.com/documentation.html

ActiveMQ介绍:http://activemq.apache.org/

RocketMQ介绍:https://github.com/alibaba/RocketMQ

1493

1493

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?