Federated Learning: Challenges, Methods, and Future Directions

论文链接: link

摘要

联邦学习包括在远程设备或孤岛数据中心上训练统计模型,如移动电话或医院,同时保持数据本地化。

在异构和潜在的大规模网络中的训练带来了新的挑战,需要从根本上背离大规模机器学习的标准方法 信息化和隐私保护的数据分析。

.在本文中,我们将讨论联邦学习的独特特点和挑战,提供了当前方法的广泛概述,并概述了未来工作的几个方向 提升到一个广泛的研究社区。

联邦学习的目标:最小化这个函数

一、联邦学习的挑战:

(1)昂贵的通信

原因:

联邦网络可能由大量的设备组成,网络中的通信可能比本地计算要慢好几个数量级。

减少通信 两个需要考虑的关键:

减少通信轮数;减少每一轮传输信息的大小

(2)系统异构

原因:

① 硬件、网络连接、电源不同;

② 每个设备上的网络大小和与系统相关的限制(计算能力、通信能力、存储能力的不同),导致活跃的设备只有一小部分;

③ 设备有可能不可靠,不稳定,可能随时退出迭代。

对开发和分析联邦学习的要求:

预测较低的参与率,容忍异构的设备;在网络中掉线的设备有鲁棒性。

(3)统计异构

原因:

① 设备经常在整个网络中生成和收集的数据通常都是独立同分布的,

② 跨设备的数据点的数量可能差异很大,

更加自然的解决方法: multi-task,meta-learning

(4)隐私

原因

训练过程中的通信模型更新,向第三方或中央服务器透露敏感信息。

现有方法:

以降低模型性能或系统效率为代价,使用同态加密、多方安全计算和差分隐私

二、目前相关工作

(1)通信效率

① 局部更新方法:可以减少通信轮数

mini-batch优化方法 现在已经成为数据中心环境中分布式机器学习的一个主流的范例。然而,在实践中,它们被证明在平衡通信-计算方面的灵活性有限,这种权衡是为了最大限度地利用分布式数据处理。可以通过动态的挑战本地更新轮数来增加灵活性。

联邦学习最常用的方法是联邦平均(FedAvg),这是一种基于局部随机梯度下降(SGD)平均更新的方法。FedAvg在经验上表现得很好,特别是在非凸问题上,但它没有收敛性保证,并且在实际情况下,当数据是异构的时,它可能会发散。

② 模型压缩方案:每一轮减少messages的size

稀疏化、子采样和量化。

虽然先前的工作已经探索了在非独立同分布数据存在的情况下,通过低精度训练的收敛保证,但是所做的假设没有考虑联邦设置的共同特征,例如低设备参与度或局部更新优化方法。

③ 非中心化的训练:降低中央服务器上的高通信成本

最近的一些工作研究了基于局部更新方案的异质数据去中心化训练。然而,它们要么局限于线性模型,要么假设设备完全参与。

还提出了层级通信模式,以进一步减轻中央服务器的负担,首先利用边缘服务器聚合来自边缘设备的更新,然后依赖云服务器聚合来自边缘服务器的更新。虽然这是一种有前途的减少通信的方法,但它不适用于所有网络,因为这种类型的物理层次可能不存在或先验已知。

(2)系统异构

① 异步通信

同步方案简单,保证了串行等效计算模型。但是在设备变化面前,也更容易受到掉队者的影响。

异步方案可以减轻异构环境中的掉队问题,特别是共享内存系统中。但是也依赖于有界延迟假设来控制过时的程度。

② 主动采样

在每一轮中主动选择参与设备

③ 容错

策略:

忽略故障,如果故障设备具有特定的数据特性,则可能会在设备采样方案中引入偏差。

编码计算。

(3)统计异构

模型异质数据

解决方法:

① 对统计异质性进行建模(元学习、多任务学习),仅限于凸目标;

② 将星形拓扑建模为贝叶斯网络,并在学习期间执行变分推理。空预处理非凸模型,但是推广到大型联邦网络是昂贵的。

③ 考虑精度以外的问题(比如公平性)很重要

non-IID数据的收敛性保证

提出了FedProx,是FedAvg的广义的、重新参数化的版本。

还有一些方法旨在通过共享本地设备数据或某些服务器端代理数据,来解决统计异质问题,但是不实际,违背了联邦学习的密钥隐私假设。

(4)隐私

模型更新作为训练过程中的一部分,这些信息共享也会泄露用户的隐私信息,

机器学习的隐私

三种策略:

差分隐私-用于通信有噪声的data sketches,

同态加密-用以操作加密的数据,

安全函数评估或多方计算。

① 差分隐私由于其强大的信息理论保证、算法简单和相对较小的系统开销而被最广泛地使用。

对于基于梯度的学习方法,一种流行的方法是通过在每次迭代时随机扰动中间输出来应用差分隐私。在应用扰动(高斯噪声、拉普拉斯噪声、二项式噪声)之前,通常剪裁梯度以限制每个例子对整体更新的影响。

差分隐私和模型精度之间存在着固有的权衡,因为增加更多的噪声会带来更大的隐私,但可能会严重影响精度。

② 同态加密还可以通过计算加密数据来保护学习过程,尽管目前它应用于有限的设置,例如训练线性模型、或仅涉及少数实体

③ 当敏感数据集分布在不同的数据所有者之间时,可以通过安全功能评估(SFE)或安全多方计算(SMC)来执行隐私保护学习。因此,虽然SMC不能保证信息泄漏的保护,但它可以与差异隐私相结合,以实现更强的隐私保证。

然而,这些方法可能不适用于大规模机器学习场景,因为它们会带来大量额外的通信和计算成本。

联邦学习的隐私

要求:除了提供严格的隐私保证外,还需要开发计算成本低、通信效率高、能够容忍掉线设备的方法,而所有这些都不会过度损害准确性。

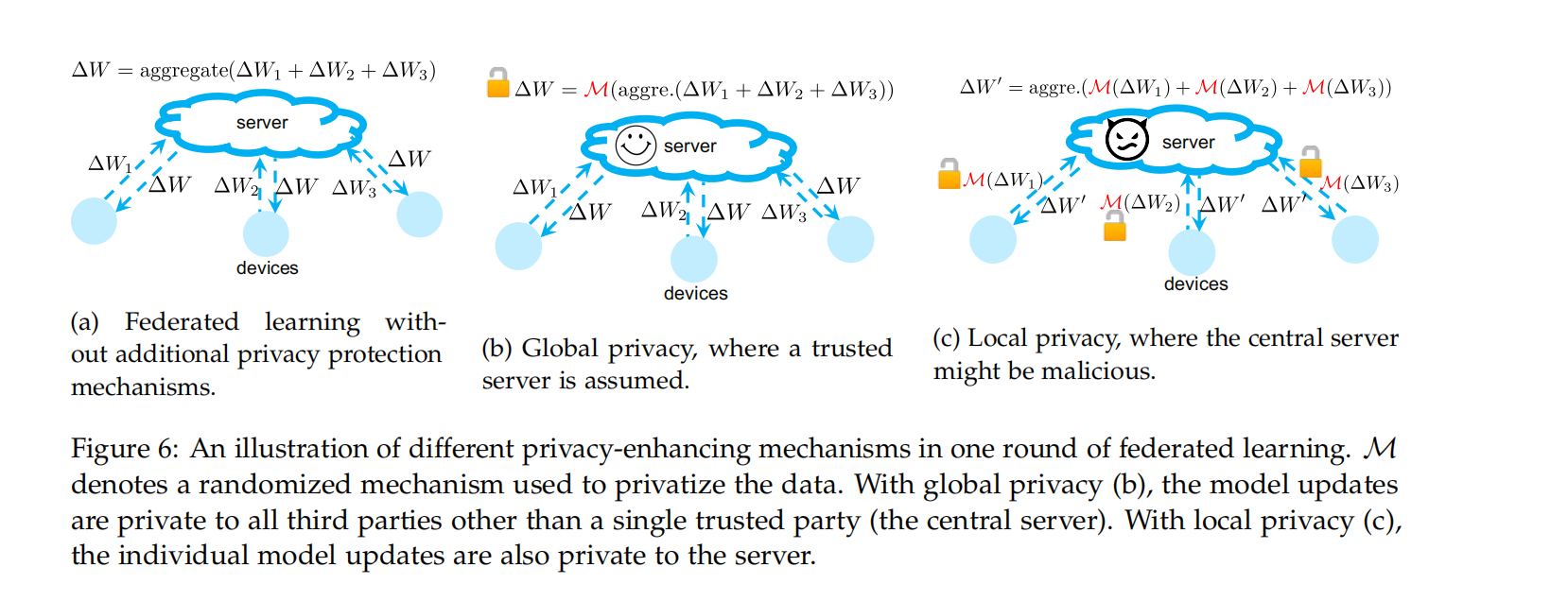

联邦学习的隐私定义为两类:全局隐私和局部隐私。

全局隐私要求在每一轮生成的模型更新,对中央服务器以外的所有不受信任的第三方都是私有的,

而本地隐私进一步要求更新对服务器也是私有的。

目前旨在提高联邦学习隐私的工作通常建立在以前的经典密码协议的基础上,如SMC和差异隐私等。

三、 未来的方向

极端的通信方案

减少通信和Pareto frontier :除了局部更新和模型压缩,Pareto frontier的改进,在相同的通信预算下,在理想情况下,在广泛的通信/精度剖面上,实现比任何其他方法更高的精度。

新的异步模型 : 研究这种更现实的以设备为中心的通信方案的效果,其中每个设备可以决定何时“唤醒”,并以事件触发的方式与中央服务器交互。

异质性诊断 :

(i)是否存在简单的诊断以快速确定联邦网络中的异质性水平?

(ii)是否可以开发类似的诊断来量化与系统相关的异质性的数量?

(iii)是否可以利用当前或新的异质性定义来进一步改进联邦优化方法的收敛性?

细微的隐私限制 :因为隐私约束可能在设备之间或甚至在单个设备上的数据点之间有所不同

超越监督学习 : 迄今为止讨论的方法是考虑到监督学习任务的。在实践中,在现实的联邦网络中生成的许多数据可能是未标记的或弱标记的。此外,手头的问题可能不是将模型拟合到已有数据,而是执行一些探索性的数据分析,确定数据的统计特性,或运行更复杂的任务,如强化学习。

产品性联邦学习 :除了本文中讨论的主要挑战之外,在生产中运行联邦学习时还出现了一些实际问题。 概念漂移、日变化、冷启动问题等

基准测试 :以现实世界的环境、假设和数据集为基础。对于更广泛的研究界来说,进一步建立在现有的实现和基准工具上,如LEAF和Tensorflow Federated是至关重要的,以促进经验结果的可重复性和联邦学习的新解决方案的传播。

四、 总结

在本文中,我们概述了联邦学习,这是一种在分布式网络边缘训练统计模型的学习范式。与传统的分布式数据中心计算和经典的隐私保护学习相比,我们讨论了联邦学习的独特性质和相关的挑战。我们提供了一个关于经典结果的广泛调查,以及最近专门针对联邦设置的工作。最后,我们概述了一些值得进一步研究的开放性问题。为这些问题提供解决方案将需要广泛的研究团体跨学科的努力。

348

348

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?