-

引言

-

简介

-

相关工作

-

模型

-

编码视觉信息

-

函数token

-

多阶段训练

-

-

模型评估

-

发送邮件

-

发送短信

-

Google搜索

-

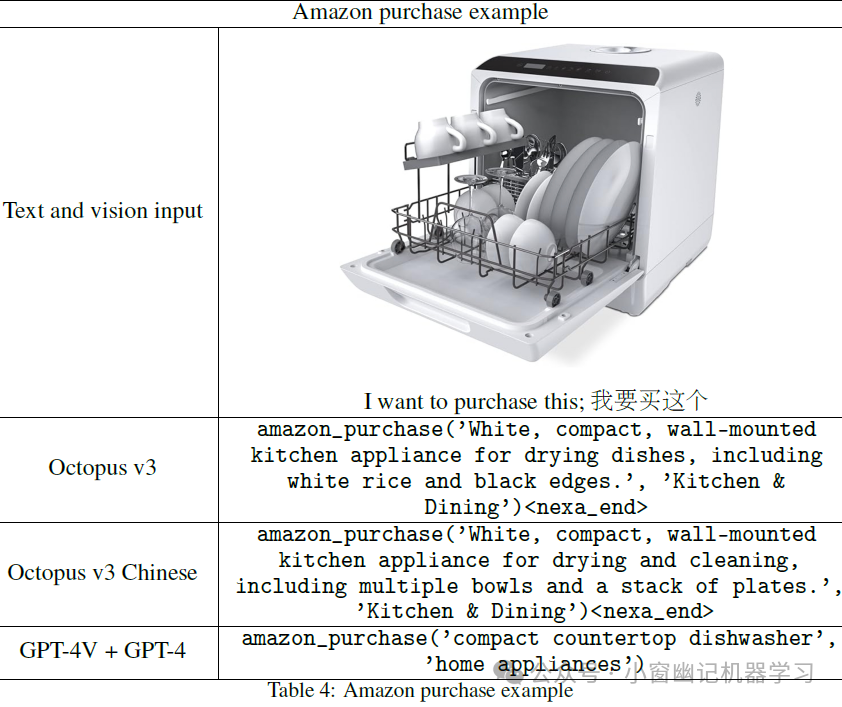

Amazon购物

-

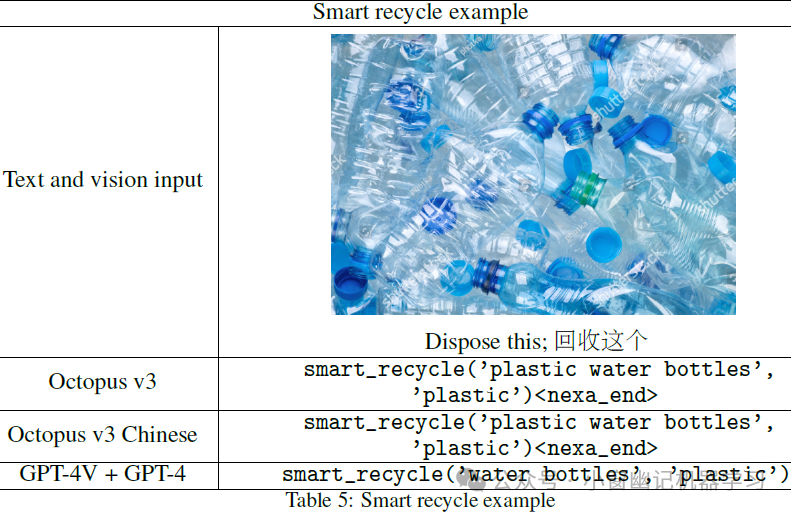

智能回收

-

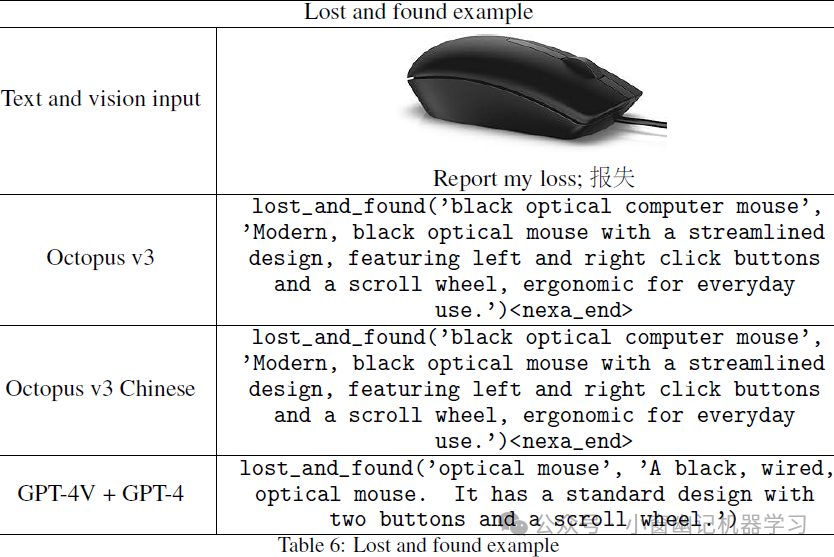

失物招领

-

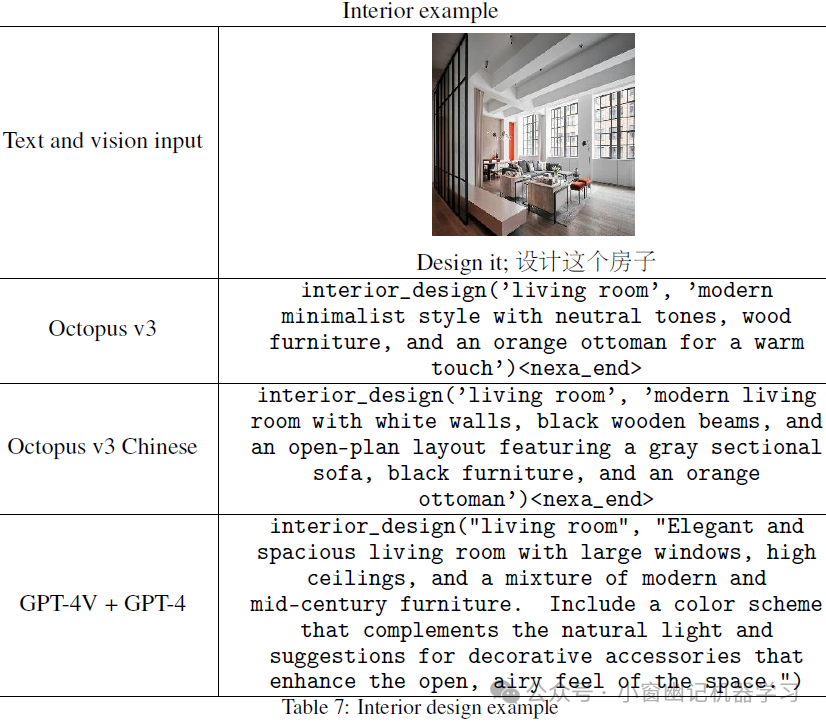

室内设计

-

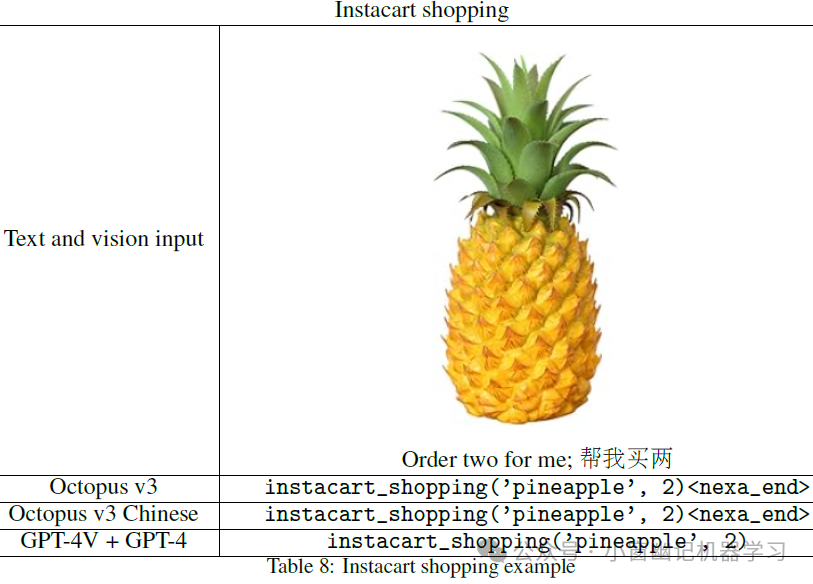

Instacart购物

-

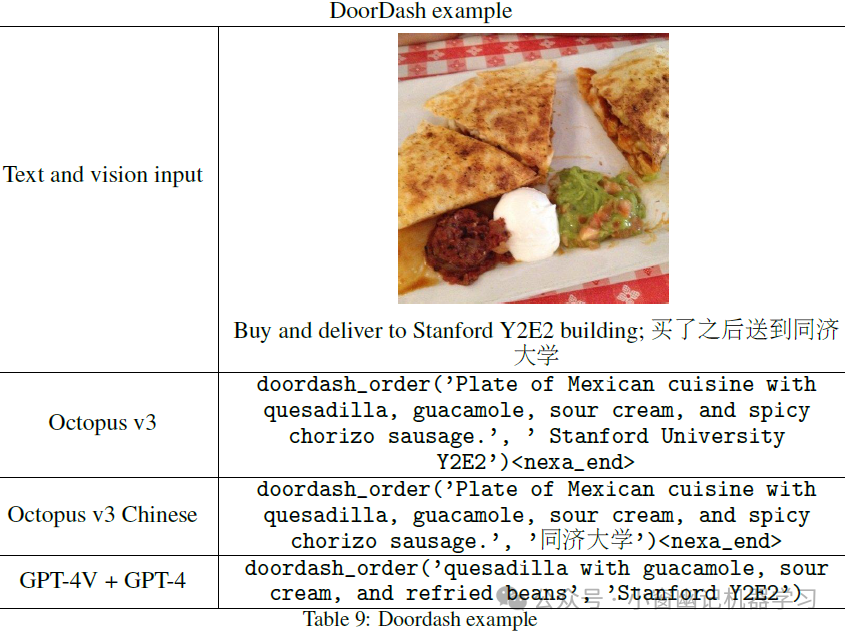

DoorDash(外卖平台)示例

-

动物护理

-

-

总结

引言

青山一道同云雨,明月何曾是两乡。

小伙伴们好,我是微信公众号《小窗幽记机器学习》的小编:卖月饼的小女孩。延续前文:端侧大模型系列 | 斯坦福手机端侧Agent大模型:Octopus v2,为Android API而生!,今天这篇小作文主要介绍Octopus v3这个端侧多模态大模型。#AI智能体 #Agent

人工智能的飞速发展改变了我们与技术的互动方式,催生了能根据自然语言和视觉信息执行复杂任务的人工智能Agent。这些Agent有望自动化处理从图像识别到医疗诊断等各类任务。

它们的核心是多模态语言模型,能够通过处理和整合文本、图像、音频等多种模态数据,理解并生成类人响应。相较传统的文本语言模型,多模态模型能更好地理解输入数据的语境,产生更准确相关的输出。

开发多模态模型的关键挑战是如何将视觉信息编码成可供模型处理的格式。主要方法包括使用卷积神经网络提取图像层次特征,或使用transformer架构捕获长程依赖关系;另一种是图像token化,将图像分解成可与文本整合的离散tokens。

开发更小、高效的多模态模型对未来人工智能Agent至关重要。这些模型可部署在资源受限设备上,扩展应用场景范围。基于强大的多模态能力,小型Agent可以更自然直观地理解和响应用户查询,为更个性化的交互开辟新可能。

此外,高效多模态模型的发展将使人工智能技术民主化,惠及更广泛的用户和行业。模型运行所需的计算资源和能耗降低,有望在医疗、教育等领域广泛应用,彻底改变生活和工作方式。更多文章可以关注微信公众号《小窗幽记机器学习》。

简介

多模态人工智能Agent(智能体)能够处理和学习各种数据类型,包括自然语言、图像和音频。虽然将视觉数据融入大型语言模型已有进展,但如何将图像数据转化为Agent可操作结果仍具挑战。这篇文章介绍一种新型多模态模型,结合了功能性标记(function token)的概念,专为Agent应用设计。为实现边缘设备部署,模型参数被优化至10亿以下。与GPT-4类似,该模型支持英语和中文处理。实践证明,该模型可在多种边缘设备(包括像树莓派这样资源受限设备)上高效运行。演示视频如下:

AI科技爱科学

模型权重和推理代码可通过此链接申请,该模型目前处于测试阶段,仅用于研究目的。

论文标题:Octopus v3: Technical Report for On-device Sub-billion Multimodal AI Agent

论文地址:https://arxiv.org/abs/2404.11459

模型权重和推理代码申请:https://www.nexa4ai.com/apply

相关工作

多模态模型能够处理和学习文本、图像、音频等多种数据类型,受到广泛关注。这些模型捕获不同模态间的复杂交互,利用互补信息提高多任务性能。视觉-语言预训练模型(如ViLBERT)通过跨模态注意力对齐视觉和文本特征;多模态transformer架构(如MMT)则调整了transformer以高效处理多模态数据。研究人员还探索纳入音频、面部表情等其他模态,如多模态情感分析模型。通过整合各模态互补信息,多模态模型相比单一模态方法表现出更好的性能和泛化能力。

这篇文章将参数小于70亿的语言模型视为设备端模型,因为在边缘设备上运行130亿参数模型存在困难。该领域最新进展包括谷歌Gemma 2B/7B、Stable Diffusion的Stable Code 3B和Meta Llama 7B等。有趣的是,较小模型在深层细长架构上表现更佳,与大型模型不同。其他行之有效的端侧技术包括嵌入共享、分组注意力和即时块式权重共享等,如MobileLLM所述。这凸显了为端侧应用开发小型语言模型时,考虑替代设计方法的重要性,因为它们可能需要不同于大型模型的优化方式。

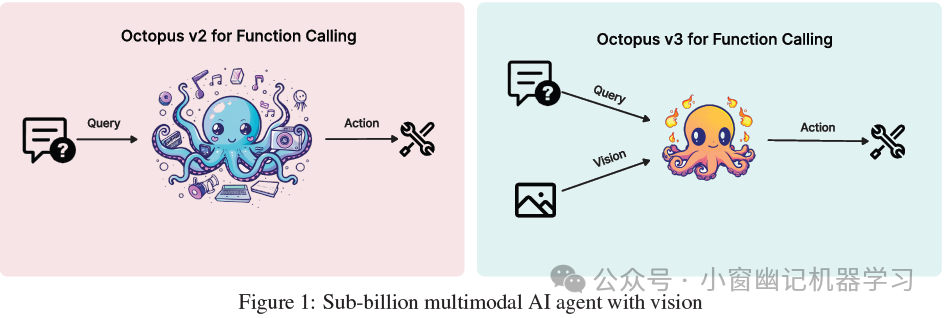

模型

本节讨论Octopus v3模型中主要涉及的技术。多模态模型开发的两个关键方面是如何将图像信息与文本输入集成,以及如何优化模型预测动作的能力。

编码视觉信息

在图像处理中编码视觉信息有多种方法,通常利用隐藏层嵌入。例如,VGG-16模型的隐藏层嵌入用于风格转换任务。OpenAI的CLIP模型展示了对齐文本和图像嵌入的能力,利用其图像编码器对图像进行嵌入。更高级的技术如应用于ViT的图像token化等方法。文章评估了各种图像编码技术,发现CLIP模型的方法最有效。因此,Octopus v3利用CLIP模型进行图像编码。

函数token

与应用于自然语言和图像的token化类似,特定函数也可以封装为函数token。在Octopus v3中为这些token引入了一种训练策略,该策略模仿自然语言模型中处理未见过term(即OOV)的技术。这种方法类似于word2vec方案,其中token的意义通过其上下文环境得到,即分布式表征。例如,先进的语言模型最初可能难以处理像PEGylation和溶酶体逃逸这样的复杂化学术语。然而,这些模型能够通过因果语言建模来获取这些术语的表示,尤其是在包含这些术语的数据集上进行训练时。同样地,函数token可以使用并行策略来获取,Octopus v2模型可以作为这种学习过程的一个强大平台。通过官方的研究表明,定义功能性标记(函数token)的潜力是无限的,通过这种方式可以将任何特定功能(函数)表示为一个token。

多阶段训练

为开发高性能的多模态人工智能Agent,整合因果语言模型和图像编码器的模型架构。该模型的训练过程分为多个阶段。最初,分别训练因果语言模型和图像编码器以建立baseline模型。随后,这些组件合并,模型经历对齐训练以同步图像和文本处理能力。在此之后,训练纳入了Octopus v2框架的方法,以促进函数token的学习。在训练的最后阶段,这些能够与环境交互的函数token能够提供反馈信息,用于进一步精炼和优化模型。因此,在最后阶段,使用强化学习,并选择另一个大型语言模型作为奖励模型。这种反复训练的方法增强了模型有处理和整合多模态信息的能力。

模型评估

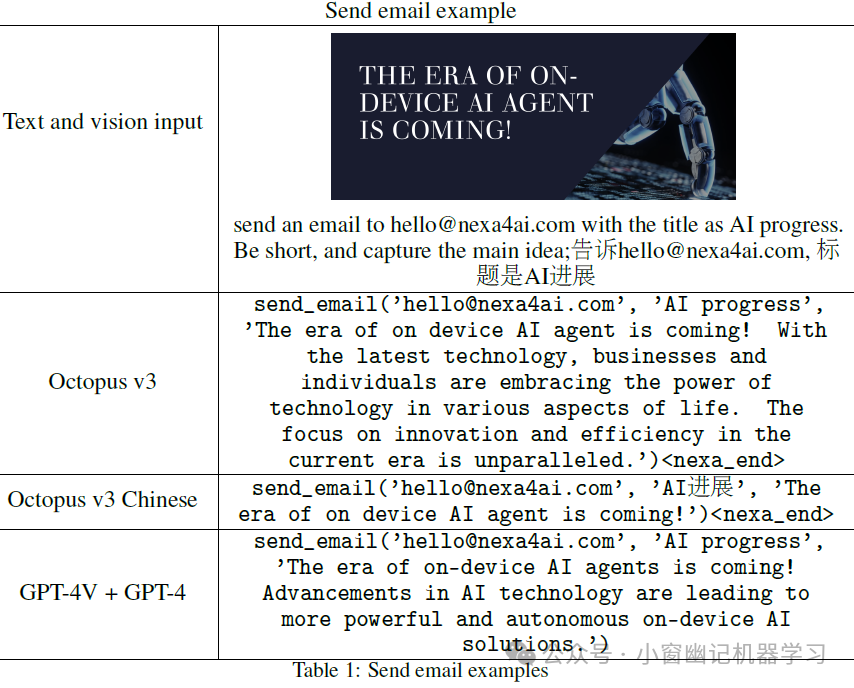

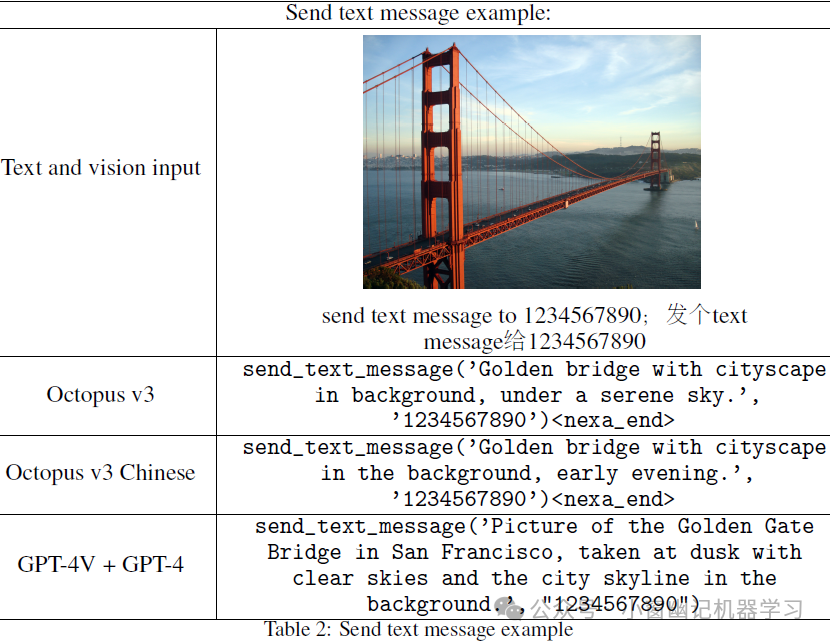

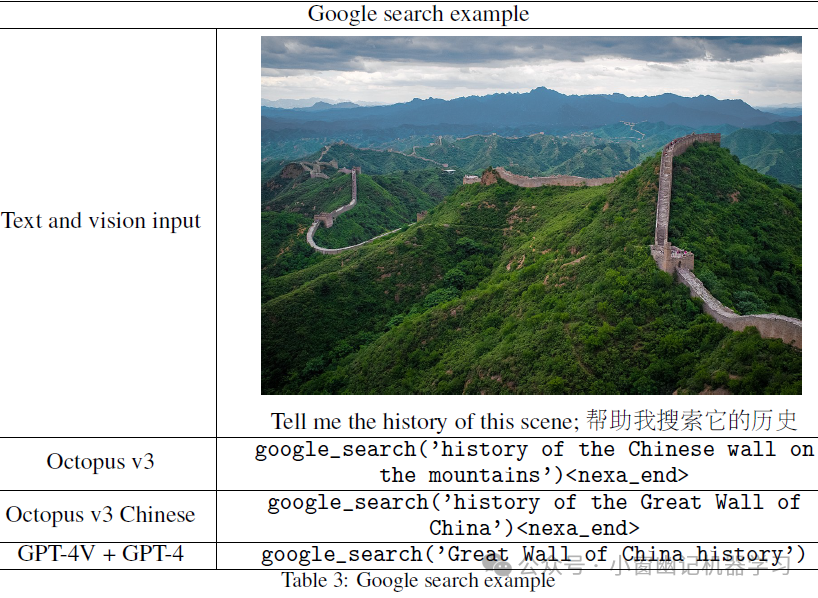

在这一部分,重要展示Octopus v3模型的结果,并与整合GPT-4V模型和GPT-4所取得的成果进行比较。为了进行这种比较,最初采用GPT-4V (gpt-4-turbo)来处理图像信息。随后,所提取的这些数据被用于GPT-4框架(gpt-4-turbo-preview),将所有函数描述纳入上下文,并使用少样本学习来提高性能。在演示中,将10个常用的智能手机API转换为函数token,并评估它们的性能,详情如下文所述。

重点要注意的是,虽然文章只展示了10个函数token,但该模型可以用更多的token进行训练,从而创建一个更加通用的AI Agent。实验结果表明,少于10亿个参数的模型,在作为面向特定API的多模态AI Agent的时候,其性能可与GPT-4V和GPT-4模型相当。

此外,由于Octopus v3模型本身所具备的的可扩展性,还允许加入各种各样的功能函数token,从而创建高度专门化的、适合特定领域或用例的AI Agent。这种适用性使文章所提出的方法在医疗保健、金融和客户服务等行业特别有价值,在这些行业中,基于AI的解决方案可以显著提高效率和用户体验。

对于下面所有的函数名称,Octopus只会输出函数token,例如<nexa_0>,...,<nexa_N>,再将函数token替换为相应的函数名称,以便于更好地演示。下面所有的结果都是直接生成的,不需要任何输出解析器。Octopus v3是一个可以同时处理中文和英文的单一模型,这意味着没有必要专门为中文训练另一个模型。

发送邮件

发送短信

Google搜索

Amazon购物

智能回收

失物招领

室内设计

Instacart购物

DoorDash(外卖平台)示例

动物护理

总结

Octopus v3作为Octopus v2的增强版,融合了文本和视觉信息处理能力,成为一种多模态模型。这一重大进展使其能够同时处理自然语言和视觉数据,为更广泛的应用场景如医疗保健、汽车行业、自动驾驶和机器人等铺平了道路。通过在边缘设备上部署,Octopus v3可将设备如Raspberry Pi转换为智能助理,不依赖云端解决方案。未来工作将致力于开发能够容纳音频、视频等其他数据形式的训练框架,同时优化视觉输入引入的推理延迟。这将进一步扩展多模态模型的能力和应用前景。

1568

1568

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?