在开发应用的时候,一定会经常碰到需要根据指定的字段排序来显示结果的需求

以前面举例用过的市民表为例,假设要查询城市是"杭州"所有人名字,并且按照姓名排序返回前1000个人的姓名、年龄

这个表的部分定义如下:

CREATE TABLE `t` (

`id` int(11) NOT NULL,

`city` varchar(16) NOT NULL,

`name` varchar(16) NOT NULL,

`age` int(11) NOT NULL,

`addr` varchar(128) DEFAULT NULL,

PRIMARY KEY (`id`),

KEY `city` (`city`)

) ENGINE=InnoDB;

SQL语句可以这么写:

select city,name,age from t where city='杭州' order by name limit 1000;

这个语句看上去逻辑很清晰,但是它的执行流程是怎么样的?接下来看看这个语句是怎么执行的,以及有什么参数会影响执行的行为

一、全字段排序

根据索引知识,为了避免全表扫描,需要在city字段加上索引

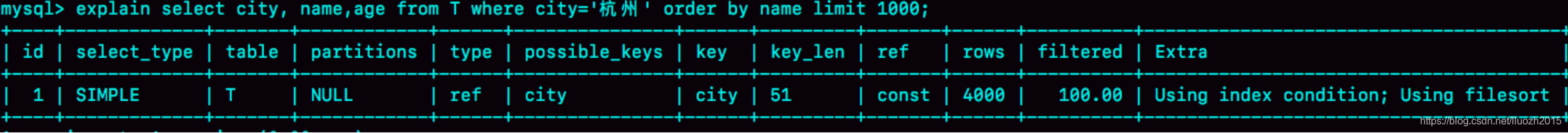

1.1 explain结果

在city字段上创建索引之后,用explain命令来看看这个语句的执行情况

Extra这个字段中的Using filesort表示的就是需要排序,MySQL会给每个线程分配一块内存用于排序,称为sort_buffer

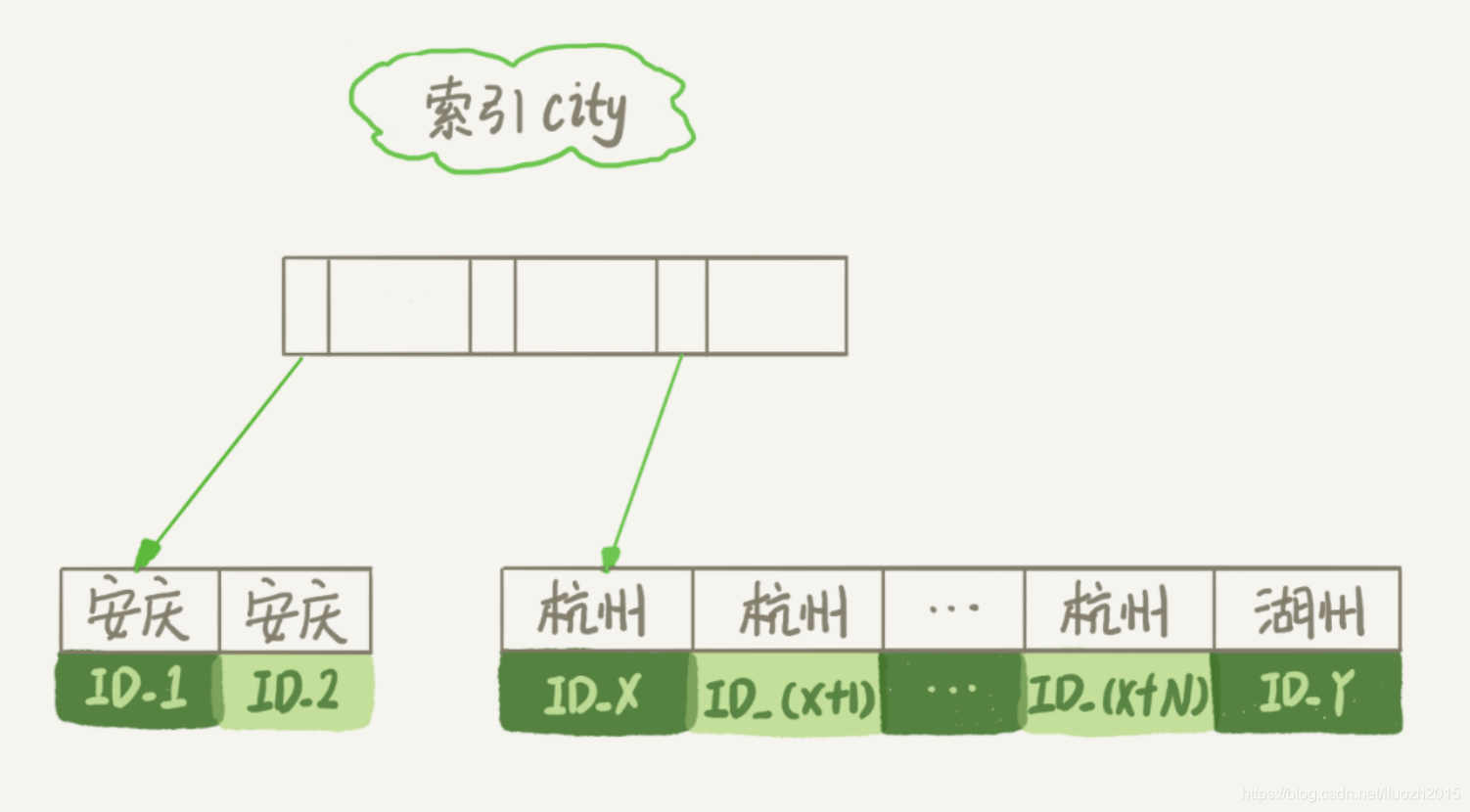

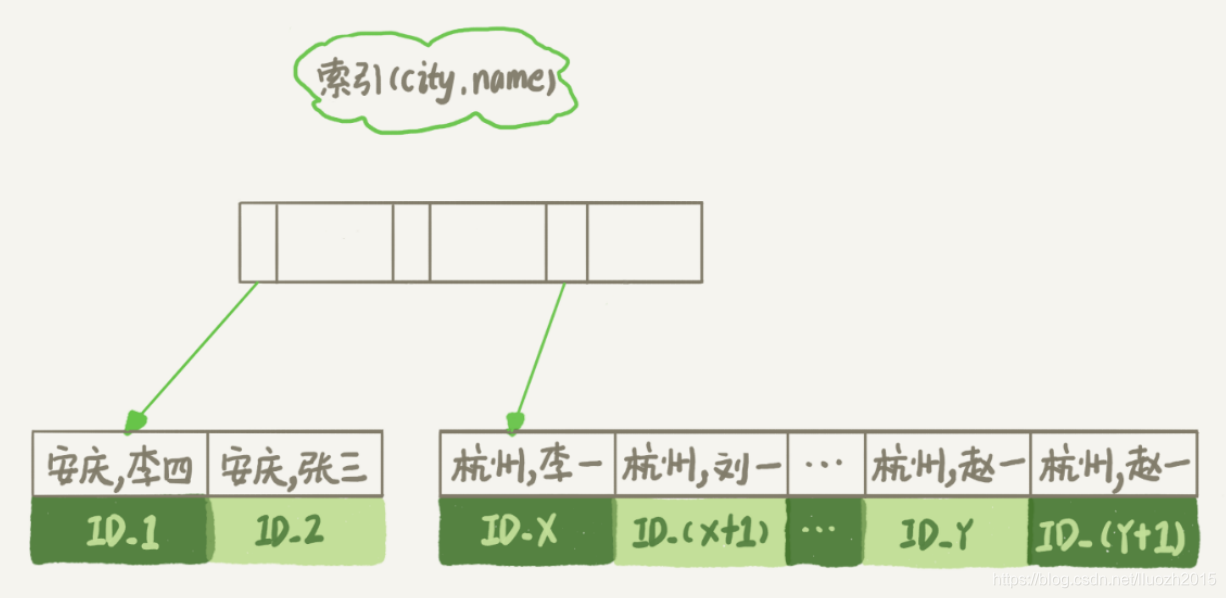

1.2 索引结构

为了说明这个SQL查询语句的执行过程,先来看一下city这个索引的示意图

从图中可以看到,满足city='杭州’条件的行,是从ID_X到ID_(X+N)的这些记录

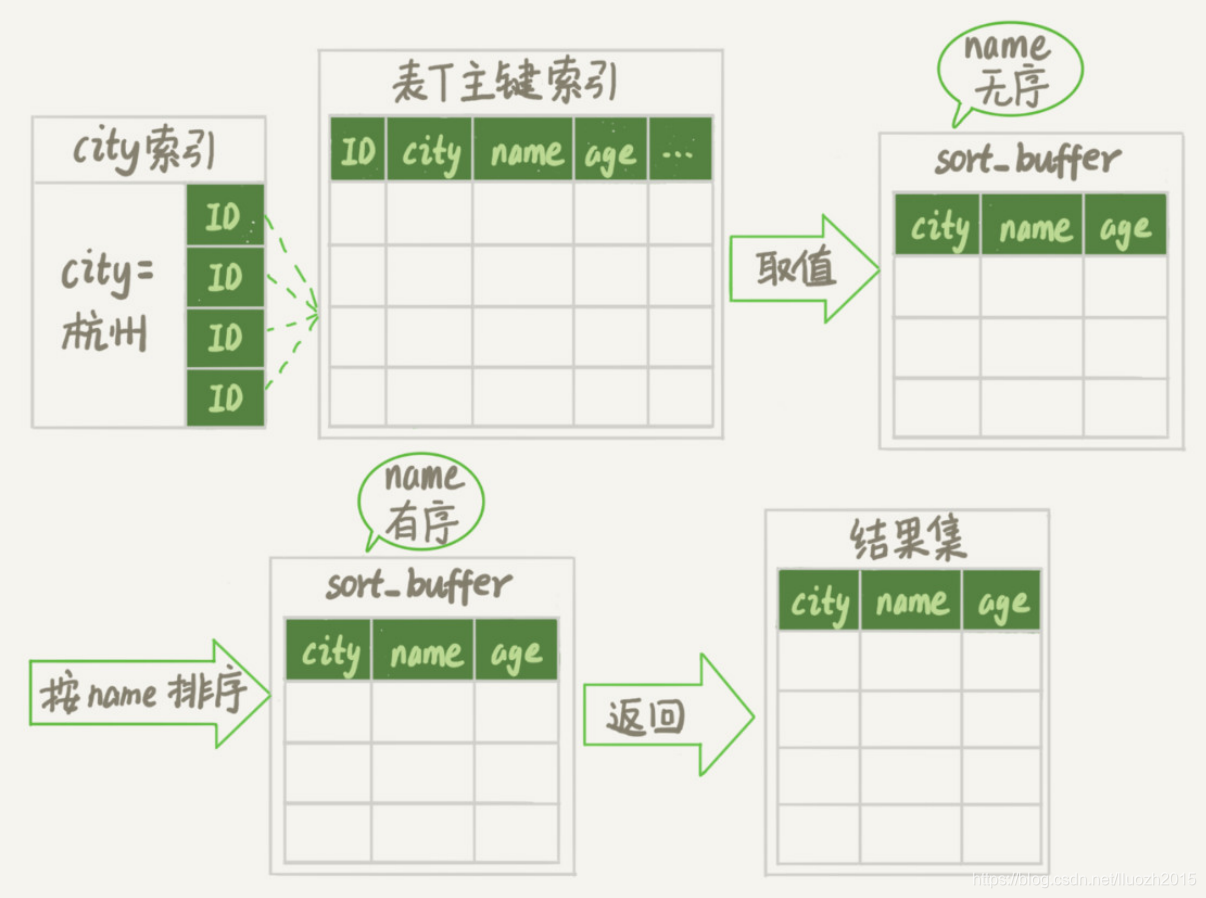

1.3 执行流程

通常情况下,这个语句执行流程如下所示:

- 初始化sort_buffer,确定放入name、city、age这三个字段

- 从索引city找到第一个满足city='杭州’条件的主键id,也就是图中的ID_X

- 到主键id索引取出整行,取name、city、age三个字段的值,存入sort_buffer中

- 从索引city取下一个记录的主键id

- 重复步骤3、4直到city的值不满足查询条件为止,对应的主键id也就是图中的ID_Y

- 对sort_buffer中的数据按照字段name做快速排序

- 按照排序结果取前1000行返回给客户端

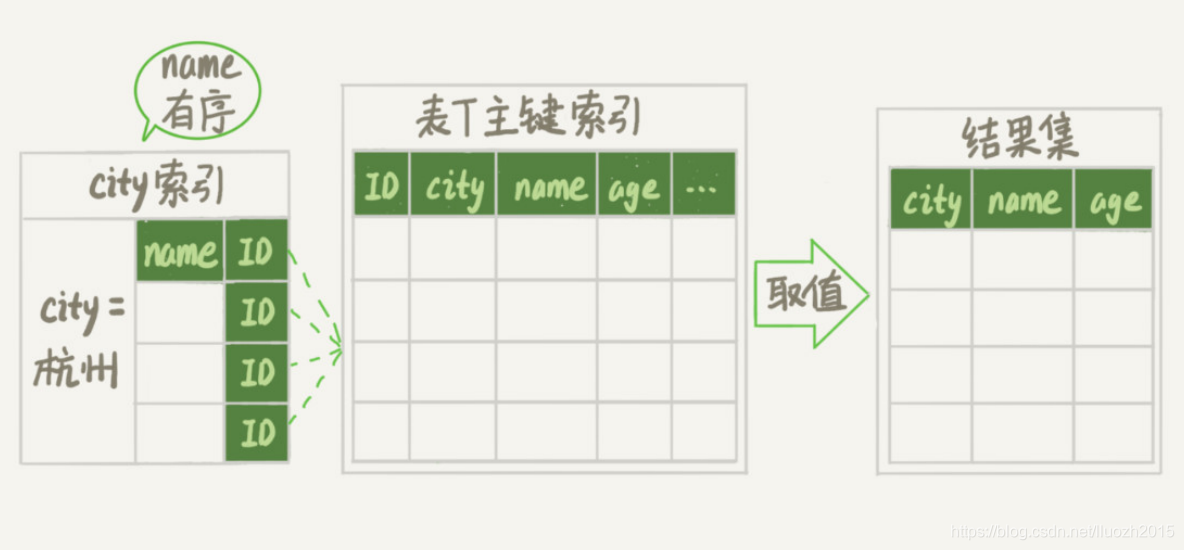

暂且把这个排序过程,称为全字段排序,全字段排序执行流程的示意图如下所示:

图中"按name排序"这个动作,可能在内存中完成,也可能需要使用外部排序,这取决于排序所需的内存和参数sort_buffer_size

1.4 sort_buffer_size

MySQL为排序开辟的内存(sort_buffer)的大小

如果要排序的数据量小于sort_buffer_size,排序就在内存中完成

如果排序数据量太大,内存放不下,则不得不利用磁盘临时文件辅助排序

二、rowid排序

2.1 全字段排序性能问题

在上面这个算法过程里面,只对原表的数据读了一遍,剩下的操作都是在sort_buffer和临时文件中执行的

这个算法有一个问题,如果查询要返回的字段很多的话,那么sort_buffer里面要放的字段数太多,这样内存里能够同时放下的行数很少,要分成很多个临时文件,排序的性能会很差

所以如果单行很大,这个方法效率不够好

那么,如果MySQL认为排序的单行长度太大会怎么做呢?

接下来,修改一个参数,让MySQL采用另外一种算法

SET max_length_for_sort_data = 16;

2.2 max_length_for_sort_data

max_length_for_sort_data是MySQL中专门控制用于排序的行数据的长度的一个参数

如果单行的长度超过这个值,MySQL就认为单行太大,要换一个算法

city、name、age 这三个字段的定义总长度是36,把max_length_for_sort_data设置为16,再来看看计算过程有什么改变

新的算法放入sort_buffer的字段,只有要排序的列(即name字段)和主键id

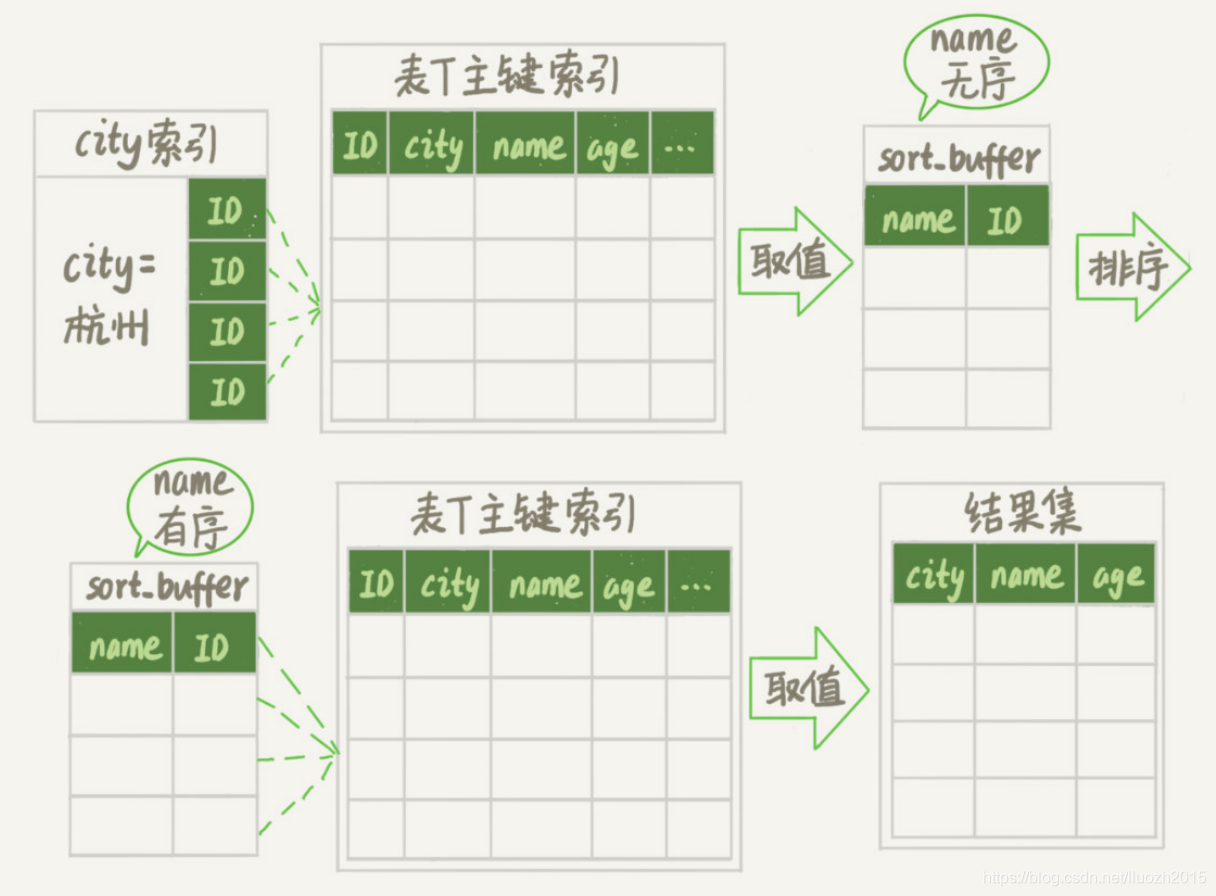

2.3 执行流程

但这时,排序的结果就因为少了city和age字段的值,不能直接返回了,整个执行流程就变成如下所示:

- 初始化sort_buffer,确定放入两个字段,即name和id

- 从索引city找到第一个满足city='杭州’条件的主键id,也就是图中的ID_X

- 到主键id索引取出整行,取name、id这两个字段,存入sort_buffer中

- 从索引city取下一个记录的主键id

- 重复步骤3、4直到不满足city='杭州’条件为止,也就是图中的ID_Y

- 对sort_buffer中的数据按照字段name进行排序

- 遍历排序结果,取前1000行,并按照id的值回到原表中取出city、name和age三个字段返回给客户端

这种排序方式称为rowid排序

rowid排序执行流程的示意图如下:

对比全字段排序流程图,rowid排序多访问了一次表t的主键索引,也就是步骤7

需要说明的是,最后的"结果集"是一个逻辑概念,实际上MySQL服务端从排序后的sort_buffer中依次取出id,然后到原表查到city、name和age这三个字段的结果,不需要在服务端再耗费内存存储结果,是直接返回给客户端的

三、全字段排序 VS rowid排序

分析一下,从这两个执行流程里,还能得出什么结论

3.1 内存因素

- MySQL内存太小

如果MySQL实在是担心排序内存太小,会影响排序效率,才会采用rowid排序算法,这样排序 过程中一次可以排序更多行,但是需要再回到原表去取数据

- MySQL内存足够大

如果MySQL认为内存足够大,会优先选择全字段排序,把需要的字段都放到sort_buffer中, 这样排序后就会直接从内存里面返回查询结果了,不用再回到原表去取数据

这体现了MySQL的一个设计思想:

如果内存够,就要多利用内存,尽量减少磁盘访问

3.2 排序性能成本

对于InnoDB表来说,rowid排序会要求回表多造成磁盘读,因此不会被优先选择

MySQL做排序是一个成本比较高的操作,那么,是不是所有的order by都需要排序操作呢?

如果不排序就能得到正确的结果,那对系统的消耗会小很多, 语句的执行时间也会变得更短

四、覆盖索引排序

4.1 索引默认有序

其实,并不是所有的order by语句,都需要排序操作的

从上面分析的执行过程,可以看到,MySQL之所以需要生成临时表,并且在临时表上做排序操作,其原因是原来的数据都是无序的

可以设想下,如果能够保证从city这个索引上取出来的行,天然就是按照name递增排序的话,是不是就可以不用再排序了呢

确实是这样的

4.2 联合索引创建

所以,可以在这个市民表上创建一个city和name的联合索引,对应的SQL语句是:

alter table t add index city_user(city, name);

4.3 联合索引示意图

作为与city索引的对比,看看city和name联合索引示意图:

在这个索引里面,依然可以用树搜索的方式定位到第一个满足city='杭州’的记录,并且额外确保了,接下来按顺序取"下一条记录"的遍历过程中,只要city的值是杭州,name的值就一定是有序的

4.3 联合索引排序执行流程

这样整个查询过程的流程:

- 从索引(city,name)找到第一个满足city='杭州’条件的主键id;

- 到主键id索引取出整行,取name、city、age三个字段的值,作为结果集的一部分直接返回

- 从索引(city,name)取下一个记录主键id

- 重复步骤2、3,直到查到第1000条记录,或者是不满足city='杭州’条件时循环结束

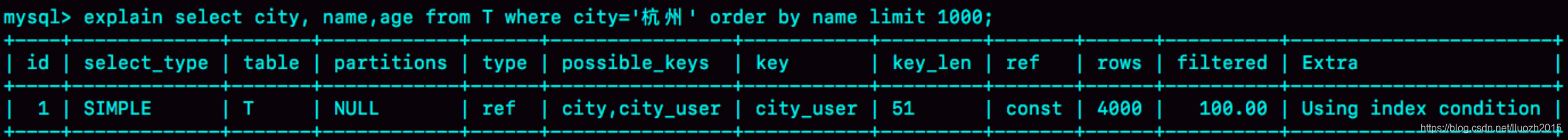

引入(city,name)联合索引后,查询语句的执行计划:

可以看到,这个查询过程不需要临时表,也不需要排序

接下来,用explain的结果来印证:

从图中可以看到,Extra字段中没有Using filesort了,也就是不需要排序了

而且由于 (city,name)这个联合索引本身有序,所以这个查询也不用把4000行全都读一遍,只要找到满足条件的前1000条记录就可以退出了,也就是说,在这个例子里,只需要扫描1000次

既然说到这里了,再往前讨论,那这个语句的执行流程有没有可能进一步简化呢?

前面提到的覆盖索引中,索引上的信息足够满足查询请求,不需要再回到主键索引上去取数据

按照覆盖索引的概念,可以再优化一下这个查询语句的执行流程

针对这个查询,我们可以创建一个city、name和age的联合索引,对应的SQL语句就是:

alter table t add index city_user_age(city, name, age);

这时,对于city字段的值相同的行来说,还是按照name字段的值递增排序的,此时的查询语

句也就不再需要排序了,整个查询语句的执行流程:

- 从索引(city,name,age)找到第一个满足city='杭州’条件的记录,取出其中的city、name和age这三个字段的值,作为结果集的一部分直接返回

- 从索引(city,name,age)取下一个记录,同样取出这三个字段的值,作为结果集的一部分直接返回

- 重复执行步骤2,直到查到第1000条记录,或者是不满足city='杭州’条件时循环结束

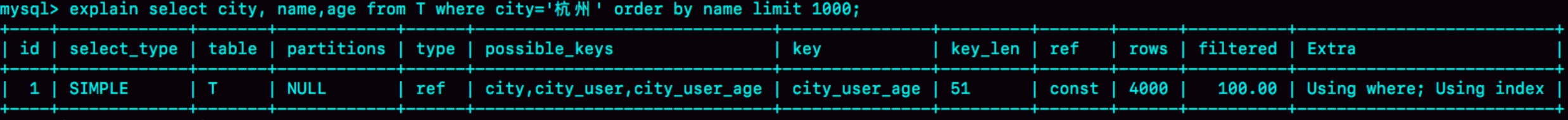

引入(city,name,age)联合索引后,查询语句的执行流程:

然后,再来看看引入(city,name,age)联合索引后explain的结果

可以看到,Extra字段里面多了"Using index",表示的就是使用了覆盖索引,性能上会快很多

当然,这里并不是说要为了每个查询能用上覆盖索引,就要把语句中涉及的字段都建上联合索引,毕竟索引还是有维护代价的,这是一个需要权衡的决定

1377

1377

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?