背景

随着流量增长,服务的节点越来越多,对服务性能要求也越来越大,在服务启动时经常会发现存在抖动,针对这些服务抖动,就需要采取一些预热措施,下面就简单介绍下系统相关的服务预热、中间件预热、数据库预热等

预热场景

服务预热

在《springcloud线上发布超时》系列文章中已经描述了一些微服务需要预热的服务资源,

- 连接池

- 线程池

- 限流池

- grpc连接

- jit

池资源相关预热我这里就不描述了,参考我的发布预热系列文章:springcloud线上发布超时

这里说一下jit,网上有两种方案,

方案一 定制化jdk

将jit过程信息保存到文件中,下次发布时自动加载,成熟方案是阿里的jwarmup,已经集成到阿里的jdk中,有兴趣的可以了解下

方案二 跑测试用例预热

一般都是采用测试用例预热,如果仅仅是jdk预热,可以直接跑几个测试用例循环n次就行,但是如果涉及到中间件预热,这里就可能不满足需求了。

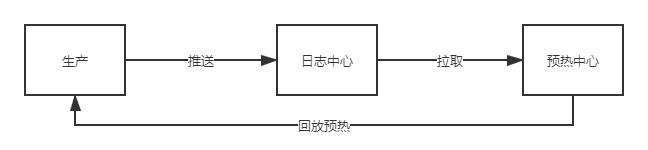

我现在就是采用流量录制以及回放预热,如下图:

方案三 定制路由策略,通过tag配置来路由

这里的方案就是需要定制化路由策略,刚启动的服务注册时带上一些配置信息,网关或者服务调用段获取到配置后来根据配置来路由,先路由少量流量,慢慢增加直到路由100%,这样可以达到针对jit的预热效果

中间件预热

redis预热

先在很多服务为了提高吞吐量而使用redis,这就会导致服务启动后或者redis数据丢失后,会导致请求都打到db中去,从而导致db压力倍增,这就是常见的redis雪崩。

CDN预热

CDN经常是也承担了入口缓存,那么这里也会需要预热,可以录制生产流量回放来达到预热效果。

mysql预热

mysql重启后十几分钟的性能是非常差的,原因是因为InnoDB有innodb buffer pool,详细可以参考该链接:https://blog.csdn.net/u014236541/article/details/79870670

416

416

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?