原文地址:http://blog.csdn.net/xvshu/article/details/47667235?locationNum=3&fps=1

不久前,我们讨论过Nginx+tomcat组成的集群,这已经是非常灵活的集群技术,但是当我们的系统遇到更大的瓶颈,全部应用的单点服务器已经不能满足我们的需求,这时,我们要考虑另外一种,我们熟悉的内容,就是分布式,而当下流行的Dubbo框架,不容我们忽视,这里,咱们一起来探讨一下这个框架的使用。

一,背景

以前我们需要远程调用他人的接口,我们是这么做的:

我们遇到的问题:

(1) 当服务越来越多时,服务URL配置管理变得非常困难,F5硬件负载均衡器的单点压力也越来越大。

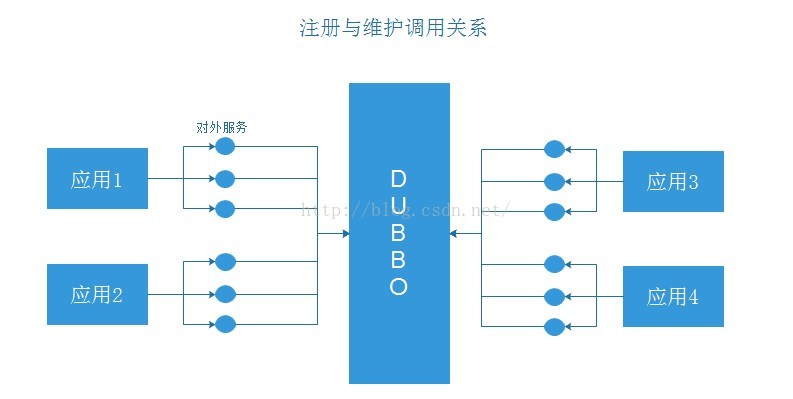

此时需要一个服务注册中心,动态的注册和发现服务,使服务的位置透明。

并通过在消费方获取服务提供方地址列表,实现软负载均衡和Failover,降低对F5硬件负载均衡器的依赖,也能减少部分成本。

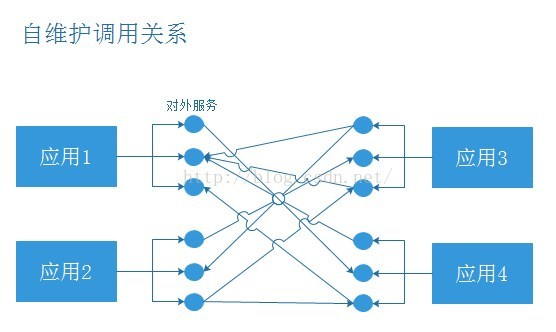

(2) 当进一步发展,服务间依赖关系变得错踪复杂,甚至分不清哪个应用要在哪个应用之前启动,架构师都不能完整的描述应用的架构关系。

这时,需要自动画出应用间的依赖关系图,以帮助架构师理清理关系。

(3) 接着,服务的调用量越来越大,服务的容量问题就暴露出来,这个服务需要多少机器支撑?什么时候该加机器?

为了解决这些问题,第一步,要将服务现在每天的调用量,响应时间,都统计出来,作为容量规划的参考指标。

其次,要可以动态调整权重,在线上,将某台机器的权重一直加大,并在加大的过程中记录响应时间的变化,直到响应时间到达阀值,记录此时的访问量,再以此访问量乘以机器数反推总容量。

为解决这些问题,Dubbo为我们做了什么呢:

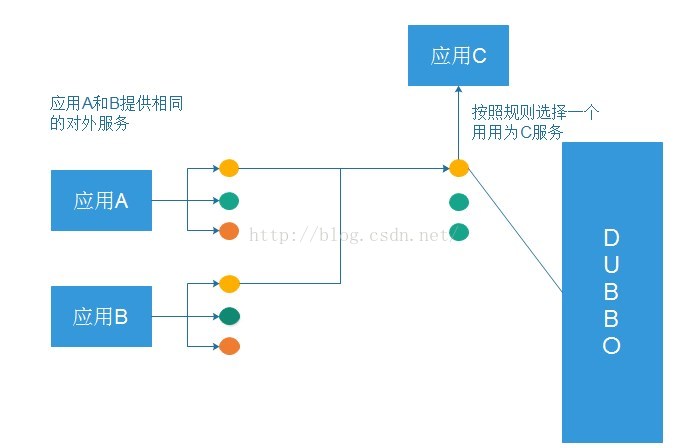

负载均衡:

这就是所谓的软负载均衡!

现在让我们一起来接触下这个优秀的框架:

简介

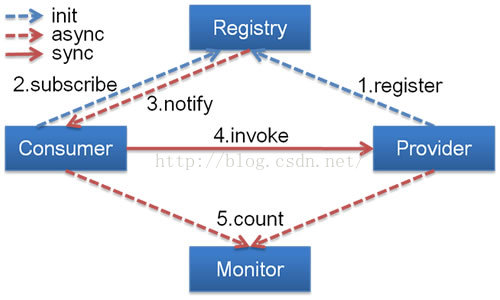

架构如图:

节点角色说明:

Provider: 暴露服务的服务提供方。

Consumer: 调用远程服务的服务消费方。

Registry: 服务注册与发现的注册中心。

Monitor: 统计服务的调用次调和调用时间的监控中心。

Container: 服务运行容器。

调用关系说明:

0. 服务容器负责启动,加载,运行服务提供者。

1. 服务提供者在启动时,向注册中心注册自己提供的服务。

2. 服务消费者在启动时,向注册中心订阅自己所需的服务。

3. 注册中心返回服务提供者地址列表给消费者,如果有变更,注册中心将基于长连接推送变更数据给消费者。

4. 服务消费者,从提供者地址列表中,基于软负载均衡算法,选一台提供者进行调用,如果调用失败,再选另一台调用。

5. 服务消费者和提供者,在内存中累计调用次数和调用时间,定时每分钟发送一次统计数据到监控中心。

Dubbo提供了很多协议,Dubbo协议、RMI协议、Hessian协议,我们查看Dubbo源代码,有各种协议的实现,如图所示:

我们之前没用Dubbo之前时,大部分都使用Hessian来使用我们服务的暴露和调用,利用HessianProxyFactory调用远程接口。

上面是参考了Dubbo官方网介绍,接下来我们来介绍SpringMVC、Dubbo、Zookeeper整合使用。

第一步:在Linux上安装Zookeeper

Zookeeper作为Dubbo服务的注册中心,Dubbo原先基于数据库的注册中心,没采用Zookeeper,Zookeeper一个分布式的服务框架,是树型的目录服务的数据存储,能做到集群管理数据 ,这里能很好的作为Dubbo服务的注册中心,Dubbo能与Zookeeper做到集群部署,当提供者出现断电等异常停机时,Zookeeper注册中心能自动删除提供者信息,当提供者重启时,能自动恢复注册数据,以及订阅请求。我们先在linux上安装Zookeeper,我们安装最简单的单点,集群比较麻烦。

先需要安装JdK,从Oracle的Java网站下载,安装很简单,就不再详述。

单机安装非常简单,只要获取到 Zookeeper 的压缩包并解压到某个目录如:C:\zookeeper-3.4.5\下,Zookeeper 的启动脚本在 bin 目录下,Windows 下的启动脚本是 zkServer.cmd。

在你执行启动脚本之前,还有几个基本的配置项需要配置一下,Zookeeper 的配置文件在 conf 目录下,这个目录下有 zoo_sample.cfg 和 log4j.properties,你需要做的就是将 zoo_sample.cfg 改名为 zoo.cfg,因为 Zookeeper 在启动时会找这个文件作为默认配置文件。下面详细介绍一下,这个配置文件中各个配置项的意义。

- tickTime:这个时间是作为 Zookeeper 服务器之间或客户端与服务器之间维持心跳的时间间隔,也就是每个 tickTime 时间就会发送一个心跳。

- dataDir:顾名思义就是 Zookeeper 保存数据的目录,默认情况下,Zookeeper 将写数据的日志文件也保存在这个目录里。

- dataLogDir:顾名思义就是 Zookeeper 保存日志文件的目录

- clientPort:这个端口就是客户端连接 Zookeeper 服务器的端口,Zookeeper 会监听这个端口,接受客户端的访问请求。

当这些配置项配置好后,你现在就可以启动 Zookeeper 了,启动后要检查 Zookeeper 是否已经在服务,可以通过 netstat – ano 命令查看是否有你配置的 clientPort 端口号在监听服务。

第二步:配置dubbo-admin的管理页面,方便我们管理页面

(1)下载dubbo-admin-2.4.1.war包,在windows的tomcat部署,先把dubbo-admin-2.4.1放在tomcat的webapps/ROOT下,然后进行解压

(2)然后到webapps/ROOT/WEB-INF下,有一个dubbo.properties文件,里面指向Zookeeper ,使用的是Zookeeper 的注册中心,如图所示:

(3)然后启动tomcat服务,用户名和密码:root,并访问服务,显示登陆页面,说明dubbo-admin部署成功,如图所示:

第三步:SpringMVC与Dubbo的整合,这边使用的Maven的管理项目

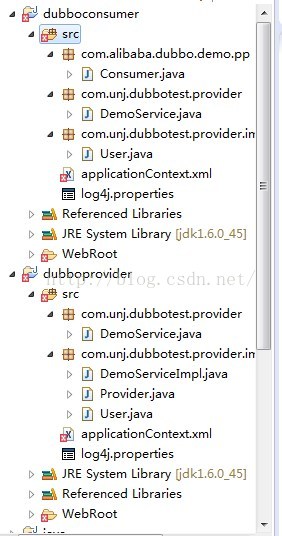

第一:我们先开发服务注册的,就是提供服务,项目结构如图所示:

(1)test-maven-api项目加入了一个服务接口,代码如下:

(2)test-maven-console在pom.xml加入Dubbo和Zookeeper的jar包、引用test-maven-api的jar包,代码如下:

(3)test-maven-console实现具体的服务,代码如下:

(4)我们服务以及实现好了,这时要暴露服务,代码如下:

说明:

dubbo:registry 标签一些属性的说明:

1)register是否向此注册中心注册服务,如果设为false,将只订阅,不注册。

2)check注册中心不存在时,是否报错。

3)subscribe是否向此注册中心订阅服务,如果设为false,将只注册,不订阅。

4)timeout注册中心请求超时时间(毫秒)。

5)address可以Zookeeper集群配置,地址可以多个以逗号隔开等。

dubbo:service标签的一些属性说明:

1)interface服务接口的路径

2)ref引用对应的实现类的Bean的ID

3)registry向指定注册中心注册,在多个注册中心时使用,值为<dubbo:registry>的id属性,多个注册中心ID用逗号分隔,如果不想将该服务注册到任何registry,可将值设为N/A

4)register 默认true ,该协议的服务是否注册到注册中心。

(5)启动项目,然后我们在Dubbo管理页面上显示,已经暴露的服务,但显示还没有消费者,因为我们还没实现消费者服务,如图所示:

第二:我们在开发服务消费者,就是调用服务,我们在新建一个新的消费者项目:

(1)test-maven-server-console的pom.xml引入Dubbo和Zookeeper的jar包、test-maven-api的jar包,因为引入test-maven-api的jar包,我们在项目中调用像在本地调用一样。代码如下:

(2)test-maven-server-console项目的具体实现,代码如下:

(3)我们要引用的地址,代码如下:

说明:

dubbo:reference 的一些属性的说明:

1)interface调用的服务接口

2)check 启动时检查提供者是否存在,true报错,false忽略

3)registry 从指定注册中心注册获取服务列表,在多个注册中心时使用,值为<dubbo:registry>的id属性,多个注册中心ID用逗号分隔

4)loadbalance 负载均衡策略,可选值:random,roundrobin,leastactive,分别表示:随机,轮循,最少活跃调用

(4)项目启动,Dubbo管理页面,能看到消费者,如图所示:

(5)然后访问消费者项目,Controller层能像调用本地一样调用服务的具体实现,如图所示:

总结:

经过一系列的操作之后,我们感觉,的确很简单,dubbo给我们封装了很多操作,让我们不需要过多考虑具体的实现细节,配置化生成咱们的应用,这样的思想,现在在IT行业正在盛行!

---------------------------------------Linux下安装和应用---------------------------------------------------------

Dubbo 建议使用 Zookeeper 作为服务的注册中心

Zookeeper 集群中只要有过半的节点是正常的情况下,那么整个集群对外就是可用的。正是基于这个 特性,要将 ZK 集群的节点数量要为奇数(2n+1:如 3、5、7 个节点)较为合适。

ZooKeeper 与 Dubbo 服务集群架构图

服务器 1:192.168.1.81 端口:2181、2881、3881

服务器 2:192.168.1.82 端口:2182、2882、3882

服务器 3:192.168.1.83 端口:2183、2883、3883

一、集群节点安装和配置

1、 修改操作系统的/etc/hosts 文件,添加 IP 与主机名映射:

# zookeeper cluster servers 192.168.1.81 edu-zk-01 192.168.1.82 edu-zk-02 192.168.1.83 edu-zk-03

2、 下载或上传 zookeeper-3.4.6.tar.gz 到/home/wusc/zookeeper 目录:

$ cd /home/wusc/zookeeper

$ wget http://apache.fayea.com/zookeeper/zookeeper-3.4.6/zookeeper-3.4.6.tar.gz

3、 解压 zookeeper 安装包,并按节点号对 zookeeper 目录重命名:

$ tar -zxvf zookeeper-3.4.6.tar.gz

服务器 1:

$ mv zookeeper-3.4.6 node-01

服务器 2:

$ mv zookeeper-3.4.6 node-02

服务器 3:

$ mv zookeeper-3.4.6 node-03

4、 在各 zookeeper 节点目录下创建以下目录:

$ cd /home/wusc/zookeeper/node-0X(X 代表节点号 1、2、3,以下同解)

$ mkdir data

$ mkdir logs

5、 将 zookeeper/node-0X/conf 目录下的 zoo_sample.cfg 文件拷贝一份,命名为 zoo.cfg:

$ cp zoo_sample.cfg zoo.cfg

6、 修改 zoo.cfg 配置文件:

zookeeper/node-01 的配置(/home/wusc/zookeeper/node-01/conf/zoo.cfg)如下:

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/home/wusc/zookeeper/node-01/data

dataLogDir=/home/wusc/zookeeper/node-01/logs

clientPort=2181

server.1=edu-zk-01:2881:3881

server.2=edu-zk-02:2882:3882

server.3=edu-zk-03:2883:3883

zookeeper/node-02 的配置(/home/wusc/zookeeper/node-02/conf/zoo.cfg)如下:

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/home/wusc/zookeeper/node-02/data

dataLogDir=/home/wusc/zookeeper/node-02/logs

clientPort=2182

server.1=edu-zk-01:2881:3881

server.2=edu-zk-02:2882:3882

server.3=edu-zk-03:2883:3883

zookeeper/node-03 的配置(/home/wusc/zookeeper/node-03/conf/zoo.cfg)如下:

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/home/wusc/zookeeper/node-03/data

dataLogDir=/home/wusc/zookeeper/node-03/logs

clientPort=2183

server.1=edu-zk-01:2881:3881

server.2=edu-zk-02:2882:3882

server.3=edu-zk-03:2883:3883

参数说明:

tickTime=2000tickTime 这个时间是作为 Zookeeper 服务器之间或客户端与服务器之间维持心跳的时间间隔,也就是每个 tickTime 时间就会发送一个心跳。

initLimit=10initLimit 这个配置项是用来配置 Zookeeper 接受客户端(这里所说的客户端不是用户连接 Zookeeper服务器的客户端,而是 Zookeeper 服务器集群中连接到 Leader 的 Follower 服务器)初始化连接时最长能忍受多少个心跳时间间隔数。当已经超过 10 个心跳的时间(也就是 tickTime)长度后 Zookeeper 服务器还没有收到客户端的返回信息,那么表明这个客户端连接失败。总的时间长度就是10*2000=20 秒。

syncLimit=5syncLimit 这个配置项标识 Leader 与 Follower 之间发送消息,请求和应答时间长度,最长不能超过多少个tickTime 的时间长度,总的时间长度就是 5*2000=10 秒。

dataDir=/home/wusc/zookeeper/node-01/data

dataDir 顾名思义就是 Zookeeper 保存数据的目录,默认情况下 Zookeeper 将写数据的日志文件也保存在这个目录里。

clientPort=2181

clientPort 这个端口就是客户端(应用程序)连接 Zookeeper 服务器的端口,Zookeeper 会监听这个端口接受客户端的访问请求。

server.A=B:C:D

server.1=edu-zk-01:2881:3881

server.2=edu-zk-02:2882:3882

server.3=edu-zk-03:2883:3883

A 是一个数字,表示这个是第几号服务器;

B 是这个服务器的 IP 地址(或者是与 IP 地址做了映射的主机名);

C 第一个端口用来集群成员的信息交换,表示这个服务器与集群中的 Leader 服务器交换信息的端口;

D 是在 leader 挂掉时专门用来进行选举 leader 所用的端口。

注意:如果是伪集群的配置方式,不同的Zookeeper 实例通信端口号不能一样,所以要给它们分配不同的端口号。

7、在 dataDir=/home/wusc/zookeeper/node-0X/data下创建 myid文件

编辑 myid 文件,并在对应的IP 的机器上输入对应的编号。如在node-01 上,myid 文件内容就是1,node-02 上就是 2,node-03 上就是 3:

| $ | vi /home/wusc/zookeeper/node-01/data/myid | ## 值为 1 | ||

| $ | vi | /home/wusc/zookeeper/node-02/data/myid | ## | 值为 2 |

| $ | vi | /home/wusc/zookeeper/node-03/data/myid | ## | 值为 3 |

8、 在防火墙中打开要用到的端口 218X、288X、388X

切换到 root 用户权限,执行以下命令:

# chkconfig iptables on

# service iptables start

编辑/etc/sysconfig/iptables

# vi /etc/sysconfig/iptables

如服务器 01 增加以下 3 行:

## zookeeper

-A INPUT -m state --state NEW -m tcp -p tcp --dport 2181 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 2881 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 3881 -j ACCEPT

重启防火墙:

# service iptables restart

查看防火墙端口状态:

# service iptables status

9、 启动并测试 zookeeper(要用 wusc 用户启动,不要用 root):

(1) 使用 wusc 用户到/home/wusc/zookeeper/node-0X/bin 目录中执行:

$ /home/wusc/zookeeper/node-01/bin/zkServer.sh start

$ /home/wusc/zookeeper/node-02/bin/zkServer.sh start

$ /home/wusc/zookeeper/node-03/bin/zkServer.sh start

(2) 输入jps 命令查看进程:

$ jps

1456

QuorumPeerMain

其中,QuorumPeerMain 是zookeeper 进程,说明启动正常

(3) 查看状态:

$ /home/wusc/zookeeper/node-01/bin/zkServer.sh status

(4) 查看 zookeeper 服务输出信息:

由于服务信息输出文件在/home/wusc/zookeeper/node-0X/bin/zookeeper.out

$ tail -500f zookeeper.out

10、停止 zookeeper 进程:

$ zkServer.sh stop

11、配置 zookeeper 开机使用 wusc 用户启动:

编辑 node-01、node-02、node-03 中的/etc/rc.local 文件,分别加入:

su - wusc -c '/home/wusc/zookeeper/node-01/bin/zkServer.sh start'

su - wusc -c '/home/wusc/zookeeper/node-02/bin/zkServer.sh start'

su - wusc -c '/home/wusc/zookeeper/node-03/bin/zkServer.sh start'

二、安装 Dubbo 管控台(主要是配置连接集群):

Dubbo 管控台可以对注册到 zookeeper 注册中心的服务或服务消费者进行管理,但管控台是否正常对Dubbo 服务没有影响,管控台也不需要高可用,因此可以单节点部署。

IP: 192.168.1.81

部署容器:Tomcat7

端口:8080

1、 下载(或上传)最新版的 Tomcat7(apache-tomcat-7.0.57.tar.gz)到/home/wusc/

2、 解压:

$ tar -zxvf apache-tomcat-7.0.57.tar.gz

$ mv apache-tomcat-7.0.57 dubbo-admin-tomcat

3、 移除/home/wusc/dubbo-admin-tomcat/webapps 目录下的所有文件:

$ rm -rf *

4、 上传 Dubbo 管理控制台程序 dubbo-admin-2.5.3.war到/home/wusc/dubbo-admin-tomcat/webapps

5、 解压并把目录命名为 ROOT:

$ unzip dubbo-admin-2.5.3.war -d ROOT

把 dubbo-admin-2.5.3.war 移到/home/wusc/tools 目录备份

$ mv dubbo-admin-2.5.3.war /home/wusc/tools

6、 配置 dubbo.properties:

[root@edu-zk-01 WEB-INF]# vi dubbo.properties[root@edu-zk-01 WEB-INF]# cat dubbo.properties | grep re

dubbo.registry.address=zookeeper://192.168.1.81:2181?backup=192.168.1.82:2182,192.168.1.83:2183

三、测试集群高可用

启用edu-zk-03,这里是从节点

[root@edu-zk-03 conf]# /home/wusc/zookeeper/node-03/bin/zkServer.sh start

JMX enabled by default

Using config: /home/wusc/zookeeper/node-03/bin/../conf/zoo.cfg

Starting zookeeper ... STARTED

[root@edu-zk-03 conf]# /home/wusc/zookeeper/node-03/bin/zkServer.sh status

JMX enabled by default

Using config: /home/wusc/zookeeper/node-03/bin/../conf/zoo.cfg

Mode: follower

我们再关掉edu-zk-02的leader节点

[root@edu-zk-02 root]# /home/wusc/zookeeper/node-02/bin/zkServer.sh stop

JMX enabled by default

Using config: /home/wusc/zookeeper/node-02/bin/../conf/zoo.cfg

Stopping zookeeper ... STOPPED

我们再查看edu-zk-03 status

[root@edu-zk-03 conf]# /home/wusc/zookeeper/node-03/bin/zkServer.sh status

JMX enabled by default

Using config: /home/wusc/zookeeper/node-03/bin/../conf/zoo.cfg

Mode: leader

这时edu-zk-03变成了leader,

provider控制台信息

016-04-15 16:53:15,516 WARN [ClientCnxn.Java:1089] : Session 0x15418fd25210000 for server null, unexpected error, closing socket connection and attempting reconnect

java.NET.ConnectException: Connection refused: no further information

at sun.nio.ch.SocketChannelImpl.checkConnect(Native Method)

at sun.nio.ch.SocketChannelImpl.finishConnect(SocketChannelImpl.java:735)

at org.apache.zookeeper.ClientCnxnSocketNIO.doTransport(ClientCnxnSocketNIO.java:350)

at org.apache.zookeeper.ClientCnxn$SendThread.run(ClientCnxn.java:1068)

2016-04-15 16:53:15,517 DEBUG [ClientCnxnSocketNIO.java:192] : Ignoring exception during shutdown input

java.nio.channels.ClosedChannelException

at sun.nio.ch.SocketChannelImpl.shutdownInput(SocketChannelImpl.java:798)

at sun.nio.ch.SocketAdaptor.shutdownInput(SocketAdaptor.java:426)

at org.apache.zookeeper.ClientCnxnSocketNIO.cleanup(ClientCnxnSocketNIO.java:189)

at org.apache.zookeeper.ClientCnxn$SendThread.cleanup(ClientCnxn.java:1157)

at org.apache.zookeeper.ClientCnxn$SendThread.run(ClientCnxn.java:1097)

2016-04-15 16:53:15,518 DEBUG [ClientCnxnSocketNIO.java:199] : Ignoring exception during shutdown output

java.nio.channels.ClosedChannelException

at sun.nio.ch.SocketChannelImpl.shutdownOutput(SocketChannelImpl.java:815)

at sun.nio.ch.SocketAdaptor.shutdownOutput(SocketAdaptor.java:434)

at org.apache.zookeeper.ClientCnxnSocketNIO.cleanup(ClientCnxnSocketNIO.java:196)

at org.apache.zookeeper.ClientCnxn$SendThread.cleanup(ClientCnxn.java:1157)

at org.apache.zookeeper.ClientCnxn$SendThread.run(ClientCnxn.java:1097)

2016-04-15 16:53:16,506 INFO [ClientCnxn.java:966] : Opening socket connection to server 192.168.1.83/192.168.1.83:2183. Will not attempt to authenticate using SASL (unknown error)

2016-04-15 16:53:16,507 INFO [ClientCnxn.java:849] : Socket connection established to 192.168.1.83/192.168.1.83:2183, initiating session

2016-04-15 16:53:16,510 DEBUG [ClientCnxn.java:889] : Session establishment request sent on 192.168.1.83/192.168.1.83:2183

2016-04-15 16:53:16,515 INFO [ClientCnxn.java:1207] : Session establishment complete on server 192.168.1.83/192.168.1.83:2183, sessionid = 0x15418fd25210000, negotiated timeout = 30000

2016-04-15 16:53:16,515 DEBUG [ZkClient.java:351] : Received event: WatchedEvent state:SyncConnected type:None path:null

2016-04-15 16:53:16,516 INFO [ZkClient.java:449] : zookeeper state changed (SyncConnected)

2016-04-15 16:53:16,516 DEBUG [ZkEventThread.java:88] : New event: ZkEvent[State changed to SyncConnected sent to com.alibaba.dubbo.remoting.zookeeper.zkclient.ZkclientZookeeperClient$1@20f8f517]

2016-04-15 16:53:16,516 DEBUG [ZkClient.java:395] : Leaving process event

2016-04-15 16:53:16,516 DEBUG [ZkEventThread.java:69] : Delivering event #2 ZkEvent[State changed to SyncConnected sent to com.alibaba.dubbo.remoting.zookeeper.zkclient.ZkclientZookeeperClient$1@20f8f517]

2016-04-15 16:53:16,517 DEBUG [ZkEventThread.java:79] : Delivering event #2 done

JMX enabled by default

Using config: /home/yxq/zookeeper/node-03/bin/../conf/zoo.cfg

Mode: leader

我们再关闭edu-zk-01节点

这里provider控制台信息报错(集群节点没有过半),这时dubbo管理台是可以正常运行的,但是集群是无用,提供者服务是缓存的,如果重启dubbo管理控制台,会发现启动不了,但是如果再启动一个节点edu-zk-01或edu-zk-02,管理控制台又立即可以运行起来。

java.Net.SocketException: Connection reset by peer: shutdown

at sun.nio.ch.Net.shutdown(Native Method)

at sun.nio.ch.SocketChannelImpl.shutdownOutput(SocketChannelImpl.java:819)

at sun.nio.ch.SocketAdaptor.shutdownOutput(SocketAdaptor.java:434)

at org.apache.zookeeper.ClientCnxnSocketNIO.cleanup(ClientCnxnSocketNIO.java:196)

at org.apache.zookeeper.ClientCnxn$SendThread.cleanup(ClientCnxn.java:1157)

at org.apache.zookeeper.ClientCnxn$SendThread.run(ClientCnxn.java:1097)

2016-04-15 16:58:09,848 INFO [ClientCnxn.java:966] : Opening socket connection to server 192.168.1.81/192.168.1.81:2181. Will not attempt to authenticate using SASL (unknown error)

2016-04-15 16:58:10,848 WARN [ClientCnxn.java:1089] : Session 0x15418fd25210000 for server null, unexpected error, closing socket connection and attempting reconnect

java.net.ConnectException: Connection refused: no further information

at sun.nio.ch.SocketChannelImpl.checkConnect(Native Method)

at sun.nio.ch.SocketChannelImpl.finishConnect(SocketChannelImpl.java:735)

at org.apache.zookeeper.ClientCnxnSocketNIO.doTransport(ClientCnxnSocketNIO.java:350)

at org.apache.zookeeper.ClientCnxn$SendThread.run(ClientCnxn.java:1068)

2016-04-15 16:58:10,848 DEBUG [ClientCnxnSocketNIO.java:192] : Ignoring exception during shutdown input

java.nio.channels.ClosedChannelException

at sun.nio.ch.SocketChannelImpl.shutdownInput(SocketChannelImpl.java:798)

at sun.nio.ch.SocketAdaptor.shutdownInput(SocketAdaptor.java:426)

at org.apache.zookeeper.ClientCnxnSocketNIO.cleanup(ClientCnxnSocketNIO.java:189)

at org.apache.zookeeper.ClientCnxn$SendThread.cleanup(ClientCnxn.java:1157)

at org.apache.zookeeper.ClientCnxn$SendThread.run(ClientCnxn.java:1097)

2016-04-15 16:58:10,849 DEBUG [ClientCnxnSocketNIO.java:199] : Ignoring exception during shutdown output

java.nio.channels.ClosedChannelException

at sun.nio.ch.SocketChannelImpl.shutdownOutput(SocketChannelImpl.java:815)

at sun.nio.ch.SocketAdaptor.shutdownOutput(SocketAdaptor.java:434)

at org.apache.zookeeper.ClientCnxnSocketNIO.cleanup(ClientCnxnSocketNIO.java:196)

at org.apache.zookeeper.ClientCnxn$SendThread.cleanup(ClientCnxn.java:1157)

at org.apache.zookeeper.ClientCnxn$SendThread.run(ClientCnxn.java:1097)

2016-04-15 16:58:11,552 INFO [ClientCnxn.java:966] : Opening socket connection to server 192.168.1.82/192.168.1.82:2182. Will not attempt to authenticate using SASL (unknown error)

2016-04-15 16:58:12,553 WARN [ClientCnxn.java:1089] : Session 0x15418fd25210000 for server null, unexpected error, closing socket connection and attempting reconnect

java.net.ConnectException: Connection refused: no further information

at sun.nio.ch.SocketChannelImpl.checkConnect(Native Method)

at sun.nio.ch.SocketChannelImpl.finishConnect(SocketChannelImpl.java:735)

at org.apache.zookeeper.ClientCnxnSocketNIO.doTransport(ClientCnxnSocketNIO.java:350)

at org.apache.zookeeper.ClientCnxn$SendThread.run(ClientCnxn.java:1068)

2016-04-15 16:58:12,554 DEBUG [ClientCnxnSocketNIO.java:192] : Ignoring exception during shutdown input

java.nio.channels.ClosedChannelException

at sun.nio.ch.SocketChannelImpl.shutdownInput(SocketChannelImpl.java:798)

at sun.nio.ch.SocketAdaptor.shutdownInput(SocketAdaptor.java:426)

at org.apache.zookeeper.ClientCnxnSocketNIO.cleanup(ClientCnxnSocketNIO.java:189)

at org.apache.zookeeper.ClientCnxn$SendThread.cleanup(ClientCnxn.java:1157)

at org.apache.zookeeper.ClientCnxn$SendThread.run(ClientCnxn.java:1097)

2016-04-15 16:58:12,555 DEBUG [ClientCnxnSocketNIO.java:199] : Ignoring exception during shutdown output

java.nio.channels.ClosedChannelException

at sun.nio.ch.SocketChannelImpl.shutdownOutput(SocketChannelImpl.java:815)

at sun.nio.ch.SocketAdaptor.shutdownOutput(SocketAdaptor.java:434)

at org.apache.zookeeper.ClientCnxnSocketNIO.cleanup(ClientCnxnSocketNIO.java:196)

at org.apache.zookeeper.ClientCnxn$SendThread.cleanup(ClientCnxn.java:1157)

at org.apache.zookeeper.ClientCnxn$SendThread.run(ClientCnxn.java:1097)

2016-04-15 16:58:13,909 INFO [ClientCnxn.java:966] : Opening socket connection to server 192.168.1.83/192.168.1.83:2183. Will not attempt to authenticate using SASL (unknown error)

2016-04-15 16:58:13,910 INFO [ClientCnxn.java:849] : Socket connection established to 192.168.1.83/192.168.1.83:2183, initiating session

2016-04-15 16:58:13,911 DEBUG [ClientCnxn.java:889] : Session establishment request sent on 192.168.1.83/192.168.1.83:2183

2016-04-15 16:58:13,914 INFO [ClientCnxn.java:1085] : Unable to read additional data from server sessionid 0x15418fd25210000, likely server has closed socket, closing socket connection and attempting reconnect

2016-04-15 16:58:13,915 DEBUG [ClientCnxnSocketNIO.java:199] : Ignoring exception during shutdown output

四、注册中心的升级或者迁移

1032

1032

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?