论文地址:https://www.ecva.net/papers/eccv_2024/papers_ECCV/papers/00666.pdf

代码地址:https://github.com/lliai/AttnZero

关注UP CV缝合怪,分享最计算机视觉新即插即用模块,并提供配套的论文资料与代码。

https://space.bilibili.com/473764881

摘要

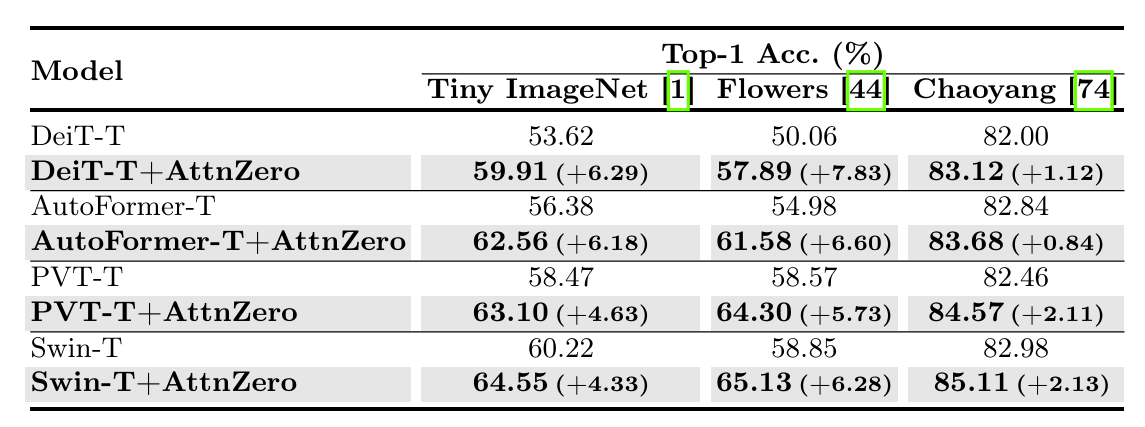

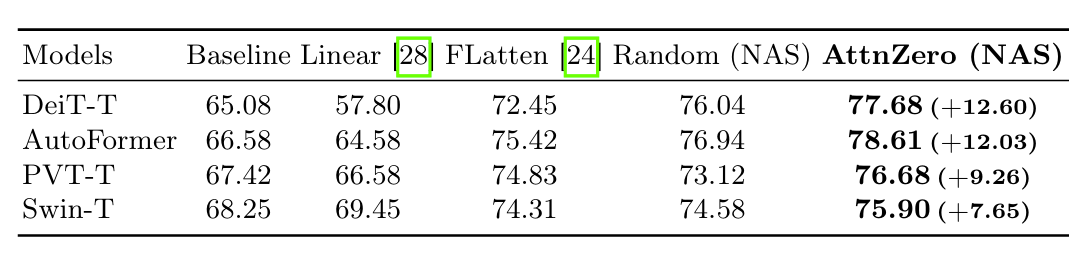

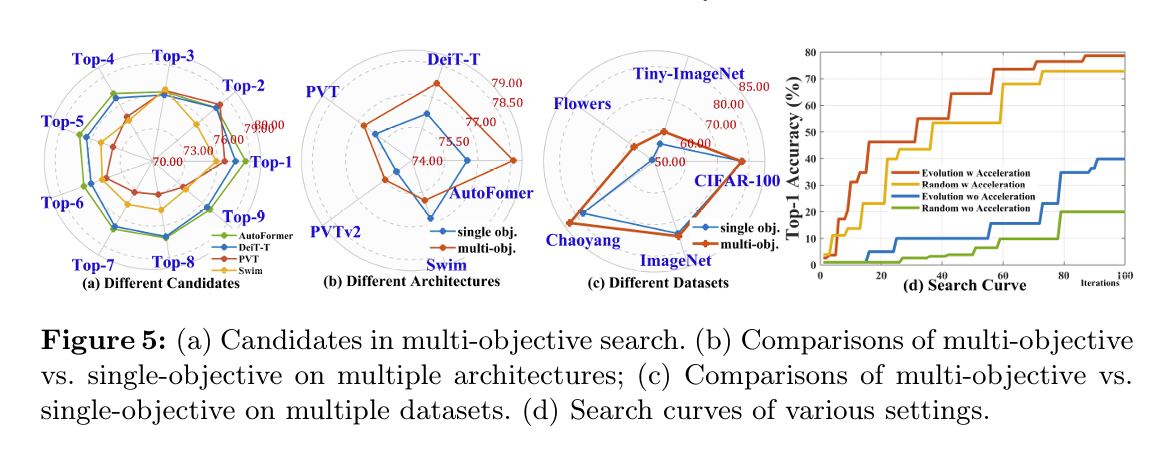

本研究提出了AttnZero,这是一个为视觉Transformer(ViT)自动发现高效注意力模块的框架。ViT中传统的自注意力机制存在二次计算复杂度的问题,而线性注意力提供了一种更高效的替代方案,其逼近具有线性复杂度。然而,现有手工设计的线性注意力存在性能下降的问题。为了解决这些问题,本研究的AttnZero构建了搜索空间,并采用进化算法来发现潜在的线性注意力公式。具体而言,本研究的搜索空间由六种计算图和高级激活、归一化和二元运算符组成。为了增强通用性,本研究将候选注意力应用于多个高级ViT的结果作为进化搜索的多目标。为了加快搜索过程,本研究利用程序检查和拒绝协议来快速过滤掉没有希望的候选注意力。此外,本研究还开发了Attn-Bench-101,它提供了搜索空间中2000个注意力的预计算性能,使本研究能够总结注意力设计见解。实验结果表明,发现的AttnZero模块可以很好地泛化到不同的任务,并在各种ViT中始终如一地提高性能。例如,在ImageNet上使用AttnZero训练的DeiT|PVT|Swin|CSwin的微型模型达到了74.9%|78.1%|82.1%|82.9%的top-1准确率。

引言

AttnZero:自动发现高效视觉Transformer注意力模块

本研究旨在提出AttnZero,这是一个自动发现为视觉Transformer(ViT)量身定制的高效注意力模块的框架。ViT中的传统自注意力机制面临计算复杂度呈平方级增长的挑战,而线性注意力则提供了一种更高效的替代方案,其复杂度呈线性近似。然而,现有的手工设计的线性注意力方法存在性能下降的问题。为了解决这些问题,本研究构建了搜索空间,并采用进化算法来发现潜在的线性注意力公式。

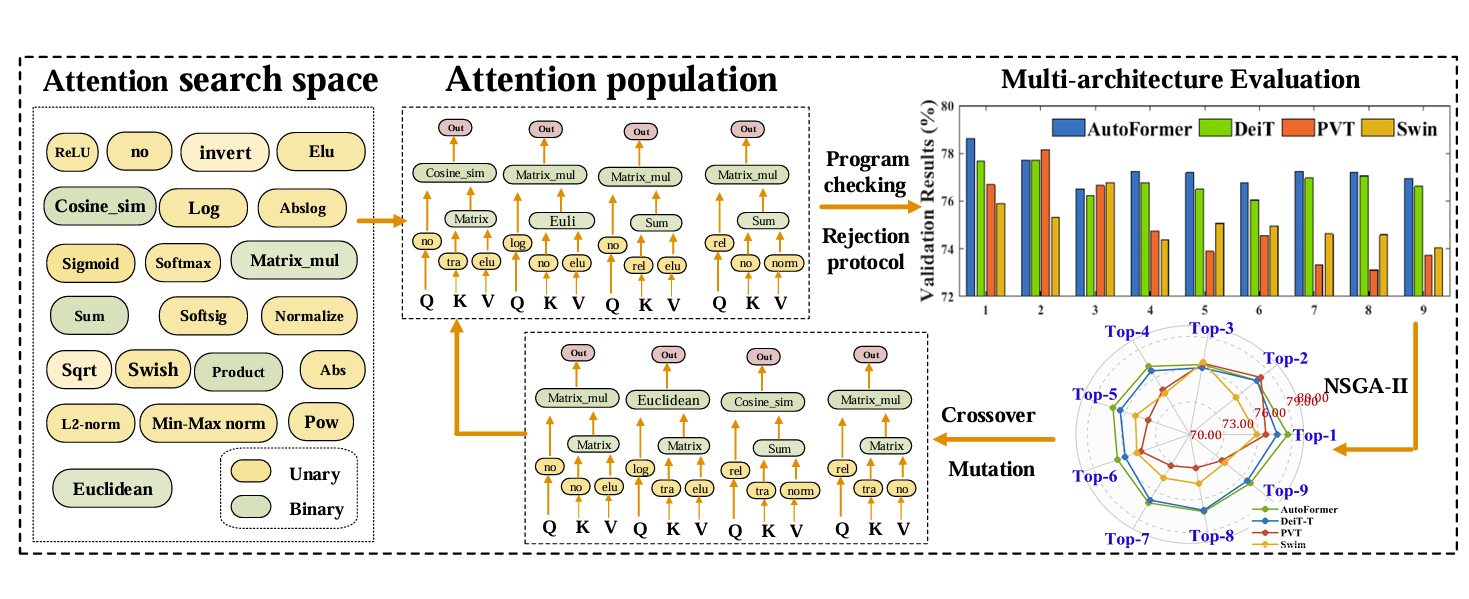

本研究的搜索空间由六种计算图以及高级激活函数、归一化方法和二元运算符组成。为了增强通用性,本研究将候选注意力应用于多个高级ViT的结果作为进化搜索的多目标。为了加快搜索过程,本研究利用程序检查和拒绝协议来快速过滤掉没有希望的候选注意力。此外,本研究还开发了Attn-Bench-101,它提供了搜索空间中2000个注意力的预计算性能,使本研究能够总结注意力设计的见解。

研究背景

本研究的背景是ViT在各种视觉任务中取得了显著成功,但自注意力机制的平方级计算复杂度限制了其处理大型图像输入的可扩展性。为了解决这个问题,研究人员一直在探索使用线性注意力作为一种计算效率更高的替代方案。然而,现有的线性注意力方法存在一些局限性:线性注意力通常会导致性能下降,并且手工设计的线性注意力通常特定于某些任务或架构,缺乏通用性。

研究现状

本研究的现状是,一些大型语言模型在Transformer中采用了新的运算符来提高性能。这启发了本研究组装一系列高级运算符来增强线性注意力,并探索它们的最佳组合公式。然而,如何有效地解决这个组合问题仍然是一个挑战。现有的神经架构搜索(NAS)方法并不适合解决本研究中的公式发现问题,因为搜索空间、搜索算法和搜索目标都不同。

研究难点

本研究面临的困难是如何在爆炸式增长的搜索空间中高效地搜索到最佳的线性注意力公式,以及如何确保发现的注意力机制能够泛化到不同的ViT模型和任务中。

研究方案

为了克服这些困难,本研究提出了AttnZero框架,该框架结合了全面的注意力搜索空间和多目标进化搜索。本研究还采用了程序检查和拒绝协议等策略来加速搜索过程。通过这些努力,本研究旨在发现能够在各种ViT模型和任务中实现更好的精度-效率平衡的优越线性注意力公式。

论文创新点

AttnZero:自动发现高效视觉Transformer注意力模块

本研究提出了AttnZero,这是一个自动发现为视觉Transformer(ViT)量身定制的高效注意力模块的框架。🔎 其创新点主要体现在以下几个方面:

-

🌟 首创高效注意力发现任务: 🌟

- 不同于传统的神经架构搜索(NAS)方法关注网络结构和参数,AttnZero着眼于发现能够泛化到各种ViT模型和任务的高效注意力机制。

- 这需要全新的搜索空间和策略,因为注意力搜索空间包含许多非参数化算子和不同的组合类型。

-

🌌 构建全面的注意力搜索空间: 🌌

- 该搜索空间包含六种计算图以及一系列高级算子,如激活函数(例如ReLU、Swish、ELU),归一化技术(例如l2_norm、min_max_norm)以及矩阵运算函数(例如cosine_similarity、euclidean_distance)。

- 这种设计带来了灵活且高效的注意力候选方案,并在性能和计算复杂度之间取得平衡。

-

🧬 采用多目标进化搜索算法: 🧬

- 为找到适用于不同ViT模型的注意力公式,采用NSGA-II进化方法进行多目标优化。

- 通过多架构评估验证候选注意力在多个ViT模型中的性能,并利用交叉和变异操作生成更优的种群。

-

🚀 引入加速策略: 🚀

- 程序检查:验证候选注意力模块的有效性,过滤掉存在错误的方案。

- 拒绝协议:剔除训练崩溃或性能远低于基线的候选方案。

- 这些策略将搜索效率提高了至少5倍。

-

🏆 AttnZero的优异性能和泛化能力: 🏆

- AttnZero包含ELU激活函数、min-max归一化和l2归一化等操作,在保持O(N)计算复杂度的同时,有效提升了注意力机制的性能。

- 通过Attn-Bench-101基准测试,进一步总结了注意力设计的指导原则,优先选择i3n302和i3n303类型的注意力以及高级归一化和激活操作的组合。

论文实验

AttnZero让ViT模型高效涨点

AttnZero让ViT模型高效涨点

455

455

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?