1.扩缩容

hadoop节点下线nodemanager

Step-by-step guide

下线Nodemanager:

在yarn-site.xml中配置以下配置:

<property>

<name>yarn.resourcemanager.nodes.exclude-path</name>

<value>/etc/hadoop/conf/mapred.exclude</value>

<final>true</final>

</property>

以后有节点下线只需要编辑mapred.exclude文件,每个节点一行

以yarn 用户执行yarn rmadmin -refreshQueues 则会把exclude的节点标记为下线

2.资源队列调整

1.案例

yz-4m1-01集群上的队列分为生产型和非生产型。在2017年4月12日凌晨0点--早上9点,非生产型队列占用资大数据培训源较多,导致集群压力过大,影响了当日早上9点的dwa下发。生产侧提出了队列资源的优化方案,如下:

| Queue | Absolute Capacity | Configured Max Capacity |

| ds | 2 | 3 |

| ec | 5 | 7 |

| db_ser | 3 | 2 |

| hc | 80 | 1.23 |

| default | 2 | 7 |

| zy_scp | 5 | 4 |

| Am1c | 3 | 4 |

2.备份当前队列的配置文件

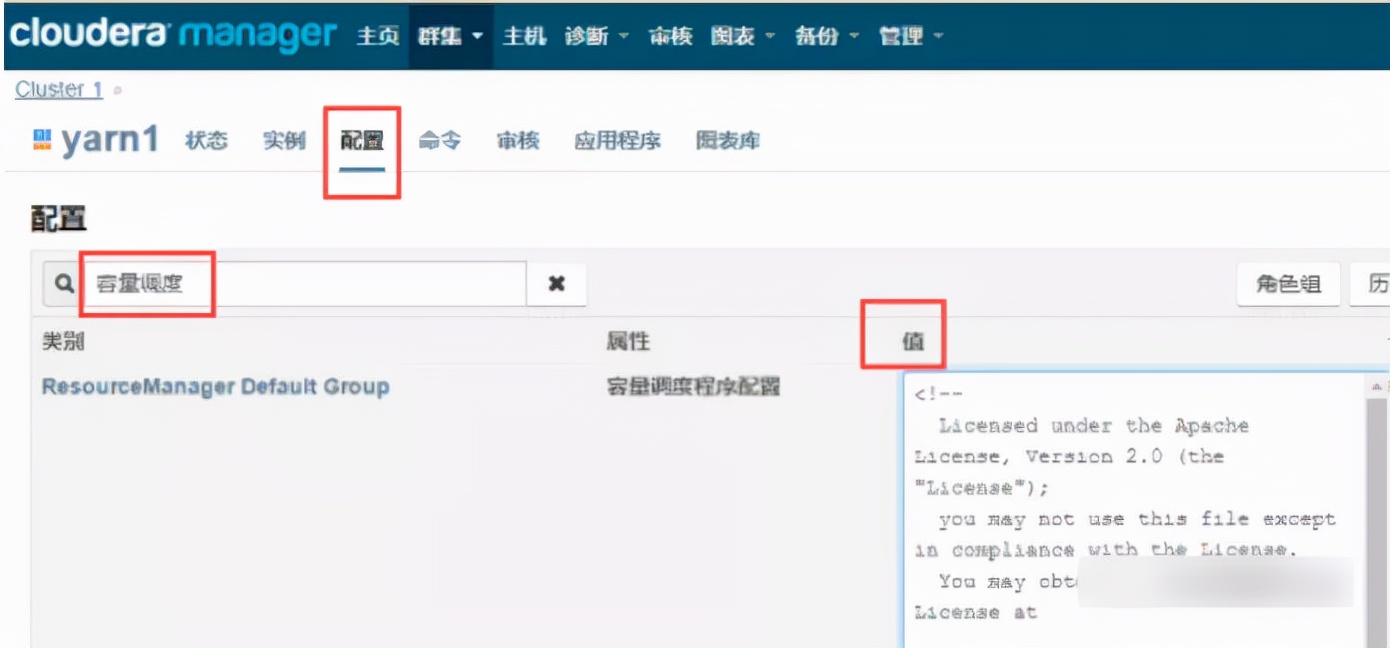

在CM首页点击yarn

在yarn的【配置】页面,搜索“容量调度”,调出右侧的【值】

将【值】中的数据全部复制出来备份到本地。建议粘贴到写字板上,粘贴到txt里排版会出现混乱。

3.修改当前队列的配置信息

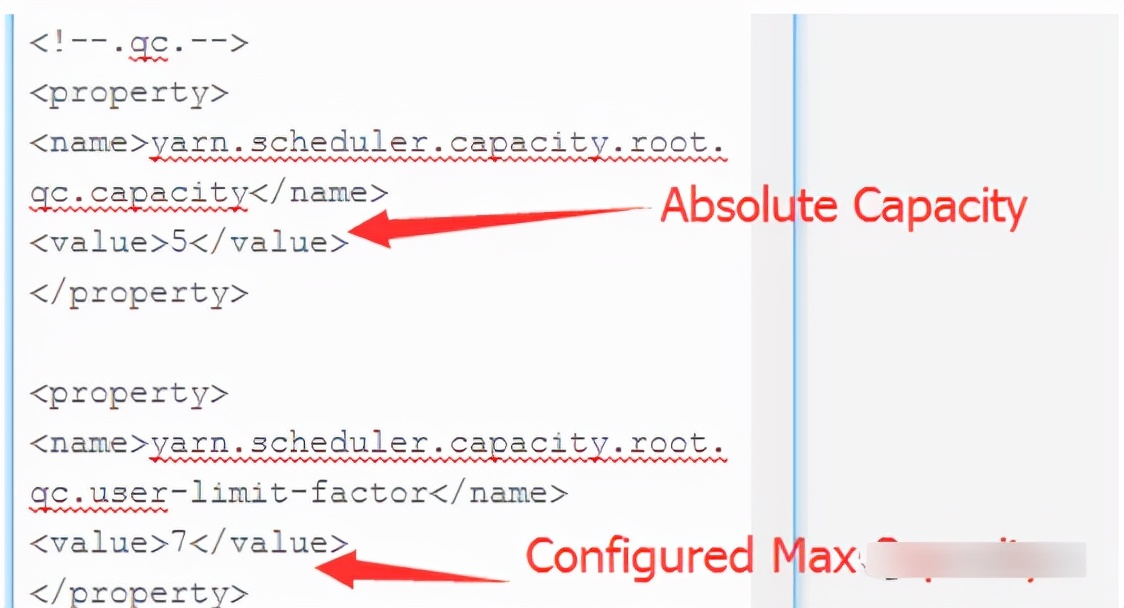

以qc队列为例:

4.保存更改

5.刷新动态资源池

在CM首页,点击集群右边的倒三角,再点击【刷新动态资源池】

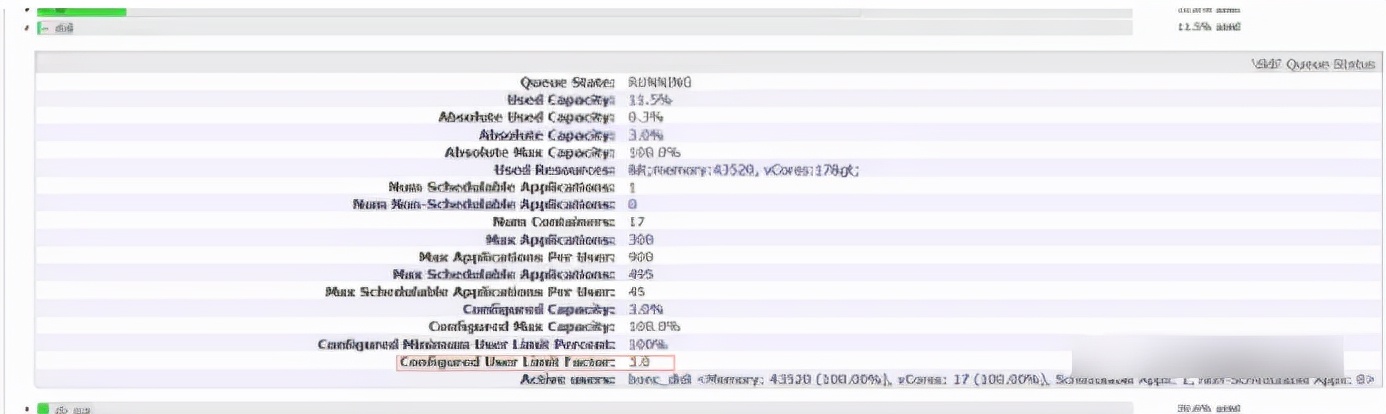

6.核实已经修改成功

在Applications页面的Scheduler,调出qc队列的信息。

3.无CM修改队列资源

1.需求:

固网集群xx队列lf_zl资源38%*1.8拆分

原队列 lf_zl 改为 25%*2 ----租户使用

其余资源新增队列lf_ja 13%*1.8 -----预计后续部署租户使用

2.修改capacity-scheduler.xml

cd/opt/beh/core/hadoop/etc/hadoop/ #进入配置文件所在目录

cpcapacity-scheduler.xmlcapacity-scheduler.xml_20170616 #备份配置文件

vi capacity-scheduler.xml #修改配置文件

修改yarn.scheduler.capacity.root.queues的值,在value里添加lf_ja

修改原lf_zl的值:

把yarn.scheduler.capacity.root.lf_zl.capacity的值从38改为25

把yarn.scheduler.capacity.root.lf_zl.user-limit-facto的值从1.8改为2

在配置文件中新增队列配置文件,如下:

<property>

<name>yarn.scheduler.capacity.root.lf_ja.capacity</name>

<value>13</value>

<description>default queue target capacity.</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.lf_ja.user-limit-factor</name>

<value>1.8</value>

<description>

default queue user limit a percentage from 0.0 to 1.0.

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.lf_ja.maximum-capacity</name>

<value>100</value>

<description>

The maximum capacity of the default queue.

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.lf_ja.state</name>

<value>RUNNING</value>

<description>

The state of the default queue. State can be one of RUNNING or STOPPED.

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.lf_ja.acl_submit_applications</name>

<value>lf_ja_pro</value>

<description>

The ACL of who can submit jobs to the default queue.

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.lf_ja.acl_administer_queue</name>

<value>lf_ja_pro</value>

<description>

The ACL of who can administer jobs on the default queue.

</description>

</property>

3.把更改后的配置文件拷贝到stanby节点

cp/opt/beh/core/hadoop/etc/hadoop/capacity-scheduler.xml /opt/beh/core/hadoop/etc/hadoop/capacity-scheduler.xml_20170616#登录stanby节点备份原配置文件

scp/opt/beh/core/hadoop/etc/hadoop/capacity-scheduler.xml hadoop@10.162.3.71:/opt/beh/core/hadoop/etc/hadoop/capacity-scheduler.xml #把修改后的配置文件拷贝到备节点主机上

4.登录主节点动态刷新资源池

yarn rmadmin -refreshQueues#刷新动态资源池

5.登录yarn界面检查更改结果是否正确,如图:

4.修改用户yarn资源分配

hadoop修改用户yarn队列分配倍数

1.以管理员用户登录所要更改的CM,进入后点击yarn,如图:

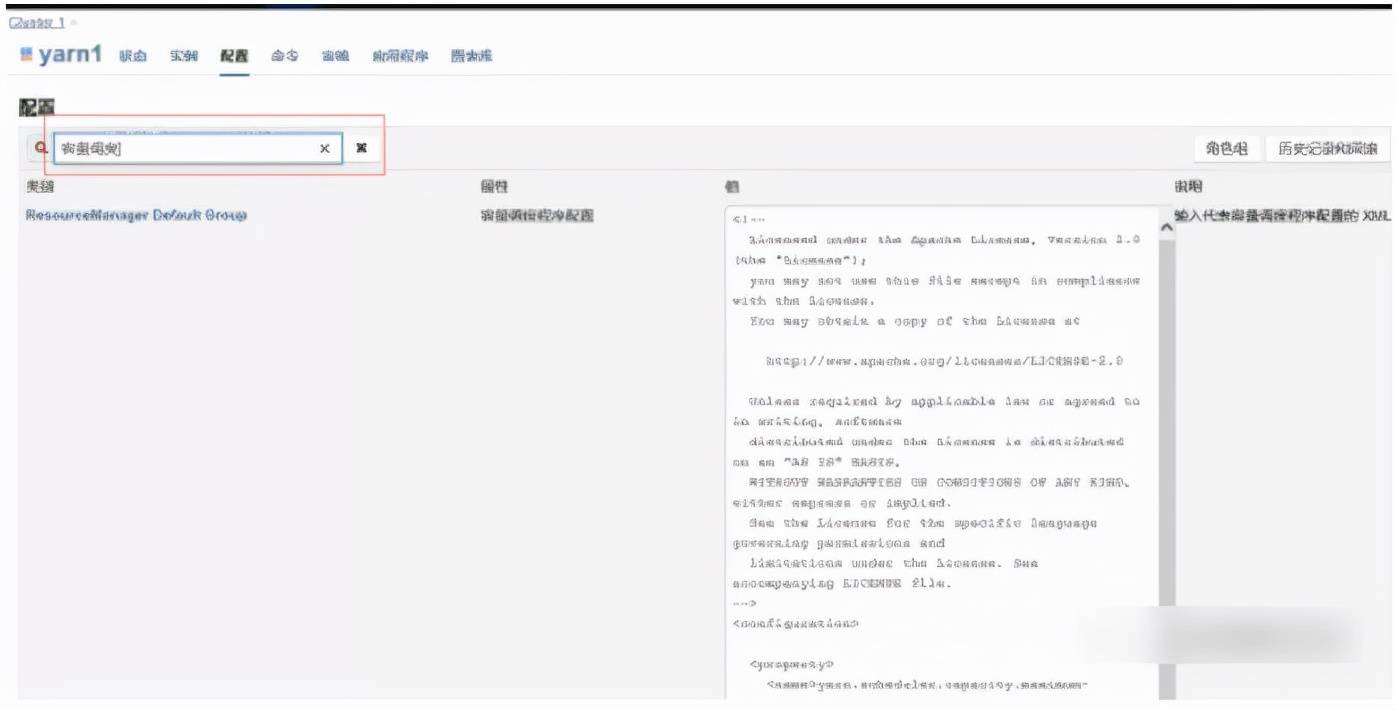

2.在yarn界面点击配置按钮,并在弹出的查找框中输入“容量调度”,查找如图:

3.把出现的值粘贴到文本留作备份(建议粘贴到写字板上,粘贴到txt里排版会出现混乱)切记一定要备份!!!

4.修改所需修改的值(一般限制用户队列,建议修改分配的倍数即Configured User Limit Factor这个值。修改Absolute Capacity需要对整体集群进行计算,所以用户加一起的达到百分百,建议不做修改)

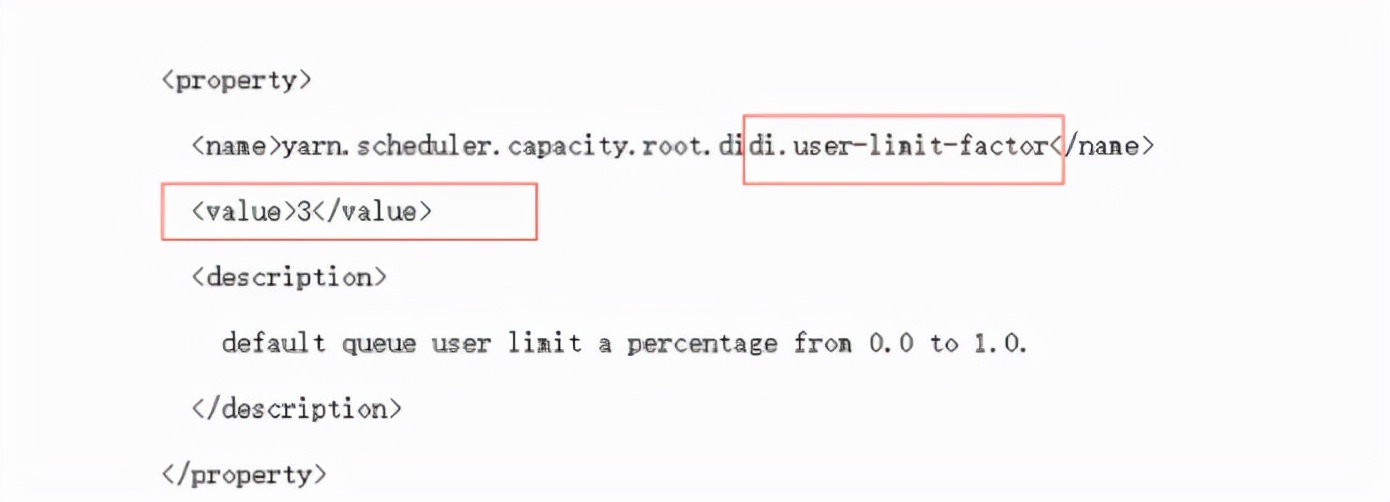

5.列:如修改didi用户的Configured User Limit Factor值。

(1)登录yarn,点击Scheduler,点击didi用户的倒三角图标:

我们可以看出didi用户的Configured User Limit Factor值为3,即他可以使用超出他分配百分比的三倍。

(2)修改拷贝中的文本,查找didi配置文件那列:

(3)找到所需修改的值Configured User Limit Factor。将倍数修改成需要调整后的值。

(3)把配置文件拷贝回CM-yarn-配置-容量调度的那个文本框里,点击保存。

(4)回到CM主页,点击集群右边的倒三角,点击刷新动态资源池。

(5)配置完毕,到yarn上查看修改是否成功。

133

133

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?