一、简介

注意力机制是人类视觉系统中的重要部分,人在识别物体时会自动的将注意力集中在所要识别的物体上。笔者个人认为这种注意力机制可以帮助人在识别物体时减少背景信息带来的影响,从而使人的识别能力更不易受其他干扰的影响,因此如果能使卷积神经网络也具有这种能力,就能在提高模型的识别能力的同时提高模型的鲁棒性。在本文中,作者通过同时利用特征图的通道信息及空间信息设计了一种具有注意力能力的卷积模块,使模型能够把“注意力”放在更有用的信息上,此外该模块可以应用各种卷积神经网络架构中,能够对各种计算机视觉任务带来一定的提升。

二、网络设计

1、注意力卷积模块

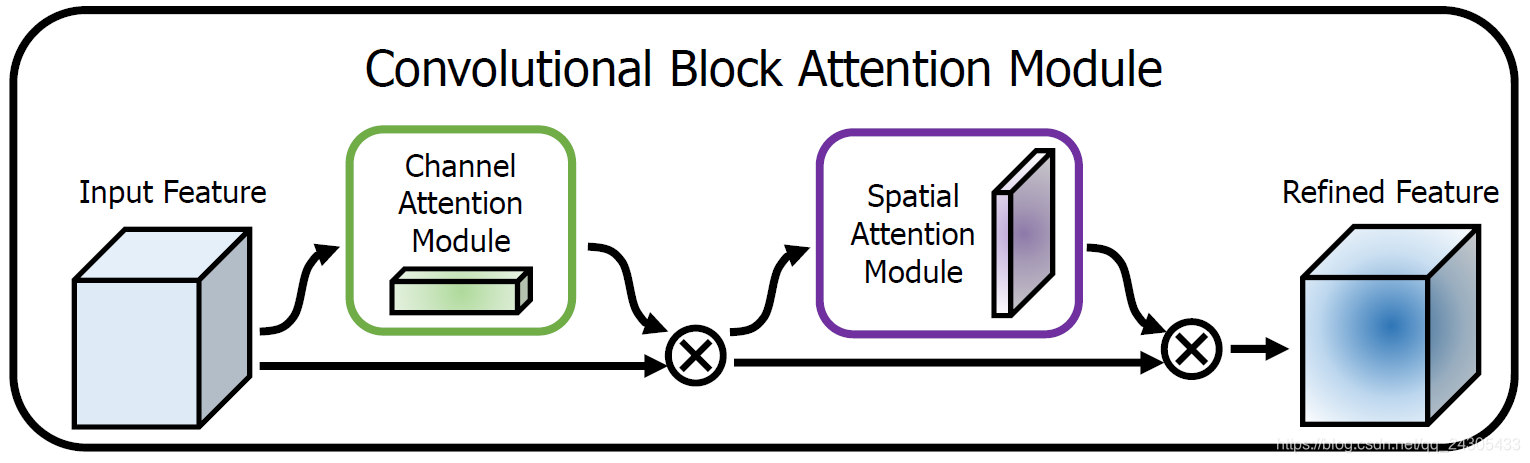

文中提出的注意力模块主要包含两部分,第一部分为通道注意力图![]() ,它能够对通道进行选择,另一部分为空间注意力图

,它能够对通道进行选择,另一部分为空间注意力图![]() ,它能够选取图像空间中所需注意的区域,对于给定的特征图,经过

,它能够选取图像空间中所需注意的区域,对于给定的特征图,经过![]() 经过卷积注意力模块后的输出如式1所示:

经过卷积注意力模块后的输出如式1所示:

2、通道注意模块

在卷积神经网络中,通道信息一般代表着图像不同的特征信息,因此通过对通道进行选择可以使网络更能注意到图像中对任务有用的信息。为实现对通道的选择,本文利用式2,分别计算每张特征图的全局平均池化及全局最大池化信息,然后通过全连接层后相加来得到通道注意力参数,其中两者共用相同的全连接网络。如图2

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

610

610

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?