摘要

基于人类反馈的强化学习 (RLHF) 可以有效地将大型语言模型 (LLM) 与人类偏好保持一致,但收集高质量的人类偏好标签是一个关键瓶颈。我们对 RLHF 与来自 AI 反馈 (RLAIF) 的 RL 进行了正面的比较,RLAIF是一种由现有的LLM代替人类来标记偏好的技术,我们发现它们会带来类似的改进。在摘要任务中,约 70% 的情况下,人类评估者更喜欢使用 RLAIF 和 RLHF 生成,而不是基线的有监督微调模型。此外,当被要求对 RLAIF 与 RLHF 总结进行评分时,人们对两者的偏好程度相同。这些结果表明,RLAIF 可以产生人类水平的性能,为 RLHF 的可扩展性限制提供潜在的解决方案。

1.Introduction

人类反馈强化学习 (RLHF) 是一种根据人类偏好对齐语言模型的有效技术,被认为是 ChatGPT 和 Bard 等目前对话语言模型成功的关键驱动因素之一。通过强化学习(RL)训练,语言模型可以针对复杂的序列级目标进行优化,而传统的有监督微调很难区分这些目标。

对高质量人类标签的需求是扩大 RLHF 规模的一个障碍,一个自然的问题是AI生成的标签是否可以达到可比的结果。几项研究表明,大型语言模型 (LLM) 与人类判断表现出高度一致,甚至在某些任务上表现优于人类。Bai et al. (2022b) 是第一个探索使用 AI 偏好来训练用于 RL 微调的奖赏模型的工作,这种技术称为“AI反馈强化学习”(RLAIF)。虽然他们表明,利用人类和人工智能偏好的混合结合“Constitutional AI”自我修正技术优于有监督微调基线,但他们的工作并没有直接比较人类与人工智能反馈的效果,因此没有回答 RLAIF 是否可以 是 RLHF 的合适替代品。

在这项工作中,我们在摘要任务上直接比较 RLAIF 和 RLHF。给定一个文本和两个候选答案,我们使用现成的LLM分配一个偏好标签。然后,我们根据 LLM 偏好和对比损失训练奖赏模型 (RM)。最后,我们通过强化学习微调策略模型,其中使用 RM 提供奖赏。

我们的结果表明,通过两种方式的比较,RLAIF 达到了与 RLHF 相当的性能。首先,我们观察到 RLAIF 和 RLHF 策略分别在 71% 和 73% 的样例中比有监督微调 (SFT) 基线更受人类青睐,并且两种获胜率在统计上没有显着差异。其次,当被要求直接比较 RLAIF 和 RLHF 的生成时,人们对两者都具有较高偏好(即 50% 的胜率)。这些结果表明,RLAIF 是 RLHF 的可行替代方案,它不依赖于人工标注,并提供有吸引力的缩放特性。

此外,我们还研究如何最大限度地使人工智能生成的偏好与人类偏好保持一致的技术。我们发现,通过详细的指令来提示我们的LLM并采用思维链推理可以提高一致性。令人惊讶的是,我们观察到,few-shot上下文学习和自洽性(我们对多个思维链进行采样并平均最终偏好的过程)都没有提高准确性,甚至降低了准确性。最后,我们进行缩放实验,以量化 LLM 标注器的大小和训练中使用的偏好示例数量与与人类偏好一致之间的权衡。

我们的主要贡献如下所示:

- 我们证明 RLAIF 在摘要任务上取得了与 RLHF 相当的性能。

- 我们比较各种使用 AI 生成标签的技术,并为 RLAIF 从业者确定最佳设置。

2.Preliminaries

我们首先回顾 Stiennon et al. (2020); Ouyang et al. (2022) 引入的 RLHF 管道,其由 3 个阶段组成:有监督微调、奖赏模型训练和基于强化学习的微调。

2.1 Supervised Fine-tuning

预训练的 LLM 使用token级监督在高质量有标注数据集上针对下游任务进行微调,以生成有监督微调 (SFT) 模型 π S F T π^{SFT} πSFT。

2.2 Reward Modeling

给定一个输入

x

x

x,我们从一个或多个模型采样一个响应对

(

y

1

,

y

2

)

∼

π

(y_1,y_2)∼π

(y1,y2)∼π,其中通常使用 SFT 模型。输入和响应被发送给标注人员,以根据某些标准评价哪个响应更好。这些注释形成三元组

D

=

{

(

x

,

y

w

,

y

l

)

}

\mathcal D=\{(x, y_w, y_l)\}

D={(x,yw,yl)}的数据集,其中

y

w

y_w

yw和

y

l

y_l

yl分别是首选和非首选响应。奖赏模型

r

ϕ

r_{\phi}

rϕ 通过最小化以下损失来训练:

L

r

(

ϕ

)

=

−

E

(

x

,

y

w

,

y

l

)

∼

D

[

l

o

g

σ

(

r

ϕ

(

x

,

y

w

)

−

r

ϕ

(

x

,

y

l

)

)

]

\mathcal L_r(\phi)=-\mathop{\mathbb E}\limits_{(x,y_w,y_l)\sim \mathcal D}[log~\sigma(r_{\phi}(x,y_w)-r_{\phi}(x,y_l))]

Lr(ϕ)=−(x,yw,yl)∼DE[log σ(rϕ(x,yw)−rϕ(x,yl))]

其中

σ

\sigma

σ是sigmoid函数。

2.3 Reinforcement Learning

策略

π

θ

R

L

π^{RL}_θ

πθRL 从 SFT 模型权重初始化,然后通过强化学习进行优化,以最大化

R

M

RM

RM 给出的奖赏,RM 充当人类偏好的代理。可选地将 Kullback-Leibler (KL) 散度损失

D

K

L

\mathbb D_{KL}

DKL 添加到目标中,以惩罚

π

θ

R

L

π^{RL}_θ

πθRL 偏离原始 SFT 策略

π

S

F

T

π^{SFT}

πSFT,由超参数

β

β

β控制 - 一种类似于自然策略梯度的技术。KL 损失有助于防止

π

θ

R

L

π^{RL}_θ

πθRL 漂移到生成由 RM 高度奖赏的语言但包含低质量或不自然语言的区域 - 这种现象称为“奖赏攻击”。完整的优化目标由以下等式描述:

m

a

x

θ

E

[

r

ϕ

(

y

∣

x

)

]

−

β

D

K

L

(

π

θ

R

L

(

y

∣

x

)

∣

∣

π

S

F

T

(

y

∣

x

)

)

\mathop{max}\limits_{\theta}\mathbb E[r_{\phi}(y|x)]-\beta\mathbb D_{KL}(\pi^{RL}_{\theta}(y|x)||\pi^{SFT}(y|x))

θmaxE[rϕ(y∣x)]−βDKL(πθRL(y∣x)∣∣πSFT(y∣x))

3.RLAIF Methodology

在本节中,我们将描述使用LLM生成偏好标签的技术,以及我们是如何进行强化学习训练以及评估指标。

3.1 Preference Labeling with LLMs

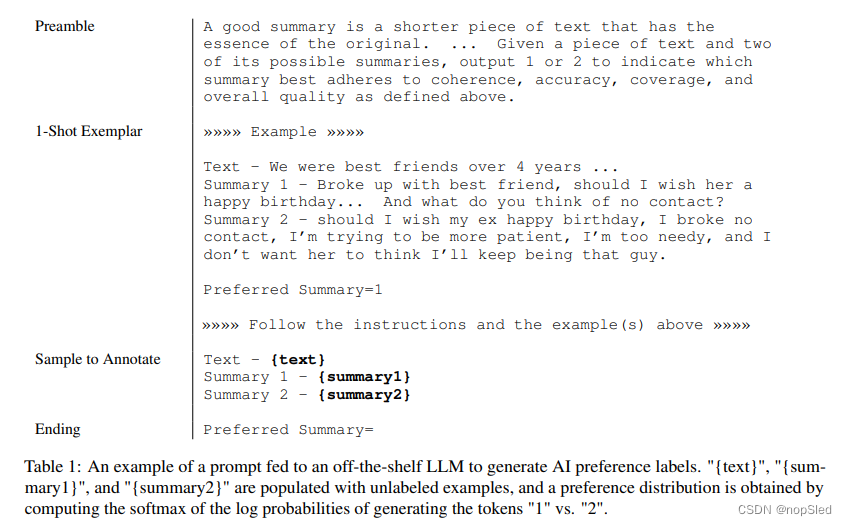

我们用“现有的”LLM来标注一对候选响应之间的偏好,这是一个针对通用领域进行了预训练或指令微调的模型,但未针对特定下游任务进行微调。给定一段文本和两个候选摘要,LLM被要求评价哪个摘要更好。LLM 的输入结构如下(表 1 中的示例):

- Preamble。对目前任务的介绍和指令进行描述。

- Few-shot exemplars (optional)。一个文本示例、一对摘要、一条思维链推理(如果适用)和一个偏好判断。

- Sample to annotate。待标注的一个文本和摘要对。

- Ending。一个结束字符串以提示LLM(e.g. “Preferred Summary=”)。

在给 LLM 提供输入后,我们获得生成token “1”和“2”的对数概率,并计算 softmax 以获得偏好分布。

从 LLM 获取偏好标签的方法有很多,例如从模型中解码格式无关的响应,并以启发式方式获取偏好( (e.g. output = “The first summary is better”),或者将偏好分布表示为one-hot表示。然而,我们并没有对这两种可选的方式进行实验,因为我们的方法已经具备高准确率。

我们试验了两种类型的Preamble:“Base”,它简单地询问“哪个摘要更好?”,以及“OpenAI”,它非常详细地模仿用于生成OpenAI TL;DR偏好数据集的人类偏好标注员的评估指令,并包含有关构成强有力摘要的详细信息。完整的前言请参见附录表 6。我们还通过在提示中添加few-shot来尝试进行上下文学习,其中手动选择样本来涵盖不同的主题。

3.1.1 Addressing Position Bias

展示给LLM的候选响应的顺序可能会导致候选偏好选择的偏差。我们发现证据表明存在这种位置偏差,尤其是对于较小尺寸的 LLM 标注器(参见附录 A)。

为了减轻偏好标签中的位置偏差,我们对每对候选响应进行两次推理,其中提交给LLM的候选响应的顺序与第二次推理相反。然后对两个推理的结果进行平均以获得最终的偏好分布。

3.1.2 Chain-of-thought Reasoning

我们尝试从AI标注器中引出思维链 (COT) 推理,以提高与人类偏好的一致性。我们将标准提示的结尾(i.e. “Preferred Summary=”) 替换为 “Consider the coherence, accuracy, coverage, and overall quality of each summary and explain which one is better. Rationale:”,然后解码LLM的响应。最后,我们将原始提示、响应和原始结尾字符串“Preferred Summary=”连接在一起,并按照第 3.1 节中的评分过程来获得偏好分布。有关说明,请参见图 3。

在zero-shot提示中,LLM 没有给出推理应该是什么样子的示例,而在few-shot提示中,我们提供了模型要遵循的 COT 推理示例。示例请参见表 7 和表 8。

3.1.3 Self-Consistency

对于思维链提示,我们还尝试了自洽推理,这是一种通过对多个推理路径进行采样并聚合每个路径末尾产生的最终答案来改进思维链推理的技术。使用非零的解码温度对多个思想链基本原理进行采样,然后按照第 3.1.2 节中的方法获得每个思想链的 LLM 偏好分布。然后对结果进行平均以获得最终的偏好分布。

3.2 Reinforcement Learning from AI Feedback

在 LLM 对偏好进行标注后,将训练奖赏模型 (RM) 来预测偏好。由于我们的方法产生软标签(例如

p

r

e

f

e

r

e

n

c

e

s

i

=

[

0.6

,

0.4

]

preferences_i=[0.6, 0.4]

preferencesi=[0.6,0.4]),因此我们将交叉熵损失应用于RM生成的奖励分数的softmax,而不是第2.2节中提到的损失。softmax 将 RM 的无界分数转换为概率分布。

在 AI 标注数据集上训练 RM 可以被视为模型蒸馏的一种形式,特别是因为我们的 AI 标注器通常比 RM 更大、性能更好。另一种方法是绕过 RM 并直接使用 AI 反馈作为 RL 中的奖赏信号,尽管这种方法的计算成本更高,因为 AI 标注器比 RM 更大。

使用经过训练的 RM,我们使用适用于语言建模领域的 Advantage Actor Critic (A2C) 算法的修改版本进行强化学习训练(详细信息参见附录 B)。 虽然最近的许多工作都使用近端策略优化(PPO)——一种类似的方法,添加了一些技术来使训练更加保守和稳定(例如裁剪目标函数),但我们使用 A2C,因为它更简单,但对我们的问题仍然有效。

3.3 Evaluation

我们通过三个指标评估我们的结果 - AI 标注器对齐、成对准确率和胜利率。

AI 标注器对齐可用于衡量 AI 标注偏好相对于人类偏好的准确性。举一个例子,它的计算方法是将软AI标注的偏好转换为二进制表示(例如

p

r

e

f

e

r

e

n

c

e

s

i

=

[

0.6

,

0.4

]

→

[

1

,

0

]

preferences_i=[0.6, 0.4] → [1, 0]

preferencesi=[0.6,0.4]→[1,0]),然后如果标签与目标人类一致则分配 1 偏好,否则为 0。 可以表示为:

A

l

i

g

n

=

∑

i

=

1

D

I

[

a

r

g

m

a

x

x

p

r

a

i

i

=

a

r

g

m

a

x

x

p

r

h

i

]

∣

D

∣

Align=\frac{\sum^D_{i=1}\mathbb I[argmax_xpr_{ai_i}=argmax_xpr_{h_i}]}{|D|}

Align=∣D∣∑i=1DI[argmaxxpraii=argmaxxprhi]

其中

p

r

a

i

pr_{ai}

prai和

p

r

h

pr_{h}

prh分别是AI和人类偏好的一个二进制表示。

x

x

x是一个索引,

D

D

D是一个数据集。

成对准确率衡量经过训练的奖赏模型相对于一组人类偏好的准确性。给定共享上下文和一对候选响应,如果根据人类标签,RM 对偏好候选的评分高于非偏好候选,则成对准确率为 1。 否则该值为 0。该数量是多个示例的平均值,以衡量 RM 的总体精度。

胜利率通过衡量人们更喜欢哪一策略的频率来评估两项策略的端到端质量。给定输入和两个生成,人类标注员选择偏向哪一生成结果。策略 A 优于策略 B 的实例百分比称为“A 与 B 的胜利率”。

研究比较了基于人类反馈的RLHF和使用AI反馈的RLAIF在语言模型中的性能,结果显示RLAIF在摘要任务中达到与RLHF相当的水平,且在70%的样本中更受欢迎。AI生成的标签提供了可扩展性和效率的潜在解决方案。

研究比较了基于人类反馈的RLHF和使用AI反馈的RLAIF在语言模型中的性能,结果显示RLAIF在摘要任务中达到与RLHF相当的水平,且在70%的样本中更受欢迎。AI生成的标签提供了可扩展性和效率的潜在解决方案。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?