简单回答一下:

1、数学本质上一样,都是特征图中的元素乘以权重再求和。全连接是把特征图拆开组成一个一维向量,再乘以一个权重向量,这两个向量中的元素一一对应所以输出结果是一个值。而1*1卷积,我们知道卷积核实质上就是权重,1*1的卷积核那就是表明只由一个权重组成,如果特征图尺寸也是1*1的话,那输出就是一个值,此时与全连接完全一样。但是如果特征图尺寸不是1*1,而是w*h的话,那么1*1的卷积输出就不是一个值而是w*h的一个矩阵。以上是数学本质上的异同。

2、功能上似乎1*1卷积可以减少或增加特征图的层数,这个是全连接做不到的。

3、用1*1卷积代替全连接应该是基于输入尺寸的考虑,全连接的输入是特征图所有元素乘以权重再求和,但是这个权重向量是在设计网络的时候就需要固定的,所以全连接没办法适应输入尺寸的变化只能固定。但是1*1卷积的输出与输入尺寸是一样大的,输出尺寸可以随着输入尺寸的变化而变化,所以1*1卷积无需固定输出尺寸。通俗来说就是卷积是权值共享,所以所学参数只跟卷积核有关,跟特征图无关。至于效果嘛,如果是分类基本上没什么差别,如果是做分割,那还是卷积比较合适,具体参看FCN这篇文章吧。

作者:科研狗也有春天

链接:https://www.zhihu.com/question/274256206/answer/948189194

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

1*1的卷积核与全连接的区别

11的卷积核是输入map大小不固定的;而全连接是固定的。

11卷积的主要作用有以下两点:

1)降维( dimension reductionality ),inception中就是这个用。

2)加入非线性,毕竟有激活。

这里有个八卦是当年FCN得到CVPR’15 best paper honorable mention的时候, Yann LeCun等人出来吐槽这个’FCN’的概念早就有了,AlexNet里面的fully connected layer (FC)本身就是个误导,因为FC layer可以看成是1x1的convolution, 本来就可以输入任意大小的图片。

更多的,卷积层跟全连接层的区别

使得网络可以接受任意的输入的方法就是把全连接层变成卷积层,这就是所谓的卷积化。这里需要证明卷积化的等价性。

直观上理解,卷积跟全连接都是一个点乘的操作,区别在于卷积是作用在一个局部的区域,而全连接是对于整个输入而言,那么只要把卷积作用的区域扩大为整个输入,那就变成全连接了,我就不给出形式化定义了。所以我们只需要把卷积核变成跟输入的一个map的大小一样就可以了,这样的话就相当于使得卷积跟全连接层的参数一样多。

举个例子,比如AlexNet,fc6的输入是256x6x6,那么这时候只需要把fc6变成是卷积核为6x6的卷积层就好了。

————————————————

版权声明:本文为CSDN博主「whitenightwu」的原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/wydbyxr/article/details/84061410

1*1卷积和全连接层的区别

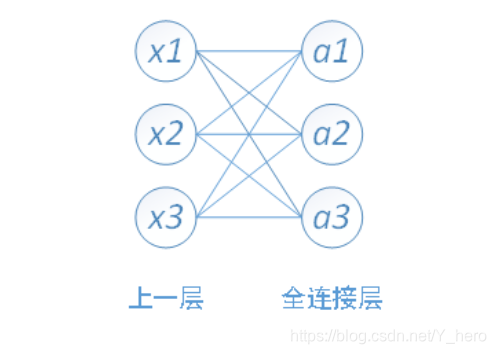

全连接层的输入是一维数组,多维数组需先进行Flatten进行一维化处理,然后连接全连接层。全连接层的每一个结点都与上一层的所有结点相连,用来把前边提取到的特征综合起来。由于其全相连的特性,一般全连接层的参数也是最多的。全连接图结构如下。

其中,x1、x2、x3为全连接层的输入,a1、a2、a3为输出,有

权值参数=输入一维数组大小*全连接层输出结点数

偏置参数b=全连接层输出结点数

eg:

输入有[5044]个神经元结点,输出有500个结点,则一共需要5044*500=400000个权值参数W和500个偏置参数b

卷积和全连接层

个人感觉,卷积跟全连接都是一个点乘的操作,区别在于卷积是作用在一个局部的区域,而全连接是对于整个输入而言,那么只要把卷积作用的区域扩大为整个输入,那就变成全连接了,我就不给出形式化定义了。所以我们只需要把卷积核变成跟输入的一个map的大小一样就可以了,这样的话就相当于使得卷积跟全连接层的参数一样多。

eg:输入是224x224x3 的图像,假设经过变换之后最后一层是[7x7x512]的,那么传统的方法应该将其展平成为一个7x7x512长度的一层,然后做全连接层,假设全连接层为4096×1000层的(假设有1000个分类结果)。 那么用1×1卷积核怎么做呢,因为1×1卷积核相当于在不同channel之间做线性变换,所以:

先选择7×7的卷积核,输出层特征层数为4096层,这样得到一个[1×1×4096]层的

然后再选择用1×1卷积核,输出层数为1000层,这样得到一个[1×1×1000]层这样就搞定了。

参考:https://blog.csdn.net/Y_hero/article/details/88296967

全连接层的作用是,可以将卷积得到的局部特征连接起来,综合考虑整个图像。

当1*1卷积层的channel个数等于全连接层的节点个数时,可以看成全连接层,其中空间维度高和宽上的每个元素相当于样本,通道相当于特征。(有点问题)

用1*1卷积层代替全连接层的好处:

1、不改变图像空间结构

全连接层会破坏图像的空间结构,而1*1卷积层不会破坏图像的空间结构。

2、输入可以是任意尺寸

全连接层的输入尺寸是固定的,因为全连接层的参数个数取决于图像大小。而卷积层的输入尺寸是任意的,因为卷积核的参数个数与图像大小无关。

————————————————

版权声明:本文为CSDN博主「纸上得来终觉浅~」的原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/qq_32172681/article/details/95971492

1*1卷积的主要作用有以下几点:

1、降维( dimension reductionality )。比如,一张500 * 500且厚度depth为100 的图片在20个filter上做1*1的卷积,那么结果的大小为500*500*20。

2、加入非线性。卷积层之后经过激励层,1*1的卷积在前一层的学习表示上添加了非线性激励( non-linear activation ),提升网络的表达能力;

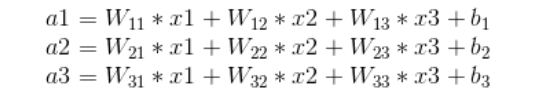

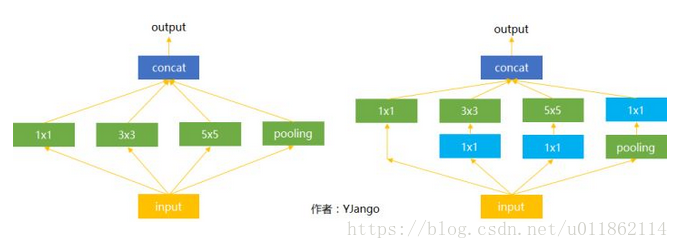

下图是Inception模块,为了消除尺寸对于识别结果的影响,一次性使用多个不同filter size来抓取多个范围不同的概念,让网络能够自己选择需要的特征。可以看到在Inception模块中,每个分支都加上一个1*1卷积的部分,这里1*1卷积的作用是让网络根据需要能够更灵活地控制数据的depth(即通道数),通过1*1卷积,可以将不同分支的feature map通道数调整到一直,便于后续操作(相加或concat)。这里的1*1卷积不止能降维,也可以升维,这完全取决与1*1卷积的通道数。

3、跨通道信息交互(channal 的变换)

如:使用1*1卷积核,实现降维和升维的操作其实就是channel间信息的线性组合变化,3*3,64channels的卷积核前面添加一个1*1,28channels的卷积核,就变成了3*3,28channels的卷积核,原来的64个channels就可以理解为跨通道线性组合变成了28channels,这就是通道间的信息交互。

参考链接:https://blog.csdn.net/u011862114/article/details/80530963?utm_source=blogxgwz2

个人总结:

1.把卷积作用的区域扩大为整个输入,那就变成全连接了,所以我们只需要把卷积核变成跟输入的一个map的大小一样就可以了,这样的话就相当于使得卷积跟全连接层的参数一样多。卷积核的个数*卷积核的大小=全连接的权重矩阵

2.1*1的卷积核表明只由一个权重组成,如果特征图尺寸也是1*1的话,那输出就是一个值,此时与全连接完全一样。但是如果特征图尺寸不是1*1,而是w*h的话,那么1*1的卷积输出就不是一个值而是w*h的一个矩阵。

用1*1卷积层代替全连接层的好处:

1、不改变图像空间结构

全连接层会破坏图像的空间结构,而1*1卷积层不会破坏图像的空间结构。

全连通就相当于每个像素点都一样对待,但是卷积是将一个区域单独对待,所以会保留图像局部特征

2、输入可以是任意尺寸

全连接层的输入尺寸是固定的,因为全连接层的参数个数取决于图像大小。而卷积层的输入尺寸是任意的,因为卷积核的参数个数与图像大小无关。

1148

1148

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?