1、使用xshell登录模板操作系统

2、执行以下命令关闭防火墙

#systemctl stop firewalld.service

#systemctl disable firewalld.service

#firewall-cmd -state

3、关闭ip6

#vi /etc/sysctl.conf

在该文件中增加如下内容

net.ipv6.conf.all.disable_ipv6 = 1

net.ipv6.conf.default.disable_ipv6 = 1

net.ipv6.conf.lo.disable_ipv6 = 1

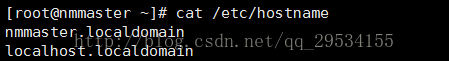

4、修改机器名(备注:此处只修改了模板机器的名字,后续需要根据集群规划重新修改每台机器的机器名)

分别在每台机器上编辑/etc/hostname文件

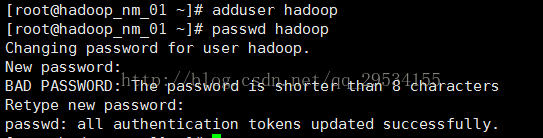

5、创建hadoop:hadoop用户和组

6、设置JAVA_HOME

#echo "export JAVA_HOME=/opt/hadoop/jdk1.8.0_121">>/etc/profile

#echo "export CLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$java_home/lib/dt.jar:$java_home/lib/tools.jar">>/etc/profile

#echo "export PATH=$PATH:$JAVA_HOME/bin">>/etc/profile

#source /etc/profile

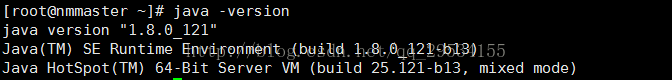

提示以下信息显示配置java成功

#echo "export HADOOP_HOME=/opt/hadoop/hadoop-2.8.1">>/etc/profile

#echo "export PATH=.:$HADOOP_HOME:$PATH">>/etc/profile

#source /etc/profile

8、修改目录权限

#chown hadoop:hadoop /opt/ -R

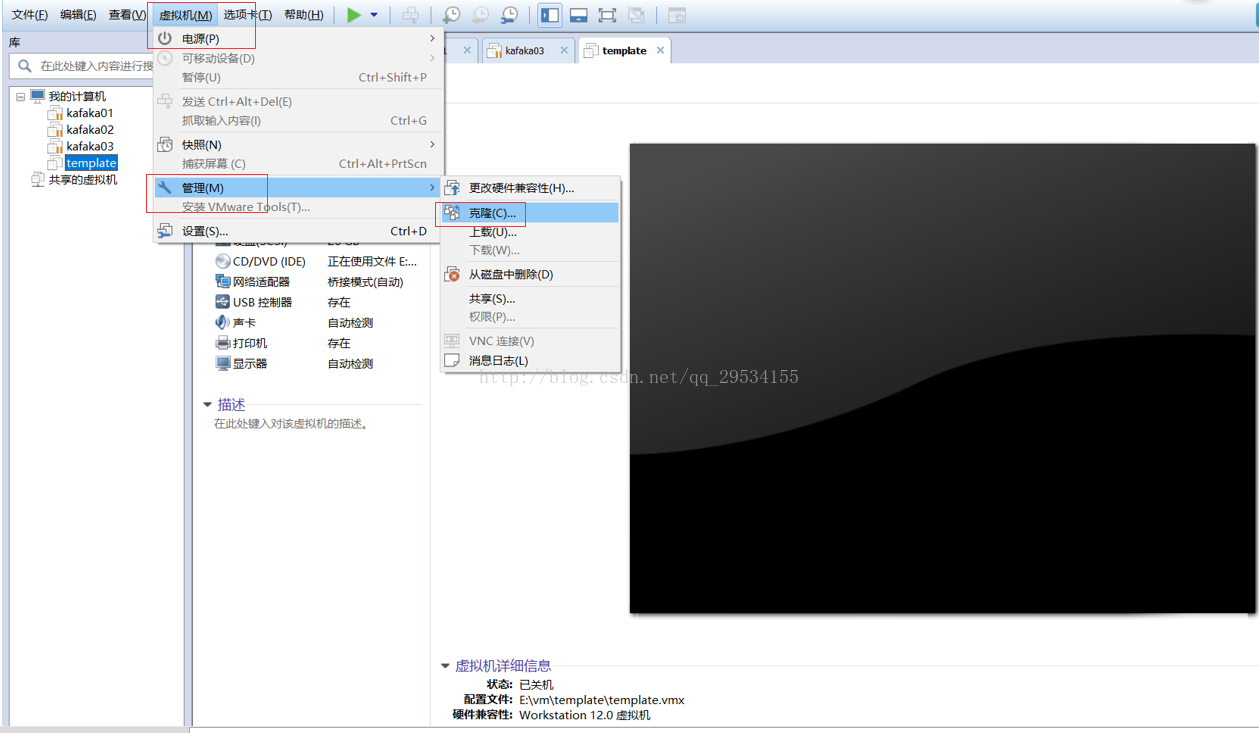

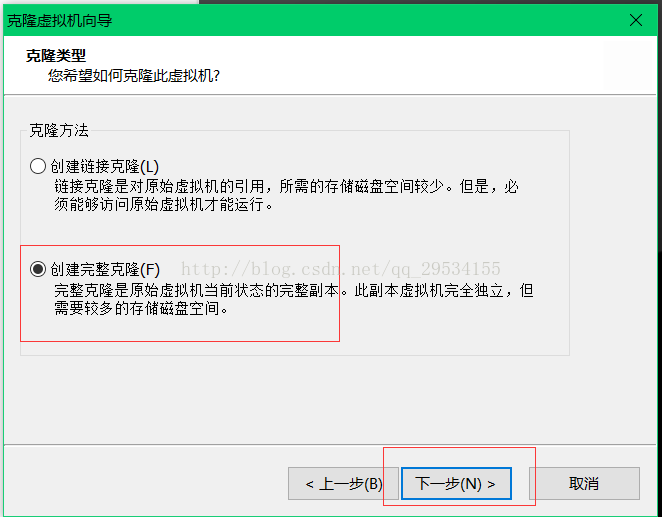

9、通过虚拟机镜像生成剩余操作系统

根据以上步骤,依次完成剩余四台机器的创建。

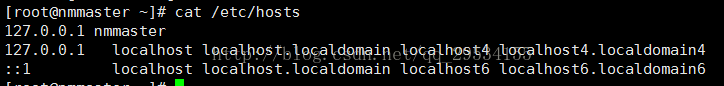

10、依次修改每台机器的主机名、IP地址,并重启服务器

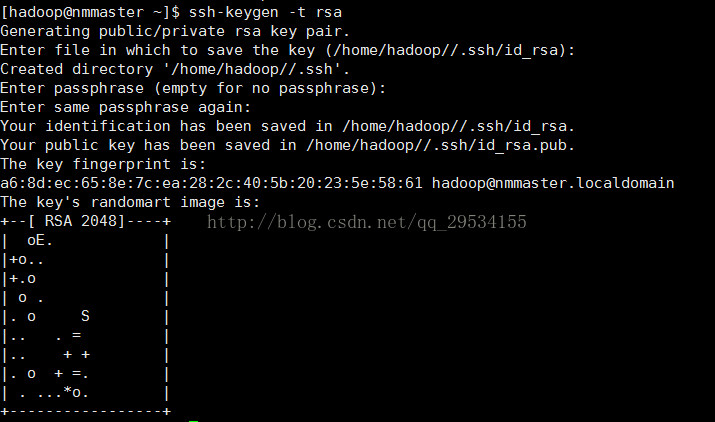

11、 配置集群间无密码SSH登陆

配置集群各个节点之间的ssh无密码互信,也就是从master开始,ssh到master(localhost)、slave01和slave02上都不需要密码,反向ssh到master。

#su - hadoop

注意登录将.ssh的权限修改成700,把authorized_keys的权限修改成644

在每台机器生成公钥,然后将每台机器的公钥写入到authorized_keys文件中。同时将authorized_keys拷贝到每台机器

当普通用户无法建立ssh信任关系时,请参考此博文进行修改

http://www.cnblogs.com/qcly/archive/2013/07/27/3219535.html

5794

5794

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?