我们深谙信息交流的价值,那网络中进程之间如何通信,如我们每天打开浏览器浏览网页时,浏览器的进程怎么与web服务器通信的?当你用QQ聊天时,QQ进程怎么与服务器或你好友所在的QQ进程通信?这些都得靠socket?那什么是socket?socket的类型有哪些?还有socket的基本函数,这些都是本文想介绍的。本文的主要内容如下:

1、网络中进程之间如何通信?

本地的进程间通信(IPC)有很多种方式,但可以总结为下面4类:

消息传递(管道、FIFO、消息队列)

同步(互斥量、条件变量、读写锁、文件和写记录锁、信号量)

共享内存(匿名的和具名的)

远程过程调用(Solaris门和Sun RPC)

但这些都不是本文的主题!我们要讨论的是网络中进程之间如何通信?首要解决的问题是如何唯一标识一个进程,否则通信无从谈起!在本地可以通过进程PID来唯一标识一个进程,但是在网络中这是行不通的。其实TCP/IP协议族已经帮我们解决了这个问题,网络层的“ip地址”可以唯一标识网络中的主机,而传输层的“协议+端口”可以唯一标识主机中的应用程序(进程)。这样利用三元组(ip地址,协议,端口)就可以标识网络的进程了,网络中的进程通信就可以利用这个标志与其它进程进行交互。

使用TCP/IP协议的应用程序通常采用应用编程接口:UNIX BSD的套接字(socket)和UNIX System V的TLI(已经被淘汰),来实现网络进程之间的通信。就目前而言,几乎所有的应用程序都是采用socket,而现在又是网络时代,网络中进程通信是无处不在,这就是我为什么说“一切皆socket”。

2、什么是Socket?

上面我们已经知道网络中的进程是通过socket来通信的,那什么是socket呢?socket起源于Unix,而Unix/Linux基本哲学之一就是“一切皆文件”,都可以用“打开open –> 读写write/read –> 关闭close”模式来操作。我的理解就是Socket就是该模式的一个实现,socket即是一种特殊的文件,一些socket函数就是对其进行的操作(读/写IO、打开、关闭),这些函数我们在后面进行介绍。

socket一词的起源

在组网领域的首次使用是在1970年2月12日发布的文献 IETF RFC33中发现的,撰写者为Stephen Carr、Steve Crocker和Vint Cerf。根据美国计算机历史博物馆的记载,Croker写道:“命名空间的元素都可称为套接字接口。一个套接字接口构成一个连接的一端,而一个连接可完全由一对套接字接口规定。”计算机历史博物馆补充道:“这比BSD的套接字接口定义早了大约12年。”

3、socket的基本操作

既然socket是“open—write/read—close”模式的一种实现,那么socket就提供了这些操作对应的函数接口。下面以TCP为例,介绍几个基本的socket接口函数。

3.1、socket()函数

int socket(int domain, int type, int protocol);

socket函数对应于普通文件的打开操作。普通文件的打开操作返回一个文件描述字,而socket()用于创建一个socket描述符(socket descriptor),它唯一标识一个socket。这个socket描述字跟文件描述字一样,后续的操作都有用到它,把它作为参数,通过它来进行一些读写操作。

正如可以给fopen的传入不同参数值,以打开不同的文件。创建socket的时候,也可以指定不同的参数创建不同的socket描述符,socket函数的三个参数分别为:

domain:即协议域,又称为协议族(family)。常用的协议族有,AF_INET、AF_INET6、AF_LOCAL(或称AF_UNIX,Unix域socket)、AF_ROUTE等等。协议族决定了socket的地址类型,在通信中必须采用对应的地址,如AF_INET决定了要用ipv4地址(32位的)与端口号(16位的)的组合、AF_UNIX决定了要用一个绝对路径名作为地址。

type:指定socket类型。常用的socket类型有,SOCK_STREAM、SOCK_DGRAM、SOCK_RAW、SOCK_PACKET、SOCK_SEQPACKET等等(socket的类型有哪些?)。

protocol:故名思意,就是指定协议。常用的协议有,IPPROTO_TCP、IPPTOTO_UDP、IPPROTO_SCTP、IPPROTO_TIPC等,它们分别对应TCP传输协议、UDP传输协议、STCP传输协议、TIPC传输协议(这个协议我将会单独开篇讨论!)。

注意:并不是上面的type和protocol可以随意组合的,如SOCK_STREAM不可以跟IPPROTO_UDP组合。当protocol为0时,会自动选择type类型对应的默认协议。

当我们调用socket创建一个socket时,返回的socket描述字它存在于协议族(address family,AF_XXX)空间中,但没有一个具体的地址。如果想要给它赋值一个地址,就必须调用bind()函数,否则就当调用connect()、listen()时系统会自动随机分配一个端口。

3.2、bind()函数

正如上面所说bind()函数把一个地址族中的特定地址赋给socket。例如对应AF_INET、AF_INET6就是把一个ipv4或ipv6地址和端口号组合赋给socket。

函数的三个参数分别为:

sockfd:即socket描述字,它是通过socket()函数创建了,唯一标识一个socket。bind()函数就是将给这个描述字绑定一个名字。

addr:一个const struct sockaddr *指针,指向要绑定给sockfd的协议地址。这个地址结构根据地址创建socket时的地址协议族的不同而不同,如ipv4对应的是:

struct sockaddr_in {

sa_family_t sin_family; /* address family: AF_INET */

in_port_t sin_port; /* port in network byte order */

struct in_addr sin_addr; /* internet address */

};

/* Internet address. */

struct in_addr {

uint32_t s_addr; /* address in network byte order */

};

ipv6对应的是:

struct sockaddr_in6 {

sa_family_t sin6_family; /* AF_INET6 */

in_port_t sin6_port; /* port number */

uint32_t sin6_flowinfo; /* IPv6 flow information */

struct in6_addr sin6_addr; /* IPv6 address */

uint32_t sin6_scope_id; /* Scope ID (new in 2.4) */

};

struct in6_addr {

unsigned char s6_addr[16]; /* IPv6 address */

};

Unix域对应的是:

#define UNIX_PATH_MAX 108

struct sockaddr_un {

sa_family_t sun_family; /* AF_UNIX */

char sun_path[UNIX_PATH_MAX]; /* pathname */

};

addrlen:对应的是地址的长度。

通常服务器在启动的时候都会绑定一个众所周知的地址(如ip地址+端口号),用于提供服务,客户就可以通过它来接连服务器;而客户端就不用指定,由系统自动分配一个端口号和自身的ip地址组合。这就是为什么通常服务器端在listen之前会调用bind(),而客户端就不会调用,而是在connect()时由系统随机生成一个。

网络字节序与主机字节序

主机字节序就是我们平常说的大端和小端模式:不同的CPU有不同的字节序类型,这些字节序是指整数在内存中保存的顺序,这个叫做主机序。引用标准的Big-Endian和Little-Endian的定义如下:

a) Little-Endian就是低位字节排放在内存的低地址端,高位字节排放在内存的高地址端。

b) Big-Endian就是高位字节排放在内存的低地址端,低位字节排放在内存的高地址端。

网络字节序:4个字节的32 bit值以下面的次序传输:首先是0~7bit,其次8~15bit,然后16~23bit,最后是24~31bit。这种传输次序称作大端字节序。由于TCP/IP首部中所有的二进制整数在网络中传输时都要求以这种次序,因此它又称作网络字节序。字节序,顾名思义字节的顺序,就是大于一个字节类型的数据在内存中的存放顺序,一个字节的数据没有顺序的问题了。

所以:在将一个地址绑定到socket的时候,请先将主机字节序转换成为网络字节序,而不要假定主机字节序跟网络字节序一样使用的是Big-Endian。由于这个问题曾引发过血案!公司项目代码中由于存在这个问题,导致了很多莫名其妙的问题,所以请谨记对主机字节序不要做任何假定,务必将其转化为网络字节序再赋给socket。

3.3、listen()、connect()函数

如果作为一个服务器,在调用socket()、bind()之后就会调用listen()来监听这个socket,如果客户端这时调用connect()发出连接请求,服务器端就会接收到这个请求。

int listen(int sockfd, int backlog);

int connect(int sockfd, const struct sockaddr *addr, socklen_t addrlen);

listen函数的第一个参数即为要监听的socket描述字,第二个参数为相应socket可以排队的最大连接个数。socket()函数创建的socket默认是一个主动类型的,listen函数将socket变为被动类型的,等待客户的连接请求。

connect函数的第一个参数即为客户端的socket描述字,第二参数为服务器的socket地址,第三个参数为socket地址的长度。客户端通过调用connect函数来建立与TCP服务器的连接。

3.4、accept()函数

TCP服务器端依次调用socket()、bind()、listen()之后,就会监听指定的socket地址了。TCP客户端依次调用socket()、connect()之后就想TCP服务器发送了一个连接请求。TCP服务器监听到这个请求之后,就会调用accept()函数取接收请求,这样连接就建立好了。之后就可以开始网络I/O操作了,即类同于普通文件的读写I/O操作。

int accept(int sockfd, struct sockaddr *addr, socklen_t *addrlen);

accept函数的第一个参数为服务器的socket描述字,第二个参数为指向struct sockaddr *的指针,用于返回客户端的协议地址,第三个参数为协议地址的长度。如果accpet成功,那么其返回值是由内核自动生成的一个全新的描述字,代表与返回客户的TCP连接。

注意:accept的第一个参数为服务器的socket描述字,是服务器开始调用socket()函数生成的,称为监听socket描述字;而accept函数返回的是已连接的socket描述字。一个服务器通常通常仅仅只创建一个监听socket描述字,它在该服务器的生命周期内一直存在。内核为每个由服务器进程接受的客户连接创建了一个已连接socket描述字,当服务器完成了对某个客户的服务,相应的已连接socket描述字就被关闭。

3.5、read()、write()等函数

万事具备只欠东风,至此服务器与客户已经建立好连接了。可以调用网络I/O进行读写操作了,即实现了网咯中不同进程之间的通信!网络I/O操作有下面几组:

read()/write()

recv()/send()

readv()/writev()

recvmsg()/sendmsg()

recvfrom()/sendto()

我推荐使用recvmsg()/sendmsg()函数,这两个函数是最通用的I/O函数,实际上可以把上面的其它函数都替换成这两个函数。它们的声明如下:

#include <unistd.h>

ssize_t read(int fd, void *buf, size_t count);

ssize_t write(int fd, const void *buf, size_t count);

#include <sys/types.h>

#include <sys/socket.h>

ssize_t send(int sockfd, const void *buf, size_t len, int flags);

ssize_t recv(int sockfd, void *buf, size_t len, int flags);

ssize_t sendto(int sockfd, const void *buf, size_t len, int flags,

const struct sockaddr *dest_addr, socklen_t addrlen);

ssize_t recvfrom(int sockfd, void *buf, size_t len, int flags,

struct sockaddr *src_addr, socklen_t *addrlen);

ssize_t sendmsg(int sockfd, const struct msghdr *msg, int flags);

ssize_t recvmsg(int sockfd, struct msghdr *msg, int flags);

read函数是负责从fd中读取内容.当读成功时,read返回实际所读的字节数,如果返回的值是0表示已经读到文件的结束了,小于0表示出现了错误。如果错误为EINTR说明读是由中断引起的,如果是ECONNREST表示网络连接出了问题。

write函数将buf中的nbytes字节内容写入文件描述符fd.成功时返回写的字节数。失败时返回-1,并设置errno变量。 在网络程序中,当我们向套接字文件描述符写时有俩种可能。1)write的返回值大于0,表示写了部分或者是全部的数据。2)返回的值小于0,此时出现了错误。我们要根据错误类型来处理。如果错误为EINTR表示在写的时候出现了中断错误。如果为EPIPE表示网络连接出现了问题(对方已经关闭了连接)。

其它的我就不一一介绍这几对I/O函数了,具体参见man文档或者baidu、Google,下面的例子中将使用到send/recv。

3.6、close()函数

在服务器与客户端建立连接之后,会进行一些读写操作,完成了读写操作就要关闭相应的socket描述字,好比操作完打开的文件要调用fclose关闭打开的文件。

#include <unistd.h>

int close(int fd);

close一个TCP socket的缺省行为时把该socket标记为以关闭,然后立即返回到调用进程。该描述字不能再由调用进程使用,也就是说不能再作为read或write的第一个参数。

注意:close操作只是使相应socket描述字的引用计数-1,只有当引用计数为0的时候,才会触发TCP客户端向服务器发送终止连接请求。

4、socket中TCP的三次握手建立连接详解

我们知道tcp建立连接要进行“三次握手”,即交换三个分组。大致流程如下:

客户端向服务器发送一个SYN J

服务器向客户端响应一个SYN K,并对SYN J进行确认ACK J+1

客户端再向服务器发一个确认ACK K+1

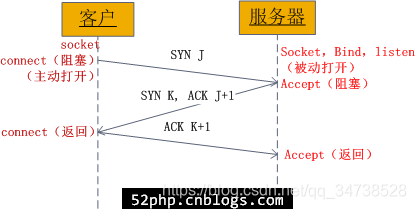

只有就完了三次握手,但是这个三次握手发生在socket的那几个函数中呢?请看下图:

图1、socket中发送的TCP三次握手

从图中可以看出,当客户端调用connect时,触发了连接请求,向服务器发送了SYN J包,这时connect进入阻塞状态;服务器监听到连接请求,即收到SYN J包,调用accept函数接收请求向客户端发送SYN K ,ACK J+1,这时accept进入阻塞状态;客户端收到服务器的SYN K ,ACK J+1之后,这时connect返回,并对SYN K进行确认;服务器收到ACK K+1时,accept返回,至此三次握手完毕,连接建立。

总结:客户端的connect在三次握手的第二次返回,而服务器端的accept在三次握手的第三次返回。

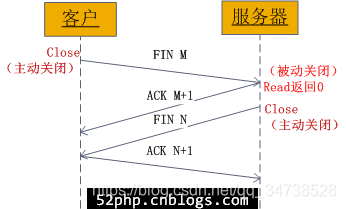

5、socket中TCP的四次握手释放连接详解

上面介绍了socket中TCP的三次握手建立过程,及其涉及的socket函数。现在我们介绍socket中的四次握手释放连接的过程,请看下图:

图2、socket中发送的TCP四次握手

图示过程如下:

某个应用进程首先调用close主动关闭连接,这时TCP发送一个FIN M;

另一端接收到FIN M之后,执行被动关闭,对这个FIN进行确认。它的接收也作为文件结束符传递给应用进程,因为FIN的接收意味着应用进程在相应的连接上再也接收不到额外数据;

一段时间之后,接收到文件结束符的应用进程调用close关闭它的socket。这导致它的TCP也发送一个FIN N;

接收到这个FIN的源发送端TCP对它进行确认。

这样每个方向上都有一个FIN和ACK。

6、一个例子(实践一下)

说了这么多了,动手实践一下。下面编写一个简单的服务器、客户端(使用TCP)——服务器端一直监听本机的6666号端口,如果收到连接请求,将接收请求并接收客户端发来的消息;客户端与服务器端建立连接并发送一条消息。

服务器端代码 server.c:

#include<stdio.h>

#include<stdlib.h>

#include<string.h>

#include<errno.h>

#include<sys/types.h>

#include<sys/socket.h>

#include<netinet/in.h>

#include <unistd.h>

#define MAXLINE 4096

int main(int argc, char **argv) {

int listenfd, connfd;

struct sockaddr_in servaddr;

char buff[4096];

int n;

if ((listenfd = socket(AF_INET, SOCK_STREAM, 0)) == -1) {

printf("create socket error: %s(errno: %d)\n", strerror(errno), errno);

exit(0);

}

memset(&servaddr, 0, sizeof(servaddr));

servaddr.sin_family = AF_INET;

servaddr.sin_addr.s_addr = htonl(INADDR_ANY);

servaddr.sin_port = htons(6666);

if (bind(listenfd, (struct sockaddr *) &servaddr, sizeof(servaddr)) == -1) {

printf("bind socket error: %s(errno: %d)\n", strerror(errno), errno);

exit(0);

}

if (listen(listenfd, 10) == -1) {

printf("listen socket error: %s(errno: %d)\n", strerror(errno), errno);

exit(0);

}

printf("======waiting for client's request======\n");

while (1) {

if ((connfd = accept(listenfd, (struct sockaddr *) NULL, NULL)) == -1) {

printf("accept socket error: %s(errno: %d)", strerror(errno), errno);

continue;

}

n = recv(connfd, buff, MAXLINE, 0);

buff[n] = '\0';

printf("recv msg from client: %s\n", buff);

close(connfd);

}

close(listenfd);

}

客户端代码 client.c:

#include<stdio.h>

#include<stdlib.h>

#include<string.h>

#include<errno.h>

#include<sys/types.h>

#include<sys/socket.h>

#include<netinet/in.h>

#include <unistd.h>

#define MAXLINE 4096

int main(int argc, char **argv) {

int sockfd, n;

char recvline[4096], sendline[4096];

struct sockaddr_in servaddr;

if (argc != 2) {

printf("usage: ./client <ipaddress>\n");

exit(0);

}

if ((sockfd = socket(AF_INET, SOCK_STREAM, 0)) < 0) {

printf("create socket error: %s(errno: %d)\n", strerror(errno), errno);

exit(0);

}

memset(&servaddr, 0, sizeof(servaddr));

servaddr.sin_family = AF_INET;

servaddr.sin_port = htons(6666);

if (inet_pton(AF_INET, argv[1], &servaddr.sin_addr) <= 0) {

printf("inet_pton error for %s\n", argv[1]);

exit(0);

}

if (connect(sockfd, (struct sockaddr *) &servaddr, sizeof(servaddr)) < 0) {

printf("connect error: %s(errno: %d)\n", strerror(errno), errno);

exit(0);

}

printf("send msg to server: \n");

fgets(sendline, 4096, stdin);

if (send(sockfd, sendline, strlen(sendline), 0) < 0) {

printf("send msg error: %s(errno: %d)\n", strerror(errno), errno);

exit(0);

}

close(sockfd);

exit(0);

}

当然上面的代码很简单,也有很多缺点,这就只是简单的演示socket的基本函数使用。其实不管有多复杂的网络程序,都使用的这些基本函数。上面的服务器使用的是迭代模式的,即只有处理完一个客户端请求才会去处理下一个客户端的请求,这样的服务器处理能力是很弱的,现实中的服务器都需要有并发处理能力!为了需要并发处理,服务器需要fork()一个新的进程或者线程去处理请求等。

7、动动手

编写如下程序完成如下功能:

服务器端:

接收地址192.168.100.2的客户端信息,如信息为“Client Query”,则打印“Receive Query”

客户端:

向地址192.168.100.168的服务器端顺序发送信息“Client Query test”,“Cleint Query”,“Client Query Quit”,然后退出。

题目中出现的ip地址可以根据实际情况定。

浅析TCP协议中的疑难杂症

https://blog.csdn.net/qiansg123/article/details/80126677

使用udp发送>=128K的消息会报ENOBUFS的错误

https://www.cnblogs.com/skynet/archive/2010/12/04/1881236.html

这个适合内核本身有关,仅是在此做一个参考

问题描述

简单介绍了Unix域套接口之后,进入主题——描述我碰到的问题。由于unix域套接口用于本机间进程通信比网络套接口效率高,因为它是不经过协议栈的!在项目中选择了unix域的数据报套接口。在使用过程中碰到了如下,问题:发送<128K的消息时,客户、进程可以正常收发消息;发送>=128K的消息时,发送端(sendto)返回ENOBUFS的错误。

服务器的代码如下:

#include<stdio.h>

#include<stdlib.h>

#include<sys/types.h>

#include<sys/socket.h>

#include<sys/un.h>

#include<errno.h>

//define send and recv buf size

#define BUFSIZE 512*1024

//define unix domain socket path

#define pmmanager "/tmp/pmmanager"

#define pmapi "/tmp/pmapi"

int main(int argc, char** argv)

{

char rx_buf[BUFSIZE];

int pmmanager_fd, ret;

socklen_t len;

struct sockaddr_un pmmanager_addr, pmapi_addr;

//create pmmanager socket fd

pmmanager_fd = socket(AF_UNIX, SOCK_DGRAM, 0);

if(pmmanager_fd == -1)

{

perror("cannot create pmmanager fd.");

}

unlink(pmmanager);

memset(&pmmanager_addr, 0, sizeof(pmmanager_addr));

pmmanager_addr.sun_family = AF_UNIX;

strncpy(pmmanager_addr.sun_path, pmmanager, sizeof(pmmanager_addr.sun_path)-1);

//bind pmmanager_fd to pmmanager_addr

ret = bind(pmmanager_fd, (struct sockaddr*)&pmmanager_addr, sizeof(pmmanager_addr));

if(ret == -1)

{

perror("can not bind pmmanager_addr");

}

int recvBufSize;

len = sizeof(recvBufSize);

ret = getsockopt(pmmanager_fd, SOL_SOCKET, SO_RCVBUF, &recvBufSize, &len);

if(ret ==-1)

{

perror("getsocket error.");

}

printf("Before setsockopt, SO_RCVBUF-%d\n",recvBufSize);

recvBufSize = 512*1024;

ret = setsockopt(pmmanager_fd, SOL_SOCKET, SO_RCVBUF, &recvBufSize, len);

if(ret == -1)

{

perror("setsockopt error.");

}

ret = getsockopt(pmmanager_fd, SOL_SOCKET, SO_RCVBUF, &recvBufSize, &len);

if(ret ==-1)

{

perror("getsocket error.");

}

printf("Set recv buf successful, SO_RCVBUF-%d\n",recvBufSize);

int recvSize;

memset(&pmapi_addr, 0, sizeof(pmapi_addr));

len = sizeof(pmapi_addr);

printf("==============wait for msg from pmapi====================\n");

for(;;)

{

memset(rx_buf, 0, sizeof(rx_buf));

recvSize = recvfrom(pmmanager_fd, rx_buf, sizeof(rx_buf), 0, (struct sockaddr*)&pmapi_addr, &len);

if(recvSize == -1)

{

perror("recvfrom error.");

}

printf("Recved message from pmapi: %s\n", rx_buf);

}

}

客户端的代码如下:

#include<stdio.h>

#include<stdlib.h>

#include<sys/types.h>

#include<sys/socket.h>

#include<sys/un.h>

#include<errno.h>

//define send and recv buf size

#define BUFSIZE 250*1024

//define unix domain socket path

#define pmmanager "/tmp/pmmanager"

#define pmapi "/tmp/pmapi"

int main(int argc, char** argv)

{

char tx_buf[BUFSIZE];

int pmapi_fd, ret;

socklen_t len;

struct sockaddr_un pmmanager_addr, pmapi_addr;

//create pmmanager socket fd

pmapi_fd = socket(AF_UNIX, SOCK_DGRAM, 0);

if(pmapi_fd == -1)

{

perror("cannot create pmapi fd.");

}

unlink(pmapi);

//configure pmapi's addr

memset(&pmapi_addr, 0, sizeof(pmapi_addr));

pmapi_addr.sun_family = AF_UNIX;

strncpy(pmapi_addr.sun_path, pmapi, sizeof(pmapi_addr.sun_path)-1);

//bind pmapi_fd to pmapi_addr

ret = bind(pmapi_fd, (struct sockaddr*)&pmapi_addr, sizeof(pmapi_addr));

if(ret == -1)

{

perror("bind error.");

}

int sendBufSize;

len = sizeof(sendBufSize);

ret = getsockopt(pmapi_fd, SOL_SOCKET, SO_SNDBUF, &sendBufSize, &len);

if(ret ==-1)

{

perror("getsocket error.");

}

printf("Before setsockopt, SO_SNDBUF-%d\n",sendBufSize);

sendBufSize = 512*1024;

ret = setsockopt(pmapi_fd, SOL_SOCKET, SO_SNDBUF, &sendBufSize, len);

if(ret == -1)

{

perror("setsockopt error.");

}

ret = getsockopt(pmapi_fd, SOL_SOCKET, SO_SNDBUF, &sendBufSize, &len);

if(ret ==-1)

{

perror("getsocket error.");

}

printf("Set send buf successful, SO_SNDBUF-%d\n\n\n", sendBufSize);

//configure pmmanager's addr

memset(&pmmanager_addr, 0, sizeof(pmmanager_addr));

pmmanager_addr.sun_family = AF_UNIX;

strncpy(pmmanager_addr.sun_path, pmmanager, sizeof(pmmanager_addr)-1);

len = sizeof(pmmanager_addr);

int sendSize = 0;

int i;

for(i=1; i<=4; i++)

{

memset(tx_buf, '0', sizeof(tx_buf));

sprintf(tx_buf, "send msg %d to pmmanager.", i);

printf("%s, msg size - %d\n",tx_buf, sizeof(tx_buf));

sendSize = sendto(pmapi_fd, tx_buf, sizeof(tx_buf), 0, (struct sockaddr*)&pmmanager_addr, len);

if(sendSize == -1)

{

perror("sendto error.");

}

printf("Send message to pmmanager: %s\n\n\n", tx_buf);

}

}

可能碰到的另外一个问题

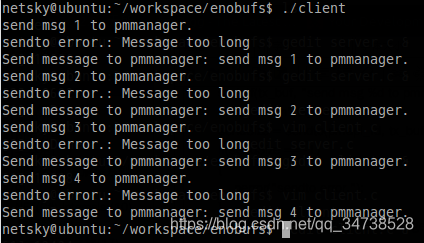

如果你没有设置足够大的发送缓冲区大小,你很有可能碰到EMSGSIZE的错误!因为应用程序写了一个大于套接口发送缓冲区大小的数据报,内核报EMSGSIZE错误。如下图:

(注意:UDP套接口有发送缓冲区的大小,并且可以通过SO_SNDBUF套接口选项修改。不过它仅仅是写到套接口的UDP数据报的大小,因为UDP是不可靠的,它不必保存应用进程的数据拷贝,因此无需一个真正的发送缓冲区。)上面的代码已经设置了足够大的发送缓冲区大小。

尝试

在sendto发送>=128K大小的消息时,返回ENOBUFS错误。

我怀疑是否是sendto()的原因,我改用sendmsg(),未果还是返回这个错误。

有人说是:“发送消息太频繁,间隔太短”。其实项目中发送消息根本就不频繁,背着死马当活马医,未果还是返回这个错误。

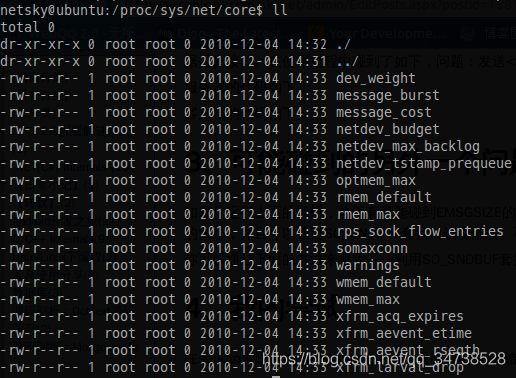

尝试修改/proc/sys/net/core下面的各种相关选项,如

未果,还是返回这个错误。(其它路径下的相关选项也试了,不行)

无从下手了,不知道128K的这个限制在哪?既然“No buffer space available”,我怎样给他空间?

最终原因及解决办法(都是内核惹得祸!!)

至此,我实在没有办法了,不知道如何解决!但是从错误ENOBUFS的说明:

ENOBUFS means there is no sufficient memory available and the system(kernel) can not allocate any more. Application will usually retry the operation when it detects this error from a system call since it indicates there is a transient resource shortage. It is the Operating system that refuses the resource request from the listener. The virtual memory allocation routine of the OS will determine if a swap can be made to disk of a real memory segment thereby allowing the listener access to some more real memory.

可以看出一些端倪,这肯定跟内存分配有关!而且限制在分配128K就失败!利用Socket进行进程间的通信,需要经过Linux内核:进程1将数据写到内核,进程2从内核读取数据。内核必须申请一个空间来存放数据包!实际上,socket发送数据包时,需要从slab中申请一块cache存放数据包。

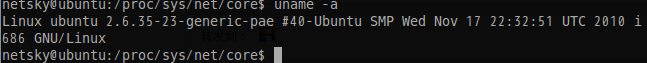

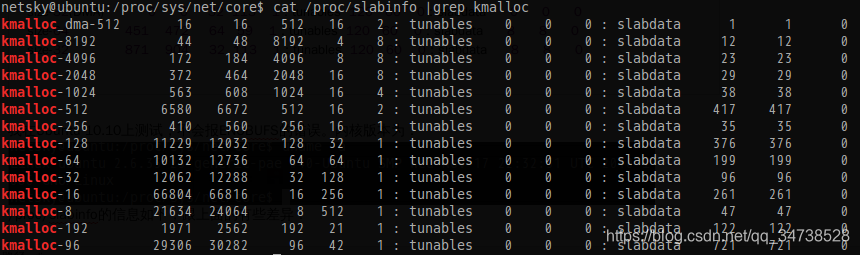

在2.6.21内核中(这就是我们公司服务器的内核版本),slab分配器最大支持的size为128K(详情可见/proc/slabinfo)。

在2.6.31内核中,slab分配器最大支持的size大小为32M。

所以2.6.21内核上,发送大于128K的数据包时,Kmalloc()会失败,并返回no buffer的错误。建议:对于本地进程通信,可以使用其它的IPC方式,进行数据通信,如shm、pipe等。

找出了原因,可以采用以下方式来解决该问题:

升级内核,或修改内核的这个限制。

改用unix 域udp套接口为unix域tcp套接口(最终我们采用的方式)。

改用其它的IPC方式(这个涉及到太多的修改,故我们放弃使用)。

附/proc/slabinfo 信息:size-131072即128K的限制!

。。。。。。

size-131072(DMA) 0 0 131072 1 32 : tunables 8 4 0 : slabdata 0 0 0

size-131072 0 0 131072 1 32 : tunables 8 4 0 : slabdata 0 0 0

size-65536(DMA) 0 0 65536 1 16 : tunables 8 4 0 : slabdata 0 0 0

size-65536 0 0 65536 1 16 : tunables 8 4 0 : slabdata 0 0 0

size-32768(DMA) 0 0 32768 1 8 : tunables 8 4 0 : slabdata 0 0 0

size-32768 0 0 32768 1 8 : tunables 8 4 0 : slabdata 0 0 0

size-16384(DMA) 0 0 16384 1 4 : tunables 8 4 0 : slabdata 0 0 0

size-16384 0 0 16384 1 4 : tunables 8 4 0 : slabdata 0 0 0

size-8192(DMA) 0 0 8192 1 2 : tunables 8 4 0 : slabdata 0 0 0

size-8192 0 0 8192 1 2 : tunables 8 4 0 : slabdata 0 0 0

size-4096(DMA) 0 0 4096 1 1 : tunables 24 12 0 : slabdata 0 0 0

size-4096 4 4 4096 1 1 : tunables 24 12 0 : slabdata 4 4 0

size-2048(DMA) 0 0 2048 2 1 : tunables 24 12 0 : slabdata 0 0 0

size-2048 12 14 2048 2 1 : tunables 24 12 0 : slabdata 7 7 0

size-1024(DMA) 0 0 1024 4 1 : tunables 54 27 0 : slabdata 0 0 0

size-1024 11 12 1024 4 1 : tunables 54 27 0 : slabdata 3 3 0

size-512(DMA) 0 0 512 8 1 : tunables 54 27 0 : slabdata 0 0 0

size-512 208 208 512 8 1 : tunables 54 27 0 : slabdata 26 26 0

size-256(DMA) 0 0 256 15 1 : tunables 120 60 0 : slabdata 0 0 0

size-256 75 75 256 15 1 : tunables 120 60 0 : slabdata 5 5 0

size-192(DMA) 0 0 192 20 1 : tunables 120 60 0 : slabdata 0 0 0

size-192 40 40 192 20 1 : tunables 120 60 0 : slabdata 2 2 0

size-128(DMA) 0 0 128 30 1 : tunables 120 60 0 : slabdata 0 0 0

size-128 86 90 128 30 1 : tunables 120 60 0 : slabdata 3 3 0

size-96(DMA) 0 0 96 40 1 : tunables 120 60 0 : slabdata 0 0 0

size-96 388 400 96 40 1 : tunables 120 60 0 : slabdata 10 10 0

size-64(DMA) 0 0 64 59 1 : tunables 120 60 0 : slabdata 0 0 0

size-32(DMA) 0 0 32 113 1 : tunables 120 60 0 : slabdata 0 0 0

size-64 451 472 64 59 1 : tunables 120 60 0 : slabdata 8 8 0

size-32 871 904 32 113 1 : tunables 120 60 0 : slabdata 8 8 0

。。。。。。

我在Ubuntu 10.10和14.04上测试,不会报ENOBUFS的错误。内核版本为:

/proc/slabinfo的信息如下,跟上面的有些差异:

kmalloc的最大限制是8192K,故我们运行上述程序没有问题!

原来都是内核惹得祸阿,害我困惑那么久!!!baidu和google都没有找到原因,因此分享此文,以警惕后者。

2470

2470

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?