1. 下载

http://www.apache.org/dyn/closer.lua/flume/1.9.0/apache-flume-1.9.0-bin.tar.gz

2. 安装JDK

确保你已经按照了JDK-1.8+

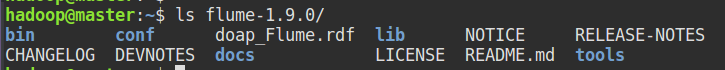

3. 安装Flume

解压安装包、移动到你想要的位置、修改名称等:

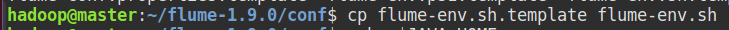

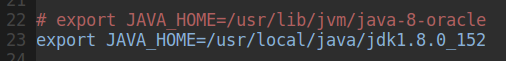

配置文件、指定JDK的安装路径::

配置环境变量:

vim ~/.bashrc

# Flume

export FLUME_HOME=/home/hadoop/flume-1.9.0

export PATH=$PATH:FLUME_HOME/bin

source ~/.bashrc

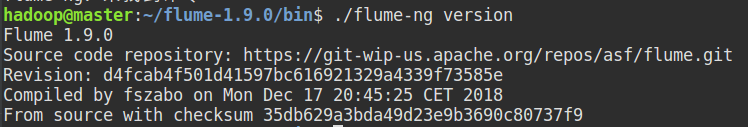

查看Flume版本:

4. 启动Flume

官网手册:http://flume.apache.org/releases/content/1.9.0/FlumeUserGuide.html#setup

使用Flume 最主要的操作就是配置配置文件,如在conf/ 下建立example.conf 文件,添加如下内容:

简单描述:

a1 是启动名命令指定的agent 名称

r1 是source名称

k1是sink名称

c1是channel名称

使用netcat 模式读取数据,指定主机和端口

设置channel数据保存在内存

设置source 和 sink的channel指向。

conf/example.conf

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source

a1.sources.r1.type = netcat

a1.sources.r1.bind = master

a1.sources.r1.port = 44444

# Describe the sink

a1.sinks.k1.type = logger

# Use a channel which buffers events in memory

a1.channels.c1.type = memory

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

启动命令:

a1 对应配置文件中的a1、–conf是flume配置文件、–conf-file是用户配置文件、-Dflume.root.logger显示到控制台。

bin/flume-ng agent \

--name a1 \

--conf $FLUME_HOME/conf \

--conf-file $FLUME_HOME/conf/example.conf \

-Dflume.root.logger=INFO,console

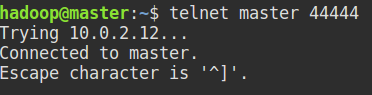

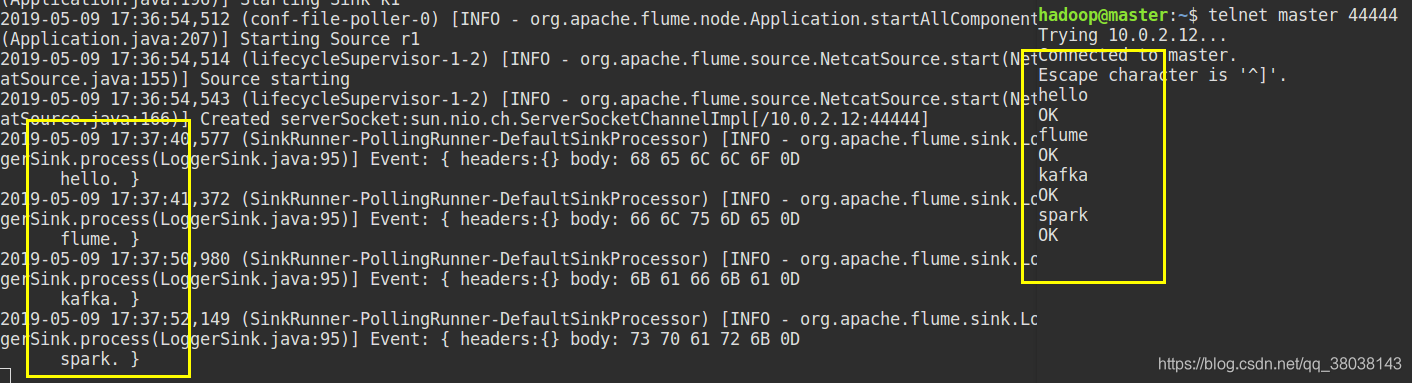

另一个终端启动telnet:

测试数据:

本文详细介绍如何下载、安装及配置Flume数据收集系统。包括JDK安装、Flume环境变量配置、配置文件编辑,以及如何通过Netcat模式读取数据。通过实例演示Flume agent的启动与数据收集流程。

本文详细介绍如何下载、安装及配置Flume数据收集系统。包括JDK安装、Flume环境变量配置、配置文件编辑,以及如何通过Netcat模式读取数据。通过实例演示Flume agent的启动与数据收集流程。

820

820

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?