文章目录

Seata 1.3 下载

下载链接:

github seata下载地址

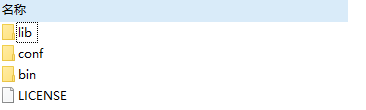

解压文件

修改配置文件

- 1、file.conf文件的修改

## transaction log store, only used in seata-server

store {

## store mode: file、db、redis

mode = "db"

## file store property

file {

## store location dir

dir = "sessionStore"

# branch session size , if exceeded first try compress lockkey, still exceeded throws exceptions

maxBranchSessionSize = 16384

# globe session size , if exceeded throws exceptions

maxGlobalSessionSize = 512

# file buffer size , if exceeded allocate new buffer

fileWriteBufferCacheSize = 16384

# when recover batch read size

sessionReloadReadSize = 100

# async, sync

flushDiskMode = async

}

## database store property

db {

## the implement of javax.sql.DataSource, such as DruidDataSource(druid)/BasicDataSource(dbcp)/HikariDataSource(hikari) etc.

datasource = "druid"

## mysql/oracle/postgresql/h2/oceanbase etc.

dbType = "mysql"

driverClassName = "com.mysql.jdbc.Driver"

url = "jdbc:mysql://192.168.99.100:3306/seata"

user = "root"

password = "root"

minConn = 5

maxConn = 30

globalTable = "global_table"

branchTable = "branch_table"

lockTable = "lock_table"

queryLimit = 100

maxWait = 5000

}

## redis store property

redis {

host = "127.0.0.1"

port = "6379"

password = ""

database = "0"

minConn = 1

maxConn = 10

queryLimit = 100

}

}

- 2、修改registry.conf配置文件

registry {

# file 、 nacos 、eureka、redis、zk、consul、etcd3、sofa

type = "nacos"

nacos {

application = "seata-server"

serverAddr = "127.0.0.1:8848"

group = "SEATA_GROUP"

namespace = ""

cluster = "default"

username = ""

password = ""

}

eureka {

serviceUrl = "http://localhost:8761/eureka"

application = "default"

weight = "1"

}

redis {

serverAddr = "localhost:6379"

db = 0

password = ""

cluster = "default"

timeout = 0

}

zk {

cluster = "default"

serverAddr = "127.0.0.1:2181"

sessionTimeout = 6000

connectTimeout = 2000

username = ""

password = ""

}

consul {

cluster = "default"

serverAddr = "127.0.0.1:8500"

}

etcd3 {

cluster = "default"

serverAddr = "http://localhost:2379"

}

sofa {

serverAddr = "127.0.0.1:9603"

application = "default"

region = "DEFAULT_ZONE"

datacenter = "DefaultDataCenter"

cluster = "default"

group = "SEATA_GROUP"

addressWaitTime = "3000"

}

file {

name = "file.conf"

}

}

config {

# file、nacos 、apollo、zk、consul、etcd3

type = "nacos"

nacos {

serverAddr = "127.0.0.1:8848"

namespace = ""

group = "SEATA_GROUP"

username = ""

password = ""

}

consul {

serverAddr = "127.0.0.1:8500"

}

apollo {

appId = "seata-server"

apolloMeta = "http://192.168.1.204:8801"

namespace = "application"

}

zk {

serverAddr = "127.0.0.1:2181"

sessionTimeout = 6000

connectTimeout = 2000

username = ""

password = ""

}

etcd3 {

serverAddr = "http://localhost:2379"

}

file {

name = "file.conf"

}

}

注册和配置均采取nacos注册中心。

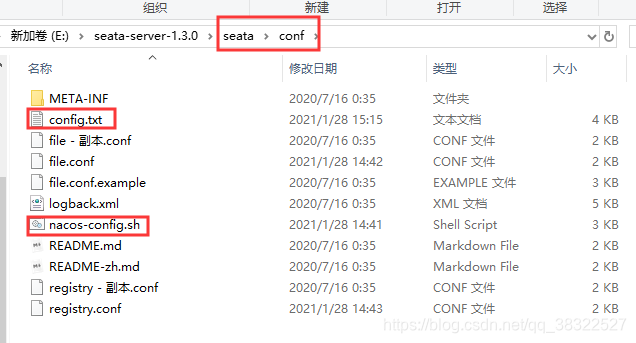

配置导入nacos,方便服务拉取seata配置

新建config.txt配置文件信息:

该文件目录地址存放

conf/下

其中的配置信息如下所示,可以直接粘贴至文件中:

transport.type=TCP

transport.server=NIO

transport.heartbeat=true

transport.enableClientBatchSendRequest=false

transport.threadFactory.bossThreadPrefix=NettyBoss

transport.threadFactory.workerThreadPrefix=NettyServerNIOWorker

transport.threadFactory.serverExecutorThreadPrefix=NettyServerBizHandler

transport.threadFactory.shareBossWorker=false

transport.threadFactory.clientSelectorThreadPrefix=NettyClientSelector

transport.threadFactory.clientSelectorThreadSize=1

transport.threadFactory.clientWorkerThreadPrefix=NettyClientWorkerThread

transport.threadFactory.bossThreadSize=1

transport.threadFactory.workerThreadSize=default

transport.shutdown.wait=3

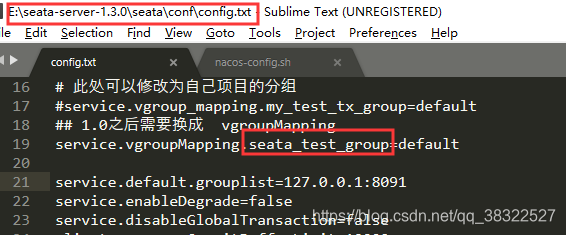

# 此处可以修改为自己项目的分组

#service.vgroup_mapping.my_test_tx_group=default

## 1.0之后需要换成 vgroupMapping

## 可以写多个配置,只需要相关联的group统一就行

service.vgroupMapping.seata_test_group=default

service.default.grouplist=127.0.0.1:8091

service.enableDegrade=false

service.disableGlobalTransaction=false

client.rm.asyncCommitBufferLimit=10000

client.rm.lock.retryInterval=10

client.rm.lock.retryTimes=30

client.rm.lock.retryPolicyBranchRollbackOnConflict=true

client.rm.reportRetryCount=5

client.rm.tableMetaCheckEnable=false

client.rm.tableMetaCheckerInterval=60000

client.rm.sqlParserType=druid

client.rm.reportSuccessEnable=false

client.rm.sagaBranchRegisterEnable=false

client.tm.commitRetryCount=5

client.tm.rollbackRetryCount=5

client.tm.defaultGlobalTransactionTimeout=60000

client.tm.degradeCheck=false

client.tm.degradeCheckAllowTimes=10

client.tm.degradeCheckPeriod=2000

#此处配置file.conf一致

store.mode=db

store.publicKey=

store.file.dir=file_store/data

store.file.maxBranchSessionSize=16384

store.file.maxGlobalSessionSize=512

store.file.fileWriteBufferCacheSize=16384

store.file.flushDiskMode=async

store.file.sessionReloadReadSize=100

store.db.datasource=druid

store.db.dbType=mysql

#配置数据库相关信息

##store.db.driverClassName=com.mysql.cj.jdbc.Driver

store.db.driverClassName=com.mysql.jdbc.Driver

store.db.url=jdbc:mysql://192.168.99.100:3306/seata?useUnicode=true

store.db.user=root

store.db.password=root

icKeyRetrieval=true

store.db.minConn=5

store.db.maxConn=30

store.db.globalTable=global_table

store.db.branchTable=branch_table

store.db.queryLimit=100

store.db.lockTable=lock_table

store.db.maxWait=5000

store.redis.mode=single

store.redis.single.host=127.0.0.1

store.redis.single.port=6379

store.redis.maxConn=10

store.redis.minConn=1

store.redis.maxTotal=100

store.redis.database=0

store.redis.password=

store.redis.queryLimit=100

server.recovery.committingRetryPeriod=1000

server.recovery.asynCommittingRetryPeriod=1000

server.recovery.rollbackingRetryPeriod=1000

server.recovery.timeoutRetryPeriod=1000

server.maxCommitRetryTimeout=-1

server.maxRollbackRetryTimeout=-1

server.rollbackRetryTimeoutUnlockEnable=false

client.undo.dataValidation=true

client.undo.logSerialization=jackson

client.undo.onlyCareUpdateColumns=true

server.undo.logSaveDays=7

server.undo.logDeletePeriod=86400000

client.undo.logTable=undo_log

client.undo.compress.enable=true

client.undo.compress.type=zip

client.undo.compress.threshold=64k

log.exceptionRate=100

transport.serialization=seata

transport.compressor=none

metrics.enabled=false

metrics.registryType=compact

metrics.exporterList=prometheus

metrics.exporterPrometheusPort=9898

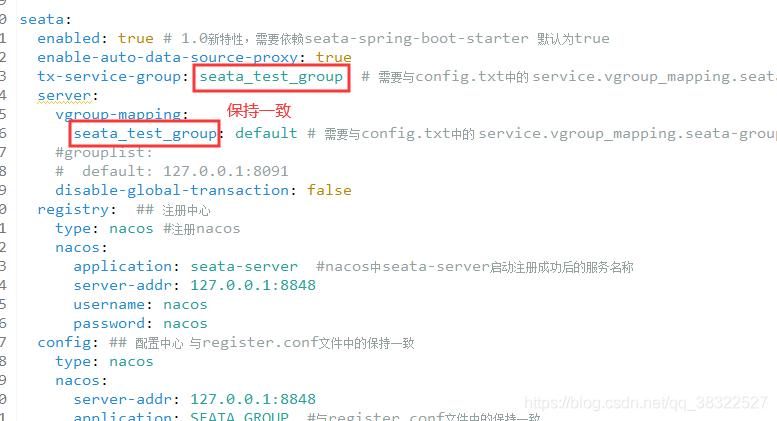

【扩展说明】service.vgroupMapping 配置项说明:

上面的配置中,有这么一行配置项:

service.vgroupMapping.seata_test_group=default

其中seata_test_group是配置的分布式事务分组,可以划分多个不同的分组级别,不同的分布式全局事务使用不同的分组。

对应

各个微服务配置文件 bootstrap.yml中的seata.tx-service-group。需要保持绝对一致!

其后的值default,对应seata 配置路径下 config/registry.conf文件中,registry中nacos的cluster的设置值。

这里使用的是nacos注册中心。

资料参考:seata解决多服务分布式事务(上)

编写nacos-config.sh脚本

该文件存放于

./conf下

其中脚本代码如下所示:

#!/usr/bin/env bash

# Copyright 1999-2019 Seata.io Group.

#

# Licensed under the Apache License, Version 2.0 (the "License");

# you may not use this file except in compliance with the License.

# You may obtain a copy of the License at、

#

# http://www.apache.org/licenses/LICENSE-2.0

#

# Unless required by applicable law or agreed to in writing, software

# distributed under the License is distributed on an "AS IS" BASIS,

# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

# See the License for the specific language governing permissions and

# limitations under the License.

while getopts ":h:p:g:t:u:w:" opt

do

case $opt in

h)

host=$OPTARG

;;

p)

port=$OPTARG

;;

g)

group=$OPTARG

;;

t)

tenant=$OPTARG

;;

u)

username=$OPTARG

;;

w)

password=$OPTARG

;;

?)

echo " USAGE OPTION: $0 [-h host] [-p port] [-g group] [-t tenant] [-u username] [-w password] "

exit 1

;;

esac

done

urlencode() {

for ((i=0; i < ${#1}; i++))

do

char="${1:$i:1}"

case $char in

[a-zA-Z0-9.~_-]) printf $char ;;

*) printf '%%%02X' "'$char" ;;

esac

done

}

if [[ -z ${host} ]]; then

host=localhost

fi

if [[ -z ${port} ]]; then

port=8848

fi

if [[ -z ${group} ]]; then

group="SEATA_GROUP"

fi

if [[ -z ${tenant} ]]; then

tenant=""

fi

if [[ -z ${username} ]]; then

username=""

fi

if [[ -z ${password} ]]; then

password=""

fi

nacosAddr=$host:$port

contentType="content-type:application/json;charset=UTF-8"

echo "set nacosAddr=$nacosAddr"

echo "set group=$group"

failCount=0

tempLog=$(mktemp -u)

function addConfig() {

curl -X POST -H "${contentType}" "http://$nacosAddr/nacos/v1/cs/configs?dataId=$(urlencode $1)&group=$group&content=$(urlencode $2)&tenant=$tenant&username=$username&password=$password" >"${tempLog}" 2>/dev/null

if [[ -z $(cat "${tempLog}") ]]; then

echo " Please check the cluster status. "

exit 1

fi

if [[ $(cat "${tempLog}") =~ "true" ]]; then

echo "Set $1=$2 successfully "

else

echo "Set $1=$2 failure "

(( failCount++ ))

fi

}

count=0

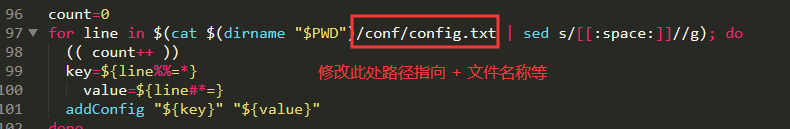

# 这里可能和官网给出的不一样,那是因为我修改了,方便两个文件放在同一路径下

for line in $(cat $(dirname "$PWD")/conf/config.txt | sed s/[[:space:]]//g); do

(( count++ ))

key=${line%%=*}

value=${line#*=}

addConfig "${key}" "${value}"

done

echo "========================================================================="

echo " Complete initialization parameters, total-count:$count , failure-count:$failCount "

echo "========================================================================="

if [[ ${failCount} -eq 0 ]]; then

echo " Init nacos config finished, please start seata-server. "

else

echo " init nacos config fail. "

fi

注意事项:

如果需要保证

config.txt和nacos-config.sh文件必须再相同路径下;

如果不想再同一路径下,你可以定义其中的.sh中的逻辑:

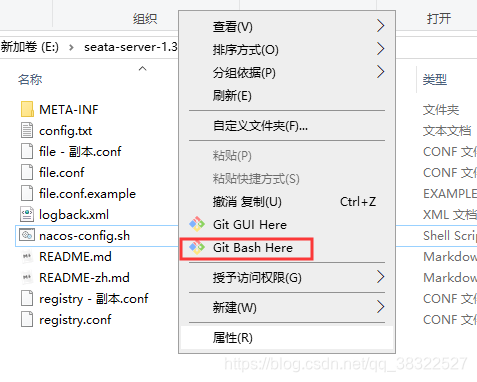

git bash窗口操作工具安装

将nacos的配置信息推送至nacos上。(必须保证nacos已启动!)

如果是windows用户,操作

xxx.sh文件,可以借用Git bash工具操作。

下载安装完成后,再指定路径下开启Git bash视窗工具。

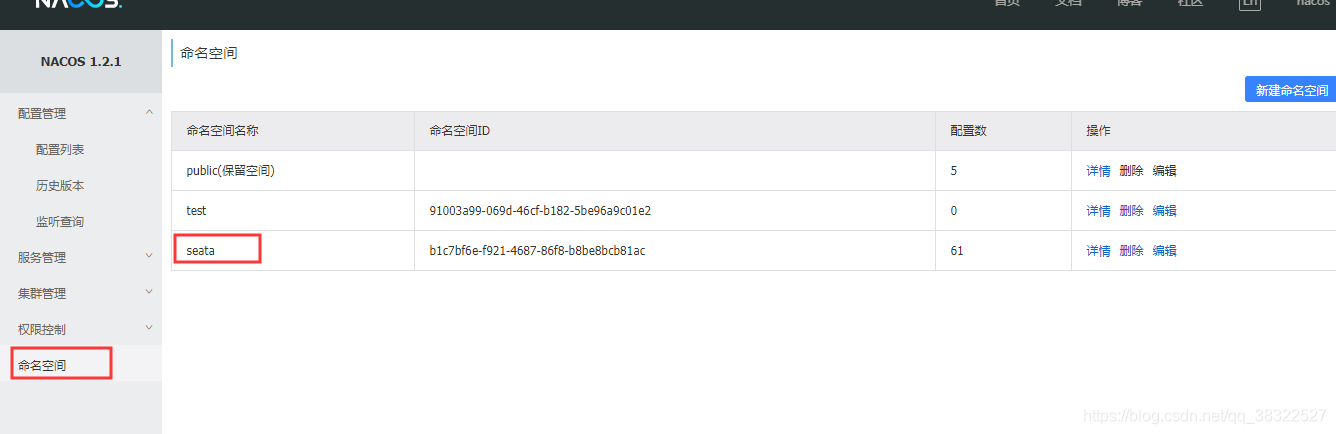

nacos中创建namespace

将配置信息推送nacos

使用如下指令实现配置推送至nacos:

sh nacos-config.sh -h 127.0.0.1 -p 8848 -g seata -t b1c7bf6e-f921-4687-86f8-b8be8bcb81ac -u nacos -w nacos

命令说明:

-h -p 指定nacos的端口地址;

-g 指定配置的分组,注意,是配置的分组;

-t 指定命名空间id;

-u -w指定nacos的用户名和密码,开启了nacos注册和配置认证的才需要指定。

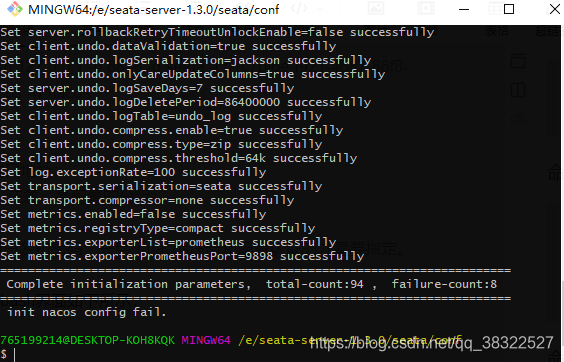

命令执行完成后,git bash界面如下所示:

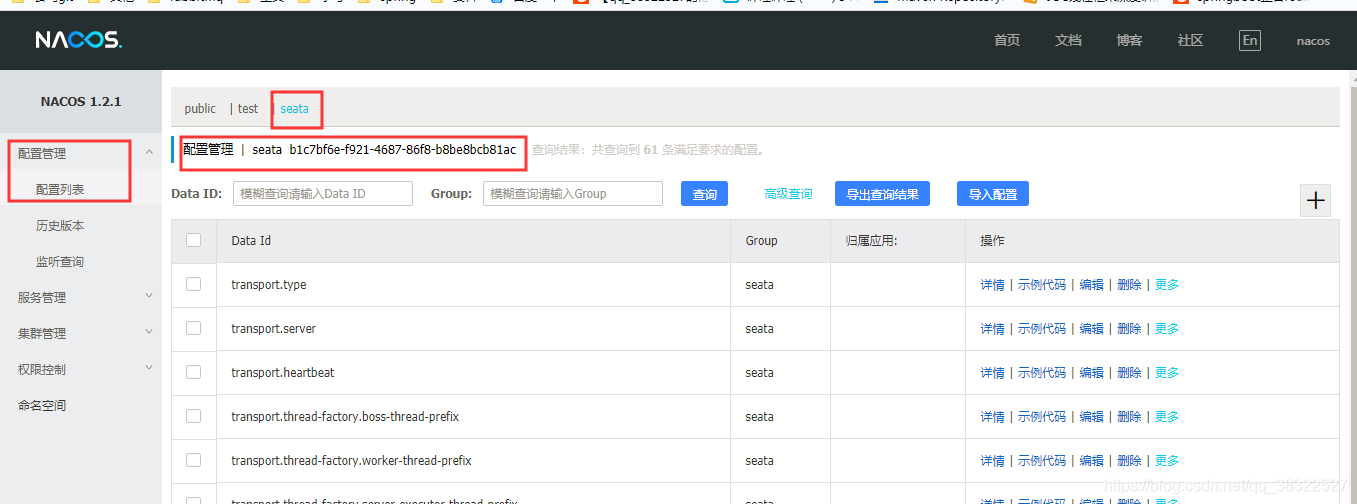

此时刷新nacos对应工作区间seata,如下所示:

此时表示seata的配置已经存放至nacos中。

springcloud父子项目工程创建

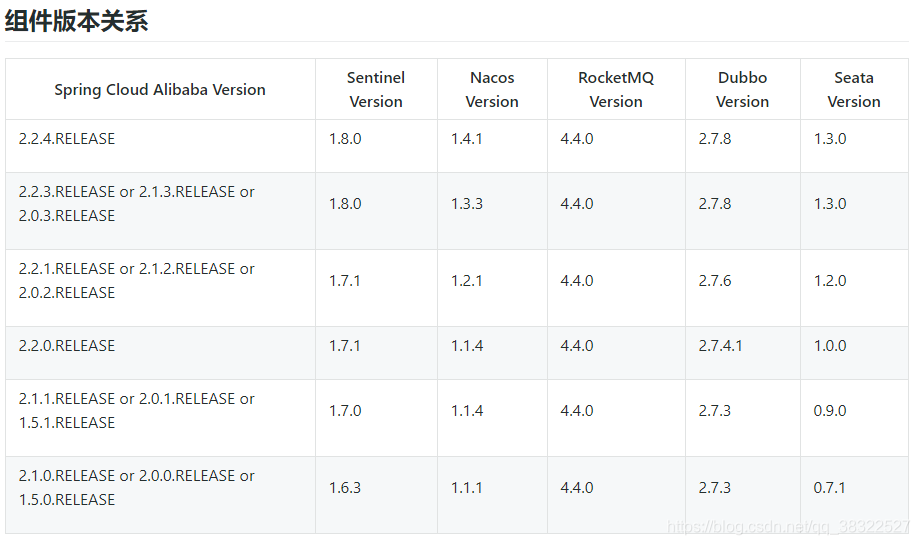

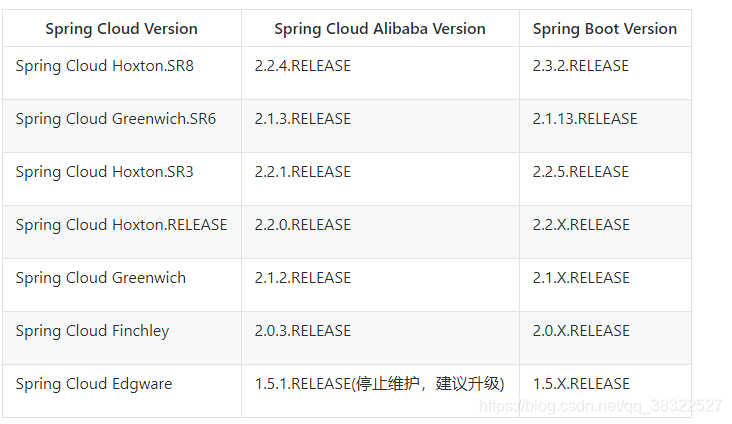

创建前的版本对应说明

再官网中,对于各个技术框架的使用有严格的版本区分,之前没有在乎版本之间的关系,出了很多问题,导致花了很多额外的时间。

官网版本关系说明

父工程创建

由于本次使用的是Eclipse,seata技术使用的版本是1.3.0,参考上面的版本要求,此时的springcloud alibaba需要使用2.2.4.RELEASE。

父工程中的主要依赖(文章末尾会给出项目git地址):

<spring.boot.version>2.2.2.RELEASE</spring.boot.version>

<spring.cloud.version>Hoxton.SR1</spring.cloud.version>

<spring.cloud.alibaba.version>2.2.4.RELEASE</spring.cloud.alibaba.version>

============================================================================

<dependencyManagement>

<dependencies>

<!--spring boot 2.2.2 -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-dependencies</artifactId>

<version>${spring.boot.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<!--spring cloud Hoxton.SR1 -->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-dependencies</artifactId>

<version>${spring.cloud.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<!--Spring cloud alibaba 2.1.0.RELEASE -->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-alibaba-dependencies</artifactId>

<version>${spring.cloud.alibaba.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<version>${lombok.version}</version>

</dependency>

<!--日志打印-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

<version>${log4j.version}</version>

</dependency>

</dependencies>

</dependencyManagement>

子项目创建

由于牵扯到的微服务数量过多,并且很多配置类的都类似,此处只展示一个子服务的创建和配置,对于其他子服务配置有疑问的可以参考文章末尾给出的github代码链接。

有

@GlobalTransactional操作的聚合服务类,需要再启动文件上移除springboot自带的DataSourceAutoConfiguration,并编写单独的数据源代理配置

其配置类如下所示:

import com.alibaba.druid.pool.DruidDataSource;

import io.seata.rm.datasource.DataSourceProxy;

import org.apache.ibatis.session.SqlSessionFactory;

import org.mybatis.spring.SqlSessionFactoryBean;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.boot.context.properties.ConfigurationProperties;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.core.io.support.PathMatchingResourcePatternResolver;

import org.springframework.core.io.support.ResourcePatternResolver;

import javax.sql.DataSource;

/**

* 配置数据源,使用seata对数据源做代理

*/

@Configuration

public class DataSourcesConfig {

@Value("${mybatis.mapperLocations}")

private String mapperLocations;

@Bean

@ConfigurationProperties(prefix = "spring.datasource")

public DataSource druidDataSource() {

return new DruidDataSource();

}

/**

* 使用 io.seata.rm.datasource.DataSourceProxy

* @param druidDataSource

* @return

*/

@Bean

public DataSourceProxy dataSourceProxy(DataSource druidDataSource) {

return new DataSourceProxy(druidDataSource);

}

@Bean

public SqlSessionFactory sqlSessionFactoryBean(DataSourceProxy dataSourceProxy) throws Exception {

SqlSessionFactoryBean bean = new SqlSessionFactoryBean();

bean.setDataSource(dataSourceProxy);

ResourcePatternResolver resolver = new PathMatchingResourcePatternResolver();

bean.setMapperLocations(resolver.getResources(mapperLocations));

return bean.getObject();

}

}

子项目依赖引入

由于使用的是父子工程模式开发,所以子项目中只需要引入其需要操作的依赖即可,本次探究的是seata 1.3.0的配置和使用,则只展示seata依赖:

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-seata</artifactId>

<!--由于默认自带的版本很低,则需要手动移除,重新导入指定版本的seata -->

<exclusions>

<exclusion>

<groupId>io.seata</groupId>

<artifactId>seata-spring-boot-starter</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>io.seata</groupId>

<artifactId>seata-spring-boot-starter</artifactId>

<version>1.3.0</version>

</dependency>

子项目配置文件的编写

## 该服务的端口信息

server:

port: 9001

## mybatis 配置

mybatis:

## 驼峰命名匹配

configuration:

map-underscore-to-camel-case: true

type-aliases-package: cn.linkpower.dao

## 扫描mapper文件

mapperLocations: classpath:mapper/*.xml

## 服务别名和nacos服务注册发现地址配置

spring:

application:

name: seata-order-service

cloud:

nacos:

discovery:

server-addr: localhost:8848

datasource:

url: jdbc:mysql://192.168.99.100:3306/seata_order?serverTimezone=UTC&useSSL=false&useUnicode=true&characterEncoding=utf-8

driver-class-name: com.mysql.cj.jdbc.Driver

username: root

password: root

seata:

enabled: true # 1.0新特性,需要依赖seata-spring-boot-starter 默认为true

enable-auto-data-source-proxy: true # 牵扯到回滚

tx-service-group: seata_test_group # 需要与config.txt中的 service.vgroupMapping.seata_test_group=default保持一致

server:

vgroup-mapping:

seata_test_group: default # 需要与config.txt中的 service.vgroupMapping.seata_test_group=default 保持一致

#grouplist:

# default: 127.0.0.1:8091

disable-global-transaction: false

registry: ## 注册中心

type: nacos #注册nacos

nacos:

application: seata-server #nacos中seata-server启动注册成功后的服务名称

server-addr: 127.0.0.1:8848

username: nacos

password: nacos

config: ## 配置中心 与register.conf文件中的保持一致

type: nacos

nacos:

server-addr: 127.0.0.1:8848

application: SEATA_GROUP #与register.conf文件中的保持一致

username: nacos

password: nacos

namespace: b1c7bf6e-f921-4687-86f8-b8be8bcb81ac #默认public,此处是创建的seata工作区间

client:

rm:

report-success-enable: false

## 监控相关

management.endpoints.web.exposure.include: '*'

feign:

hystrix:

enabled: false

此处的配置文件中,需要额外注意的一点:

784

784

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?