David Silver 第二讲MDP基本概念

本文只是作者个人理解,如有错误,欢迎各位指正。

一、基本定义

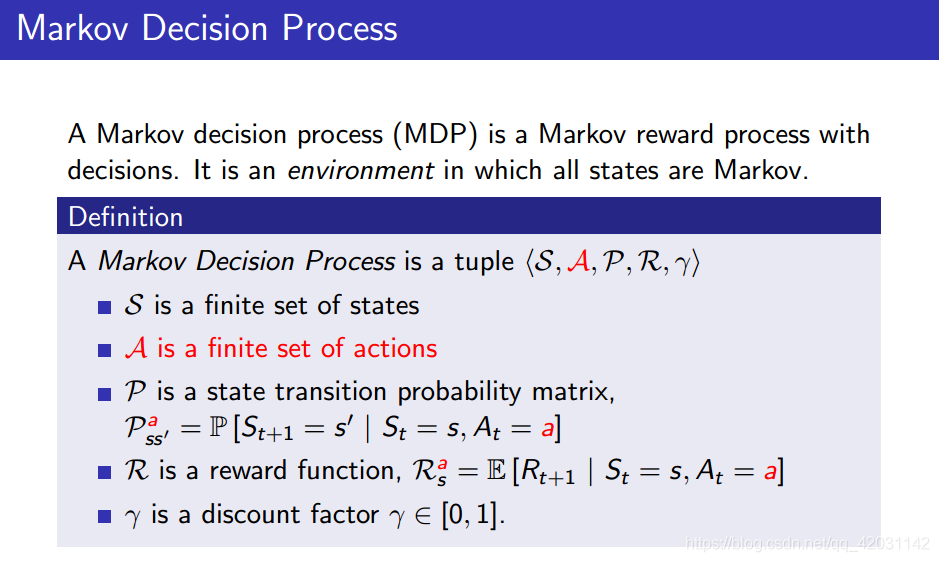

MDP过程是一个五元组——状态空间+行为空间+状态转移概率空间+奖励+折扣因子

其中,状态空间,折扣因子类比于MRP(马尔可夫奖励过程)

对于,行为空间:一组有限行为的集合,例:走迷宫游戏的(上下左右四个动作)构成行为空间

状态转移概率:与MP(马尔可夫过程)和MRP(马尔可夫奖励过程)不同,MDP加入了行为(Action)的影响。例:无人操控的小船状态转移完全服从传统的状态转移矩阵,即,但是对于有人操控的小船,状态转移受到了人的影响,此时

。注意:这里人的行为(即a)对状态转移的影响是概率事件,也就是说,小船在状态

的时候加入人的行为

,小船下一个状态也是随机的,只不过这个随机概率和没人操控时小船状态变化的随机概率不一样。

奖励:MRP中的奖励定义为:,MDP加入了行为(Action)的影响。简单理解:身处状态s,系统并不会给Agent奖励,而是身处状态s并做动作a,系统才会给Agent奖励。

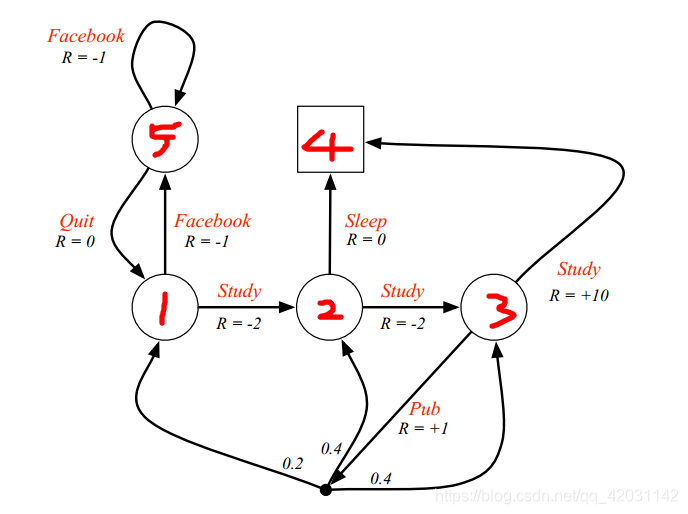

引用David Silver的Student MDP例子说明:

1、状态空间:包含五个状态:1~5,比较容易理解;

2、行为空间:{FaceBook Study Pub Quit};

3、状态转移概率:例:;这里=1是一个巧合,即只要在状态1下学习必定到达状态2

正常一点的例子:

,

,

这里表示在状态3下进行Pub动作可以到达1,2,3中任一个状态,且服从0.2,0.4,0.4的概率分布,这个就是上面的公式

即在状态下加入人的行为

,下一个状态是随机的。

4、奖励:(状态-动作)二元组来决定奖励。

(1) 不同状态下做相同动作的奖励不同。例:状态3下做Study的动作奖励为10,状态1下做Study的动作奖励为-2

(2) 同一状态下做不同动作的奖励不同。例:状态1下做Study的动作奖励为-2,状态1下做FaceBook的动作奖励为-1

所以在MDP中,奖励和所处状态和采取行为都有关。

二、策略Policy

Writing...

518

518

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?