swish

2.swish

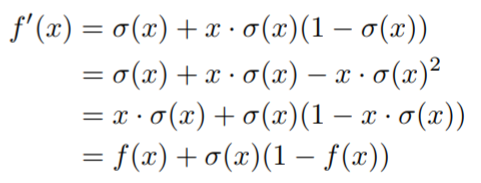

其中σ(x)是sigmoid函数,swish是光滑而且单调的,swish的导数是:

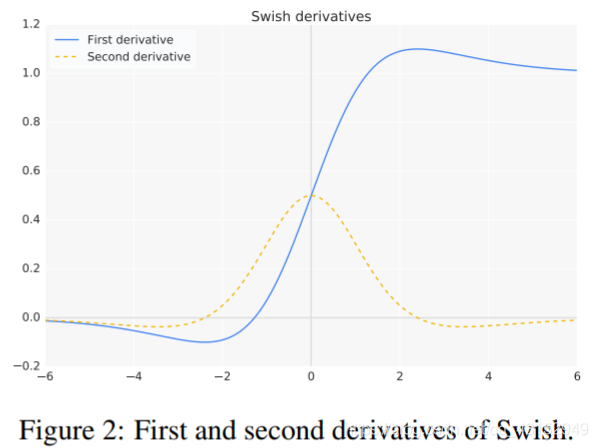

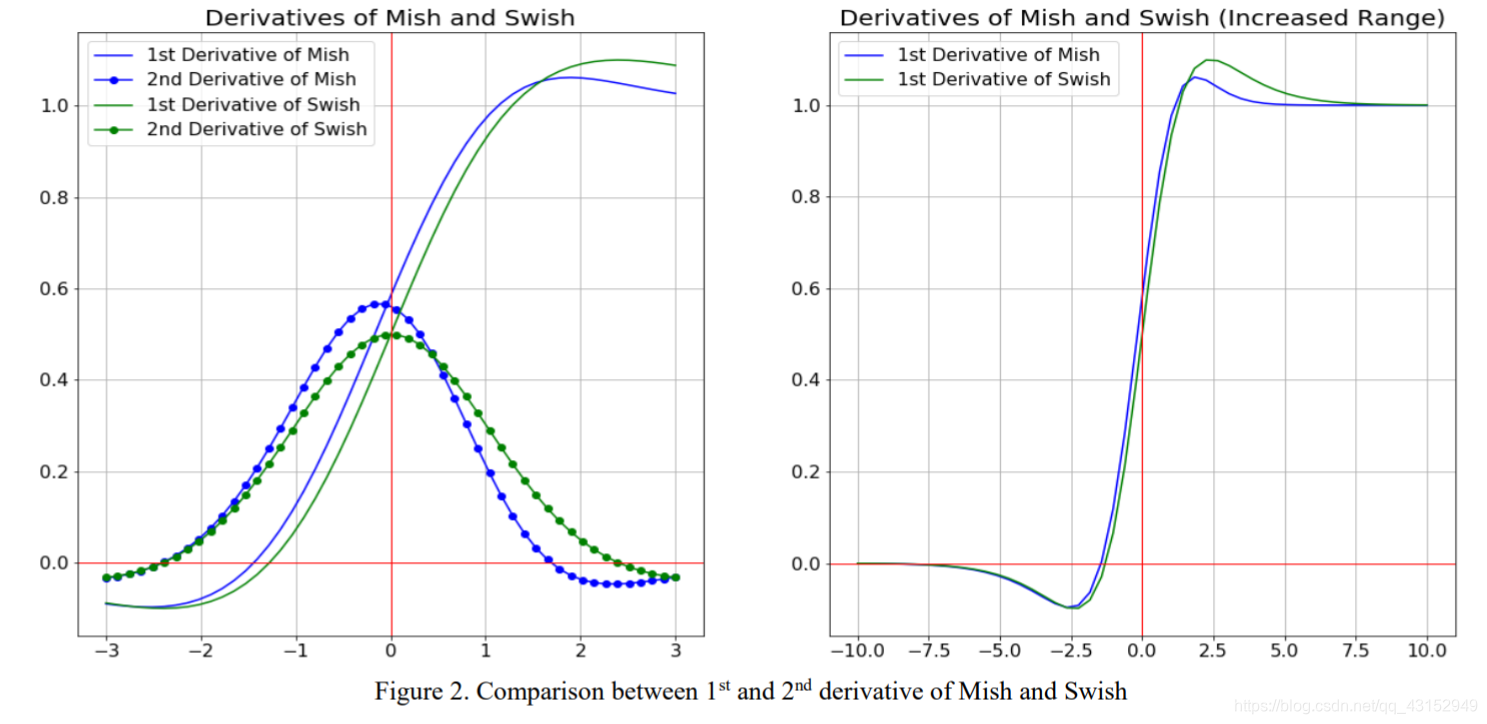

swish的第一和第二导数如图2所示:

无界性避免了饱和,函数饱和区域的梯度很小,训练非常缓慢,因此网络必须小心的初始化才能保持在这些函数的线性状态。此外,有下届也可能是有利的,因为强大的正则化效应。与relu和softplus不同的是, 由于它的非单调性,它为小的负输入产生负输出,swish的非单调性增加了表现力并改善了梯度流,这一点很重要,因为许多预激活都属于这个范围,该属性还可以对不同的初始化和学习速率提供一定的鲁棒性。

swish的网络输出landscape比relu要平滑的多,输出landscape的平整度直接影响着损失的平整度,平滑的损失可能更容易优化,因为它更具可遍历性,降低了对初始化和学习速率的敏感性。

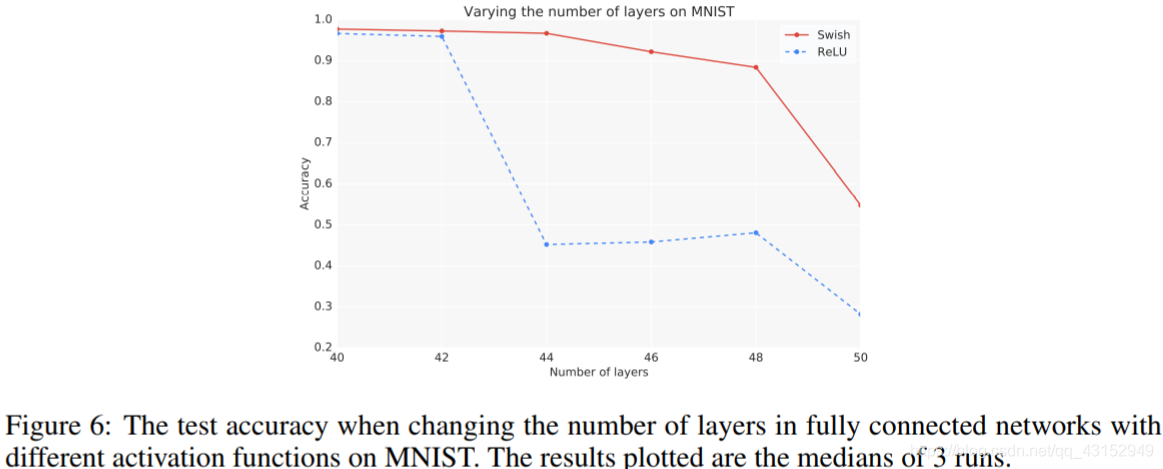

在非常深的网络中swish比relu精度更高,因为他没有压缩梯度。

mish

Mish的导数定义为:

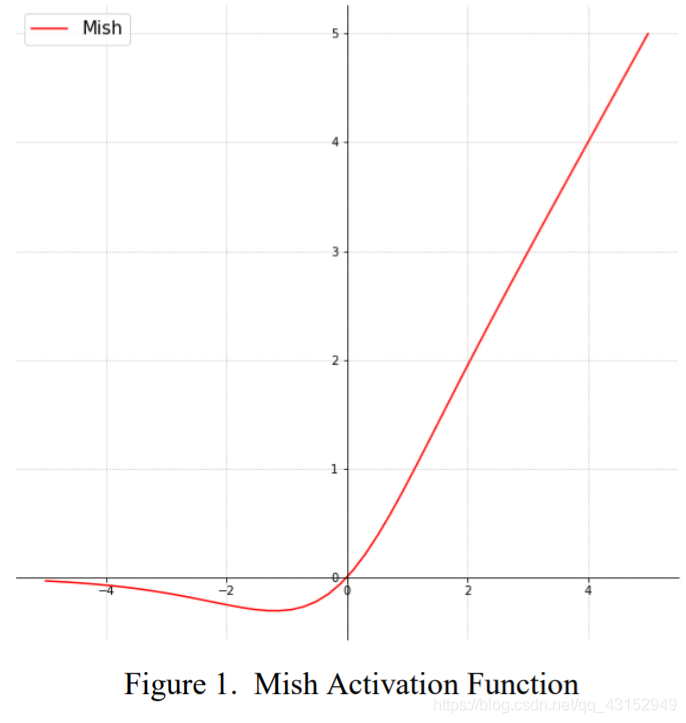

mish从swish的self-Gating属性中获得灵感,其中标量输入被提供给gate,self-gating有利于代替像relu这样的激活函数,而不需要改变网络参数。

Properties of Mish

由于其他很多的训练因素,很难解释为什么一种激活函数比另一种更好,但Mish无上界,有下界,平滑和非单调的特性都对结果有改善。

mish与swish对比:

从数据上来看mish的性能略优于swish,两篇论文的依据都差不多,mish中没有为什么mish优于swish的解释,单单是从大量的实验中得出mish优于swish的结论,两者的各项性质很像,mish这篇论文有大量的实验数据,从性能角度大体上看是:mish > swish > relu,其中mish只比swish的性能好一点点,而mish每个epoch的train的时间是158 seconds,而swish只有不到150 seconds,而relu只有不135 seconds左右。

2021

2021

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?