1. 模型的复杂性和权重大小相关:

在机器学习中,模型的复杂性可以与模型的参数大小挂钩。如果模型的权重非常大,说明模型对输入特征的某些维度特别敏感,这可能是因为模型过度拟合了训练数据的细节和噪声。权重过大往往意味着模型学到了不必要的复杂模式,导致在测试数据上表现不佳(即过拟合)。

2. L2 正则化通过惩罚大权重,控制模型复杂度:

L2 回归(L2 Regularization,也称 Ridge Regression)通过限制模型权重的大小来度量和控制模型的复杂性。它的核心思想是惩罚过大的权重值,以此避免模型过拟合数据,并提升模型的泛化能力。

L2 正则化的平方惩罚项 会强制模型的权重趋向于较小的值。如果权重值变大,惩罚项会大幅增加,从而增大总损失。这就迫使模型在优化时倾向于选择较小的权重,从而限制模型的复杂性。

- 当权重较小时,模型会更简单,不会对输入数据的微小变化产生过于剧烈的响应。

- 当权重较大时,模型可能会变得过于复杂,过拟合训练数据。

例子:线性回归模型中的 L2 正则化

假设我们有一个简单的线性回归模型,模型的目标是拟合一个函数 来预测输出值。

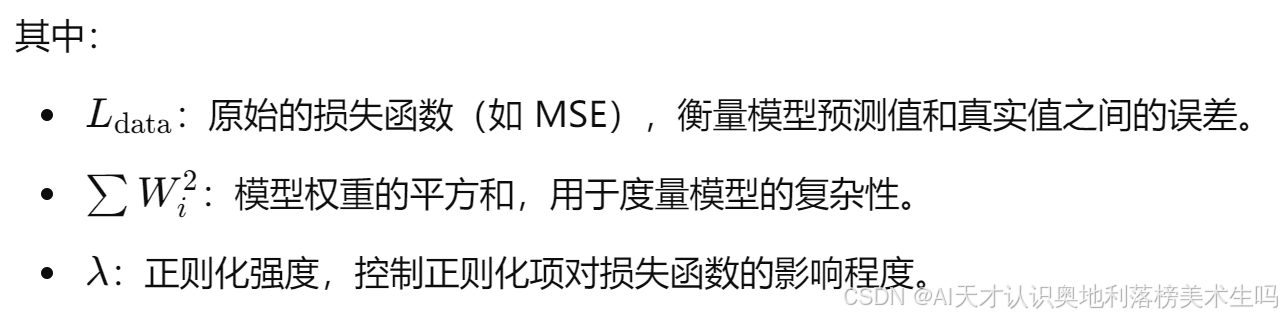

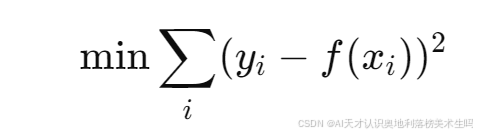

- 如果没有 L2 正则化,模型的目标是最小化均方误差(MSE),即:

在这种情况下,如果训练数据中有一些噪声点或异常点,模型可能会通过将某些权重

调得非常大,来准确拟合这些数据点。这会导致过拟合。

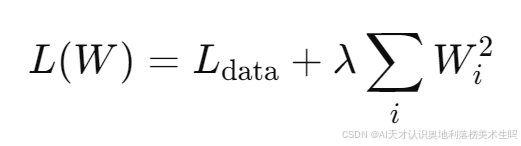

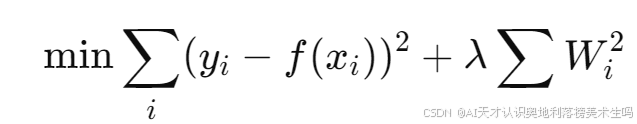

- 如果我们加上 L2 正则化,损失函数变为:

其中的

其中的  是正则化项,它惩罚权重过大的情况。这样,模型会倾向于选择较小的权重,避免过拟合。

是正则化项,它惩罚权重过大的情况。这样,模型会倾向于选择较小的权重,避免过拟合。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?