序言

AI 编码助手很厉害,但像 GitHub Copilot 那样收费就有点痛苦了。因此DeepSeek R1登场了!这是一个免费的开源语言模型,性能不输于 GPT-4 和 Claude 3.5。结合名为Cline的 VS Code 插件,可以编写代码、调试,甚至自动执行。而且,费用为零!

大概也就是因为如此,上一篇文章有非常多的朋友进行了阅读。白嫖超强 AI?DeepSeek R1 本地部署与 VS Code 集成全攻略!

有一些朋友在评论区进行了一些细节的提问题。

本文将从Cline的安装到如何将 DeepSeek R1 优化到项目中,详细说明所有必要的内容。让我们开始吧!

DeepSeek R1 的特别之处是什么?

1. 完全免费!

DeepSeek R1 是开源的,商业使用也可以。没有令牌限制,也没有隐藏费用。可以直接利用 AI 的力量。

2. 收费模型相媲美的性能

在编码、数学和逻辑推理方面表现出色。32B 模型超过了 OpenAI 的 o1-mini,70B 模型具有与 Claude 3.5 Sonnet 相当的能力。

3. 灵活的使用方式

如果重视隐私,可以在本地使用;如果想在云端使用,可以利用 DeepSeek 的 API(每百万个令牌$0.01 起)。

在 VS Code 中使用 Cline 设置 DeepSeek R1

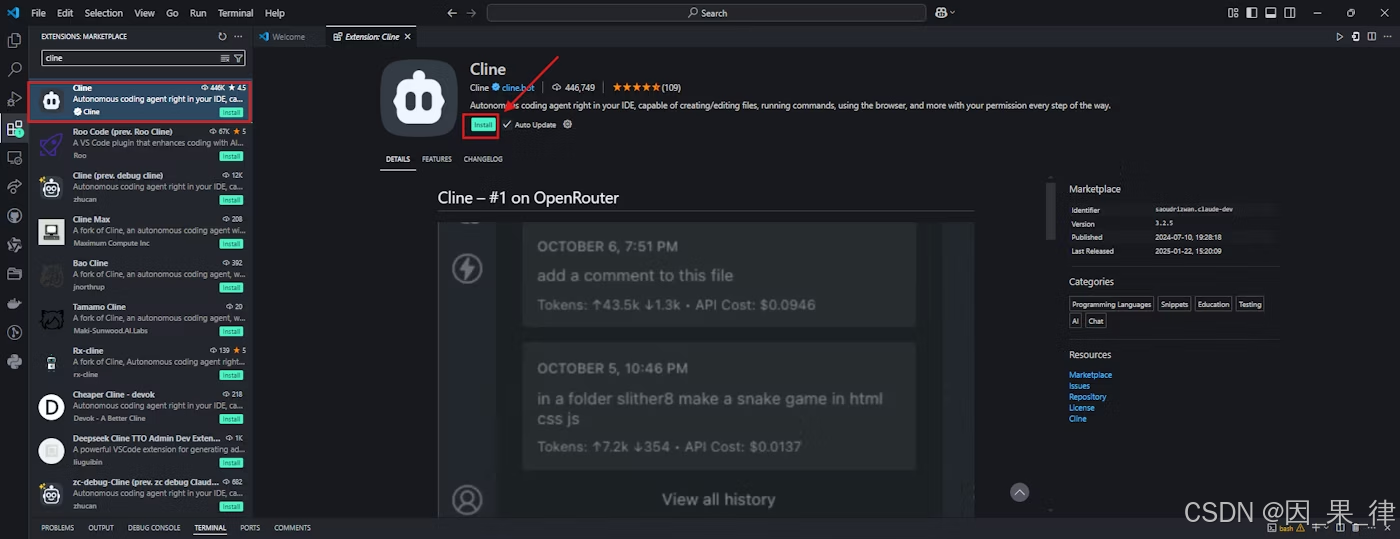

步骤 1:安装 Cline 插件

-

打开 VS Code,移动到扩展标签

-

搜索并安装「Cline」

-

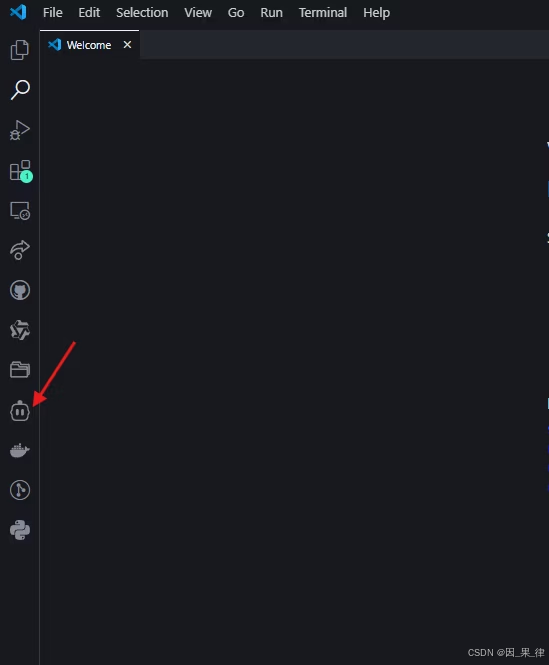

点击左侧边栏中的机器人图标以激活 Cline

步骤 2:选择 DeepSeek R1 的工作流程

选项 A:本地设置(免费,注重隐私)

-

安装 Ollama:ollama.com下载

-

模型拉取:在终端中执行以下命令

ollama pull deepseek-r1:14b # 中等级别硬件(例:RTX 3060)

基本的任务可以使用 1.5b,但编码建议使用 14B 以上。

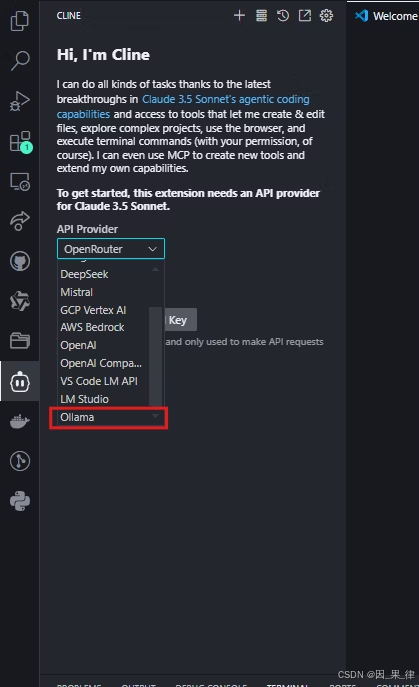

- 设置 Cline:

-

将 API 提供者设置为「Ollama」

-

在基础 URL 中输入

http://localhost:11434,并选择模型(例如:deepseek-r1:14b)

-

点击「Lets go」以开始使用。

选项 B:OpenRouter 集成(灵活的模型切换)

如果想访问多个 AI 模型,OpenRouter 非常方便。可以将 DeepSeek R1 设为默认,同时也可以与其他模型进行比较。

步骤 1: 获取 OpenRouter API 密钥

- 访问OpenRouter.ai并注册

- 创建API KEY

选项:在账户设置中设置支出限制。

步骤 2:将 Cline 设置为 OpenRouter 使用

- 在 VS Code 中打开 Cline 的设置

- 选择作为 API 提供者的“OpenAI-Compatible”

- 将基础 URL 设置为

https://openrouter.ai/api/v1 - 粘贴 OpenRouter API 密钥

- 在模型 ID字段中输入

deepseek/deepseek-chat

步骤 3:测试集成

向 Cline 询问编码问题并确认设置:

如果设置正确,DeepSeek R1 将在 Cline 的接口上生成带注释的代码。

为什么选择 OpenRouter?

- 多模型访问:轻松切换 DeepSeek R1 和其他模型

- 成本透明度:在一个仪表板上跟踪所有模型的令牌使用量

- 回退支持:当 DeepSeek R1 的 API 过载时,自动将请求路由到备份模型

与成本相关的考虑事项

OpenRouter 的 DeepSeek R1 的价格接近直接 API 成本,但请始终检查实时费用。对于重度用户,OpenRouter 的统一账单简化了费用管理。

优化性能的专业提示

1. 模型大小和硬件

| 模型 | 必要的 RAM | 推奨GPU |

|---|---|---|

| 1.5B | 4GB | 综合型 |

| 7B | 8–10GB | NVIDIA GTX 1660 |

| 14B | 16GB+ | RTX 3060/3080 |

| 70B | 40GB+ | RTX 4090/A100 |

提示:量子化的模型(例如:Q4_K_M.gguf)可以将 VRAM 使用量减少 30%,且几乎没有质量的显著下降。

2. 提示工程

- 代码用:例如“使用 Python 3.11 和类型提示”的明确指示。

- 调试用:粘贴错误日志并询问“请解释并修复此错误”

常见问题的故障排除

1. 回复慢

- 修正:切换到小模型,或使用

OLLAMA_GPU_LAYERS=12在 Ollama 中启用 GPU 加速

2. 幻觉和不相关的回答

- 修正:使用更严格的提示,或升级到像

32B这样的更大模型

3. Cline 忽略文件上下文

- 修正:始终提供完整的文件路径(例如:

/src/components/Login.jsx),避免模糊的引用。

总结

DeepSeek R1 和 Cline 不仅仅是工具,而是一种范式转变。可以以零成本获得 GPT-4 级别的智能,完全控制隐私,实现与高级开发者配对的工作流程。

你准备好加强编码了吗?

- 安装 Cline 和 Ollama

- 选择 DeepSeek R1 模型

- 把精彩的东西做出来,告诉我怎么样!

最后读完,谢谢您!

希望您阅读本文后能有所理解!

5501

5501

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?