Hive从0.14版本开始支持事务和行级更新,但缺省是不支持的,需要一些附加的配置。要想支持行级insert、update、delete,需要配置Hive支持事务。

一、Hive具有ACID语义事务的使用场景

1. 流式接收数据。

许多用户使用诸如Apache Flume、Apache Storm或Apache Kafka这样的工具将流数据灌入Hadoop集群。当这些工具以每秒数百行的频率写入时,Hive也许只能每15分钟到1小时添加一个分区,因为过于频繁地添加分区很快就会使一个表中的分区数量难以维护。而且这些工具还可能向已存在的分区中写数据,但是这样将会产生脏读(可能读到查询开始时间点以后写入的数据),还在这些分区的所在目录中遗留大量小文件,进而给NameNode造成压力。在这个使用场景下,事务支持可以获得数据的一致性视图同时避免产生过多的文件。

2. 缓慢变化维。

在一个典型的星型模式数据仓库中,维度表随时间的变化很缓慢。例如,一个零售商开了一家新商店,需要将新店数据加到商店表,或者一个已有商店的营业面积或其它需要跟踪的特性改变了。这些改变会导致插入或修改个别记录。从0.14版本开始,Hive支持行级更新。

3. 数据重述。

有时发现数据集合有错误并需要更正。或者当前数据只是个近似值(如只有全部数据的90%,得到全部数据会滞后)。或者业务业务规则可能需要根据后续事务重述特定事务(打个比方,一个客户购买了一些商品后又购买了一个会员资格,此时可以享受折扣价格,包括先前购买的商品)。或者一个客户可能按照合同在终止了合作关系后要求删除他们的客户数据。从Hive 0.14开始,这些使用场景可以通过INSERT、UPDATE和DELETE支持。

二、配置Hive支持事务(Hive 2.0版)

1. 在hive-site.xml文件中添加如下配置项

2. 添加Hive元数据(使用mysql存储)

说明:初始时这三个表没有数据,如果不添加数据,会报以下错误:

org.apache.hadoop.hive.ql.lockmgr.DbTxnManager FAILED: Error in acquiring locks: Error communicating with the metastore

三、测试

1. 启动hadoop集群和mysql

2. 建立测试表

说明:建表语句必须带有into buckets子句和stored as orc TBLPROPERTIES ('transactional'='true')子句,并且不能带有sorted by子句。

3. 测试insert、update、delete

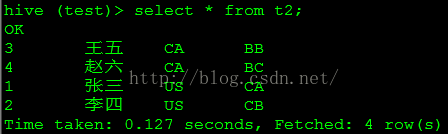

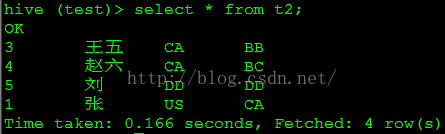

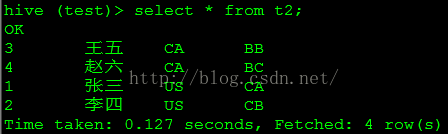

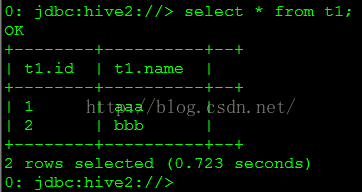

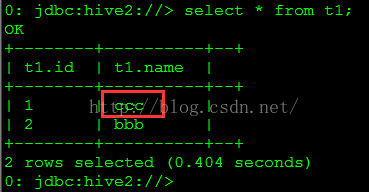

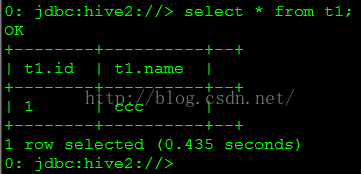

执行结果分别如图1-3所示。

说明:不能修改bucket列的值,否则会报以下错误:

FAILED: SemanticException [Error 10302]: Updating values of bucketing columns is not supported. Column id.

说明:不能update分区键,否则会报以下错误:

FAILED: SemanticException [Error 10292]: Updating values of partition columns is not supported

四、参考

https://cwiki.apache.org/confluence/display/Hive/Hive+Transactions

https://cwiki.apache.org/confluence/display/Hive/LanguageManual+DML#LanguageManualDML-Delete

http://unmeshasreeveni.blogspot.in/2014/11/updatedeleteinsert-in-hive-0140.html

https://www.mapr.com/blog/hive-transaction-feature-hive-10

一、Hive具有ACID语义事务的使用场景

1. 流式接收数据。

许多用户使用诸如Apache Flume、Apache Storm或Apache Kafka这样的工具将流数据灌入Hadoop集群。当这些工具以每秒数百行的频率写入时,Hive也许只能每15分钟到1小时添加一个分区,因为过于频繁地添加分区很快就会使一个表中的分区数量难以维护。而且这些工具还可能向已存在的分区中写数据,但是这样将会产生脏读(可能读到查询开始时间点以后写入的数据),还在这些分区的所在目录中遗留大量小文件,进而给NameNode造成压力。在这个使用场景下,事务支持可以获得数据的一致性视图同时避免产生过多的文件。

2. 缓慢变化维。

在一个典型的星型模式数据仓库中,维度表随时间的变化很缓慢。例如,一个零售商开了一家新商店,需要将新店数据加到商店表,或者一个已有商店的营业面积或其它需要跟踪的特性改变了。这些改变会导致插入或修改个别记录。从0.14版本开始,Hive支持行级更新。

3. 数据重述。

有时发现数据集合有错误并需要更正。或者当前数据只是个近似值(如只有全部数据的90%,得到全部数据会滞后)。或者业务业务规则可能需要根据后续事务重述特定事务(打个比方,一个客户购买了一些商品后又购买了一个会员资格,此时可以享受折扣价格,包括先前购买的商品)。或者一个客户可能按照合同在终止了合作关系后要求删除他们的客户数据。从Hive 0.14开始,这些使用场景可以通过INSERT、UPDATE和DELETE支持。

二、配置Hive支持事务(Hive 2.0版)

1. 在hive-site.xml文件中添加如下配置项

2. 添加Hive元数据(使用mysql存储)

说明:初始时这三个表没有数据,如果不添加数据,会报以下错误:

org.apache.hadoop.hive.ql.lockmgr.DbTxnManager FAILED: Error in acquiring locks: Error communicating with the metastore

三、测试

1. 启动hadoop集群和mysql

2. 建立测试表

说明:建表语句必须带有into buckets子句和stored as orc TBLPROPERTIES ('transactional'='true')子句,并且不能带有sorted by子句。

3. 测试insert、update、delete

执行结果分别如图1-3所示。

图1

图2

图3

说明:不能修改bucket列的值,否则会报以下错误:

FAILED: SemanticException [Error 10302]: Updating values of bucketing columns is not supported. Column id.

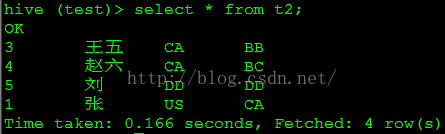

4. 已有非ORC表的转换

-- 在本地文件/home/grid/a.txt中写入以下4行数据

1,张三,US,CA

2,李四,US,CB

3,王五,CA,BB

4,赵六,CA,BC

图4

图5

说明:不能update分区键,否则会报以下错误:

FAILED: SemanticException [Error 10292]: Updating values of partition columns is not supported

四、参考

https://cwiki.apache.org/confluence/display/Hive/Hive+Transactions

https://cwiki.apache.org/confluence/display/Hive/LanguageManual+DML#LanguageManualDML-Delete

http://unmeshasreeveni.blogspot.in/2014/11/updatedeleteinsert-in-hive-0140.html

https://www.mapr.com/blog/hive-transaction-feature-hive-10

2837

2837

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?