目录:

1、将HDFS备份数降低

2、删除无用HDFS数据和Hbase表格

3、设置kafka的日志时间

4、删除本机无用文件

5、清理Trash回收站

6、Balancer重新平衡

7、Cloudera监控日志清理

8、查看一级目录大小

1、将备份数降低

1)将默认的备份数3设置为2。

步鄹:CDH–>HDFS–>配置–>复制因子–>设置为2

2)执行命令: hadoop fs -setrep 2 path(记住为根目录 / )

3)重启hdfs

4)结果如下:

2、删除无用HDFS数据和Hbase表格

查看HDFS上面文件每个文件大小

hdfs dfs -du -h /

可以删除的文件

hdfs dfs -du -h /user/spark/applicationHistory

hdfs dfs -rmr /user/root/.Trash

3、设置kafka的日志时间

4、删除本机无用文件

下面是我写的一个shell脚本,可以查看所有目录和文件的大小,将大的无用文件删除

#!/bin/bash

path=$1

dir=$(ls -l $path |awk '/^d/ {print $NF}')

for i in $dir

do

du -sh $path/$i

done

5、清理Trash回收站

HDFS 的Trash回收站功能的配置、使用

http://blog.csdn.net/silentwolfyh/article/details/53907118

**6、Balancer重新平衡 **

1)集群运行一段时间后各个节点的磁盘使用率可能会产生较大的差异,这时可以用balancer来重新平衡各个节点。

2)首先调大balancer的带宽 Hadoop dfsadmin -setBalancerBandwidth 52428800 ,这里设置为50MB。默认的带宽较小,防止占用太多资源。若需要快速平衡可以将带宽调为一个较大的值。

3)接着启动balancer。可以在CM里启动(hdfs-balancer-示例-操作-重新平衡),也可以命令启动(hadoop balancer [-threshold ])。

7、Cloudera监控日志清理

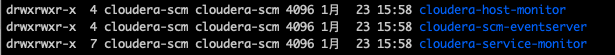

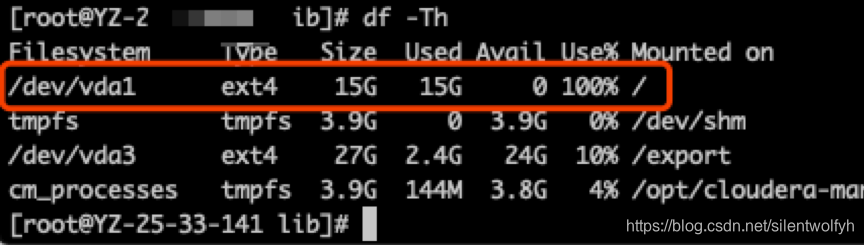

装cm的机器:/var/lib 路径下有如下文件:有时候根目录空间不够

解决方法一:主要清理cloudera-host-monitor 、cloudera-service-monitor

这两个文件下子目录带ts两个字母的目录下都会有partitions,直接清掉就ok

例:subject_ts、ts_subject、ts等带有ts的目录(慎重啊)

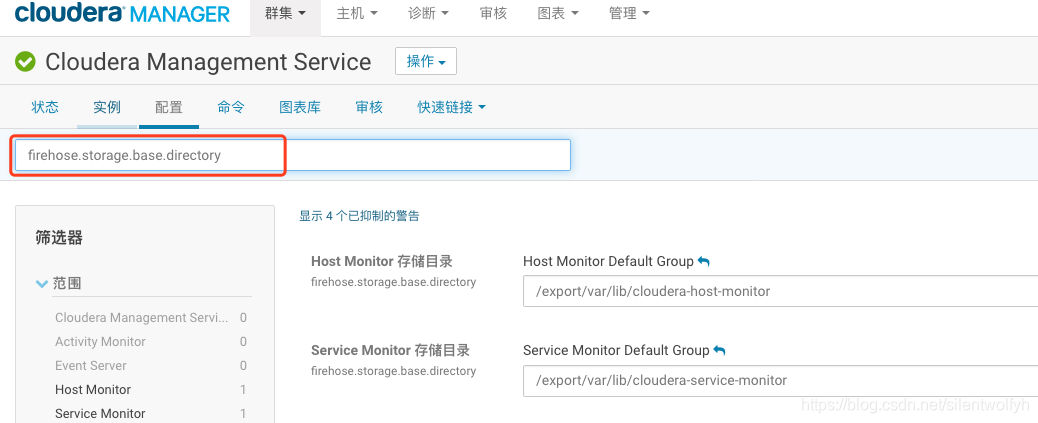

解决方法二:firehose.storage.base.directory,将路径设置到其余文件下

8、查看一级目录大小

du -h --max-depth=1 /

166

166

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?