1.有哪些有名的CNN实例

——classic networks

·LeNet-5(1980s)

·AlexNet

·VGG

——ResNet(Residual Network,残差网络,152层)

——Inception(谷歌,盗梦空间)

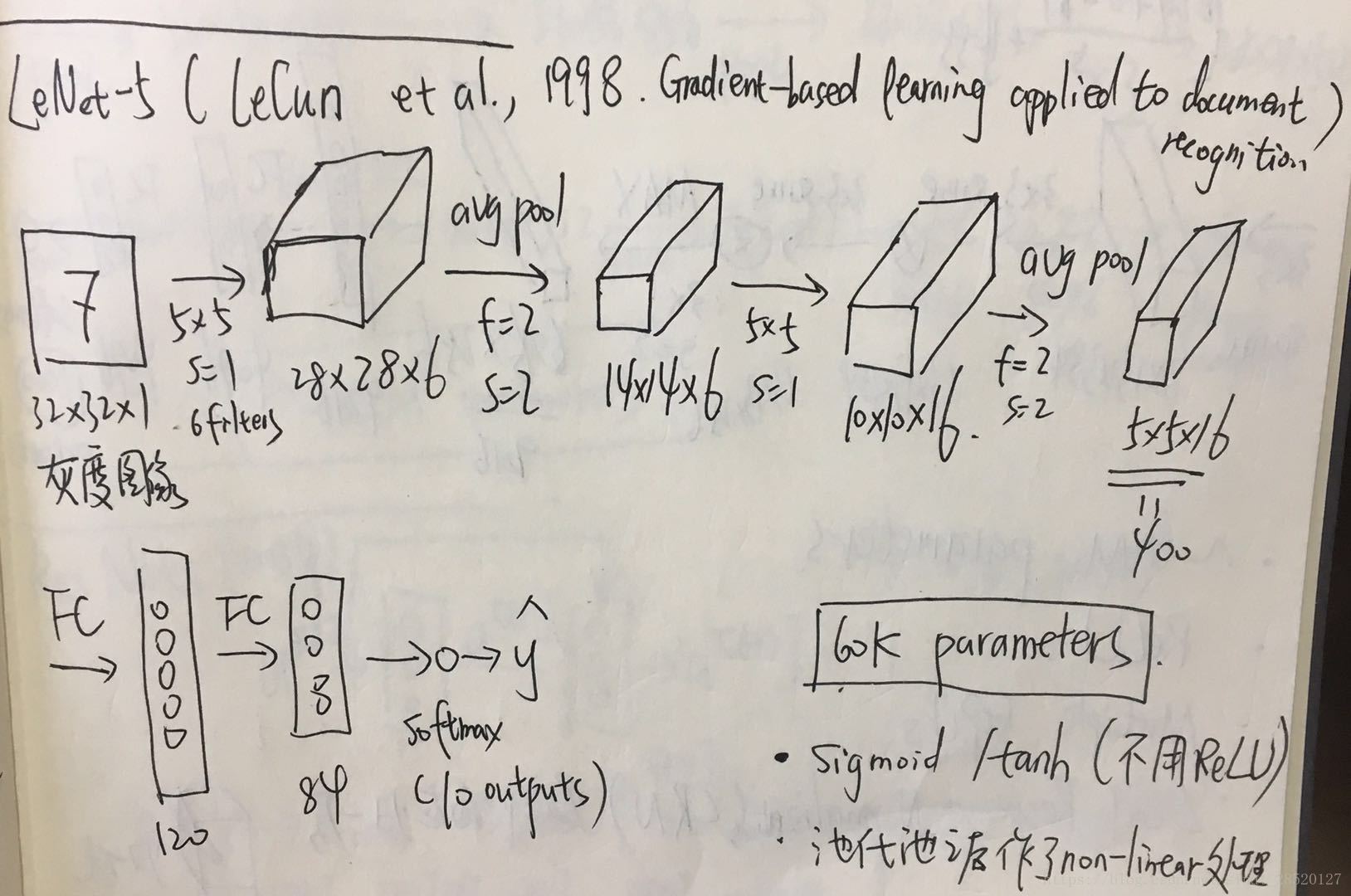

2.大神LeCun的LeNet-5

上个世界八十年代,LeCun搭建了针对灰度图像进行训练的LeNet-5,后来在论文LeCun et al.,1998. Gradient-based learning applied to document recognition中详细阐述,其大致架构如下所示:

其中大约有6万个参数。在那个年代,no padding,人们常用的是sigmoid和tanh函数,而如今ReLU是常用的非线性函数。

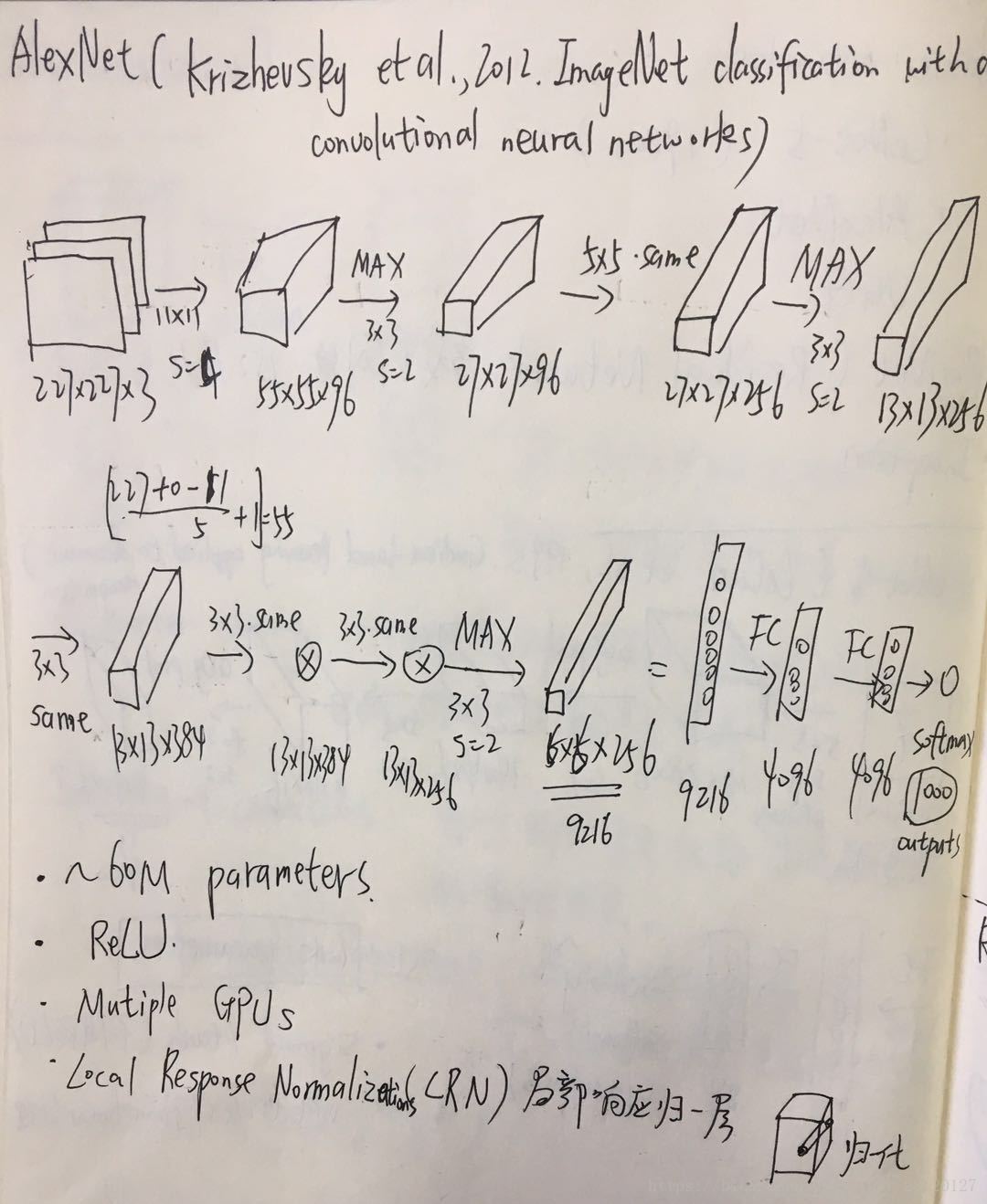

3.AlexNet

具体的架构和LeNet大致相似,但是更加庞大,大约有6千万个参数,如下图所示:

——使用了padding,即same filter。

——使用了ReLU激活函数

——两个GPUs之间相互协作

——使用LRN(局部响应归一层),即在激活值构成的立方体沿着通道的数值进行归一化操作。

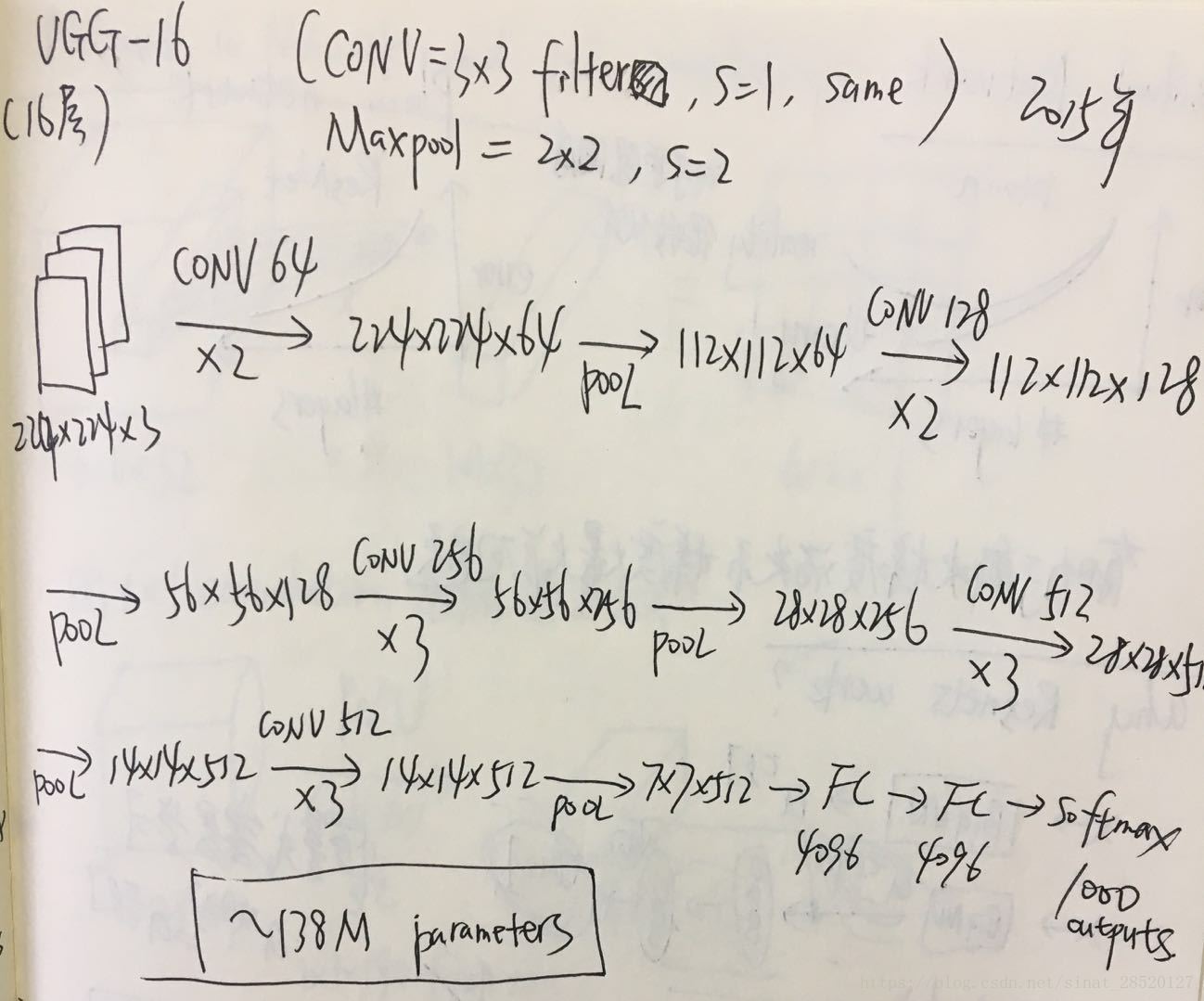

4.VGG-16

这是一个没有那么多超级参数(不需要关注f,s,p等),只关注有规律地构建卷积层的深度CNN。大约有138M个参数,比AlexNet更大。

VGG网络的一大优点:结构很规整,共16个卷积层,卷积层过滤器的数量很有规律,从64翻倍至128至256至512。并且图片通过池化层缩小也有规律,每次缩小一半。使用了CONV为3*3的same的filter,s=1;使用了2*2的Maxpool,s=2。具体见下图:

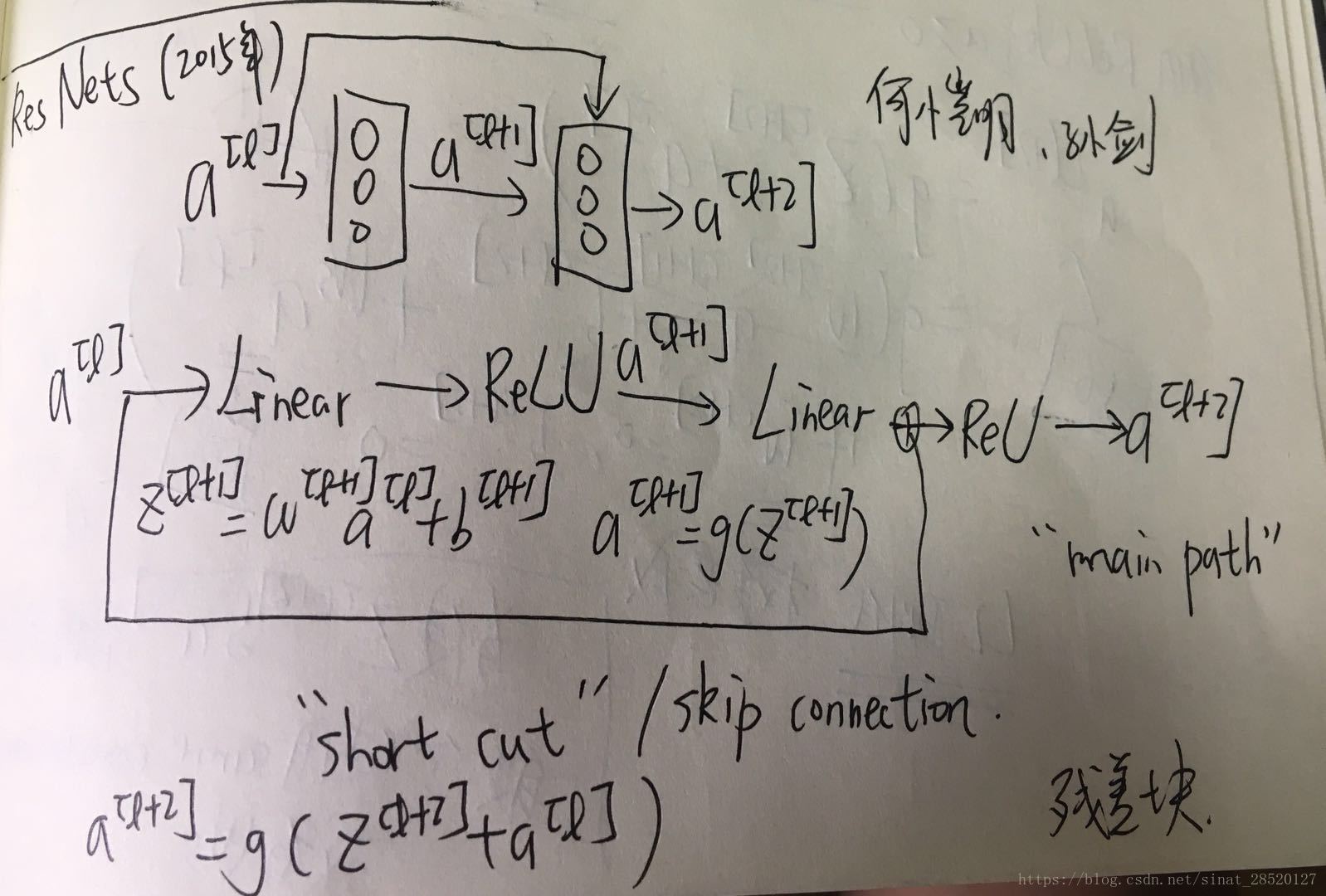

5.残差网络(ResNets)

利用跳远连接搭建更深的网络结构(152层)。由何恺明、孙剑等人提出。

其基础结构为残差块(Residual block)。具体见下图:

main path下的深层网络理论上随着层数的增加,训练误差越来越小;但是实际情况是由于很难优化,导致误差增大。而使用ResNets则可以消除这一情况。

ResNets还有助于解决梯度消失和梯度爆炸的问题。

2632

2632

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?