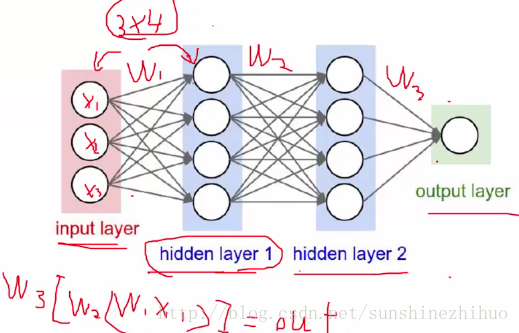

12.神经网络整体架构

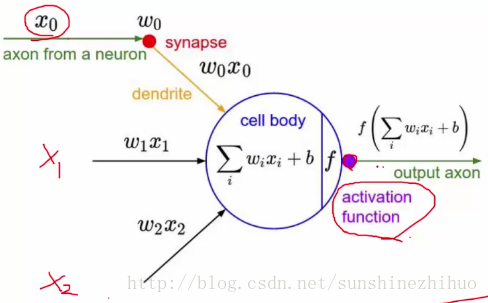

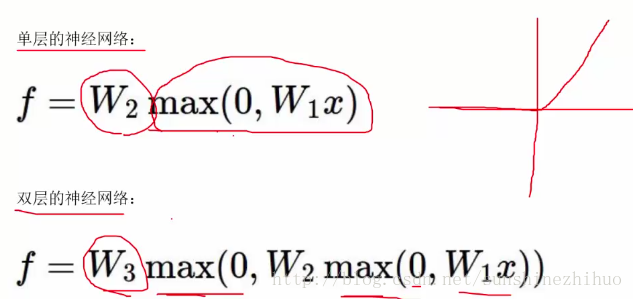

神经网络是层次结构,且是非线性的结构。那么需要指定哪些参数呢?

w1, w2, w3,要明确他们的大小。

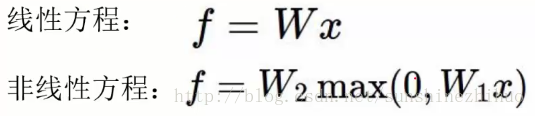

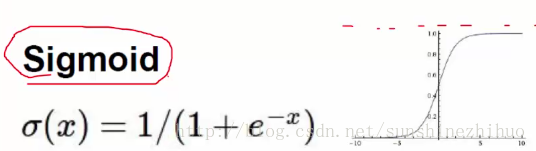

非线性的成立需要有激活函数(如sigmoid),使得神经网络的效果很好,表达出非常强大的效果。

13.神经网络模型实例演示

激活函数:使结果非线性

当求完的得分值,数值比较大或者比较小时,函数的导数值都很小,易发生梯度消失的现象,没法更新权值,没法反向传播,神经网络就收敛不了了。层次越多,梯度消失现象就越严重。

Sigmoid出现的问题:梯度消失

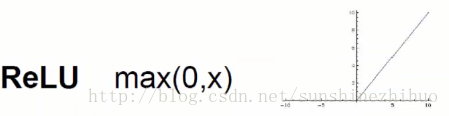

Relu激活函数的好处:能够解决梯度消失问题。

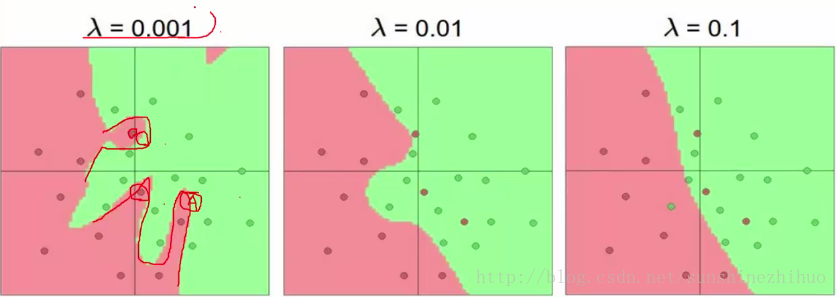

神经元的数量会影响最终的分类效果,神经元个数越多,通常情况下,网络模型的效果就越好。越多的神经元就越能表达越复杂的模型,但要提防过拟合现象。

14.过拟合问题解决方案

正则化项在神经网络中的作用:

λw2

λ

w

2

,

λ

λ

表明了对参数w的惩罚力度。合理的

λ

λ

可以增强神经网络的泛化能力。

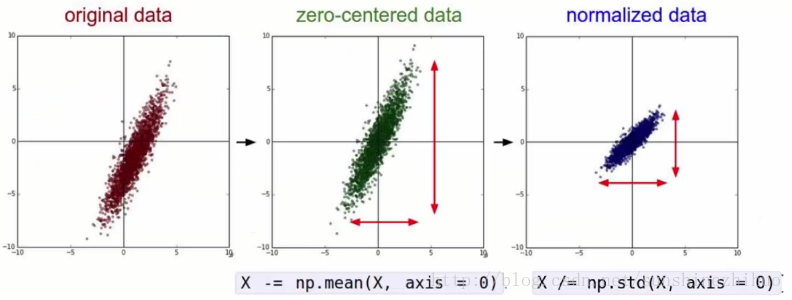

数据预处理

归一化数据:减去均值(以0为中心的数据),除以标准差。

权重初始化:采用高斯初始化或者随机初始化,不能采用全零值初始化,即不能拿常值初始化。

对于偏置b而言,采用0值初始化即可,用常值初始化是没有问题的。

W = 0.01 * np.random.randn(D,H)Drop Out:

对于全连接来说,过拟合的风险很高。

解决方法:每次迭代时,随机drop out。这种做法非常常见。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?