问题导读:

1.hdfs中的建立的目录. 表与目录的关系式什么?一个表是否对应一个目录?

2.-ROOT-表和.META对应几个文件?

3.splitlog和.corrupt目录是用来做什么的?

4.通过http查看文件,需要配置那个文件?

为了查看HBASE表在HDFS中的文件结构.

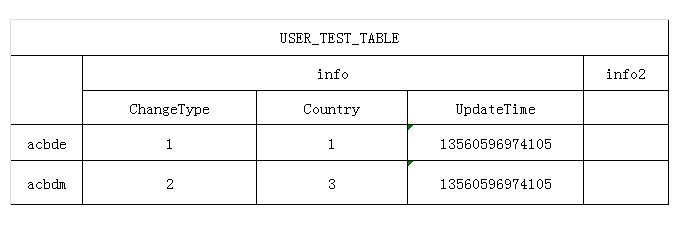

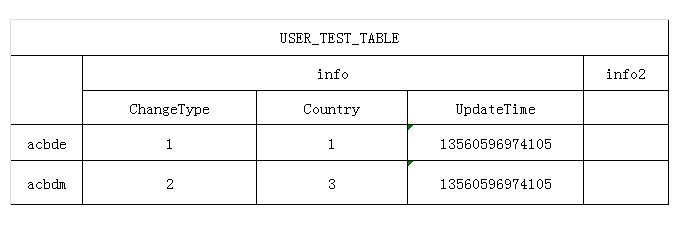

在HBASE中建立一张表结构如下:

结构图如下, 往下表插入测试数据, 下面查看此表在HDFS中文件的存储方式.

由于在HBase服务器配置文件中指定的存储HBase文件的HDFS地址为:

hdfs://HADOOPCLUS01:端口/hbase

登录到namenode服务器,这里为HADOOPCLUS01, 用hadoop命令查看hbase在hdfs中此表的文件.

1. 查看Hbase根目录.

可以看到所有表的信息. 在hdfs中的建立的目录. 一个表对应一个目录.

-ROOT-表和.META.表也不例外, -ROOT-表和.META.表都有同样的表结构, 关于两表的表结构和怎么对应HBase整个环境的表的HRegion, 可以查看上篇转载的文章.

splitlog和.corrupt目录分别是log split进程用来存储中间split文件的和损坏的日志文件的。

.logs和.oldlogs目录为HLog的存储.

.oldlogs为已经失效的HLog(Hlog对HBase数据库写Put已经全部完毕), 后面进行删除.

HLog File 是一个Sequence File,HLog File 由一条条的 HLog.Entry构成。可以说Entry是HLog的基本组成部分,也是Read 和Write的基本单位。

Entry由两个部分组成:HLogKey和WALEdit。

2. 查看建立表hdfs目录内容:

有两个目录, 说明此表已经分裂成两个HRegion.

3. 在查看其中一个HRegion的文件目录.

.regioninfo 此HRegion的信息. StartRowKey, EndRowKey. 记录Region在表中的范围信息.

info, info2, 两个ColumnFamily. 为两个目录.

4. 再对.regioninfo文件用cat查看内容:

乱码已经过滤, 存储的信息整理:

5. 查看info ColumnFamily中信息文件和目录:

6. 查看具体保存HBase数据的HDFS文件信息:

即是上面图片中插入的其中一部分数据.

在HBase中存储时, 对于每个Qualifer有如下5个属性RowKey, ColumnFamily, Qualifer, TimeStamp, Value.

# AA-AAA11110UDH 部分对应RowKey;

# info对应了ColumnFamily;

# Country对应Qualifer;

# 1对用Value;

# 13560596974000对应TimeStamp.

后面将分析RowKey与AA-AAA11110UDH的对应关系.

7. 使用HTTP查看文件:

在上面命令中, 也可以有Http查看Hdfs中的文件, 配置在hdfs-site.xml下面配置:

所以访问HDFS的HTTP的URL为:

1.hdfs中的建立的目录. 表与目录的关系式什么?一个表是否对应一个目录?

2.-ROOT-表和.META对应几个文件?

3.splitlog和.corrupt目录是用来做什么的?

4.通过http查看文件,需要配置那个文件?

为了查看HBASE表在HDFS中的文件结构.

在HBASE中建立一张表结构如下:

结构图如下, 往下表插入测试数据, 下面查看此表在HDFS中文件的存储方式.

由于在HBase服务器配置文件中指定的存储HBase文件的HDFS地址为:

hdfs://HADOOPCLUS01:端口/hbase

登录到namenode服务器,这里为HADOOPCLUS01, 用hadoop命令查看hbase在hdfs中此表的文件.

1. 查看Hbase根目录.

可以看到所有表的信息. 在hdfs中的建立的目录. 一个表对应一个目录.

-ROOT-表和.META.表也不例外, -ROOT-表和.META.表都有同样的表结构, 关于两表的表结构和怎么对应HBase整个环境的表的HRegion, 可以查看上篇转载的文章.

splitlog和.corrupt目录分别是log split进程用来存储中间split文件的和损坏的日志文件的。

.logs和.oldlogs目录为HLog的存储.

.oldlogs为已经失效的HLog(Hlog对HBase数据库写Put已经全部完毕), 后面进行删除.

HLog File 是一个Sequence File,HLog File 由一条条的 HLog.Entry构成。可以说Entry是HLog的基本组成部分,也是Read 和Write的基本单位。

Entry由两个部分组成:HLogKey和WALEdit。

2. 查看建立表hdfs目录内容:

有两个目录, 说明此表已经分裂成两个HRegion.

3. 在查看其中一个HRegion的文件目录.

.regioninfo 此HRegion的信息. StartRowKey, EndRowKey. 记录Region在表中的范围信息.

info, info2, 两个ColumnFamily. 为两个目录.

4. 再对.regioninfo文件用cat查看内容:

乱码已经过滤, 存储的信息整理:

5. 查看info ColumnFamily中信息文件和目录:

6. 查看具体保存HBase数据的HDFS文件信息:

即是上面图片中插入的其中一部分数据.

在HBase中存储时, 对于每个Qualifer有如下5个属性RowKey, ColumnFamily, Qualifer, TimeStamp, Value.

# AA-AAA11110UDH 部分对应RowKey;

# info对应了ColumnFamily;

# Country对应Qualifer;

# 1对用Value;

# 13560596974000对应TimeStamp.

后面将分析RowKey与AA-AAA11110UDH的对应关系.

7. 使用HTTP查看文件:

在上面命令中, 也可以有Http查看Hdfs中的文件, 配置在hdfs-site.xml下面配置:

所以访问HDFS的HTTP的URL为:

4407

4407

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?