Logistic回归模型

Logistic分布

Logistic分布的定义如下。

设 X 是连续随机变量,

X 服从Logistic分布是指 X 具有下列分布函数和密度函数。

F(x)=P(X≤x)=11+e−(x−μ)/γ

f(x)=F′(x)=e−(x−μ)/γγ(1+e−(x−μ)/γ)2

式中, μ 为位置参数, γ>0 为形状参数。

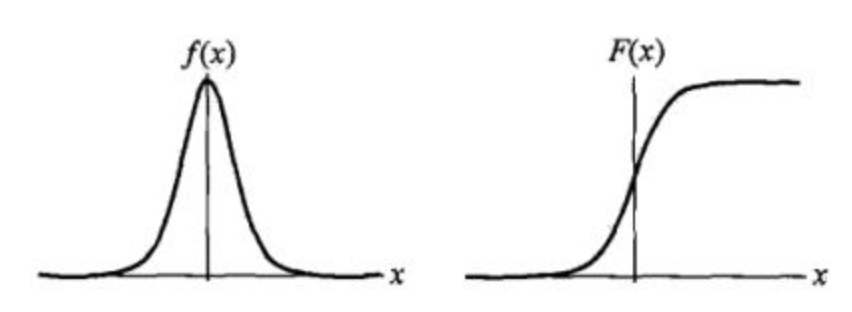

Logistic分布的密度函数

f(x)

和分布函数

F(x)

的图形如下所示。

分布函数是关于点

(μ,12)

为中心对称,即满足:

F(−x+μ)−12=−F(x+μ)+12

曲线在中心附近增加速度较快,在两端增长速度较慢。形状参数

γ

的值越小,曲线在中心附近增长得越快。

联合界与Hoeffding不等式

联合界定理

定义:

令 A1,A2,...,Ak 是 k 个时间,这k 个事件可以相互独立也可以不相互独立,那么有下面结论:

P(A1∪A2∪...∪Uk)≤P(A1)+P(A2)+...+P(Ak)

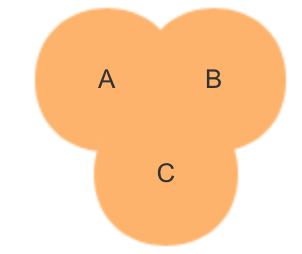

该定理可以用Venn图来表示如下。

圆A,B,C分别代表着事件A,B,C发生的概率,之间有重叠,所以ABC任意一个发生的概念是小于三者发生的概率之和的。

Hoeffding不等式

定义:令 Z1,Z2,...,Zk 为k个独立同分布变量,服从伯努利分布,即:

P(Zi=1)=φ,P(Zi=0)=1−φ

我们使用者m个变量的平均值来估计 φ ,得到

φ′=1m∑mi=1Zi

那么Hoeffding不等式的定义即为对于任意的固定数值 γ>0 ,存在:

P(|φ′−φ|)≤2e−2γ2m

意义:当样本足够大时,可以认为对参数的估计逼近真实值。

极大似然估计

信息论基本理论

信息论这门学科是香农建立的。笔者学习过这门课,学习完信息论,感觉信息论是一门哲学,很有意思。对于数学和信道编码有兴趣的读者可以学习下。

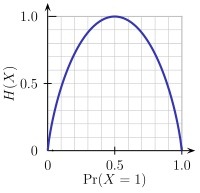

熵

熵表示的是随机变量不确定性的度量。

一个离散型随机变量

X

的熵

H(X)=−∑x∈χp(x)logp(x)

其中对数

log

所用的底是2,约定

0log0=0

关于熵的理解可以想一下掷硬币,当硬币均匀时,掷硬币的结果的不确定是最大的。因为它正反的概念都是0.5,此时它的熵最大。如下图所示。

联合熵

给出联合熵的定义:

对于服从联合分布为 p(x,y) 的一对离散随机变量 (X,Y) ,其联合熵 H(X,Y) 定义为: H(X,Y)=−∑x∈χ∑Y∈Y′p(x,y)logp(x,y)

注意:(Y的向量空间打不出来,我这里用Y’表示)

条件熵

给出条件熵的定义:

H(Y|X)=∑ni=1piH(Y|X=xi)

链式法则

H(X,Y)=H(X)+H(Y|X)

互信息

互信息一般用I来表示,互信息

I(X;Y)

是在给定Y知识的条件下

X

的不确定度的缩减量。

其公式为

I(X;Y)=H(X)−H(X|Y) 互信息的概念在李航统计学习方法中又称为

信息增益。本博文参考了:

1.李航《统计学习方法》,清华大学出版社

2.Thomas M. Cover Joy A. Thomas 《Information theory》

3.《数学分析》第三版,复旦大学。高等教育出版社。

425

425

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?