详解可以参考文章

一 、模型结构

逻辑回归实质是Linear线性函数(wx+b)与一个sigmoid函数的结合。

二、数据说明

数据来源:UCI German Credit分类数据,下载如下

https://archive.ics.uci.edu/ml/machine-learning-databases/statlog/german/

数据说明:24个属性数量,分类结果2种(label 1表示Good Man, label2表示 Bad Man)

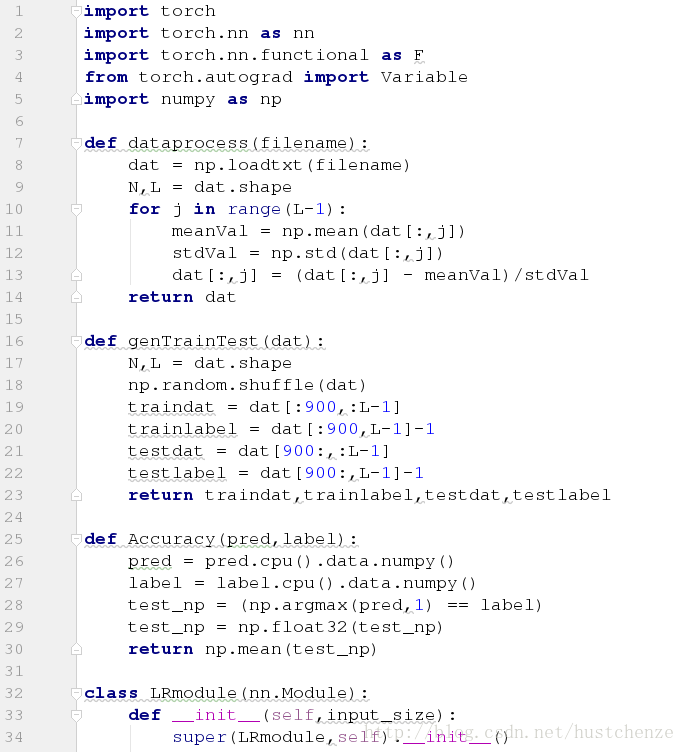

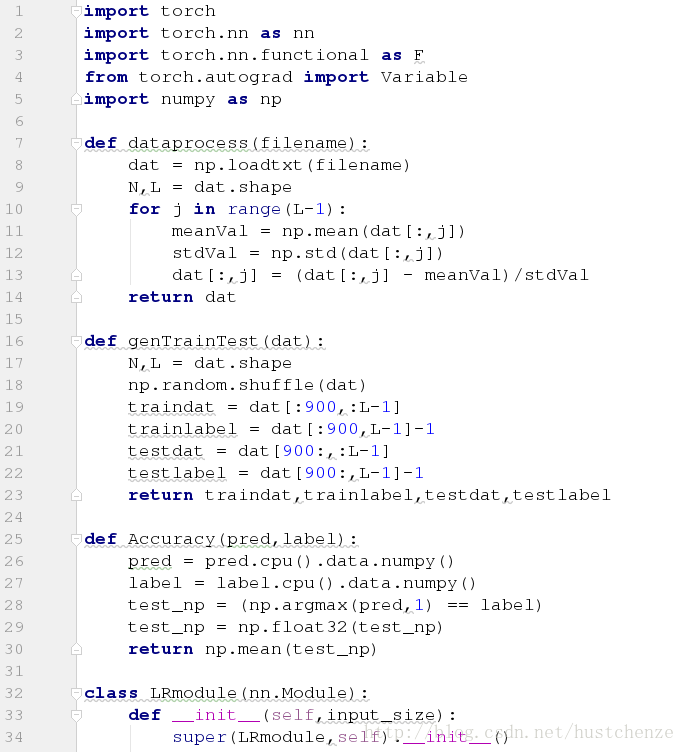

三、代码如下(截图,可直接运行)

详解可以参考文章

一 、模型结构

逻辑回归实质是Linear线性函数(wx+b)与一个sigmoid函数的结合。

二、数据说明

数据来源:UCI German Credit分类数据,下载如下

https://archive.ics.uci.edu/ml/machine-learning-databases/statlog/german/

数据说明:24个属性数量,分类结果2种(label 1表示Good Man, label2表示 Bad Man)

三、代码如下(截图,可直接运行)

332

332

1580

1580

3516

3516

8161

8161

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?