一.移动端深度学习的几种实现方式

(1)Caffe的移动端编译项目

caffe(命令式框架)算是在国内最流行的深度学习开源框架,使用它进行商业,研究的人很多。对于移动端的实现,也有开源项目对caffe进行了移植。

项目连接如下:

我认识的很多科研院所的朋友以及百度这种大公司他们,在移动端的本地项目中也使用了caffe-android,证明了该项目有很高的实用性。当然,我认为该项目存在的问题就是模型过大,速度性能很差;当前不支持GPU,无法做到实时;caffe是个通用的框架,调用了很多库,如果只需要做cnn的话,该项目还需要自我定制和瘦身。

(2)mxnet的移动端项目

mxnet(符号式框架)主要也是几个中国人一起发起和维护的深度开源项目,足够灵活,速度足够快,扩展新的功能比较容易,内存复用,很有潜力成为未来优秀的深度项目。最关键的是,mxnet本身提供了对android,ios移动端的的支持。而且最近,mxnet已经 被 Amazon AWS 选为官方深度学习平台。

项目连接如下:

本人也使用过该项目,其中的感想如下。

1) mxnet明显从本身特点就比caffe更适合移动端,因为依赖少,内存要求少,对于android性能变化大的手机,通用性更高。

2) mxnet需要先使用ndk交叉编译项目中的amalgamation,可以根据自己的需求,修改jni中的接口,然后,编译好的动态链接库替换掉android demo 中的。不过在编译过程中我遇到了很多的问题,编译成功也不是很简单的事情。

3)mxnet 提供了对caffe 模型的支持,那么即使你用caffe训练好的模型,也可以通过提供的工具讲其进行转化json格式,然后就可以在mxnet 上使用,自然也可以在移动端使用,不过我在使用过程中也遇到了一个问题,比如prelu激活函数,mxnet本身支持的,但是转化工具不支持,所以,我训练的caffe模型一直转化不成功,但是最后改了工具的源码,就解决了这个问题。当然,mxnet提供的caffe_converter是很多坑的,很多模型都转化不成功,这个如果对caffe模型很熟悉的话,这些问题也许很容易解决。

(3)tensorflow的移动端项目

tensorflow是google开源的,是最有竞争力成为未来深度框架的主流。而且,对android端的支持也是官方提供的,毕竟google公司自己的os。

简单总结

除了以上介绍的深度框架,还有torch

以上框架都是很流行,很通用的,自然带来的问题就是,过于庞大对于android系统来说,所以,如果要实现一个相对单一的深度算法,那么,我们必须需要对其进行瘦身。移动端,在不需要实时的项目中,对gpu的要求不高,但是如果能提供对gpu的支持,那么项目的性能自然可以提高很多,但是,大部分android端手机,gpu不支持cuda,所以以上介绍的深度框架,只能使用cpu-only模型进行前向传播,不过为了能利用到gpu,有一个解决方案是使用opencl进行gpu加速。我这个没有尝试过,有兴趣的人可以看下这个开源项目。

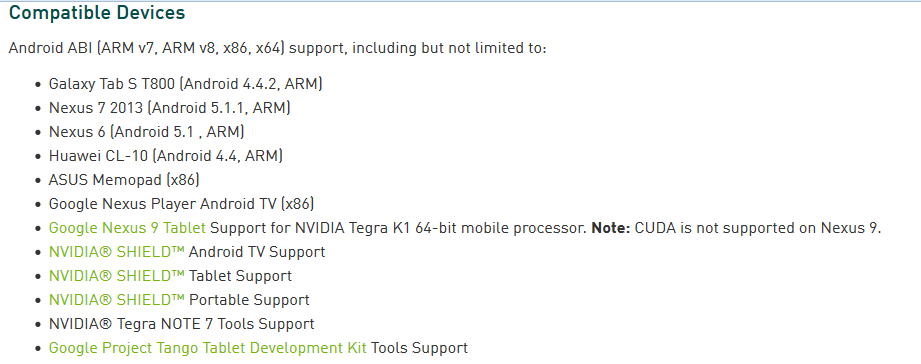

当然,最新的nvidia 提供了android端的gpu开发接口。

而且支持非Nvidia的Tegra处理器的Android设备和支持各个版本的Android系统。

二.tiny-cnn的移动端移植

tiny-cnn相对于上述的开源深度框架来说就小的多,而且是完全的c++11版本的卷积神经网络的实现,这个开源项目维护的人也很多,本人也参与到其中。

本人对tiny-cnn进行了android端的移植,做了开源项目,而且,本身tiny-cnn支持caffe模型的转化,所以,最新的android版本也支持了caffe模型。

开源项目地址和详细介绍如下。

tinycnn for android 的优缺点。

| 优缺点 | 内容 |

|---|---|

| 优点 | 易于理解和修改,对于小模型的支持更好。android端是完全的一个eclispe 工程,依赖库除了opencv其他基本配置好。提供了完全的jni源码;提供了对caffe模型的支持 |

| 缺点 | 不能很好支持大模型(需要的内存过大,例如vgg当前是跑不起来的);有些类型的层不支持,例如prelu;当前只支持cnn模型 |

三.专注移动端的Caffe2go项目

在手机端一直深度学习的算法,估计很多实验室和科技公司早就做了,不过很多估计是不开源的。

11月9号,贾扬清在facebook上发布了一篇文章,关于手机深度学习项目caffe2go的详细介绍和应用。项目是专门为手机定制的深度框架,是在caffe2 的基础上进行迁移的,目的就是让最普遍的智能设备——手机也能广泛高效地应用深度学习算法。

关于caffe2的,介绍:

Caffe2 is a deep learning framework made with expression, speed, and modularity in mind. It is an experimental refactoring of Caffe, and allows a more flexible way to organize computation.

Github链接:

https://github.com/caffe2/caffe2

当然,caffe2go有一下几个特点:

(1)专注手机端

之前说了,真正做到手机端是很简单的事情,关键就是技术优化。

caffe2go的给的测试是风格化转换的实时处理。关于优化,文章说明了几点。

- 模型压缩

- 通过使用移动 CPU 中被称为 NEON 的功能,可以显著提高运算速度

- 模型中,优化了卷积层的数量

- 调整了处理过程中的空间分辨率(spatial resolution),更早地使用pooling层。

有几点是很难理解的。只能等待caffe2go尽快发布。

(2)CPU而非GPU

我们都知道印象中的深度学习是离不开GPU的,及时只是运行模型,而且是实时的情况下。caffe2go在手机端,是运行在cpu下的,这就能保证了框架的普遍适用性。毕竟对于Android手机来说,并没有统一的硬件标准,也没有统一的GPU型号,所以就很难做到一个框架支持所有手机。这应该是facebook选择使用cpu而非GPU的一个原因。

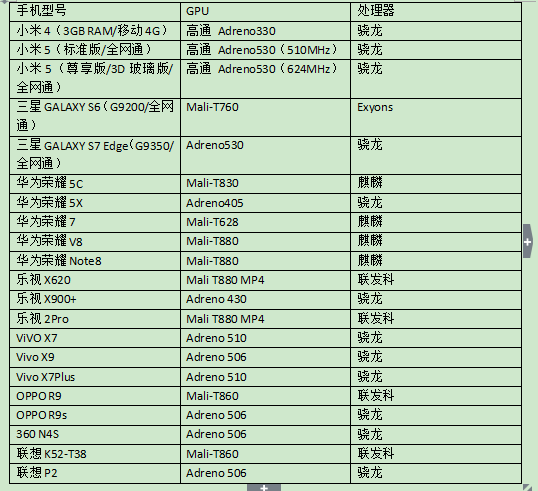

关于当前主流手机的GPU型号。看一下列表。

值得注意的是,当前,嵌入式设备(Android手机等)的GPU,实际上要比CPU要慢得多。所以,估计贾应该也做了GPU的,但是效果不好,因此并没有强调。

(3)强调本地,而非云。

我们都知道,关于深度学习的处理,完全可以不通过本地调用,而是远程获取,但是通过caffe2go的目标,则与此相反。他们认为随着硬件的发展,本地的运算消耗是要比远程请求更节约时间,更方便的。

四.总结与未来改进

-

总结

以上提到的方式都有优缺点,可以根据自己的项目定位和需求进行选择。如果模型不大,tiny-cnn 的 android版本还是很适合的。当然,如果论未来的话,我个人比较推崇tensorflow,毕竟google是干爹。还有就是关注caffe2go开源情况。总的来说,移动平台必然是以后深度学习算法的一个广泛的应用平台。

-

项目改进

本人对tiny-cnn移植的工作,未来的改进,大概就是提供对更多的层的支持,以及使用opencl来进行gpu加速。整个项目,将改成makefile编译的形式。

四.应用截图

我的开源项目,提供了两个分类的例子,一个是使用tiny-cnn自己训练的模型——车标识别;一个是使用caffe训练的模型——性别识别。具体看github链接。

项目地址: cnnforandroid

1867

1867

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?