模型结构

CBOW模型,中文译为“连续词袋模型”,完成的任务是给定中心词

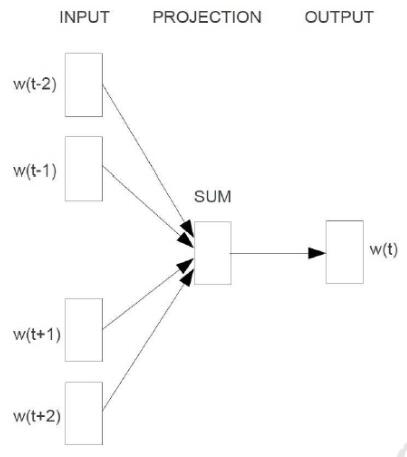

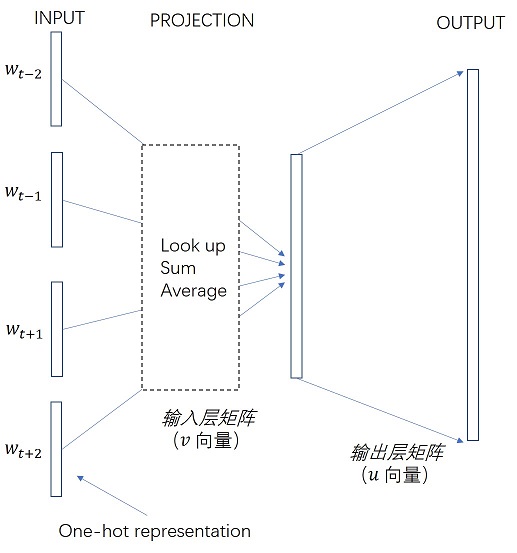

在上面的结构示意图中,符号w(t-1),w(t-2),w(t+1),w(t+2) 表示输入的单词,实际是一个one-hot的vector,通过构建词典,建立单词索引可以很容易实现,向量的维度和词典中单词数目相同,只有一个维度的值为1,该维度对应该单词在词典索引中的位置,其余维度的值为0。其中的PROJECTION层是通过查表得到的,首先初始化一个words vector矩阵W,W是一个二维的矩阵,行数等于构建的词典中的单词的数目,依赖具体语料库大小等因素,列数是一个超参数,人为设定,一般为100;论文中给出的结构图太简单,我自己画了一个,如下:

输入是中心词

将one-hot编码的向量

公式详解每一步操作

1、查表(lookup) 从单词到向量

对

这是一个(n x 1) 的矩阵和一个(n x d)的矩阵之间的矩阵乘法,得到的是一个(1 x d)的向量

2、求和平均(sum and average)

上一步通过lookup,得出了中心词

这里做一下说明,论文中给出的求和后取平均值,可以看成是四个上下文

3、输出(output)

这一步需要计算的是由

由于经过lookup层后,上下文单词

由于给定上下文时,不止是只能生成中心词,还能生成整个词典中的任何一个单词,只是生成的概率没有中心词概率大,我们用一个通用的公式表示如下:

表示给定上下文单词

其中,表示词典的大小,

就是上下文单词的词向量,因为

和

看成是一个单词的两套词向量,即

模型的损失函数及优化

在讲解CBOW模型的损失函数和参数优化前,可以先看看训练数据是什么样子的。假设训练数据是一段文本,长度为T,则在CBOW模型下,训练样本的格式如下:

训练数据是从长度为T的文本中抽取的,可以抽取很多个上式表达的训练数据。有训练数据,同时我们又建立了概率模型,那么我们就可以定义一个似然函数,使得训练集中样本的似然概率最大。

生成这一段文本的似然概率如下:

其中,

将具体的概率公式替换。可得

这个cost fucntion是关于

4622

4622

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?