点云PCL免费知识星球,点云论文速读。

文章:RGB-L: Enhancing Indirect Visual SLAM using LiDAR-based Dense Depth Maps

作者:Florian Sauerbeck, Benjamin Obermeier, Martin Rudolph

编辑:点云PCL

代码:https://github.com/TUMFTM/ORB_SLAM3_RGBL.git

欢迎各位加入免费知识星球,获取PDF论文,欢迎转发朋友圈。文章仅做学术分享,如有侵权联系删文。未经博主同意请勿擅自转载。

公众号致力于点云处理,SLAM,三维视觉,高精地图等领域相关内容的干货分享,欢迎各位加入,有兴趣的可联系dianyunpcl@163.com。未经作者允许请勿转载,欢迎各位同学积极分享和交流。

摘要

本文提出了一种基于RGB-D模式将3D激光雷达深度信息集成到现有ORBSLAM3中的新方法。我们提出并比较了两种深度图生成方法:传统的计算机视觉方法,即逆膨胀操作和基于监督深度学习的方法。通过添加直接读取激光雷达点云的所谓RGB-L(LiDAR)模式,将前者直接集成到ORB-SLAM3框架中。在KITTI里程表数据集上评估了所提出的方法,并将其与标准ORB-SLAM3双目方法进行了比较。我们证明根据环境,可以实现轨迹精度和鲁棒性方面的优势。此外我们还证明了与双目模式相比,ORB-SLAM3算法的运行时间可以减少40%以上。ORB-SLAM3 RGB-L模式的相关代码将作为开源软件在

https://github.com/TUMFTM/ORB_SLAM3_RGBL.git

主要贡献

自动驾驶汽车软件的所有模块,如路径规划、轨迹跟踪或目标预测,都需要鲁棒和精确的定位,为了实现完全的自动驾驶能力,依赖基于卫星的全球定位系统是不可行的。首先,这种传感器价格昂贵;第二,传感器失效会导致随后的系统故障。因此,同时定位和建图(SLAM)算法在开发机器人和自动驾驶车辆中非常重要。这些算法可以通过仅使用环境的传感器测量来提供精确的机器人姿态,因此提供了一种重要的定位技术。为了实现稳健的SLAM算法,需要包括来自各种传感器(如激光雷达和照相机)的环境信息。由于所有传感器都有各自的优点和缺点,因此传感器融合可以为自动驾驶汽车的定位带来好处。本文对众所周知的ORB-SLAM3算法进行了改进。目前,该算法仅依赖于相机数据来计算机器人的位姿。目标是利用LiDAR传感器深度测量信息增强该算法,以实现更高的定位精度和更好的鲁棒性,例如在城市环境中。总之,本文包括四个主要贡献:

提出了一种将LiDAR深度测量值集成到现有ORB-SLAM3算法中的方法。

提出并比较了两种从LiDAR点云生成稠密深度图的方法

为自动驾驶汽车的定位提供了各种实验,证明了我们方法的准确性和鲁棒性。

比较了运行时间,并显示与双目模式相比减少了40%以上。

主要内容

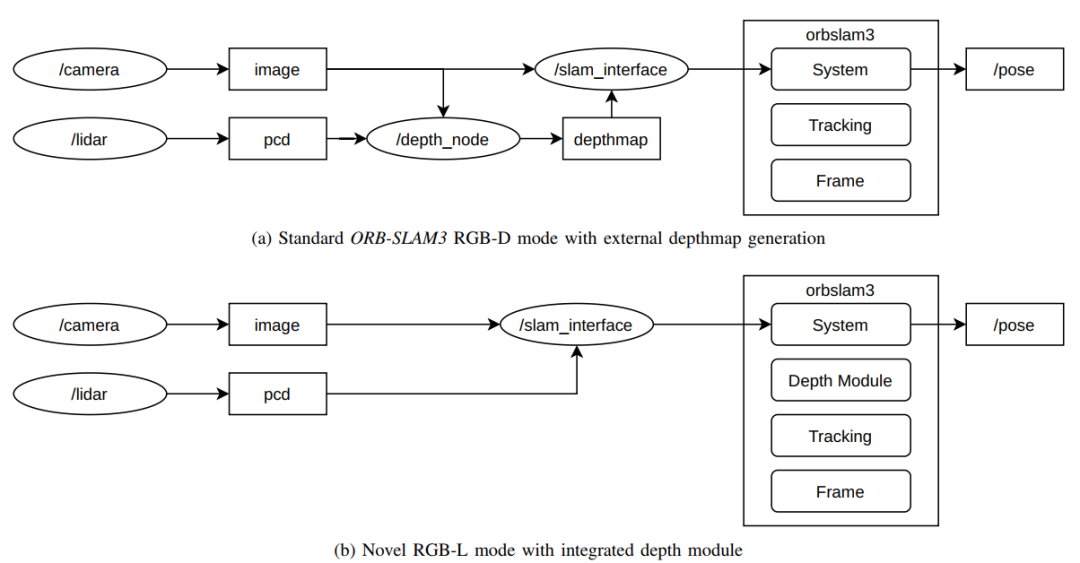

图1:ORB-SLAM3的配置,用于在标准RGB-D模式和新型RGB-L模式下使用基于LiDAR的稠密深度图

这项工作的总体方法如图1所示,LiDAR深度测量值(点云数据(pcd))被转换到相机帧中并上采样。

A、 ORB-SLAM集成

作为一种基线特征点的视觉SLAM算法,我们使用ORB-SLAM3中RGB-D模式已经集成,并提供了直接向每个对应的相机图像提供深度图的选项。这使我们能够使用RGBD模式与先前生成和保存的深度图,如图1a所示。此外,我们还引入了RGB-L模式,该模式使用常规CV在线上采样LiDAR数据,并将结果反馈给SLAM模块,如图1b所示,深度节点将LiDAR数据转换为相机帧,并使用常规CV方法在线对数据进行上采样。

B、 深度图的生成

与相机相比,激光雷达输出稀疏点云数据,因此,很难获得将视觉特征转换成3D空间所需的像素级深度信息,图2显示了转换为相应相机图像的激光雷达点云。

图2:稀疏LiDAR点云投影到相机图像中

我们提出了两种不同的深度图生成方法,将在下面进行评估和比较:传统的CV方法和基于深度学习的方法。使用不同的常规上采样方法进行的多次实验表明,在常规CV方法中,具有5x5砖石核的逆膨胀表现出最佳结果。通常,图像扩展用于增加前景对象的厚度大小。这里希望使用它来增加转换到图像帧中的LiDAR点云的密度。我们选择的内核矩阵大小为5x5像素,具有菱形形状。来自KITTI Odometry数据集的未处理深度图在投影到相机帧中后具有约96%的平均稀疏度。通过应用逆腐蚀操作以将稀疏度降低到65%左右。生成的深度图的MAE为1.03 m,RMSE为4.41m。通过深度学习方法,我们可以实现100%的密度,这意味着每个像素都具有相应的深度值。然而,由于KITTI深度数据集不包含这些像素的真值,因此这些值对于没有LiDAR返回的区域来说是不可信的。对于基于深度学习的LiDAR深度图,我们使用了基于ENet的CNN,之前已经针对运行时进行了优化,在我们的配置中,网络的平均运行时间为16.32毫秒,其中9.66毫秒是GPU上的实际计算时间。对于每像素MAE,我们获得的值为0.39 m,RMSE为1.17 m。这些值是在KITTI深度数据集上生成的,里程计数据的值可能不同。然而,由于数据来自同一来源,因此有理由假设里程计数据的准确性具有可比性,来自神经网络的典型高分辨率深度图和相应的相机图像如图3所示。

图3:基于ENet的神经网络生成的典型相机图像和相应的深度图

实验结果

本节总结了我们使用所提出的方法获得的结果,希望将我们的结果与ORBSLAM3双目模式在精度方面进行比较,特别是在运行时方面,实验在KITTI里程计数据集上进行。

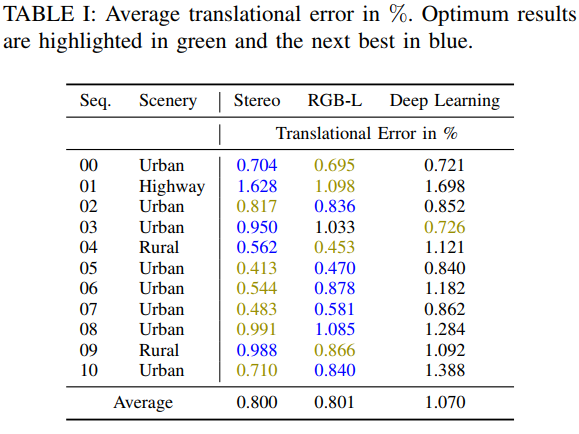

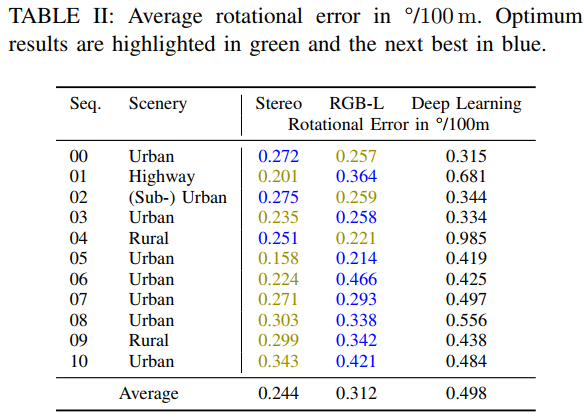

A、 轨迹

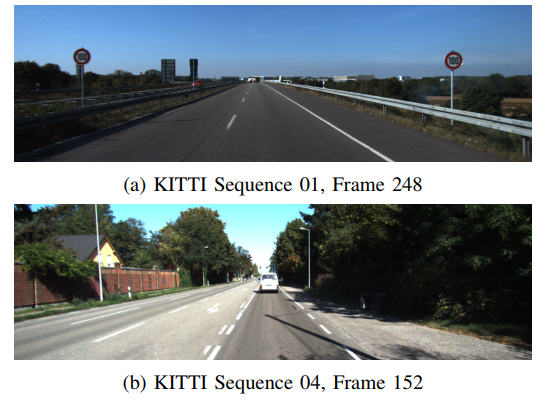

表I和II的比较显示了十个KITTI里程计序列上所述SLAM模式的平移和旋转误差,双目和RGB-L表现出相当的性能,对于双目模式略有优势。可以直接看出,对于平移和旋转误差,深度学习方法的精度都明显较差。这可能是因为很难定义网络表现良好的区域,为了最大限度地减少这种情况的负面影响,忽略了深度图的上30%。神经网络的另一个缺点是KITTI地面真值仅使用高达80米的值,因此,即使距离远得多的区域也会显示80米左右的深度值,RGB-L模式仅使用接近LiDAR实际深度测量值的深度值,因此可以更好地概括。在进一步研究不同序列中算法的准确性后,很明显RGB-L模式在低特征环境中表现特别好,如图4所示。

图4:低特征环境的典型图像。RGB-L在这里优于ORB3-SLAM 双目模式精度

B、 运行时间评估

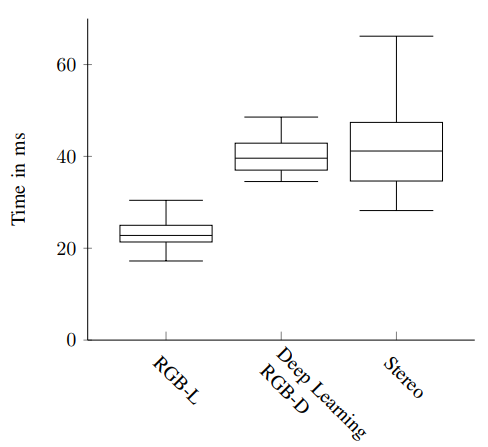

由于SLAM是一个耗时的过程,必须在自动驾驶车辆上实时运行,因此我们希望特别关注运行时分析。图5比较了三种模式的总运行时间,使用激光雷达深度图的两种模式都显示出明显较小的差异,RGB-L运行时间的平均值为22.8ms,因此比立体声模式的41.2ms平均值小40%以上。

图5:所述方法的运行时间比较

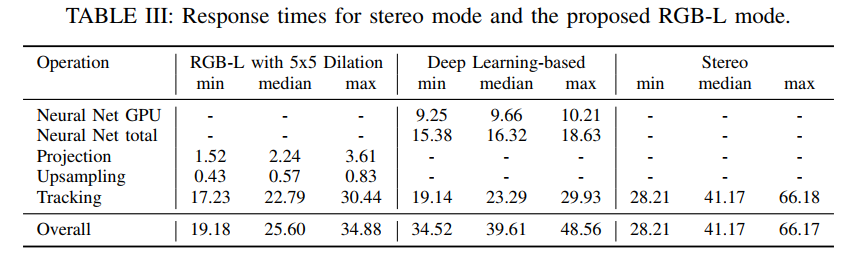

表III总结了运行时间的组成, 由于RGB-D模式需要先前生成的深度图,应注意,离线和在线计算的部分计算时间相加,传统的CV算法具有非常低的计算时间,因此与双目模式相比,所提及的较小平均计算时间与较小的方差相结合可以使所提出的方法对于具有有限硬件资源的嵌入式应用程序特别有趣,所有算法都在CPU上运行,而不需要耗电量大的GPU。

总结

本文提出了一种将激光雷达深度测量值融合到现有的特征点视觉SLAM算法中的方法,即ORB-SLAM3,比较了两种为每个相机图像生成逐像素深度图的方法,为了对LiDAR点云进行上采样,使用了5x5像素大小的菱形核的逆膨胀和基于ENet的监督深度学习方法,虽然在运行SLAM之前必须离线创建基于深度学习的深度图,但扩展作为RGB-L模式直接包含在ORB SLAM3中,该代码将作为开源软件提供。根据KITTI里程表数据集的顺序,RGB-L模式可以匹配双目方法的性能,甚至在低特征环境中表现更好,基于深度学习的深度图的使用在这项工作中没有被证明是有益的,将成为未来研究的主题。使用RGB-L与双目模式相比,我们能够将运行时间减少40%以上,同时运行时间差异显著降低。

更多详细内容请加入知识星球查看原文。

资源

自动驾驶及定位相关分享

【点云论文速读】基于激光雷达的里程计及3D点云地图中的定位方法

自动驾驶中基于激光雷达的车辆道路和人行道实时检测(代码开源)

更多文章可查看:点云学习历史文章大汇总

SLAM及AR相关分享

结构化PLP-SLAM:单目、RGB-D和双目相机使用点线面的高效稀疏建图与定位方案

如果你对本文感兴趣,请后台发送“知识星球”获取二维码,务必按照“姓名+学校/公司+研究方向”备注加入免费知识星球,免费下载pdf文档,和更多热爱分享的小伙伴一起交流吧!

以上内容如有错误请留言评论,欢迎指正交流。如有侵权,请联系删除

扫描二维码

关注我们

让我们一起分享一起学习吧!期待有想法,乐于分享的小伙伴加入免费星球注入爱分享的新鲜活力。分享的主题包含但不限于三维视觉,点云,高精地图,自动驾驶,以及机器人等相关的领域。

分享及合作方式:微信“920177957”(需要按要求备注) 联系邮箱:dianyunpcl@163.com,欢迎企业来联系公众号展开合作。

点一下“在看”你会更好看耶

316

316

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?