来源:NIPS 2015

本文介绍了decode时采样的一种新方法,称为“curriculum learning”(课程学习),对应的采样方法叫做“scheduled sampling”(计划采样)。

-

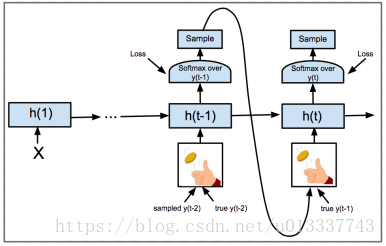

传统方法的问题:传统的神经网络训练时和预测时的输入不一样。

比如对于上图这种网络结构,训练时上一步的y是真实序列标记,然后做为输入到下一步,而预测时上一步的y是模型的输出,然后再做为下一步的输入。这种训练和预测时输入的差异导致了一个问题:当在某一步做出一个错误选择后,后面可能会产生累积错误。因为训练和预测时的前一输入的选择不同,导致可能会出现预测时产生的序列在训练过程中从没有出现过,导致预测时模型不知道如何选择。基于此,作者提出尽量让训练和预测过程一致的“课程学习” -

“课程学习”和”计划采样“

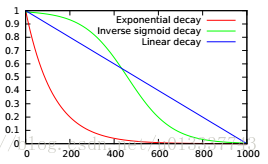

课程学习如上图所示,训练时网络将不再完全采用真实序列标记做为下一步的输入,而是以一个概率p选择真实标记,以1-p选择模型自身的输出。“计划采样”即p的大小在训练过程中是变化的,就像学习率一样。作者的思想是:一开始网络训练不充分,那么p尽量选大值,即尽量使用真实标记。然后随着训练的进行,模型训练越来越充分,这时p也要减小,即尽量选择模型自己的输出。这样就尽量使模型训练和预测保持一致。

p随训练次数的变化方式有如下选择:

-

实验

本文提出的想法在image captioning,Constituency Parsing,speech Recognition等任务上较之前的成果取得了一定improve。

5664

5664

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?