这是一种将海量的数据水平扩展的数据库集群系统,数据分表存储在sharding 的各个节点上,使用者通过简单的配置就可以很方便地构建一个分布式MongoDB 集群。

MongoDB 的数据分块称为 chunk。每个 chunk 都是 Collection 中一段连续的数据记录,通常最大尺寸是 200MB,超出则生成新的数据块。要构建一个 MongoDB Sharding Cluster,需要三种角色:

Shard Server

即存储实际数据的分片,每个Shard 可以是一个mongod 实例,也可以是一组mongod 实例

构成的Replica Set。为了实现每个Shard 内部的auto-failover,MongoDB 官方建议每个Shard

为一组Replica Set。

Config Server

为了将一个特定的collection 存储在多个shard 中,需要为该collection 指定一个shard key,例如{age: 1} ,shard key 可以决定该条记录属于哪个chunk。Config Servers 就是用来存储:所有shard 节点的配置信息、每个chunk 的shard key 范围、chunk 在各shard 的分布情况、该集群中所有DB 和collection 的sharding 配置信息。

Route Process

这是一个前端路由,客户端由此接入,然后询问Config Servers 需要到哪个Shard 上查询或保存记录,再连接相应的Shard 进行操作,最后将结果返回给客户端。客户端只需要将原本发给mongod 的查询或更新请求原封不动地发给Routing Process,而不必关心所操作的记录存储在哪个Shard 上。

下面我们在同一台物理机器上构建一个简单的 Sharding Cluster:

(2)配置Sharding

我们已经对test.users 表进行了分片的设置,下面我们们插入一些数据看一下结果

MongoDB 的数据分块称为 chunk。每个 chunk 都是 Collection 中一段连续的数据记录,通常最大尺寸是 200MB,超出则生成新的数据块。要构建一个 MongoDB Sharding Cluster,需要三种角色:

Shard Server

即存储实际数据的分片,每个Shard 可以是一个mongod 实例,也可以是一组mongod 实例

构成的Replica Set。为了实现每个Shard 内部的auto-failover,MongoDB 官方建议每个Shard

为一组Replica Set。

Config Server

为了将一个特定的collection 存储在多个shard 中,需要为该collection 指定一个shard key,例如{age: 1} ,shard key 可以决定该条记录属于哪个chunk。Config Servers 就是用来存储:所有shard 节点的配置信息、每个chunk 的shard key 范围、chunk 在各shard 的分布情况、该集群中所有DB 和collection 的sharding 配置信息。

Route Process

这是一个前端路由,客户端由此接入,然后询问Config Servers 需要到哪个Shard 上查询或保存记录,再连接相应的Shard 进行操作,最后将结果返回给客户端。客户端只需要将原本发给mongod 的查询或更新请求原封不动地发给Routing Process,而不必关心所操作的记录存储在哪个Shard 上。

下面我们在同一台物理机器上构建一个简单的 Sharding Cluster:

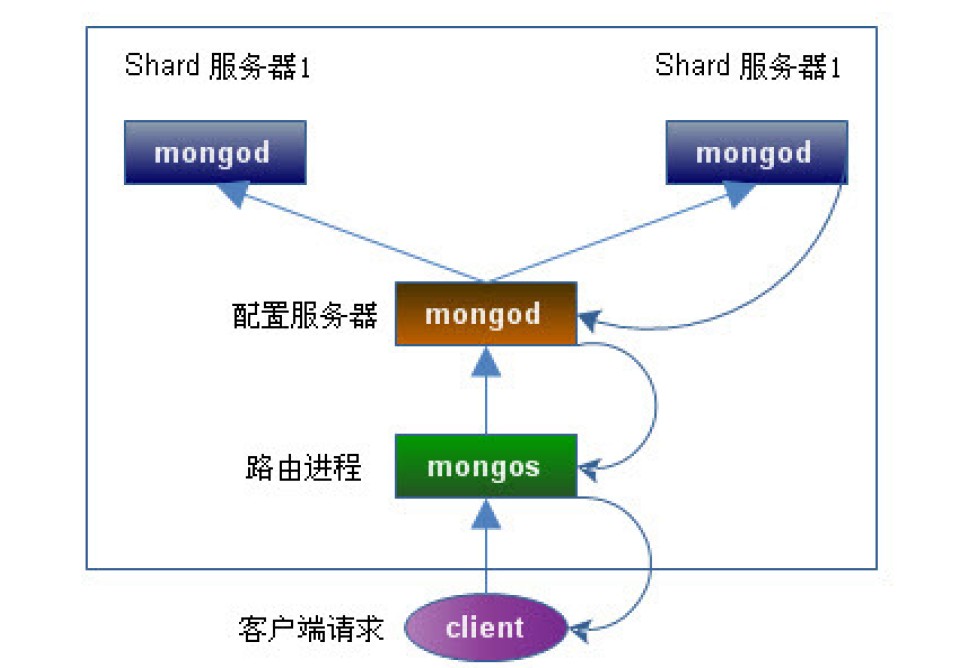

架构图如下:

Shard Server 1:20000

Shard Server 2:20001

Config Server :30000

Route Process:40000

(1)启动三服务

启动Shard Server

mkdir -p /data/shard/s0 --创建数据目录

mkdir -p /data/shard/s1

mkdir -p /data/shard/log --创建日志目录

/Apps/mongo/bin/mongod --shardsvr --port 20000 --dbpath /data/shard/s0 --fork --logpath

/data/shard/log/s0.log --directoryperdb --启动Shard Server 实例1

/Apps/mongo/bin/mongod --shardsvr --port 20001 --dbpath /data/shard/s1 --fork --logpath

/data/shard/log/s1.log --directoryperdb --启动Shard Server 实例2mkdir -p /data/shard/config --创建数据目录

/Apps/mongo/bin/mongod --configsvr --port 30000 --dbpath /data/shard/config --fork --logpath

/data/shard/log/config.log --directoryperdb --启动Config Server 实例/Apps/mongo/bin/mongos --port 40000 --configdb localhost:30000 --fork --logpath

/data/shard/log/route.log --chunkSize 1 --启动Route Server 实例(2)配置Sharding

接下来,我们使用MongoDB Shell 登录到mongos,添加Shard 节点

[root@localhost ~]# /Apps/mongo/bin/mongo admin --port 40000 --此操作需要连接admin 库

MongoDB shell version: 1.8.1

connecting to: 127.0.0.1:40000/admin

> db.runCommand({ addshard:"localhost:20000" }) --添加 Shard Server

{ "shardAdded" : "shard0000", "ok" : 1 }

> db.runCommand({ addshard:"localhost:20001" })

{ "shardAdded" : "shard0001", "ok" : 1 }

> db.runCommand({ enablesharding:"test" }) --设置分片存储的数据库

{ "ok" : 1 }

> db.runCommand({ shardcollection: "test.users", key: { _id:1 }}) --设置分片的集合名称,且必

须指定Shard Key,系统会自动创建索引

{ "collectionsharded" : "test.users", "ok" : 1 }

>我们已经对test.users 表进行了分片的设置,下面我们们插入一些数据看一下结果

> use test

switched to db test

> for (var i = 1; i <= 500000; i++) db.users.insert({age:i, name:"wangwenlong", addr:"Beijing",

country:"China"})

> db.users.stats()

{

"sharded" : true, --说明此表已被shard

"ns" : "test.users",

"count" : 500000,

"size" : 48000000,

"avgObjSize" : 96,

"storageSize" : 66655232,

"nindexes" : 1,

"nchunks" : 43,

"shards" : {

"shard0000" : { --在此分片实例上约有24.5M 数据

"ns" : "test.users",

"count" : 254889,

"size" : 24469344,

"avgObjSize" : 96,

"storageSize" : 33327616,

"numExtents" : 8,

"nindexes" : 1,

"lastExtentSize" : 12079360,

"paddingFactor" : 1,

"flags" : 1,

"totalIndexSize" : 11468800,

"indexSizes" : {

"_id_" : 11468800

},

"ok" : 1

},

"shard0001" : { --在此分片实例上约有23.5M 数据

"ns" : "test.users",

"count" : 245111,

"size" : 23530656,

"avgObjSize" : 96,

"storageSize" : 33327616,

"numExtents" : 8,

"nindexes" : 1,

"lastExtentSize" : 12079360,

"paddingFactor" : 1,

"flags" : 1,

"totalIndexSize" : 10649600,

"indexSizes" : {

"_id_" : 10649600

},

"ok" : 1

}

},

"ok" : 1

}

>[root@localhost bin]# ll /data/shard/s0/test --此分片实例上有数据产生

总计 262420

-rw------- 1 root root 16777216 06-03 15:21 test.0

-rw------- 1 root root 33554432 06-03 15:21 test.1

-rw------- 1 root root 67108864 06-03 15:22 test.2

-rw------- 1 root root 134217728 06-03 15:24 test.3

-rw------- 1 root root 16777216 06-03 15:21 test.ns

[root@localhost bin]# ll /data/shard/s1/test --此分片实例上有数据产生

总计 262420

-rw------- 1 root root 16777216 06-03 15:21 test.0

-rw------- 1 root root 33554432 06-03 15:21 test.1

-rw------- 1 root root 67108864 06-03 15:22 test.2

-rw------- 1 root root 134217728 06-03 15:23 test.3

-rw------- 1 root root 16777216 06-03 15:21 test.ns

[root@localhost bin]#

341

341

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?