将hadoop-1.2.1-eclipse-plugin.jar复制到eclipse\plugins下面

重启eclipse

会发现打开open perspective选项卡,点击other,弹出窗口下会多出Mapreduce选项

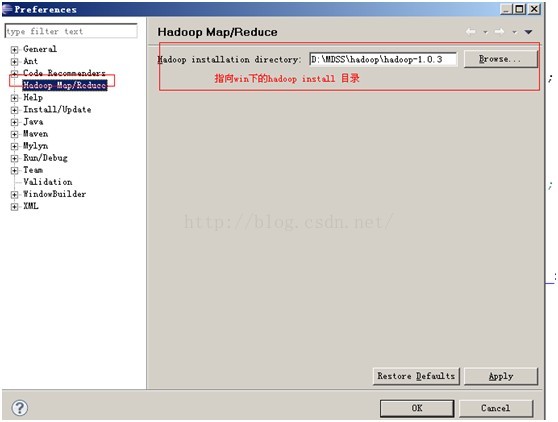

配置本地Hadoop Install (hadoop的源码目录)目录

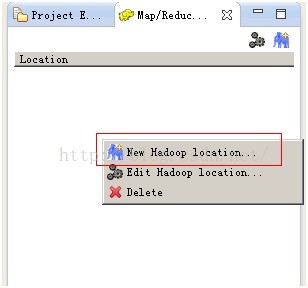

新建一个Hadoop Location

点击 “New Hadoop Location”(在控制台的地方)

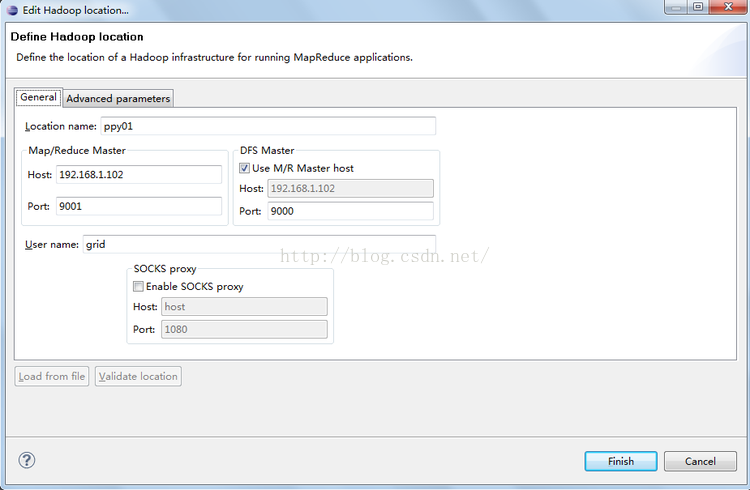

根据hadoop环境正确填写General和Advanced parameters内容,点击finish

Location name是你自己取的名字,我这里用了hadoop,Map/Reduce Master这里的host和port对应上面mapred-site.xml中mapred.job.tracker的值,我配置的是localhost和9001;DFS Master对应上面core-site.xml中fs.default.name中的值,我配置的是localhost和9000.

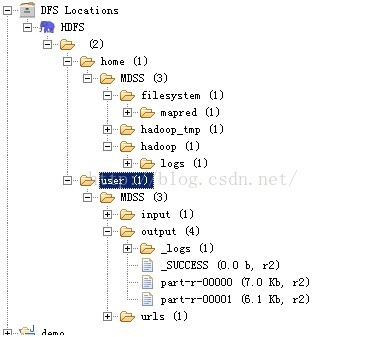

完成后,如果屏幕左上方的DFS Locations中的内容可以正常显示,说明配置一切成功。

Map/Reduce Master:

两个参数就是 mapred-site.xml中mapred.job.tracker的ip和端口

DFS Master:

两个参数就是

User Name:

搭建Hadoop集群时所用的用户名

至此,就可以hadoop-eclipse插件配置就已经完成,可以使用eclipse连接至hadoop集群,进行Mapreduce程序开发和调试了。

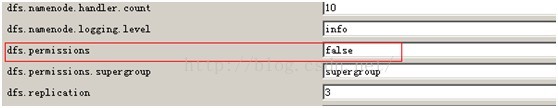

相关异常信心以及解决办法:

1.

解决办法:修改主机名与集群用户名一致,或者重新编译core.org.apache.fs.FileUtil类,

修改hadoop源代码,去除权限认证,修改FileUtil.java的checkReturnValue方法,如下:

private static void checkReturnValue(boolean rv, File p,

FsPermission permission

) throws IOException {

// if (!rv) {

// throw new IOException("Failed to set permissions of path: " + p +

// " to " +

// String.format("o", permission.toShort()));

// }

}

2.

at sun.reflect.NativeConstructorAccesso

at sun.reflect.NativeConstructorAccesso

1495

1495

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?