简介:Swift是Apple的编程语言,与Core ML框架结合,可以实现iOS应用中的机器学习模型集成。本指南详细阐述了Swift与Core ML结合的开发流程,包括模型的导入、使用、转换与优化,以及UI集成和实时预测。掌握这些技能可以帮助开发者构建智能应用,如图像识别和自然语言处理。通过持续学习和模型更新,开发者可以保持在技术前沿。

1. Core ML框架概述

Core ML是苹果公司推出的机器学习框架,它使得开发者能够轻松地在自己的应用程序中集成机器学习模型。这一框架支持广泛的数据类型和算法,并且能够自动优化模型以适应不同的设备,无论是iPhone、iPad还是Mac,都能提供流畅的用户体验。

1.1 Core ML框架的定位

Core ML旨在简化开发者的工作流程,让他们无需深入了解机器学习的复杂算法,就能将先进的AI功能带给用户。通过直接利用在Xcode中创建的模型,开发者可以快速开发出能够执行任务的应用程序,如图像识别、自然语言处理等。

1.2 Core ML框架的技术特点

Core ML框架的核心技术特点包括高效的性能、易用性以及与现有开发工具的无缝集成。它支持深度学习、传统机器学习模型和核心图形处理器(Core GPU)加速,使得应用可以快速响应用户请求。此外,它还利用了苹果的Neural Engine,进一步提升了模型运行的速度与效率。

2. Swift编程语言特点

2.1 Swift语言基础

2.1.1 Swift语言的发展历程

Swift是苹果公司于2014年推出的一种全新的编程语言,旨在替代旧有的Objective-C语言。Swift具有现代编程语言的特征,如类型推断、闭包、元组等,其设计目标是提供安全、快速且易于使用的开发体验。Swift的开发团队在设计时汲取了其他现代编程语言的优点,并针对苹果自家的平台进行了深度优化。自从在2014年WWDC上公布以来,Swift经历了多个版本的迭代,每一次的更新都增加了新特性和对现有功能的改进,使得Swift更加成熟和功能强大。

2.1.2 Swift语言的核心特性

Swift的核心特性包括:

- 安全性 :Swift强类型的语言特性和自动内存管理机制减少了常见的编程错误,如空引用错误和数组越界错误。

- 性能 :Swift编译器使用了高度优化的中间代码和专有的高级优化技术,能够产生与C语言相媲美的执行效率。

- 现代特性 :如闭包、元组、泛型、操作符重载等,使得代码更加简洁和表达力更强。

- 与Objective-C的兼容性 :Swift与Objective-C代码可以无缝互操作,使得开发者可以渐进式迁移到Swift。

2.2 Swift与Objective-C的比较

2.2.1 语言特性的对比分析

Swift相比Objective-C在语言设计上有以下几个显著的区别:

- 类型安全 :Swift通过引入

Optionals处理了空值的问题,提供了更安全的类型系统。 - 简洁性 :Swift提供了更简洁的语法。例如,Swift中不需要分号来结束语句,属性的声明也更为直观。

- 脚本化 :Swift的Playgrounds提供了交互式的编程体验,方便了学习和实验。

- 并发性 :Swift对并发编程提供了更好的支持,通过

async/await和actor模型使得并发编程变得更加安全和直观。

2.2.2 Swift在iOS开发中的优势

Swift对iOS开发带来的优势主要体现在:

- 开发效率 :Swift代码通常比Objective-C更短、更直观,能显著提高开发效率。

- 运行效率 :Swift的运行时性能与Objective-C相当,甚至在某些方面更优。

- 安全 :Swift的类型系统和现代编程特性减少了运行时错误,提高了应用的稳定性。

- 社区和生态系统 :由于其现代特性,Swift拥有一个活跃的开发社区和丰富的开源资源。

在理解了Swift语言的基础知识之后,接下来的章节将深入探讨如何将Swift与iOS开发中的不同技术栈相结合,以进一步提升开发效率和用户体验。

3. Core ML模型的导入与使用

3.1 Core ML模型的准备工作

3.1.1 支持的模型格式

在开始导入Core ML模型之前,必须了解它支持的模型格式。Core ML是Apple为iOS、macOS、watchOS和tvOS应用提供的机器学习框架,它能够将训练好的模型转换为特定格式,以便在苹果设备上高效运行。截至本文知识截止日期,Core ML支持的模型格式包括但不限于以下几种:

- ONNX (Open Neural Network Exchange):一种开放的格式,用于表示深度学习模型。

- Keras:基于Python的高级神经网络API,可以在TensorFlow、CNTK或Theano之上运行。

- Caffe:伯克利AI研究小组(BAIR)开发的一个深度学习框架。

- scikit-learn:一个Python模块,专门用于机器学习。

- XGBoost:一个梯度提升库,用于分布式、高性能机器学习。

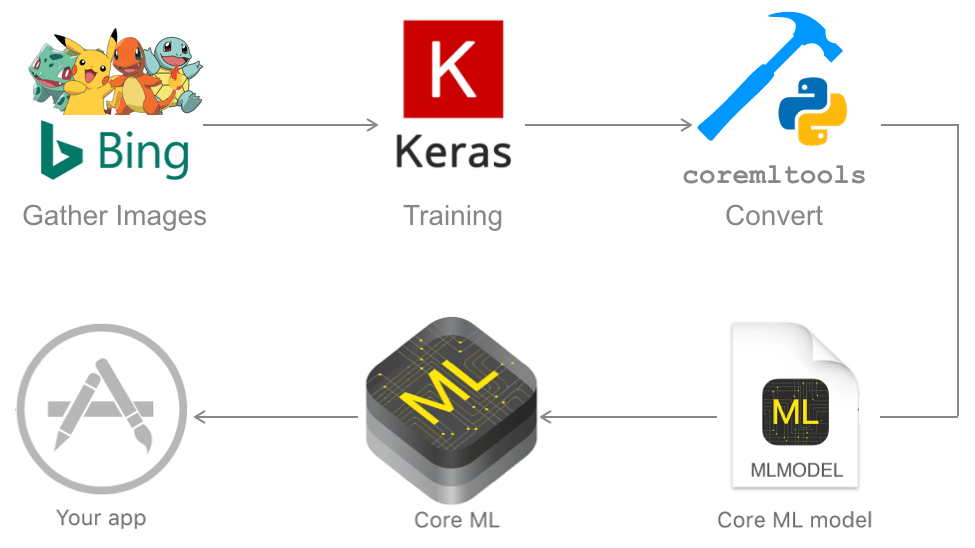

模型转换成Core ML格式的过程通常涉及到使用 coremltools Python库,这是苹果官方提供的一个工具包,支持将上述多种格式的模型转换为 .mlmodel 文件。

3.1.2 使用Xcode导入模型

导入模型的步骤在Xcode中十分直观。开发者可以按照以下步骤操作:

- 打开Xcode项目。

- 选择项目目标,并在项目导航器中打开项目的目标设置。

- 进入“Build Phases”选项卡,点击“Link Binary with Libraries”旁边的加号按钮。

- 添加模型文件,Xcode会识别文件类型并将其放入适当的位置。

当模型文件被添加到项目中后,Xcode会自动处理模型的编译,并将其嵌入到应用程序的二进制文件中。开发者可以在项目中直接引用这些模型,无需担心路径和文件管理的问题。

3.2 Core ML模型在Swift中的应用

3.2.1 编写Core ML集成代码

集成Core ML模型到Swift代码中是一个简单的过程,主要步骤包括加载模型并创建一个模型实例,然后使用该实例来生成预测。以下是一个简单的示例代码块:

import CoreML

// 加载模型

let model = YourModelClass(configuration: YourModelClass.Configuration())

// 假设我们有一个输入数据结构

let inputData = YourModelClass.Input() // 填充输入数据

// 进行预测

model.prediction(inputData: inputData) { result, error in

if let error = error {

print("模型预测出错: \(error.localizedDescription)")

return

}

if let result = result {

print("预测结果: \(result.output)")

}

}

在上述代码中, YourModelClass 是模型的Swift类名,根据你所使用的模型工具转换后的结果不同而有所不同。开发者需要根据实际情况替换 YourModelClass 和 YourModelClass.Input 为正确的类和输入数据结构。

3.2.2 模型的使用和调用方法

在实际使用中,模型的调用通常发生在应用的某些业务逻辑中,比如在用户交互后或者在特定的时间间隔。例如,在一个图像识别应用中,当用户选择一张图片后,可以加载图像识别模型并调用预测方法:

func imagePickerController(_ picker: UIImagePickerController, didFinishPickingMediaWithInfo info: [UIImagePickerController.InfoKey : Any]) {

if let image = info[.originalImage] as? UIImage {

// 将UIImage转换为模型期望的输入格式,比如CVPixelBuffer

guard let pixelBuffer = image.toPixelBuffer() else {

print("转换图片失败")

return

}

// 使用转换后的图像进行预测

let predictionResult = model.predict(image: pixelBuffer)

// 处理预测结果

print("识别结果: \(predictionResult)")

}

picker.dismiss(animated: true)

}

在上述示例代码中, image.toPixelBuffer() 方法是一个假设的图片转换方法,开发者需要根据实际情况编写相应的转换代码以匹配模型的输入格式要求。

3.3 小结

通过本章节的介绍,我们了解了Core ML模型的准备工作,包括支持的模型格式和如何使用Xcode导入模型。我们还学习了如何在Swift中编写集成Core ML模型的代码,并以图像识别为例展示了模型的使用和调用方法。通过这些步骤,开发者可以将机器学习模型嵌入到iOS应用中,实现智能功能并提升用户体验。

4. 模型转换与性能优化

4.1 模型转换工具介绍

4.1.1 工具选择与安装

随着机器学习的不断发展,越来越多的工具被开发出来帮助开发者将训练好的模型转换为Core ML模型。一个核心工具是Apple提供的coremltools Python库。它支持多种开源框架的模型转换,比如TensorFlow、Keras、scikit-learn等。

首先,你需要安装Python环境和pip包管理工具。然后,使用pip安装coremltools库:

pip install coremltools

安装完成后,可以通过Python的交互式环境检查版本确保安装成功:

import coremltools

print(coremltools.__version__)

4.1.2 转换过程详解

以Keras模型为例,下面是转换为Core ML模型的简要流程:

import coremltools as ct

from keras.models import load_model

# 加载预先训练好的Keras模型

model_keras = load_model('path_to_your_keras_model.h5')

# 转换为Core ML模型

model_coreml = ct.convert(model_keras, source='keras',

class_labels='path_to_labels.txt')

# 保存转换后的模型

model_coreml.save('YourModel.mlmodel')

转换过程中需要注意模型的输入输出格式、数据类型等,确保在转换后的Core ML模型中能正确处理数据。coremltools文档提供详细的转换参数说明,有助于在遇到问题时进行调试。

4.2 性能优化策略

4.2.1 模型的剪枝与量化

模型剪枝和量化是常见的优化技术,可减少模型大小,加速模型的推理速度。

- 模型剪枝 是去除模型中不重要的权重和神经元,以减少模型复杂度。coremltools库提供了剪枝功能:

# 对模型进行剪枝操作

model_pruned = ct prune(model_coreml, 0.2) # 保留80%的权重

model_pruned.save('PrunedYourModel.mlmodel')

- 模型量化 将模型中的浮点数参数转换为定点数,减少了模型大小和计算复杂性。coremltools同样支持量化:

# 对模型进行量化操作

model_quantized = ct quantize(model_coreml, nbits=8)

model_quantized.save('QuantizedYourModel.mlmodel')

4.2.2 加速推理速度的技巧

除了剪枝和量化,还可以通过以下方法优化模型的性能:

- 模型简化 :在不影响准确性的情况下,尽可能简化模型架构。

- 利用硬件加速 :使用支持神经网络引擎(NNAPI)的设备进行加速。

- 多线程和并行处理 :Core ML支持并发执行,允许在多线程环境中加速模型的执行。

- 优化输入输出 :使用合适的数据类型和批量大小可以提高处理速度。

在实际应用中,往往需要根据具体情况,结合多种优化手段,来达到最佳的性能提升效果。

表格展示不同优化手段的对比:

| 优化手段 | 描述 | 优缺点 | 适用场景 |

|---|---|---|---|

| 剪枝 | 去除不重要的权重和神经元 | 减少模型大小,可能轻微影响准确性 | 在准确率允许范围内的模型 |

| 量化 | 将浮点数转换为定点数 | 减少计算量和模型大小,节省内存 | 需要较低内存和提高推理速度的模型 |

| 硬件加速 | 利用专门的硬件优化计算 | 显著提高计算效率,但设备依赖性高 | 支持专用加速硬件的设备 |

| 多线程 | 同时使用多个计算资源 | 加快模型处理速度,可能增加功耗 | 多核处理器的设备 |

5. UIKit和SwiftUI集成Core ML模型

5.1 UIKit集成Core ML模型

5.1.1 UIKit概述及与Core ML的结合

UIKit是Apple开发的iOS应用框架的核心组成部分,用于处理应用的用户界面和窗口管理。UIKit与Core ML的结合,允许开发者在不牺牲性能的前提下,将机器学习模型的预测能力集成到iOS应用的用户界面中。通过将Core ML模型嵌入UIKit应用,开发者可以创建更加智能、响应用户行为的应用程序。

要将Core ML模型集成到UIKit应用中,首先要确保已经有一个训练好的Core ML模型。模型可以在Xcode中创建,也可以通过其他工具转换得到。一旦模型准备就绪,可以通过Swift代码将其加载到项目中,并在UIKit的视图控制器中进行调用。

5.1.2 UIKit项目中的实践案例

为了更具体地理解UIKit与Core ML模型的结合,我们可以看一个简单的实践案例。假设我们有一个图像分类的应用程序,它使用Core ML模型来识别用户上传的图片中包含的物体种类。

首先,在Xcode项目中导入Core ML模型文件,可以将模型文件拖拽到项目中,Xcode会自动生成对应的Swift类,这个类将作为模型的接口。

接下来,在 ViewController.swift 文件中,使用模型进行预测:

import UIKit

import CoreML

class ViewController: UIViewController {

@IBOutlet weak var imageView: UIImageView!

let model = ImageClassifier()

override func viewDidLoad() {

super.viewDidLoad()

// 预设图片并进行预测

guard let image = UIImage(named: "example.jpg") else { return }

imageView.image = image

predict(image: image)

}

func predict(image: UIImage) {

// 将UIImage转换为模型需要的格式

guard let ciImage = image.coreImage else { return }

let input = ImageClassifierInput(image: ciImage)

// 执行模型预测

model.prediction(image: input).start { (result, error) in

if let error = error {

print(error)

return

}

if let result = result?.classLabel, let confidence = result.confidence {

DispatchQueue.main.async {

self.showResult(result: result, confidence: confidence)

}

}

}

}

func showResult(result: String, confidence: Float) {

let message = "The image is classified as \(result) with \(confidence*100)% confidence."

let alert = UIAlertController(title: "Classification Result", message: message, preferredStyle: .alert)

alert.addAction(UIAlertAction(title: "OK", style: .default, handler: nil))

self.present(alert, animated: true, completion: nil)

}

}

在上述代码中, ImageClassifier 是Xcode自动生成的Core ML模型类。 ImageClassifierInput 是将UIImage转换为模型输入格式的结构体,我们在 predict 函数中将UIImage转换为CIImage,然后调用模型的 prediction 方法进行预测。预测结果会在异步回调中返回,我们在 showResult 函数中处理预测结果并显示。

这个案例展示了UIKit如何与Core ML模型进行集成,实现基本的图像分类功能。开发者可以通过类似的方式,将各种Core ML模型集成到自己的UIKit应用中,为用户提供更加智能的功能。

5.2 SwiftUI集成Core ML模型

5.2.1 SwiftUI简介及特点

SwiftUI是Apple在2019年推出的全新UI框架,它引入了一种新的声明式编程范式来构建用户界面。与UIKit相比,SwiftUI更简洁、更易用,并且能够更直观地反映用户界面的状态和交互。SwiftUI的一个重要特点在于它与Swift语言的紧密结合,使开发者能够以更少的代码编写复杂的界面。

SwiftUI提供了对Core ML的直接支持,允许开发者在声明式UI代码中直接集成模型的预测功能。这种集成方式减少了样板代码,并且使得模型的使用与用户界面的状态变化紧密相关。

5.2.2 SwiftUI中Core ML模型的集成方法

在SwiftUI中集成Core ML模型,我们首先需要确保模型已经集成到Xcode项目中。和UIKit集成类似,将模型文件拖拽到项目中,SwiftUI可以自动识别模型并生成相应的Swift代码。

接下来,我们通过一个例子来展示如何在SwiftUI视图中使用Core ML模型。假设我们有一个使用Core ML模型进行文本情感分析的SwiftUI视图。

import SwiftUI

import CoreML

struct SentimentAnalysisView: View {

@State private var text: String = ""

@State private var result: String = ""

var body: some View {

VStack {

TextField("Enter text...", text: $text)

Button(action: {

self.analyzeSentiment(text: text)

}) {

Text("Analyze Sentiment")

}

Text("Result: \(result)")

}

}

func analyzeSentiment(text: String) {

let model = SentimentClassifier()

let input = SentimentClassifierInput(text: text)

model.prediction(text: input).start { (result, error) in

if let error = error {

self.result = "Error: \(error.localizedDescription)"

} else if let result = result?.classLabel, let confidence = result.confidence {

self.result = "Sentiment: \(result) (Confidence: \(confidence))"

}

}

}

}

struct SentimentAnalysisView_Previews: PreviewProvider {

static var previews: some View {

SentimentAnalysisView()

}

}

在上面的SwiftUI视图中,我们创建了一个文本输入框和一个按钮用于触发情感分析。当用户点击按钮时, analyzeSentiment 函数会被调用。该函数创建了模型实例,并调用了模型的 prediction 方法来获取预测结果。预测结果通过修改 result 状态变量来显示在界面上。

这个简单的例子展示了如何在SwiftUI应用中快速集成Core ML模型,并为用户提供一个交互式体验。开发者可以通过类似的方式,将各种Core ML模型集成到自己的SwiftUI应用中,从而为用户提供更加智能的功能和更好的用户体验。

6. 实时预测与用户体验提升

随着移动设备计算能力的增强和机器学习技术的发展,实时预测成为了移动应用中的一个重要功能。通过在设备上本地运行机器学习模型,应用程序可以提供即时、私密且无需依赖网络的智能服务。实时预测对于提升用户体验至关重要,它能减少用户等待的时间,增加应用的交互性和响应速度。本章将探讨实时预测的实现方法,并讨论如何通过优化用户体验来增强应用的整体价值。

6.1 实时预测的实现

实时预测涉及到在移动设备上执行复杂的计算任务,需要考虑的不仅仅是模型的准确性和效率,还需要考虑到设备的资源限制,如内存、电池和处理能力。为了确保实时预测既快速又准确,开发者通常需要对模型进行优化,并且合理地安排预测过程。

6.1.1 预测过程的优化

优化预测过程的第一步是选择合适模型。模型的大小和计算复杂度直接关联到执行预测的时间。更小、更简单的模型往往更快速,但也可能牺牲准确性。因此,在模型选择时需要权衡速度与准确性的关系。

接下来,开发者可以利用模型压缩技术如剪枝(Pruning)、量化(Quantization)等,这些技术能减少模型大小和提高推理速度,同时尽量保持模型性能。模型剪枝通过去除权重较小的神经元来简化模型结构,而量化则通过减少权重表示的精度来减小模型的存储空间和计算需求。

以下是一个简化的量化示例,展示了如何将模型权重从浮点数转换为定点数:

import numpy as np

# 假设这是模型权重的一部分

weights = np.array([

[0.1, -0.2, 0.3],

[0.4, -0.5, 0.6],

[0.7, -0.8, 0.9]

])

# 定义量化参数

quantization_bits = 8 # 假设我们使用8位来表示每个权重

max_value = np.max(np.abs(weights)) # 计算最大权重绝对值

quantized_weights = np.round((weights / max_value) * ((2**quantization_bits - 1) / 2)).astype(np.int8) # 进行量化

# 输出量化后的权重

print(quantized_weights)

该代码首先计算权重的最大值,然后使用这个最大值对权重进行归一化,接着量化到8位整数。最后,将归一化并量化的权重转换成整型数组。

量化后,模型的大小会缩小,并且乘法操作可以被移位操作替代,从而加快计算速度。在某些情况下,量化模型可能会降低模型的预测准确性,所以需要进行彻底的测试来验证模型的性能。

6.1.2 降低延迟的策略

除了优化模型本身外,还有其他方法可以降低预测过程中的延迟。一种常见的方法是异步处理,这样用户界面UI可以继续对用户的输入做出反应,而预测计算在后台进行。

在移动设备上,还可以利用多线程来进一步提升性能。例如,在iOS中,可以使用Grand Central Dispatch(GCD)来创建并管理后台线程,提高CPU资源的利用效率。

DispatchQueue.global(qos: .background).async {

// 这里是后台任务,例如进行模型预测

DispatchQueue.main.async {

// 预测完成后,回到主线程更新UI

// 例如,显示预测结果

}

}

在这段代码中,我们使用了全局队列来进行异步的后台任务处理,而所有与UI相关的更新则被放在主线程的同步块中执行。这种方法能够有效减少应用的响应延迟,并保持界面的流畅性。

6.2 用户体验的增强技巧

实时预测只是提升用户体验的一个方面。为了确保用户能够从实时预测中受益,开发者还需要对用户界面进行优化,让预测结果更易于理解和使用。

6.2.1 界面设计与用户交互优化

优秀的用户界面和交互设计能够引导用户正确地与应用互动,从而提高用户的满意度和应用程序的使用效率。例如,预测结果的展示应该直观和简洁,避免过于复杂的技术术语。

考虑到实时预测的特点,界面设计应当简洁流畅,避免过度设计导致的资源消耗。此外,用户交互应该响应迅速,避免任何可能引起延迟的因素。例如,在用户输入时,可以提供即时反馈,如输入状态的视觉变化、自动完成建议等,来提升用户感知的响应速度。

6.2.2 预测结果的可视化与解释

预测结果的可视化是提升用户体验的另一个关键方面。有效的数据可视化可以帮助用户更快地理解预测结果,并作出决策。例如,在健康应用中,可以使用图表或进度条来展示用户的健康指标预测。

此外,预测结果的解释对于增强用户对模型的信任也非常重要。开发者应当提供清晰的解释说明,告诉用户预测是如何得出的,以及预测结果的意义。这对于非技术用户尤其重要,因为他们可能不熟悉机器学习模型的工作原理。

例如,一个天气预报应用不仅告诉用户明天下雨的概率,还应该说明是根据哪些气象数据预测出的结果,例如气压、温度、湿度等。

| 指标 | 数值 | 预测解释 |

| ---- | ---- | -------- |

| 气压 | 1012 | 低气压通常预示着天气变化 |

| 温度 | 21°C | 相对温暖,有助于降水 |

| 湿度 | 65% | 湿度较高,增加了下雨的可能性 |

在上表中,我们提供了一个简单的天气预测结果解释,这可以帮助用户更好地理解天气预报的原因。通过使用这种表格形式的可视化,用户可以更直观地看到各项指标与预测之间的关系。

综上所述,实时预测与用户体验的提升息息相关。通过优化预测过程和用户界面,可以显著提升应用的响应性和用户满意度。在本章中,我们讨论了多种方法来提高实时预测的效率,包括模型优化、异步处理和多线程使用。同时,我们也探讨了如何通过界面设计和预测结果的可视化与解释,来增强用户体验。这些内容将有助于开发者设计出更加高效和用户友好的智能应用。

7. Core ML模型的热更新机制

在移动应用开发中,热更新机制是一个关键的特性,它允许开发者在无需提交App Store审核的情况下,即时推送更新给用户。对于机器学习模型来说,这种更新方式尤为重要,因为它可以快速响应市场需求的变化,修复潜在的模型缺陷,或添加新的功能。

7.1 热更新的重要性与原理

7.1.1 iOS平台热更新的需求分析

随着市场竞争的加剧,应用开发不仅仅是开发出一个功能完善的应用,还需要不断地改进和更新应用,以满足用户的需求和期望。特别是对于使用机器学习模型的应用,可能需要根据用户的反馈或模型性能测试结果来调整模型参数或结构。

iOS平台对于热更新有着严格的规定,因此传统的做法是通过App Store进行更新。然而,这种方式需要用户主动下载安装更新包,且审核过程较长。热更新机制使得应用能够绕过这一过程,快速将更新推送到用户的设备上。

7.1.2 热更新技术概述

热更新技术在iOS开发中主要依赖于App Transport Security (ATS)、On-Demand Resources (ODR)、App Slicing和Dynamic Libraries。这些技术可以分为两类:

- 应用内容更新 :通过下载额外的内容来更新应用。例如,App Slicing可以为不同设备提供优化的内容,ODR允许动态下载必要的资源。

- 动态库更新 :允许应用下载动态链接库(.dylib)进行更新。动态库是在应用运行时被加载的,因此可以通过热更新技术来替换它们,而不影响应用的其他部分。

热更新机制使得Core ML模型的更新变得更为灵活和及时,但开发者需要确保更新过程的安全性和稳定性。

7.2 实现Core ML模型热更新

7.2.1 实施热更新的步骤

要实现Core ML模型的热更新,可以遵循以下步骤:

- 模型更新准备 :将新的或优化后的Core ML模型上传到服务器。

- 后端集成 :后端系统需要提供下载新模型的接口。

- 应用内更新检测 :开发应用时,集成一个机制定期检查服务器上的模型更新情况。

- 下载模型 :通过网络请求将新模型下载到用户设备上。

- 模型替换 :利用Core ML的

MLModel类替换旧模型,这通常涉及到加载动态库(.dylib)。 - 验证更新 :对新模型进行测试,确保更新后的模型能够正常工作且性能符合预期。

7.2.2 热更新过程中的挑战及应对

在实现热更新过程中,开发者可能会遇到挑战,比如模型的安全性、设备兼容性以及更新的稳定性。

-

模型安全性 :确保下载的模型没有被篡改,可以在下载后通过哈希校验来确认文件的完整性。

-

设备兼容性 :新模型可能需要设备具备特定的硬件能力,因此在推送更新之前要对目标设备进行兼容性测试。

-

更新的稳定性 :为避免更新过程中出现崩溃或异常,应该设计健壮的回滚机制,确保应用能够在更新失败时恢复到稳定状态。

通过以上方法,可以在保障用户体验的同时,快速对应用中的Core ML模型进行更新和优化。

简介:Swift是Apple的编程语言,与Core ML框架结合,可以实现iOS应用中的机器学习模型集成。本指南详细阐述了Swift与Core ML结合的开发流程,包括模型的导入、使用、转换与优化,以及UI集成和实时预测。掌握这些技能可以帮助开发者构建智能应用,如图像识别和自然语言处理。通过持续学习和模型更新,开发者可以保持在技术前沿。

356

356

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?