文章目录

- 一、概述

- 二、常见的几种CNI插件介绍

- 1)Flannel(本文讲解)

- 2)Calico

- 3)Romana

- 4)Weave Nets

- 三、Flannel 组件的解释

- 如何给k8s集群安装和使用Flannel插件

- 四、Flannel底层网络通信全过程

- 1)同节点Pod之间的通信

- 实验

- 工作流程

- 步骤1:源容器向目标容器发送数据,数据首先发送给 cni0 网桥

- 步骤2:cni0 网桥接受到数据后,将其转交给 flannel.1 虚拟网卡处理

- 步骤3: flannel.1 接受到数据后,对数据进行封装,并发给宿主机的 ens33,再通过ens33出外网,或者访问不同node节点上的pod

- 2)不同节点Pod之间的通信

- 3)Pod与Service之间的通信

- 五、尾声

一、概述

Kubernetes 采用的是基于扁平地址空间的、非NAT的网络模型,每个Pod有自己唯一的IP地址。网络是由CNI(container network interface)插件建立的,而非K8S本身。

CNI 和 Calico关系:CNI 是一个容器网络标准,是理论上的,是一个标准,相当于SPI,其他的 Calico Flannel 都是实现了的 CNI 插件。

二、常见的几种CNI插件介绍

为了使容器之间的通信更加方便,Google 和 CoreOS 主导制定了一个容器网络标准CNI(Conteinre Network Interface) 。

k8s官网:https://kubernetes.io/docs/concepts/cluster-administration/addons/

CNI可允许K8S配置任何CNI插件,常见的CNI插件有以下几种:

1)Flannel(本文讲解)

Flannel是由CoreOS开发的项目,是容器编排系统中最成熟的网络结构示例之一,旨在实现更好的容器间和主机间网络。

与其他方案相比,Flannel相对容易安装和配置。它被打包为单个二进制文件flanneld,许多常见的Kubernetes集群部署工具和许多Kubernetes发行版都可以默认安装Flannel。Flannel可以使用Kubernetes集群的现有etcd集群来使用API存储其状态信息,因此不需要专用的数据存储。

详细参考 https://github.com/coreos/flannel

官网:https://coreos.com/flannel/docs/latest/

文档:https://coreos.com/flannel/docs/latest/kubernetes.html

2)Calico

Calico是Kubernetes生态系统中另一种流行的网络选择,它提供收费的技术支持。虽然Flannel被公认为是最简单的选择,但Calico以其性能、灵活性而闻名。Calico的功能更为全面,更为复杂。它不仅提供主机和pod之间的网络连接,还涉及网络安全和管理。Calico CNI插件在CNI框架内封装了Calico的功能。

详细参考 https://github.com/projectcalico/cni-plugin

3)Romana

Romana是Panic Networks在2016年新提出的开源项目,旨在解决Overlay方案给网络带来的开销。虽然目标和Calico基本一致,但其采取的方法却截然不同,具体项目的发展有待观察。

4)Weave Nets

大家都叫惯了weave,实际上目前该产品的名字叫做Weave Nets。

Weave是由Weaveworks提供的一种插件,它提供的模式是在集群中的节点之间创建网状的overlay网络。与Calico一样,Weave也为Kubernetes集群提供网络策略功能。

三、Flannel 组件的解释

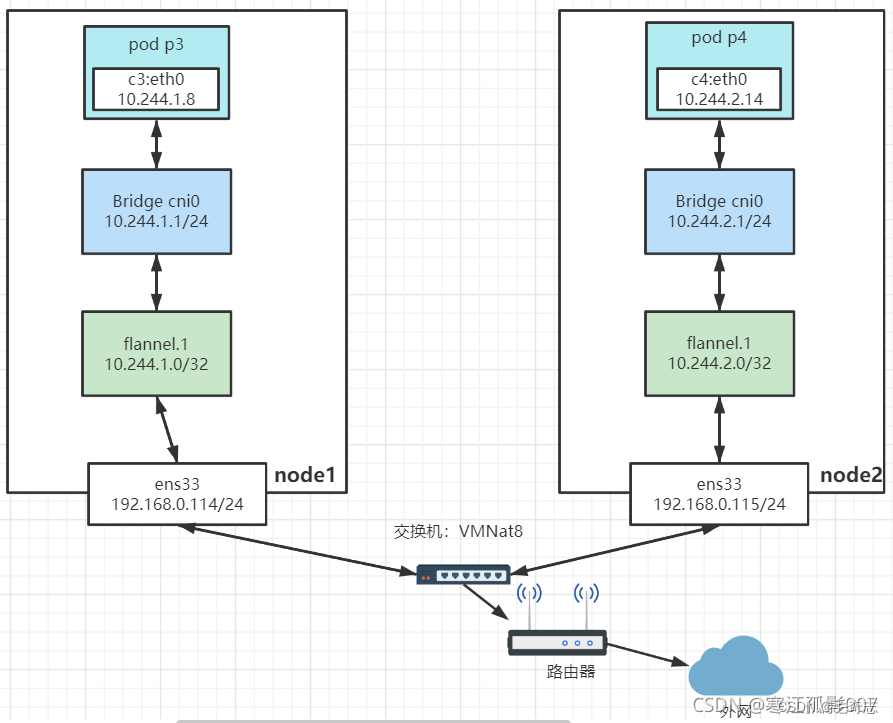

Cni0:网桥设备,每创建一个pod都会创建一对 veth pair,其中一端是pod中的eth0,另一端是Cni0网桥中的端口 (网卡),Pod中从网卡eth0发出的流量都会发送到Cni0网桥设备的端口(网卡)上,Cni0 设备获得的ip地址是该节 点分配到的网段的第一个地址。

Flannel.1:overlay网络的设备,用来进行vxlan报文的处理(封包和解包),不同node之间的pod数据流量都从 overlay设备以隧道的形式发送到对端。

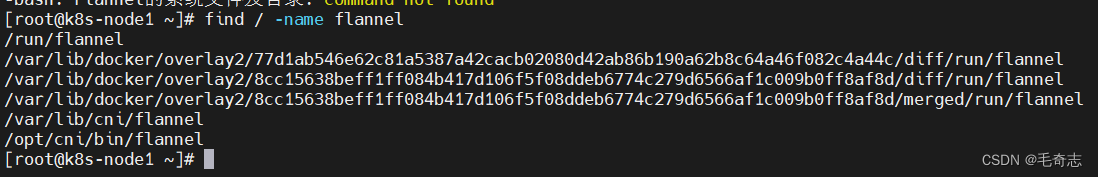

Flannel的系统文件及目录

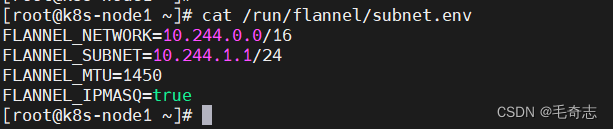

当前node主机IP地址范围

当前node主机IP地址范围

如何给k8s集群安装和使用Flannel插件

参考链接(亲测可用):

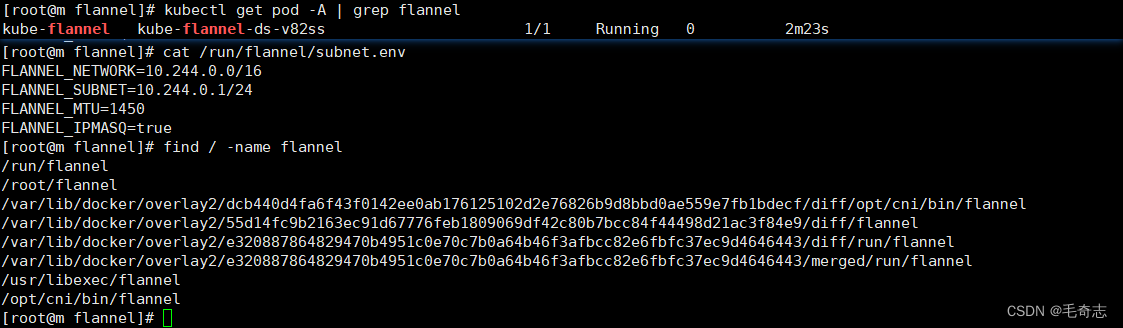

安装完成之后,成功标志,如下:

四、Flannel底层网络通信全过程

1)同节点Pod之间的通信

在容器启动前,会为容器创建一个虚拟Ethernet接口对,这个接口对类似于管道的两端,其中一端在主机命名空间中,另外一端在容器命名空间中,并命名为eth0。在主机命名空间的接口会绑定到网桥。网桥的地址段会取IP赋值给容器的eth0接口。

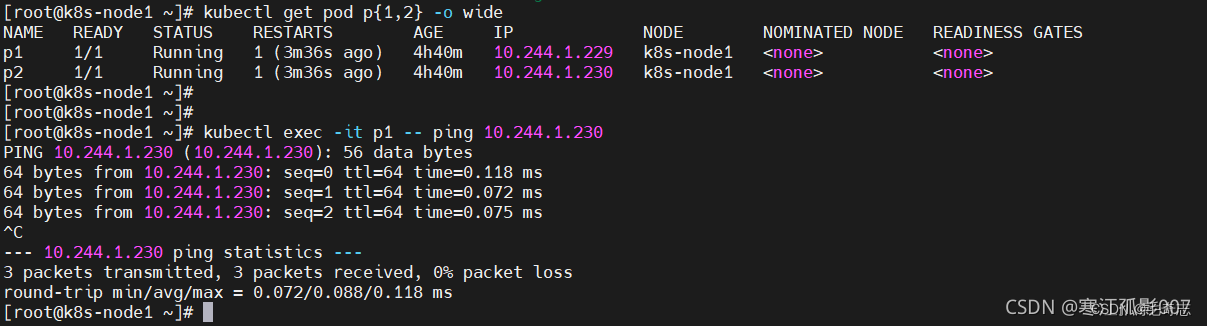

实验

【实验】这里利用nodeName特性将Pod调度到相同的node节点上(亲和性),创建两个pod

执行

工作流程

步骤1:源容器向目标容器发送数据,数据首先发送给 cni0 网桥

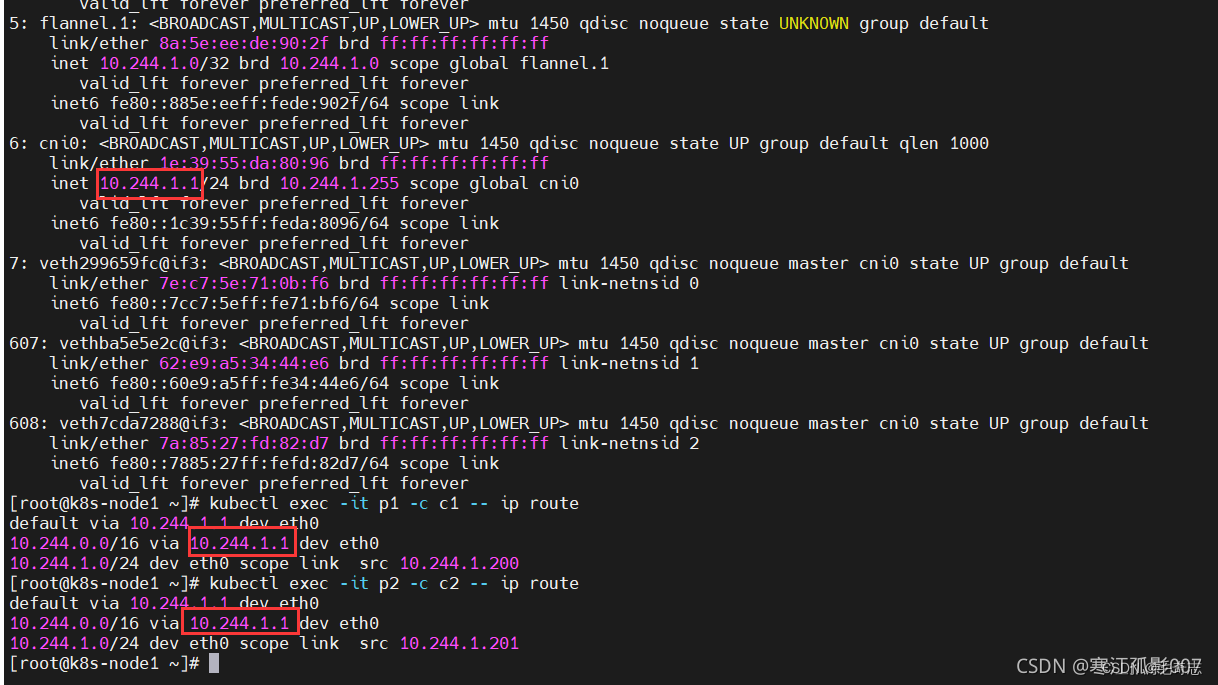

查看路由

步骤2:cni0 网桥接受到数据后,将其转交给 flannel.1 虚拟网卡处理

cni0 收到数据包后,docker0的内核栈处理程序会读取这个数据包的目标地址,根据目标地址将数据包发送给下一个路由节点:

步骤3: flannel.1 接受到数据后,对数据进行封装,并发给宿主机的 ens33,再通过ens33出外网,或者访问不同node节点上的pod

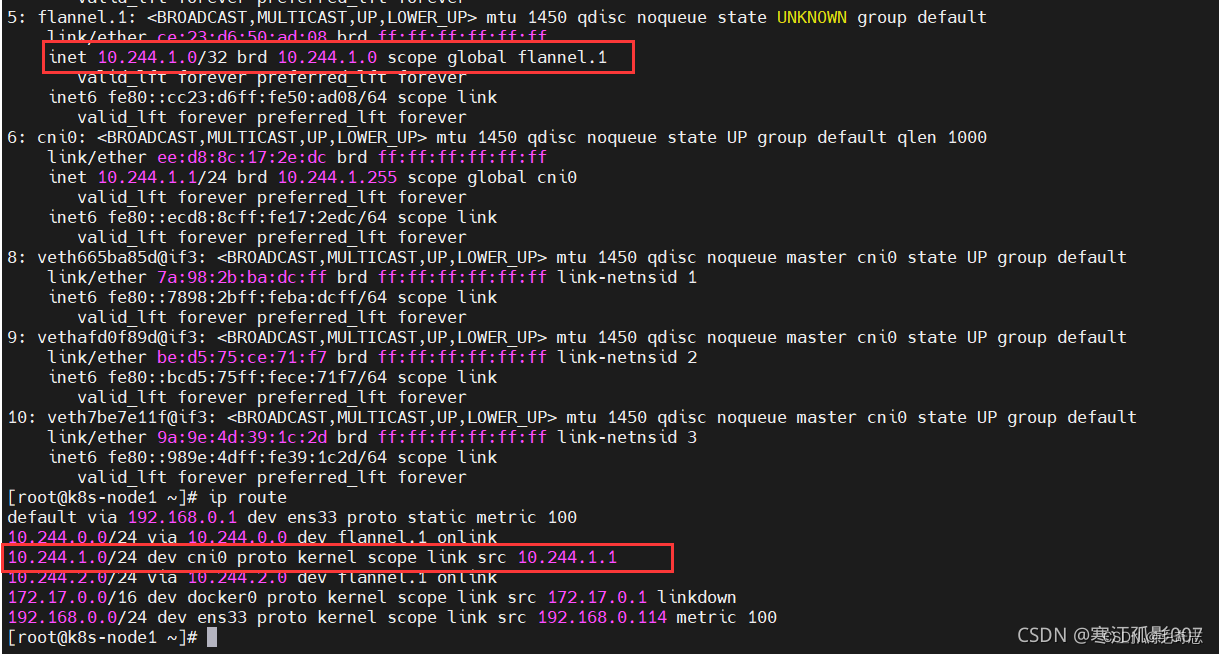

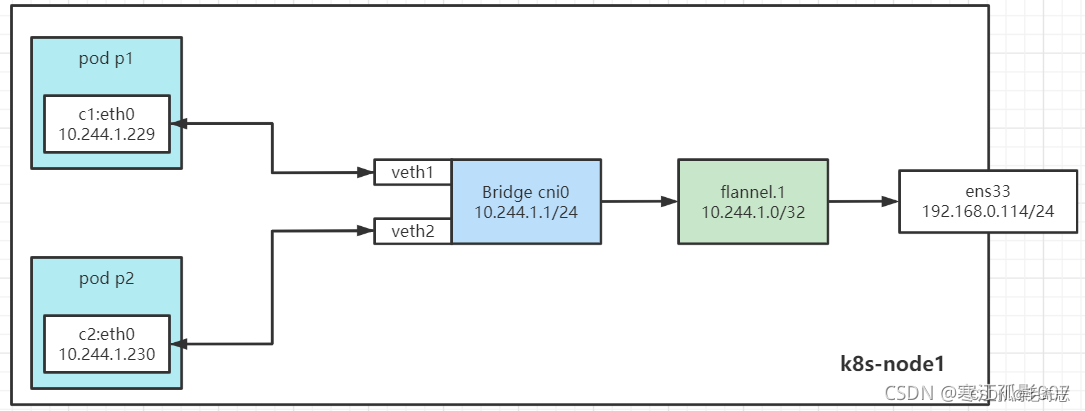

针对相同节点上的pod通信,直接cni0 网桥通信,流程如下图:

2)不同节点Pod之间的通信

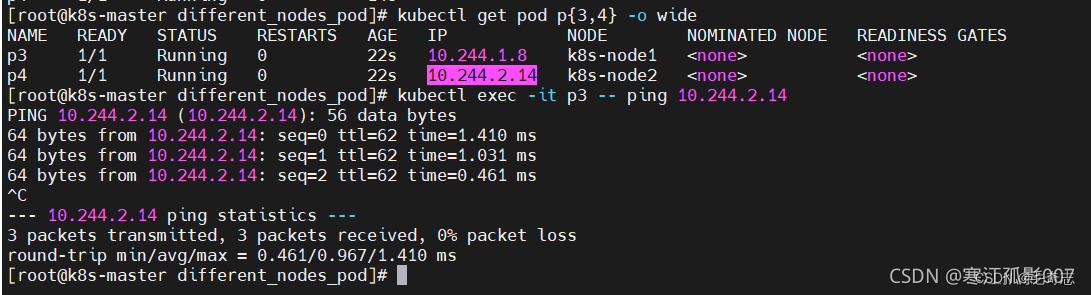

【实验】这里利用nodeName特性将Pod调度到不同的node节点上(亲和性),创建两个pod

执行

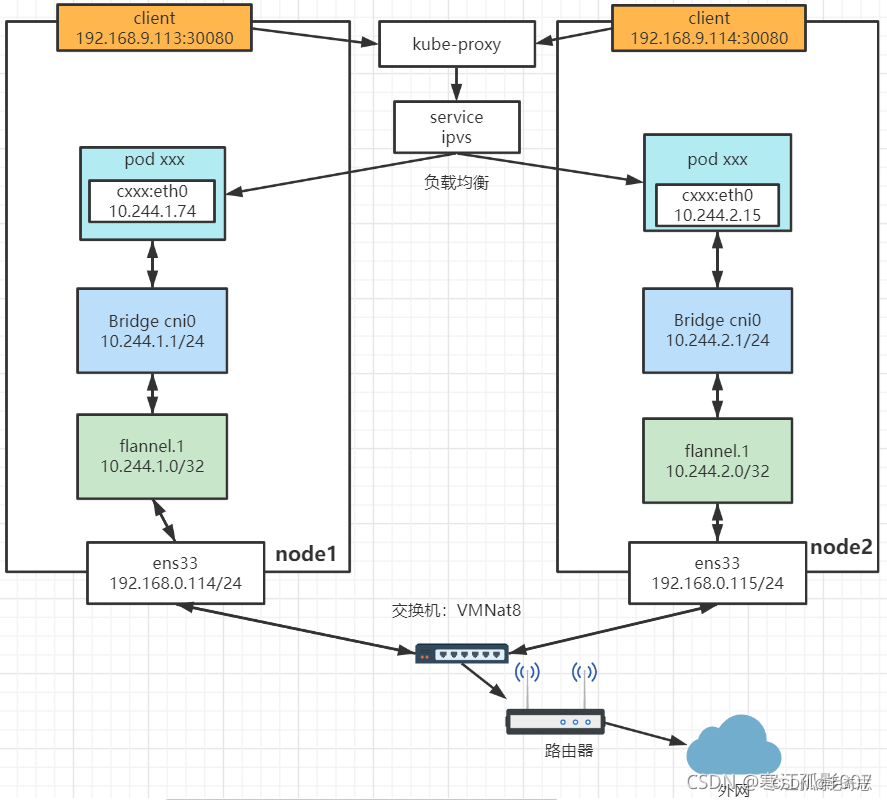

工作流程上面已经讲解了,这里就不重复了。流程如下图:

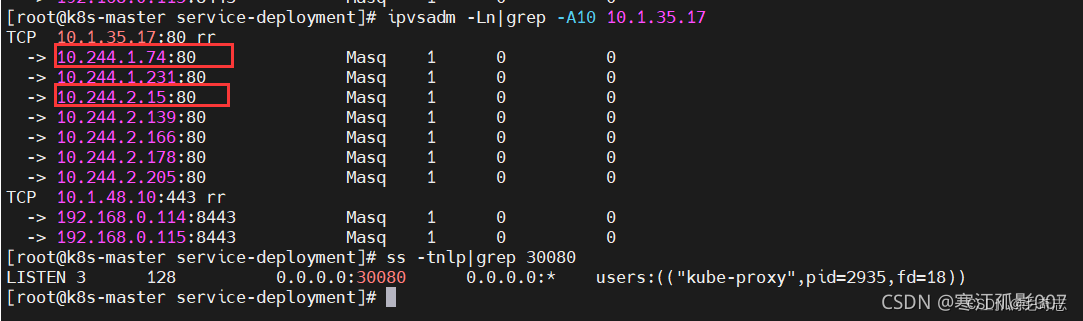

3)Pod与Service之间的通信

在不同节点上的Pod通信中,我们知道了Pod是以IP地址进行通信,但Kubernetes 的集群中, Pod 可能会频繁的销毁和创建,也就是说 Pod 的 IP 不是固定的。为了解决这个问题,Service 提供了访问 Pod 的抽象层,即为一组功能相同的Pod提供单一不变的接入点资源。无论后端的 Pod 如何变化,Service 都作为稳定的前端对外提供服务。同时,Service 还提供了高可用和负载均衡功能,Service 负责将请求转发给正确的 Pod。

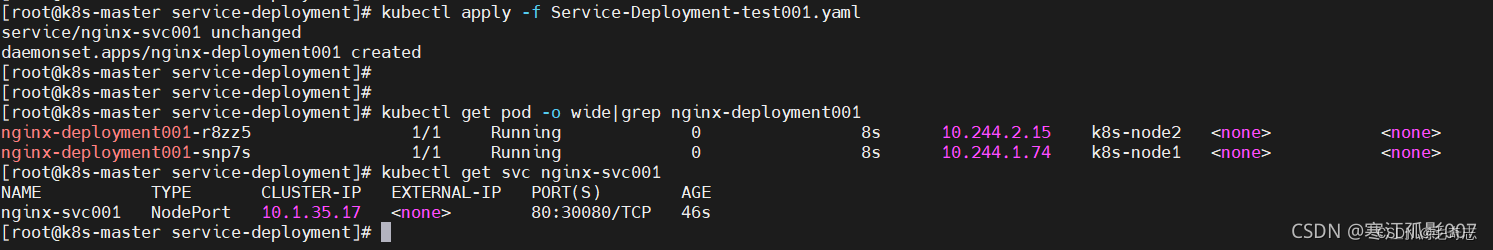

【实验】因为在pod基本上都是由控制器管理,不明白控制器的,可以看这里,所以这里就创建Service和Deployment

执行

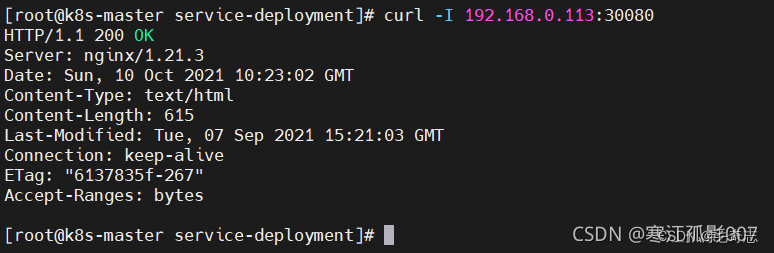

发现每个node节点上都运行了一个pod,curl验证是否正常访问

流程图如下:

五、尾声

学会安装使用是最重要的,底层原理了解就好。

Flannel参考资料(两篇质量很好的讲Flannel底层原理的博客,Flannel看完这两篇就好):

[这篇博客里面有yaml安装flannel的具体方式(亲测有效)]

flannel安装与配置:

虚拟化安装:etcd+flannel+docker https://blog.51cto.com/mshxuyi/5858681

flannel网络问题,各个节点之间的Pod无法ping通:

在K8s集群中安装和配置Flannel网络: https://code84.com/788163.html

安装flannel网络插件

704

704

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?