写在前边的话:

算是自己做的一个小课题吧,自己搭建平台,自己爬取数据,自己进行数据清洗和分析,自己进行可视化展示,写这篇博客不为别的,只是记录下自己做这个课题的整个过程,大神们勿喷

环境说明:hadoop2.7集群,包含Hbase,Hive,Spark,Sqoop,Mahout组件

过 程:平台部署->数据采集-> 数据存储->数据ETL->数据分析->可视化

课题github地址:https://github.com/Thinkgamer/Douban_Movies_Analysi (主要是源代码部分)

1:平台部署

看之前的博客:点击阅读

2:数据采集

数据来源,豆瓣电影,以Tag采集入口,对应标签采集对应的电影,使用Python3.4.3 + BeautifulSoup4.4.1 + urllib进行数据

的采集,本地存储形式为csv格式,代码结构为

-DouBan-Spider #项目根目录

----download #下载网页源代码模块

--------__init__.py

-------down_html.py

----fileoutput #文件输出保存路径

----output #将抓取的内容写入文件

--------__init__.py

--------output_all.py

----parase #解析网页代码

--------__init__.py

--------parase_html.py

----urlmanager #链接管理

--------__init__.py

--------manage_url.py

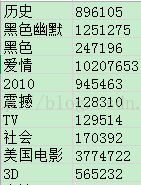

----maincategory.csv,两列(标签name,对应的电影数目)

movie.csv,10列(电影ID,名字,导演,编剧,类型,主演,上映时间,时长,评论人数,豆瓣评分)

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?