大家好,有两周没好好坐下来聊聊近期的实践课程了,今年也是对网工技能要求上的一个非常大的挑战,怎么说呢?因为上云的趋势已经来临,去年是所有的企业都在拥抱互联网,今年则是所有的企业都在拥抱云计算,加上各大产商的疯狂扩展与竞争,“价格战····”已经不计其数,但真正能协助用户落地实施方案成功上云的服务商,用手指在上海完全能数得过来。

这里就不点名了,点名就有点个人情绪在里面了,还是回归老本行扯扯技术,聊聊梦想。

我见过很多公司,号称自己有云。但是去聊了下,也其实就是虚拟化(kvm、xen、vmware、hyper-v),这真的不算什么云,这也就是虚拟化而已。云化的概念大家也都明白,就是把资源“池化”,伸缩自如。虚拟化可以吗?狭义上可以的,但是以虚拟化著称自己做了云,这个明显是不负责任且站不住脚跟的。

当然呢,今天我不想过多去聊云产品、虚拟化,我想说的是“如何在物理idc网络和云上的网络”连起来的话题。不论是现在的“clound link、hybrid clound”等等,均离不开传统的物理网络基础设施,所以侧面的证明了一家做ISP的公司,一定要有一张自己的网,这张网提供了你全国甚至全球的链路上的业务扩张。

所以啊,今天我来分享下我们在做传统机房如何和云计算节点打通的经验之谈。

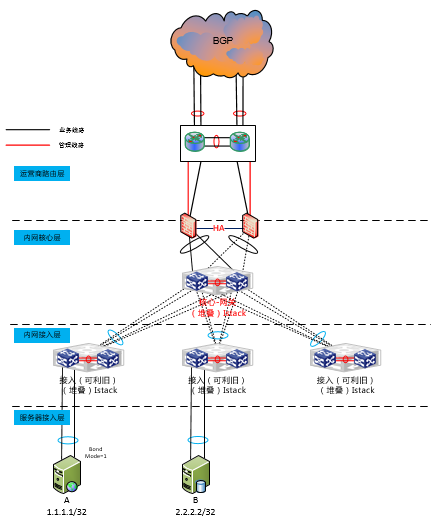

首先呢,大家都知道,传统的物理idc机房,是这样的。

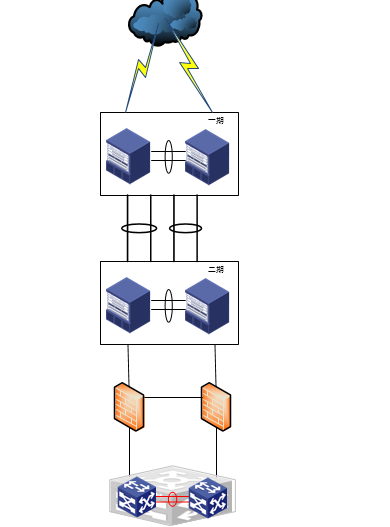

也有可能是这样的:

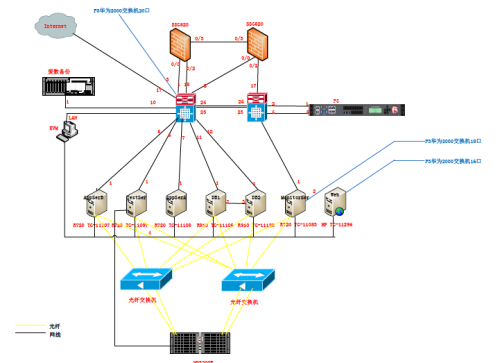

也有可能是这样的:

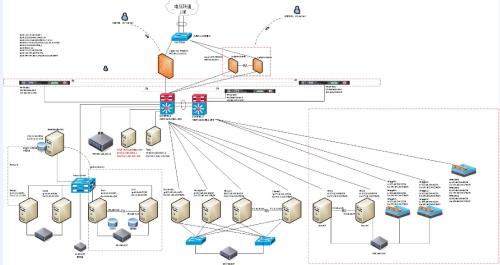

也有这样涉及比较多业务系统的:

以上的拓扑图呢,都是很多项目测试期间以及改网之前的原有的样子,已经是过去式了,所以我这里比较直接的拿出来给大家分享了。

但是大家想一想,这一套网络基础设施或者一套业务系统硬件动则上千万,哪位老板会说不用就不用了,谁不都会想着能利旧就利旧,能跑点东西就跑点,别浪费!!!今年有太多的咨询公司跑到各个地方说:上云把,完全可以替代原有的基础设施。一条×××就能保证云上的内网通信,这样你就可以把业务迁移过去了。

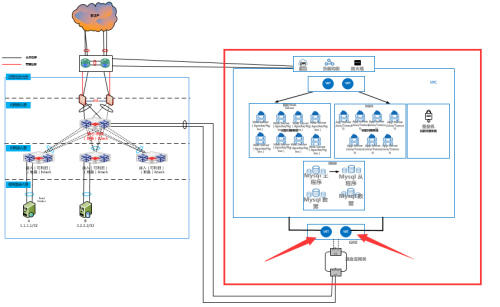

但是谁有说的好,云上好,还是物理好呢。所以这才是但是混合云的最佳场景。我们把物理和云用专线打通,将云的池化环境与传统物理的组网打通。实现虚实结合的组网结构。就类似如下的示意图:

(近场混合云组网示例图)

如上拓扑,云计算的出口网络仍然是使用的某数据中心的出口,但下面会采用裸纤或者六类网线或者内网GRE隧道打通的形式直连接入完成通信的链接。池化的环境与物理的完成完全打通,即实现了我们在需要对前端的快速部署或者释放。我们在很多场景里面也完成物理做数据计算,对外提供服务以池化的云计算环境为主。

方式一般分为:GRE、裸光纤、网线直连、(IPSE×××,这种不算,切记)

但以上也是目前很多厂商非常常见且成熟的对接方案,这是我在图上标注“近场混合云”组网的特征,为什么这么说呢,相当于你的云要么是自己在当前IDC机房自己建的、或者你的公有云提供商在你托管的数据中心的另外一边,有云计算节点。这就是所谓的近场混合云组网.

综上结论,混合云的组网,基本上就是这个套路,希望大家在后期不要被瞎吹牛的咨询商套路了。其实就是这么简单的互联,没什么其他特点的地方。

这里面涉及的更多的是管理上的话题,云化后的运维运营管理,流程对接,快捷的整合现有资源达到资源利用最大化等等。这也是今天的一小块的开门见山的经验之谈。

后面会给大家分享,如何利用MPLS实现三层跨数据中心的内网通信、以及大二层波分组网结合GTM完成的双活数据中心组网、以及如何利用大二层技术结合大势的阿里云实现虚实合一的组网,希望大家期待。

把学习和总结当成一种生活习惯,把技术成就梦想做成最佳实践

————来自一家二级运营商的网工分享

补充,以上均代表个人经验之谈与任何公司和51CTO无任何直接联系,不代表任何甲方立场。

QQ:549675970

QZONE:http://user.qzone.qq.com/549675970

E-mail:549675970@qq.com

allen_junjun@hotmail.com

人生格言:越努力、越幸运

转载于:https://blog.51cto.com/allen686/1907748

390

390

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?