代码地址如下:

http://www.demodashi.com/demo/13209.html

前言

今天讲讲科大讯飞的语音合成功能吧

涉及以下内容:

- 在科大讯飞平台上创建应用

- 在androidstudio中的配置

- 语音合成相关代码

- 语音合成工具类SpeechHelper的调用

- 使用过程中需要注意的问题

- 项目结构图

一. 在科大讯飞平台上创建应用

先登录科大讯飞开发者平台,进入控制台,然后创建应用,创建的时候需要填写以下内容:

应用名称 -------------- 填写你应用的名称

应用分类 -------------- 选择你应用属于的行业

应用功能描述 -------- 写些对你应用的基本介绍

应用平台 ------------- 我们是android开发,就选择android最后点击提交,就生成科大讯飞应用了,然后给你的应用添加新服务,选择“在线语音合成”

ok,此时在平台上一个具有在线语音合成功能的应用已经弄好了,请记下你这个应用的appId,在后面会用到。

二. 在androidstudio中的配置

先在科大讯飞你创建的应用下,将对应的sdk下载到本地,这个sdk有两个作用:

- 里面的jar包和so文件是你的应用中需要用到的

- 里面的samlpe可以给你在开发的时候提供参考

ok,在下载的sdk文件夹中,你可以看到libs文件夹下有以下东西:

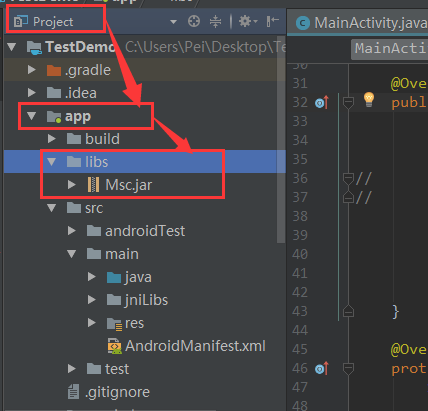

打开你的项目,将标签切换到project,在app文件夹下建libs文件夹,然后将Msc.jar和Sunflower.jar复制到libs文件夹下(由于我只用到了Msc.jar,所以没有拷贝Sunflower.jar),如下图:

选中Msc.jar ---> 右键 --->选择 add as Library ,用来导入Msc.jar包,Sunflower.jar的导入同理。

还是将你的项目切换到project标签下,在 app/src/main/ 文件夹下新建jniLibs文件夹,将 arm64-v8a,armeabi,armeabi-v7a,mips,mips64,x86,x86_64文件夹全部拷贝到 jniLbswen文件夹下,如下图:

至此,androidstudio中的配置完成。

三. 语音合成相关代码

注册语音合成功能,你可以这样:

SpeechUtility.createUtility(context, "appid=" + "xxxxxxxx");

//其中"xxxxxx"为你在语音开发平台上的appid初始化语音合成对象:

private SpeechSynthesizer mTts;

mTts = SpeechSynthesizer.createSynthesizer(AppContext.getInstance(), mTtsInitListener);监听初始化成功/失败:

/**

* 初始化监听。

*/

private InitListener mTtsInitListener = new InitListener() {

@Override

public void onInit(int code) {

LogUtil.i("InitListener init() code = " + code);

if (code != ErrorCode.SUCCESS) {

LogUtil.i("初始化失败,错误码: " + code);

} else {

// 初始化成功,之后可以调用startSpeaking方法

// 注:有的开发者在onCreate方法中创建完合成对象之后马上就调用startSpeaking进行合成,

// 正确的做法是将onCreate中的startSpeaking调用移至这里

}

}

};初始化成功之后,设置语音合成参数:

mTts.setParameter(SpeechConstant.ENGINE_TYPE, SpeechConstant.TYPE_CLOUD);

// 设置在线合成发音人

mTts.setParameter(SpeechConstant.VOICE_NAME, mVoicer);

//设置合成语速

mTts.setParameter(SpeechConstant.SPEED, COMPOUND_SPEED);

//设置合成音调

mTts.setParameter(SpeechConstant.PITCH, COMPOUND_TONES);

//设置合成音量

mTts.setParameter(SpeechConstant.VOLUME, COMPOUND_VOICE);

//设置播放器音频流类型

mTts.setParameter(SpeechConstant.STREAM_TYPE,VOICE_STREAM_TYPE);

// 设置播放合成音频打断音乐播放,默认为true

mTts.setParameter(SpeechConstant.KEY_REQUEST_FOCUS, "true");参数设置完后,开始合成:

int code=mTts.startSpeaking(message, mTtsListener);

//合成回调

/**

* 合成回调监听。

*/

private SynthesizerListener mTtsListener = new SynthesizerListener() {

@Override

public void onSpeakBegin() {

// LogUtil.i("开始播放");

}

@Override

public void onSpeakPaused() {

// LogUtil.i("暂停播放");

}

@Override

public void onSpeakResumed() {

// LogUtil.i("继续播放");

}

@Override

public void onBufferProgress(int percent, int beginPos, int endPos,

String info) {

// 合成进度

mPercentForBuffering = percent;

// LogUtil.i("======合成进度======缓冲进度="+mPercentForBuffering+" 播放进度:"+mPercentForPlaying);

}

@Override

public void onSpeakProgress(int percent, int beginPos, int endPos) {

// 播放进度

mPercentForPlaying = percent;

// LogUtil.i("======播放进度======缓冲进度="+mPercentForBuffering+" 播放进度:"+mPercentForPlaying);

}

@Override

public void onCompleted(SpeechError error) {

if (error == null) {

// LogUtil.i("播放完成");

} else if (error != null) {

LogUtil.i(error.getPlainDescription(true));

}

mSpeaking=false;

}

@Override

public void onEvent(int eventType, int arg1, int arg2, Bundle obj) {

// 以下代码用于获取与云端的会话id,当业务出错时将会话id提供给技术支持人员,可用于查询会话日志,定位出错原因

// 若使用本地能力,会话id为null

// if (SpeechEvent.EVENT_SESSION_ID == eventType) {

// String sid = obj.getString(SpeechEvent.KEY_EVENT_SESSION_ID);

// Log.d(TAG, "session id =" + sid);

// }

}

};最后,使用完后,释放语音合成功能:

if( null != mTts ){

mTts.stopSpeaking();

// 退出时释放连接

mTts.destroy();

}代码看着有些繁琐,所以我将语音合成所需要用到的方法封装成一个语音合成工具类SpeechHelper,带代码demo中有,下面讲讲工具类SpeechHelper的使用

四. 语音合成工具类SpeechHelper的调用

在线语音合成需要网络权限,因此你需要在你的mainfast.xml中添加网络权限:

<uses-permission android:name="android.permission.INTERNET"/>在你应用自己的application中初始化语音合成

public class AppContext extends Application{

@Override

public void onCreate() {

super.onCreate();

//语音合成

SpeechHelper.getInstance().initSpeech(this);

}注意在initSpeech方法中有一行代码:

SpeechUtility.createUtility(context, "appid=" + "xxxxxxxx");xxxxxxxx 为你自己应用的appid

在需要调用的地方使用语音合成:

SpeechHelper.getInstance().speak("大家好");使用完后,需要注销语音合成服务:

SpeechHelper.getInstance().destroy();五.使用过程中需要注意的问题

首先需要注意的是,在线语音合成,必须要在你的mainfast.xml中配置网络权限

当你调用以下代码:

SpeechHelper.getInstance().speak("130");也许你希望它播报的是“一三零”,但遗憾的是它可能播报成“一百三十”,这是一件很尴尬的事,那么当你需要它播成“一三零”的话,你需要在“130”中做下处理,将每个数字间增加空格,及“130”写成“1 3 0”,这样就能播报“一三零”了。

在我们执行代码的时候,你可能会遇到以下问题:

组件未安装.(错误码:21002),couldn't find "libmsc.so"这个是因为你没有将sdk中拷贝的所有文件夹方法你项目中的正确位置,也许你将这些文件夹放到 project的app/libs/ 下面了,如果是这样,请将文件夹全部剪切到project的app/src/main/jniLibs/ 文件夹下。

六.项目结构图

科大讯飞语音合成实例

代码地址如下:

http://www.demodashi.com/demo/13209.html

注:本文著作权归作者,由demo大师代发,拒绝转载,转载需要作者授权

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?