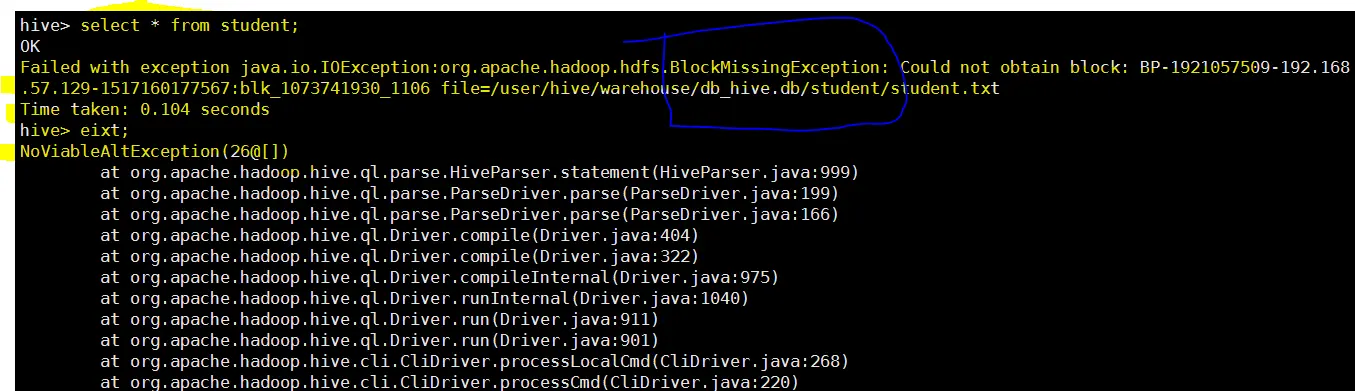

报错

Failed with exception java.io.IOException:org.apache.hadoop.hdfs.BlockMissingException: Could not obtain block: BP-1921057509-192.168.57.129-1517160177567:blk_1073741930_1106 file=/user/hive/warehouse/db_hive.db/student/student.txt

Time taken: 0.104 seconds

hive> eixt;

NoViableAltException(26@[])

image.png

-

hdfs检测

检测命令:bin/hdfs fsck /

- 清理坏块命令:bin/hdfs fsck / -delete命令说明:将丢失的块全部删除

-

检测

bin/hdfs fsck /

health

-

hive测试

success

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?