在老板的支持下,陆续划拉到了10几台机器,绑定了固定IP,工作之余开始了Hadoop之旅。将要点记录下来,以备查阅。

硬件构成:

Resource | Volume |

CPU | 2 cores |

Memory | 4 GB |

Disk | 500 GB |

Network | 100 M |

软件构成:

Name | Version | Install Path |

CentOS | 6.7 x86_64 | / |

Oracle JDK | 7u79-linux-x64 | /usr/local/java/ |

Hadoop | 2.7.1 | /home/hadoop/ |

Flume | 1.6.0 | /home/flume/ |

Maven | 3.3.9 | /usr/local/maven/ |

Ant | 1.9.6 | /usr/local/ant |

MySQL | 5.6.21 Community Server | /home/mysql/ |

D3.js | v3 |

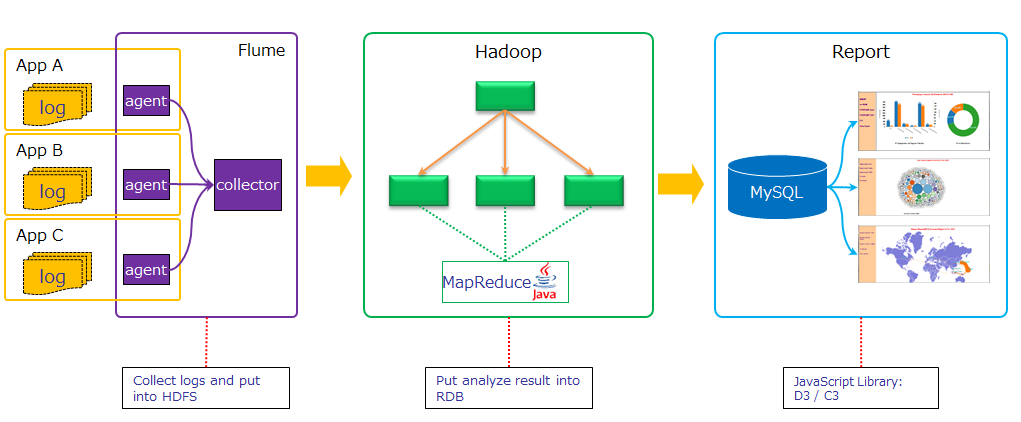

整体架构:

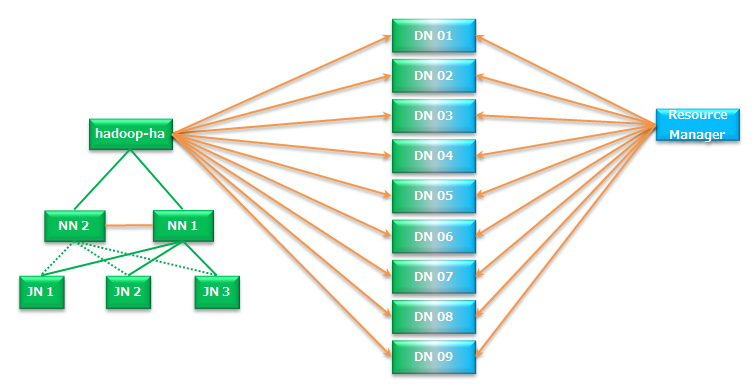

DFS和Yarn构成:

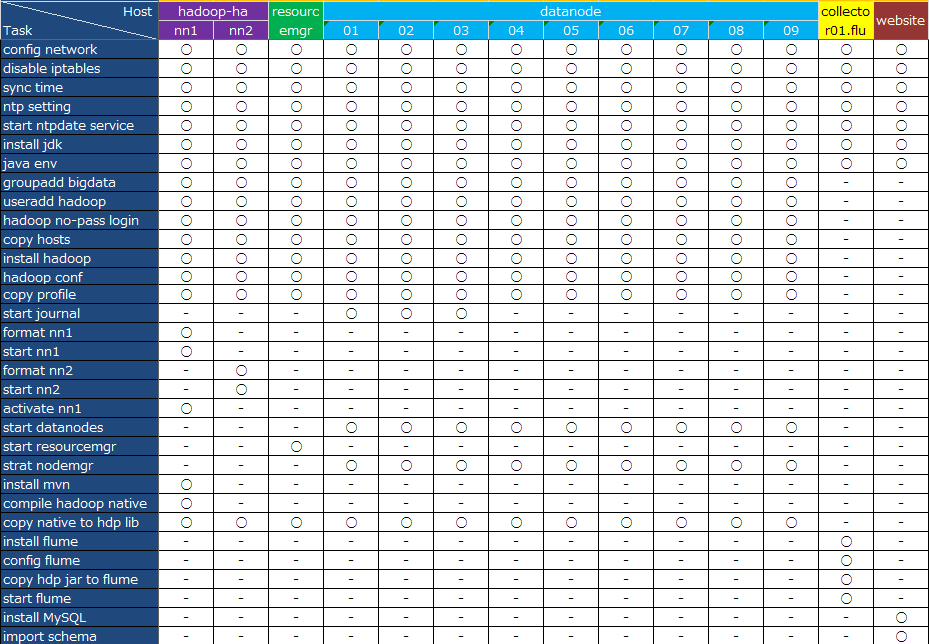

各个节点需要的配置:

调试hadoop节点用到的命令:

sbin/hadoop-daemon.sh start journal

bin/hdfs namenode format

sbin/hadoop-daemon.sh start namenode

bin/hdfs namenode -bootstrapStandby

sbin/hadoop-daemon.sh start namenode

bin/hdfs haadmin -transitionToActive nn1

sbin/hadoop-daemons.sh start datanode

sbin/yarn-daemon.sh start resourcemanager

sbin/yarn-daemon.sh start nodemanager

调试完毕后的集群启动/关闭命令:

sbin/start-dfs.sh

sbin/start-yarn.sh

bin/hdfs haadmin -transitionToActive nn1

sbin/stop-dfs.sh

sbin/stop-yarn.sh

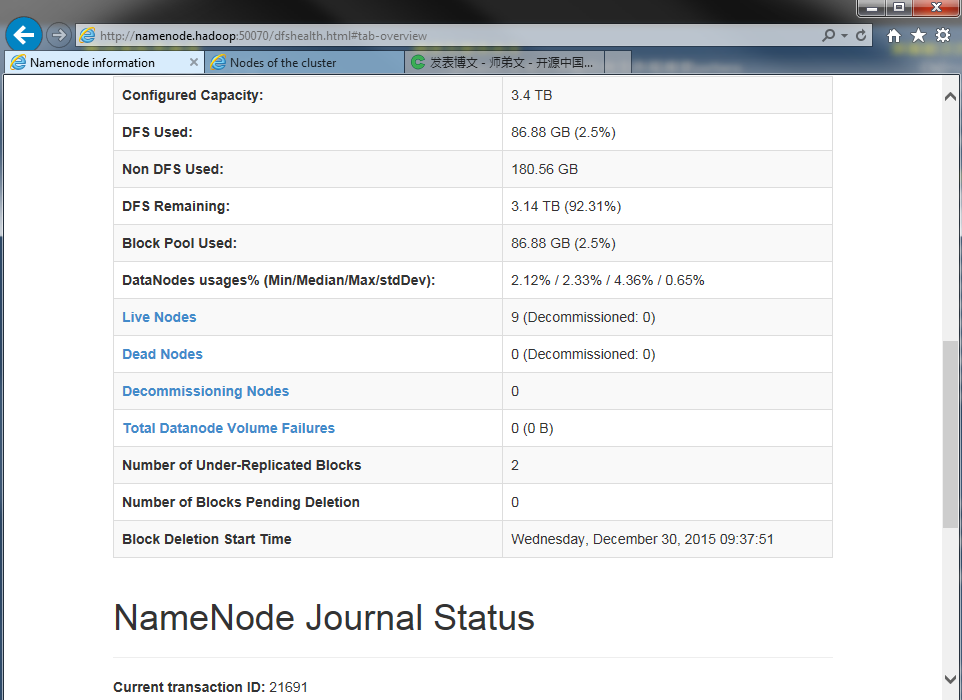

DFS管理界面:

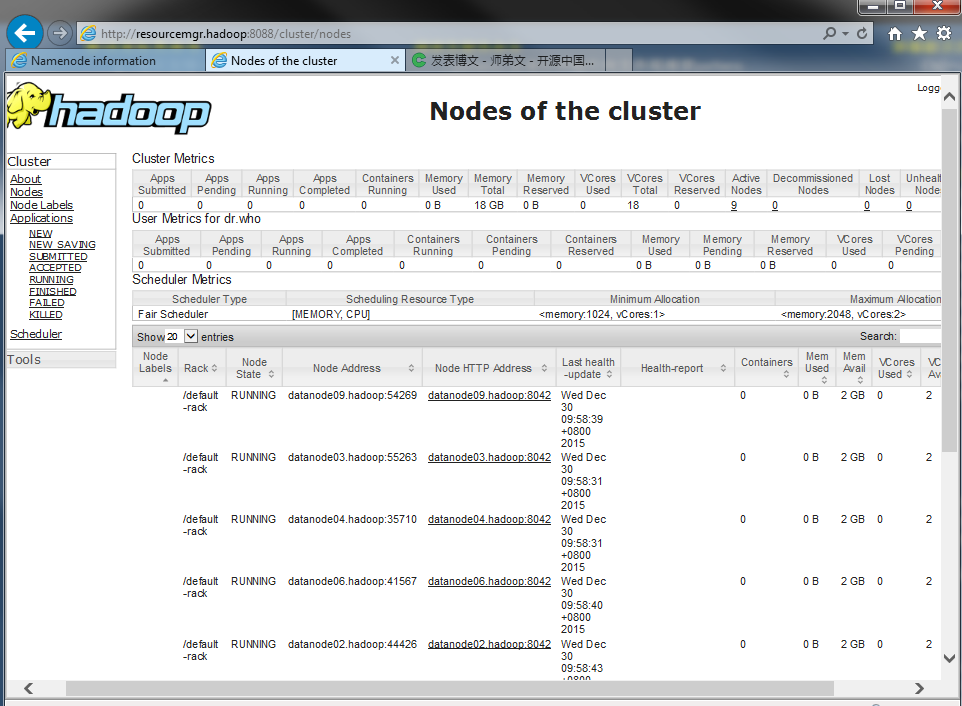

YARN管理界面:

正在把150G日志手动导入DFS,暂时还没用上Flume,后面逐步集成进来。

MR运行结果存入DFS或者灌入MySQL都试验成功,回头整理。

Yarn的资源队列临时配置了一个,现在只是能跑,还不明白咋回事,抽时间继续研究。

在4个data node节点上(昨晚才凑到9节点)对15G日志跑一个过滤useragent的MR,需要8分钟,这样算下来需要1天时间才能对1个月的日志解析完,孰能忍!性能优化需要陆续展开。

配置文件的内容参考了hadoop官网,董西成博客,感谢董先生无私分享。

240

240

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?